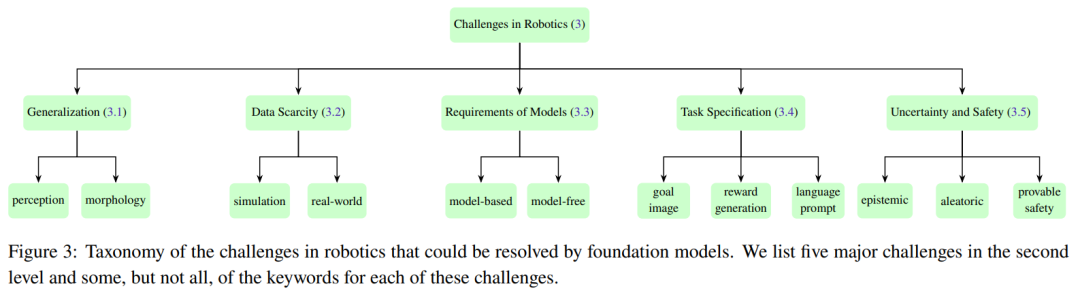

Roboter sind eine Technologie mit unbegrenztem Potenzial, insbesondere mit der Unterstützung intelligenter Technologie. In jüngster Zeit wird davon ausgegangen, dass einige großformatige Modelle mit revolutionären Anwendungen möglicherweise zu intelligenten Gehirnen für Roboter werden und Robotern dabei helfen können, die Welt wahrzunehmen und zu verstehen sowie Entscheidungen und Pläne zu treffen. Kürzlich veröffentlichte ein gemeinsames Team unter der Leitung von Yonatan Bisk von CMU und Fei Xia von Google DeepMind einen Übersichtsbericht, der die Anwendung und Entwicklung grundlegender Modelle im Bereich der Robotik vorstellt.

Der Mensch hat schon immer davon geträumt, einen Roboter zu entwickeln, der sich autonom an verschiedene Umgebungen anpassen kann. Die Verwirklichung dieses Traums ist jedoch ein langer und herausfordernder Weg.

In der Vergangenheit verwendeten Roboterwahrnehmungssysteme normalerweise traditionelle Deep-Learning-Methoden, die eine große Menge an gekennzeichneten Daten erforderten, um überwachte Lernmodelle zu trainieren. Allerdings ist die Kennzeichnung großer Datensätze durch Crowdsourcing sehr kostspielig.

Darüber hinaus weisen klassische überwachte Lernmethoden gewisse Einschränkungen in ihrer Generalisierungsfähigkeit auf. Um diese trainierten Modelle auf bestimmte Szenarien oder Aufgaben anzuwenden, ist in der Regel ein sorgfältiger Entwurf der Domänenanpassungstechnologie erforderlich, der häufig eine weitere Datenerfassung und Annotation erfordert. Ebenso erfordern herkömmliche Roboterplanungs- und -steuerungsmethoden eine genaue Modellierung der Dynamik der Umgebung, des Agenten selbst und anderer Agenten. Diese Modelle werden häufig für eine bestimmte Umgebung oder Aufgabe erstellt. Wenn sich die Bedingungen ändern, muss das Modell neu erstellt werden. Dies zeigt, dass auch die Übertragungsleistung klassischer Modelle begrenzt ist.

Tatsächlich ist die Erstellung effektiver Modelle für viele Anwendungsfälle entweder zu teuer oder einfach unmöglich. Obwohl auf Deep (Reinforcement) Learning basierende Bewegungsplanungs- und Kontrollmethoden dazu beitragen, diese Probleme zu lindern, leiden sie immer noch unter Verteilungsverschiebungen und einer verminderten Generalisierungsfähigkeit.

Obwohl die Entwicklung universeller Robotersysteme viele Herausforderungen mit sich bringt, haben die Bereiche der Verarbeitung natürlicher Sprache (NLP) und Computer Vision (CV) in letzter Zeit schnelle Fortschritte gemacht, einschließlich großer Sprachmodelle (LLM) für NLP und Benutzerdiffusion Modell für die Generierung von Bildern mit hoher Wiedergabetreue, leistungsstarkes visuelles Modell und visuelles Sprachmodell für CV-Aufgaben wie die Erzeugung von Null-Aufnahmen/wenigen Aufnahmen.

Das sogenannte „Foundation-Modell“ ist eigentlich ein großes Pre-Training-Modell (LPTM). Sie verfügen über starke visuelle und verbale Fähigkeiten. In jüngster Zeit werden diese Modelle auch im Bereich der Robotik eingesetzt und sollen Robotersystemen eine offene Weltwahrnehmung, Aufgabenplanung und sogar Bewegungssteuerungsfunktionen verleihen. Neben der Nutzung bestehender Seh- und/oder Sprachgrundmodelle im Bereich der Robotik entwickeln einige Forschungsteams auch Grundmodelle für Roboteraufgaben, etwa Aktionsmodelle zur Manipulation oder Bewegungsplanungsmodelle zur Navigation. Diese grundlegenden Robotermodelle weisen starke Generalisierungsfähigkeiten auf und können sich an verschiedene Aufgaben und sogar spezifische Lösungen anpassen.

Es gibt auch Forscher, die direkt visuelle/sprachliche Basismodelle für Roboteraufgaben verwenden, was die Möglichkeit zeigt, verschiedene Robotermodule in ein einziges einheitliches Modell zu integrieren.

Obwohl Seh- und Sprachgrundmodelle im Bereich der Robotik vielversprechende Perspektiven haben und auch neue Robotergrundmodelle entwickelt werden, gibt es im Bereich der Robotik immer noch viele Herausforderungen, die schwer zu lösen sind.

Aus der Perspektive des tatsächlichen Einsatzes sind Modelle oft nicht reproduzierbar, nicht in der Lage, auf verschiedene Roboterformen zu verallgemeinern (multi-embodied generalization) oder es ist schwierig, genau zu verstehen, welche Verhaltensweisen in der Umgebung machbar (oder akzeptabel) sind. Darüber hinaus verwenden die meisten Forschungsarbeiten eine Transformer-basierte Architektur und konzentrieren sich auf die semantische Wahrnehmung von Objekten und Szenen, die Planung und Steuerung auf Aufgabenebene. Andere Teile des Robotersystems sind weniger untersucht, beispielsweise Grundmodelle für die Weltdynamik oder Grundmodelle, die symbolisches Denken durchführen können. Diese erfordern domänenübergreifende Generalisierungsfähigkeiten.

Schließlich brauchen wir auch mehr groß angelegte reale Daten und High-Fidelity-Simulatoren, die vielfältige Roboteraufgaben unterstützen.

Dieser Übersichtsartikel fasst die im Bereich der Robotik verwendeten Grundmodelle zusammen, mit dem Ziel zu verstehen, wie die Grundmodelle zur Lösung oder Linderung der Kernherausforderungen im Bereich der Robotik beitragen können.

Papieradresse: https://arxiv.org/pdf/2312.08782.pdf

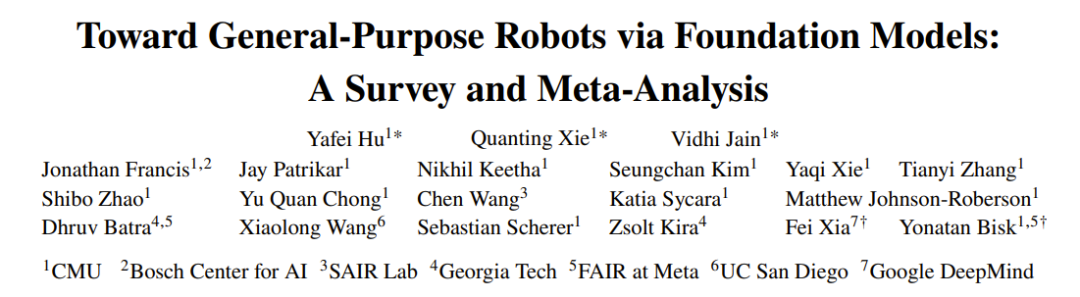

In dieser Rezension verwendeten die Forscher „Grundlagenmodelle für Roboter“. Der Begriff „Robotik“ umfasst zwei Aspekte : (1) bestehende (hauptsächlich) Vision- und Sprachmodelle für Roboter, hauptsächlich durch Zero-Shot- und Kontextlernen (2) speziell entwickeltes und genutztes Roboter-Grundmodell zur Lösung von Roboteraufgaben; Sie fassten die Methoden in relevanten Veröffentlichungen zusammen, die für Basismodelle von Robotern verwendet wurden, und führten eine Metaanalyse der experimentellen Ergebnisse dieser Veröffentlichungen durch.

Abbildung 1 zeigt die Hauptbestandteile dieses Überprüfungsberichts.

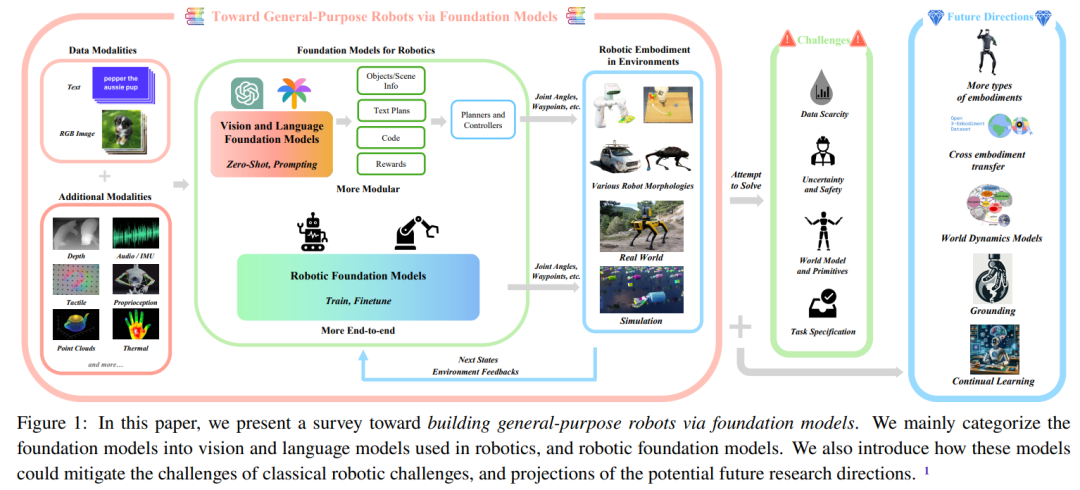

Abbildung 2 gibt die Gesamtstruktur dieser Rezension wieder.

Um den Lesern zu helfen, den Inhalt dieser Rezension besser zu verstehen, stellt das Team zunächst einen Abschnitt mit Vorwissen bereit.

Sie werden zunächst die Grundlagen der Robotik und die beste aktuelle Technologie vorstellen. Der Schwerpunkt liegt dabei auf Methoden, die im Bereich der Robotik vor der Ära der Basismodelle eingesetzt wurden. Hier ist eine kurze Erklärung. Weitere Informationen finden Sie im Originalpapier.

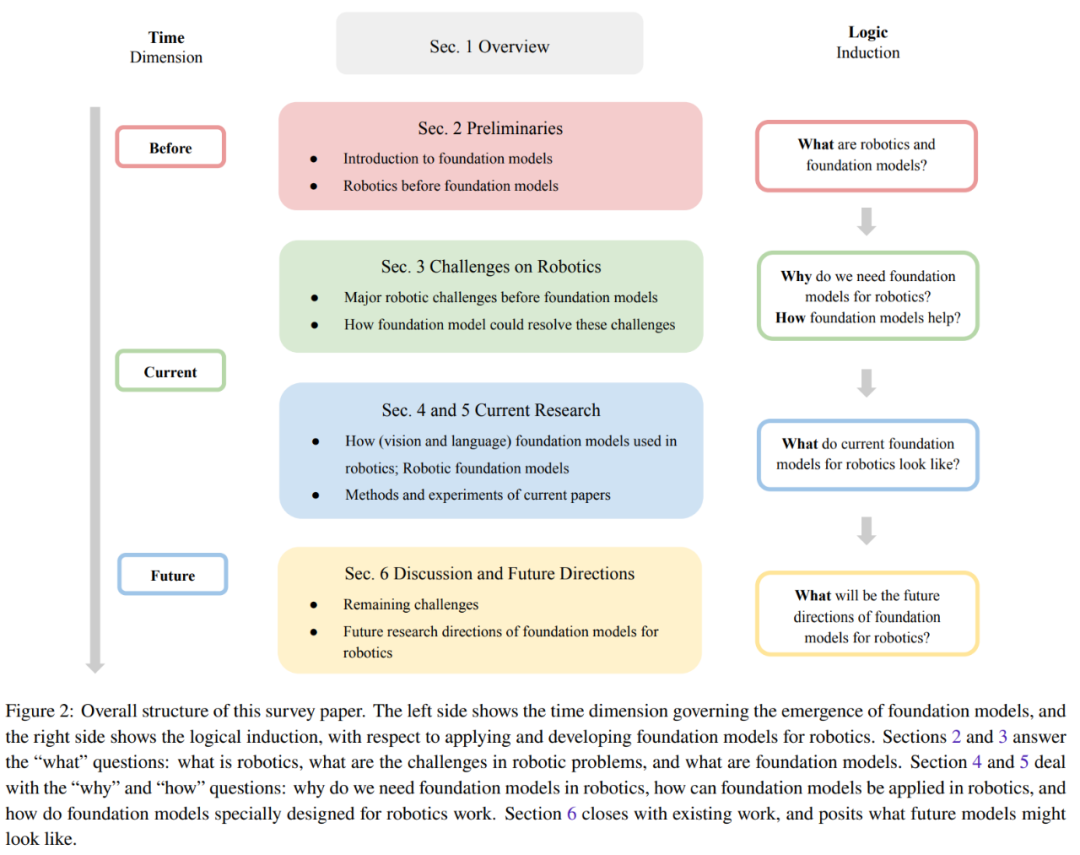

Dieser Abschnitt fasst die fünf zentralen Herausforderungen zusammen, denen sich verschiedene Module eines typischen Robotersystems gegenübersehen. Abbildung 3 zeigt die Einordnung dieser fünf Herausforderungen.

Robotersysteme haben oft Schwierigkeiten, ihre Umgebung genau zu erfassen und zu verstehen. Ihnen fehlt auch die Fähigkeit, Trainingsergebnisse einer Aufgabe auf eine andere zu übertragen, was ihren Nutzen in der realen Welt weiter einschränkt. Darüber hinaus ist es aufgrund der unterschiedlichen Roboterhardware auch schwierig, das Modell auf verschiedene Roboterformen zu übertragen. Das Generalisierungsproblem kann teilweise durch die Verwendung des Basismodells für Roboter gelöst werden.

Und weitere Fragen wie die Verallgemeinerung auf verschiedene Roboterformen müssen noch beantwortet werden.

Um zuverlässige Robotermodelle zu entwickeln, sind qualitativ hochwertige Daten in großem Maßstab von entscheidender Bedeutung. Es gibt bereits Bemühungen, umfangreiche Datensätze aus der realen Welt zu sammeln, darunter automatisierte Werte, Roboterbetriebsbahnen und mehr. Und das Sammeln von Roboterdaten aus menschlichen Demonstrationen ist teuer. Und aufgrund der Vielfalt der Aufgaben und Umgebungen wird der Prozess der Erfassung ausreichender und umfassender Daten in der realen Welt noch komplizierter. Darüber hinaus bestehen Sicherheitsbedenken hinsichtlich der Erfassung von Daten in der realen Welt.

Um diesen Herausforderungen zu begegnen, haben viele Forschungsarbeiten versucht, synthetische Daten in simulierten Umgebungen zu generieren. Diese Simulationen können eine äußerst realistische virtuelle Welt schaffen, die es Robotern ermöglicht, ihre Fähigkeiten in nahezu realen Szenarien zu erlernen und anzuwenden. Allerdings weist die Verwendung simulierter Umgebungen auch Einschränkungen auf, insbesondere im Hinblick auf die Vielfalt der Objekte, was eine direkte Übertragung der erlernten Fähigkeiten auf reale Situationen erschwert.

Außerdem ist es in der realen Welt sehr schwierig, Daten in großem Maßstab zu sammeln, und es ist noch schwieriger, die Bild-/Textdaten im Internetmaßstab zu sammeln, die zum Trainieren des Basismodells verwendet werden.

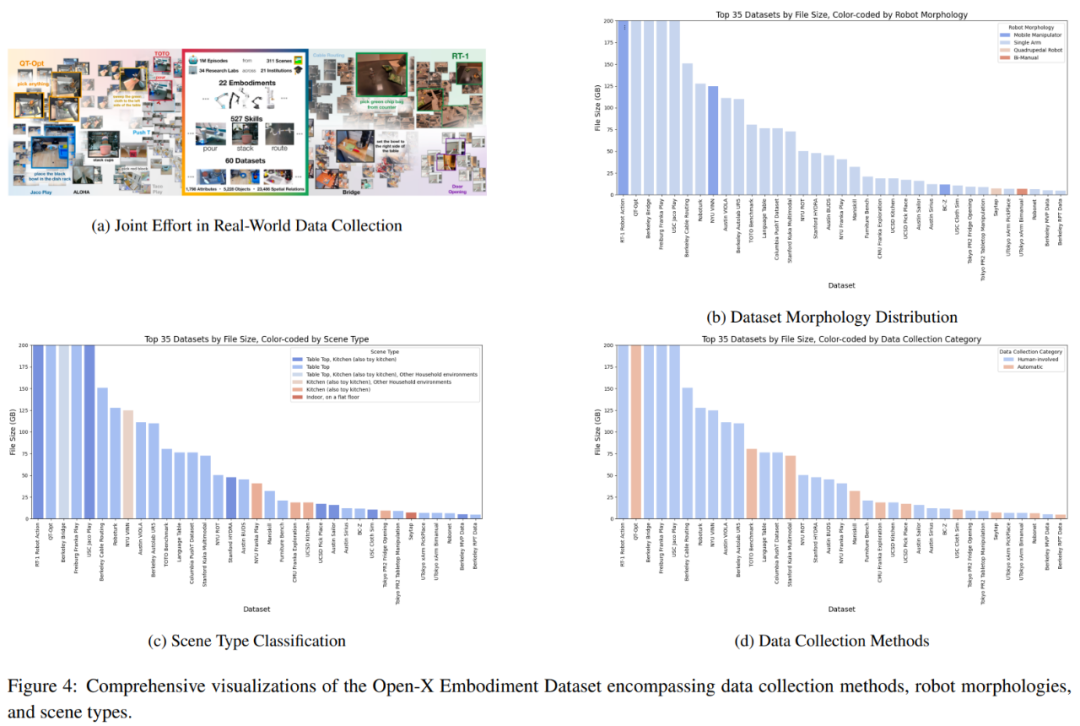

Ein vielversprechender Ansatz ist die kollaborative Datenerfassung, bei der Daten aus verschiedenen Laborumgebungen und Robotertypen gemeinsam gesammelt werden, wie in Abbildung 4a dargestellt. Das Team warf jedoch einen detaillierten Blick auf den Open-X-Embodiment-Datensatz und stellte fest, dass es hinsichtlich der Verfügbarkeit der Datentypen einige Einschränkungen gab.

Klassische Planungs- und Steuerungsmethoden erfordern in der Regel sorgfältig entworfene Umgebungs- und Robotermodelle. Frühere lernbasierte Methoden (z. B. Nachahmungslernen und Verstärkungslernen) trainierten Richtlinien in einer End-to-End-Methode, d. Diese Methoden können das Problem, sich auf explizite Modelle zu verlassen, teilweise lösen, es ist jedoch oft schwierig, sie auf verschiedene Umgebungen und Aufgaben zu übertragen.

Dies führt zu zwei Fragen: (1) Wie lernt man eine modellunabhängige Richtlinie, die sich gut verallgemeinern lässt? (2) Wie lernt man ein gutes Weltmodell, damit klassische modellbasierte Methoden angewendet werden können?

Um einen Allzweckagenten zu erreichen, besteht eine zentrale Herausforderung darin, die Aufgabenspezifikationen zu verstehen und sie im aktuellen Weltverständnis des Roboters zu verankern. Typischerweise werden diese Aufgabenspezifikationen vom Benutzer bereitgestellt, der die Einschränkungen der kognitiven und physischen Fähigkeiten des Roboters nur begrenzt versteht. Dies wirft viele Fragen auf, darunter nicht nur, welche Best Practices für diese Aufgabenspezifikationen bereitgestellt werden können, sondern auch, ob die Erstellung dieser Spezifikationen natürlich und einfach genug ist. Es ist auch eine Herausforderung, Unklarheiten in den Aufgabenspezifikationen zu verstehen und zu lösen, basierend auf dem Verständnis des Roboters über seine Fähigkeiten.

Beim Einsatz von Robotern in der realen Welt besteht eine zentrale Herausforderung im Umgang mit der Unsicherheit, die der Umgebung und den Aufgabenspezifikationen innewohnt. Abhängig von der Quelle kann Unsicherheit in epistemische Unsicherheit (durch mangelndes Wissen verursachte Unsicherheit) und zufällige Unsicherheit (umgebungsinhärenter Lärm) unterteilt werden.

Die Kosten der Unsicherheitsquantifizierung (UQ) können so hoch sein, dass Forschung und Anwendungen nicht nachhaltig sind, und sie können auch verhindern, dass nachgelagerte Aufgaben optimal gelöst werden. Angesichts der stark überparametrisierten Natur des zugrunde liegenden Modells ist es für die Erzielung von Skalierbarkeit ohne Einbußen bei der Modellgeneralisierungsleistung von entscheidender Bedeutung, UQ-Methoden bereitzustellen, die das Trainingsschema beibehalten und gleichzeitig die zugrunde liegende Architektur so wenig wie möglich ändern. Die Entwicklung von Robotern, die zuverlässige Schätzungen ihres eigenen Verhaltens liefern und im Gegenzug auf intelligente Weise klar formuliertes Feedback anfordern können, bleibt eine ungelöste Herausforderung.

Trotz einiger jüngster Fortschritte bleibt es eine Herausforderung, sicherzustellen, dass Roboter aus Erfahrungen lernen, ihre Strategien verfeinern und in neuen Umgebungen sicher bleiben können.

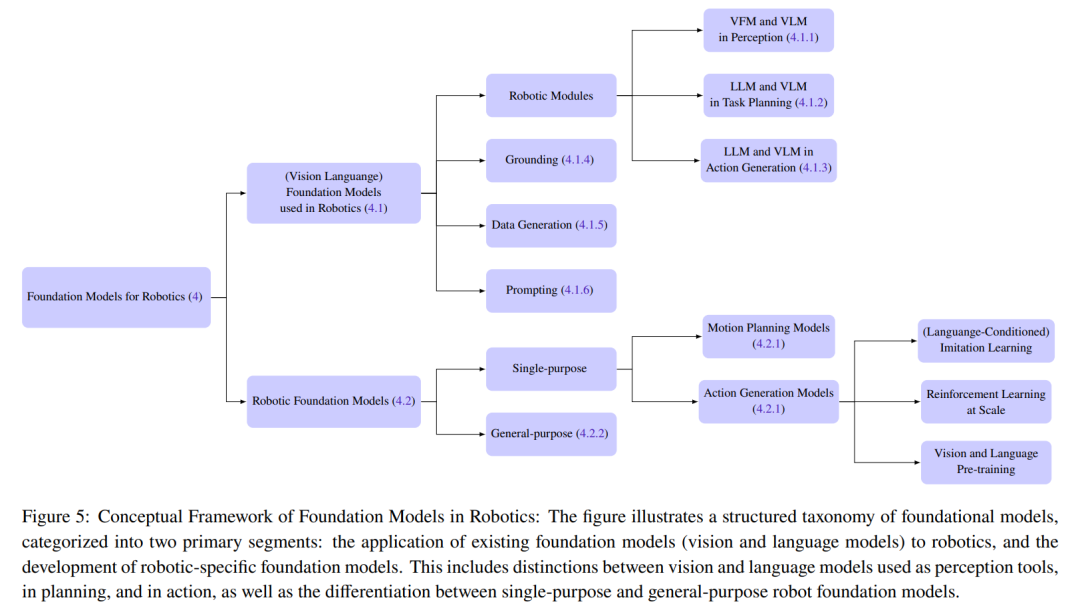

Dieser Abschnitt fasst die aktuellen Forschungsmethoden zusammen, die für das Basismodell des Roboters verwendet werden. Das Team teilte die im Bereich der Robotik verwendeten Grundmodelle in zwei Hauptkategorien ein: Grundmodelle für Roboter und Roboter-Grundmodelle (RFM).

Das Grundmodell für Roboter bezieht sich hauptsächlich auf die Verwendung der visuellen und sprachlichen Grundmodelle für Roboter im Zero-Sample-Verfahren, was bedeutet, dass keine zusätzliche Feinabstimmung oder Schulung erforderlich ist. Das Roboterbasismodell kann mithilfe der Vision-Language-Pre-Training-Initialisierung warmgestartet werden und/oder das Modell kann direkt auf dem Roboterdatensatz trainiert werden.

Abbildung 5 zeigt die Klassifizierungsdetails

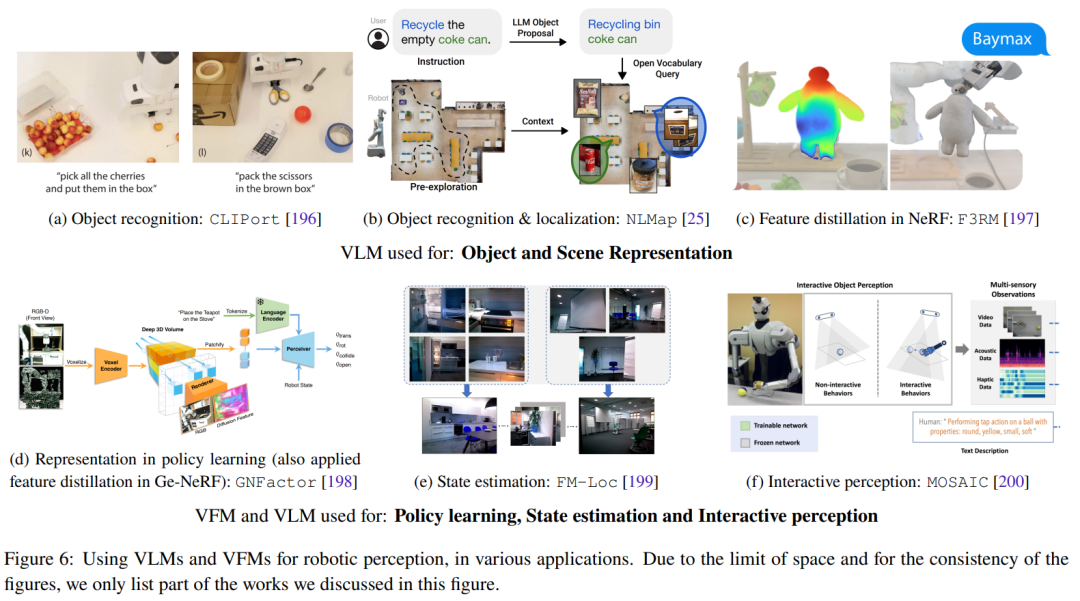

Dieser Abschnitt konzentriert sich auf die Zero-Shot-Anwendung visueller und sprachlicher Grundmodelle im Bereich der Robotik. Dazu gehört vor allem der Zero-Shot-Einsatz von VLM in Roboterwahrnehmungsanwendungen unter Nutzung der Kontextlernfähigkeiten von LLM für die Planung und Aktionsgenerierung auf Aufgaben- und Bewegungsebene. Abbildung 6 zeigt einige repräsentative Forschungsarbeiten. 2. Roboter-Fundamentalmodell (RFM) Das Modell (RFM )-Kategorie wird auch immer wahrscheinlicher, erfolgreich zu sein. Diese Modelle nutzen Roboterdaten, um das Modell für die Lösung von Roboteraufgaben zu trainieren.

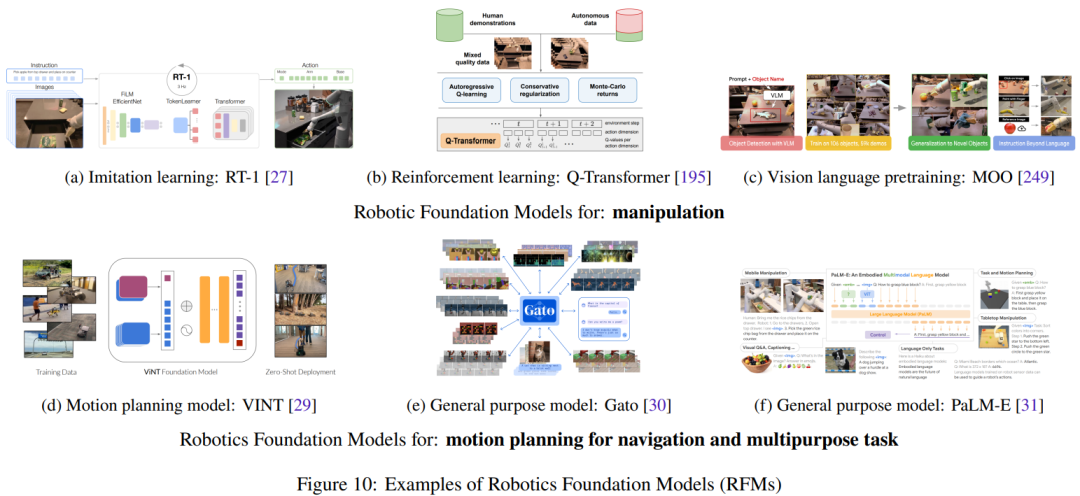

In diesem Abschnitt werden die verschiedenen Arten von RFM zusammengefasst und besprochen. Das erste ist ein RFM, das eine Art Aufgabe in einem einzelnen Robotermodul ausführen kann, das auch als Einzelobjektiv-Roboterbasismodell bezeichnet wird. RFM kann beispielsweise Aktionen auf niedriger Ebene zur Steuerung des Roboters oder Modelle generieren, die eine Bewegungsplanung auf höherer Ebene generieren können.

Die fünf größten Herausforderungen, vor denen der Bereich Robotik steht, sind oben aufgeführt. In diesem Abschnitt wird beschrieben, wie Basismodelle zur Bewältigung dieser Herausforderungen beitragen können.

Die fünf größten Herausforderungen, vor denen der Bereich Robotik steht, sind oben aufgeführt. In diesem Abschnitt wird beschrieben, wie Basismodelle zur Bewältigung dieser Herausforderungen beitragen können.

Alle Grundmodelle im Zusammenhang mit visuellen Informationen (wie VFM, VLM und VGM) können im Wahrnehmungsmodul des Roboters verwendet werden. LLM hingegen ist vielseitiger und kann zur Planung und Steuerung eingesetzt werden. Das Robot Basic Model (RFM) wird typischerweise in Planungs- und Aktionsgenerierungsmodulen verwendet. Tabelle 1 fasst die zugrunde liegenden Modelle zur Lösung verschiedener Robotikherausforderungen zusammen.

Wie aus der Tabelle ersichtlich ist, sind alle Grundmodelle gut darin, die Aufgaben verschiedener Robotermodule zu verallgemeinern. LLM ist besonders gut in der Aufgabenspezifikation. RFM hingegen ist gut im Umgang mit den Herausforderungen dynamischer Modelle, da es sich bei den meisten RFMs um modellfreie Ansätze handelt. Für die Roboterwahrnehmung sind Generalisierungsfähigkeiten und Modellherausforderungen miteinander gekoppelt, denn wenn das Wahrnehmungsmodell bereits über gute Generalisierungsfähigkeiten verfügt, besteht keine Notwendigkeit, weitere Daten zu erfassen, um Domänenanpassungen oder zusätzliche Feinabstimmungen durchzuführen.

Darüber hinaus mangelt es noch an Forschung zu Sicherheitsherausforderungen, die eine wichtige zukünftige Forschungsrichtung sein werden.

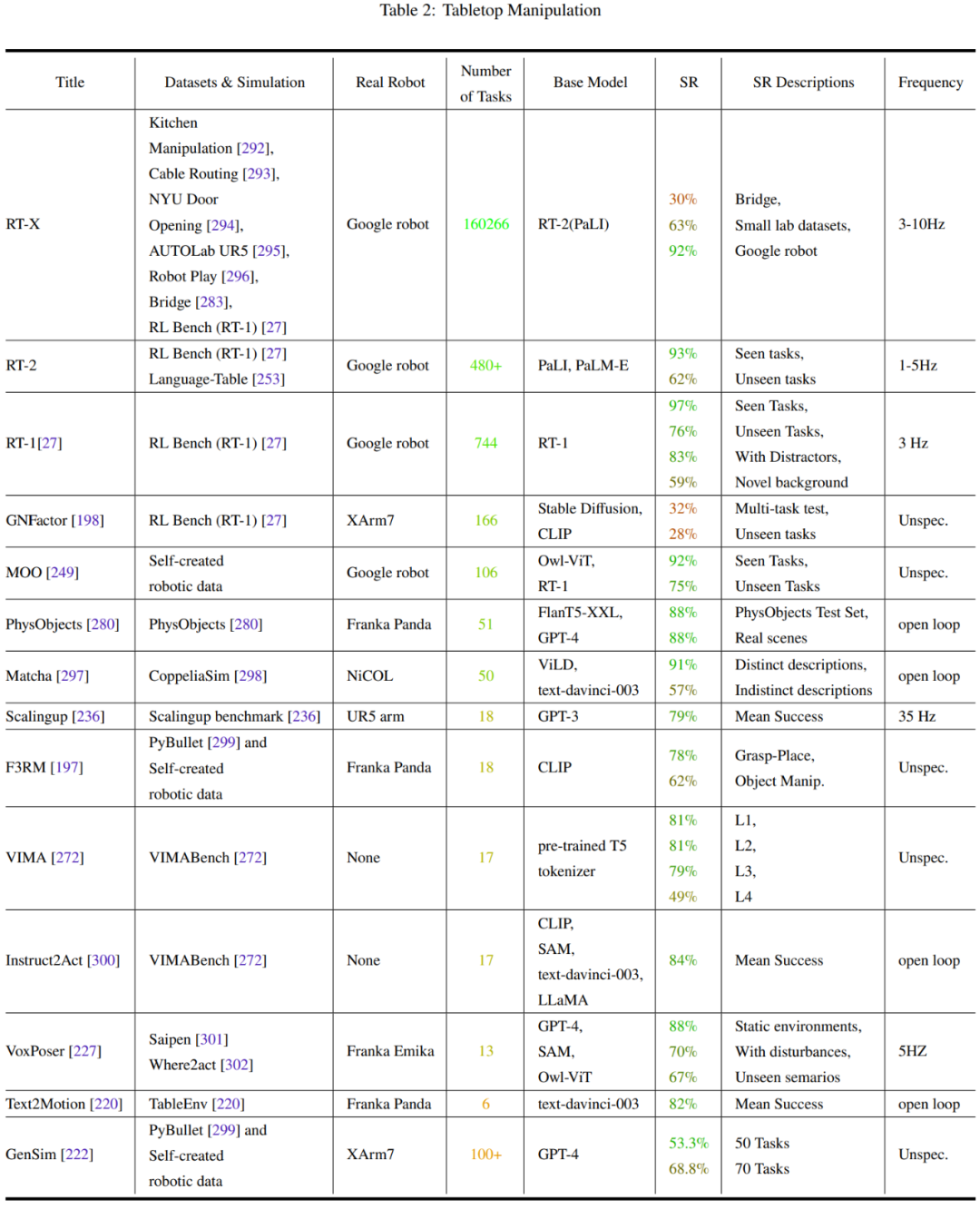

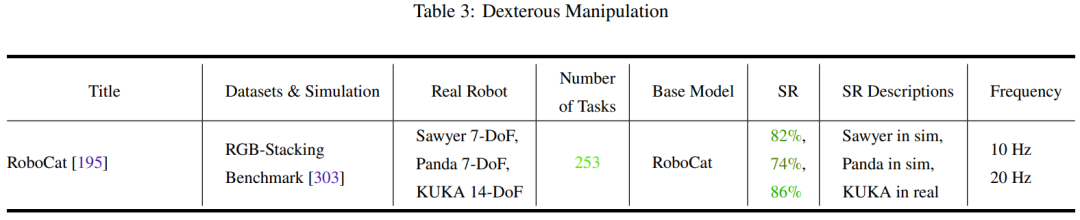

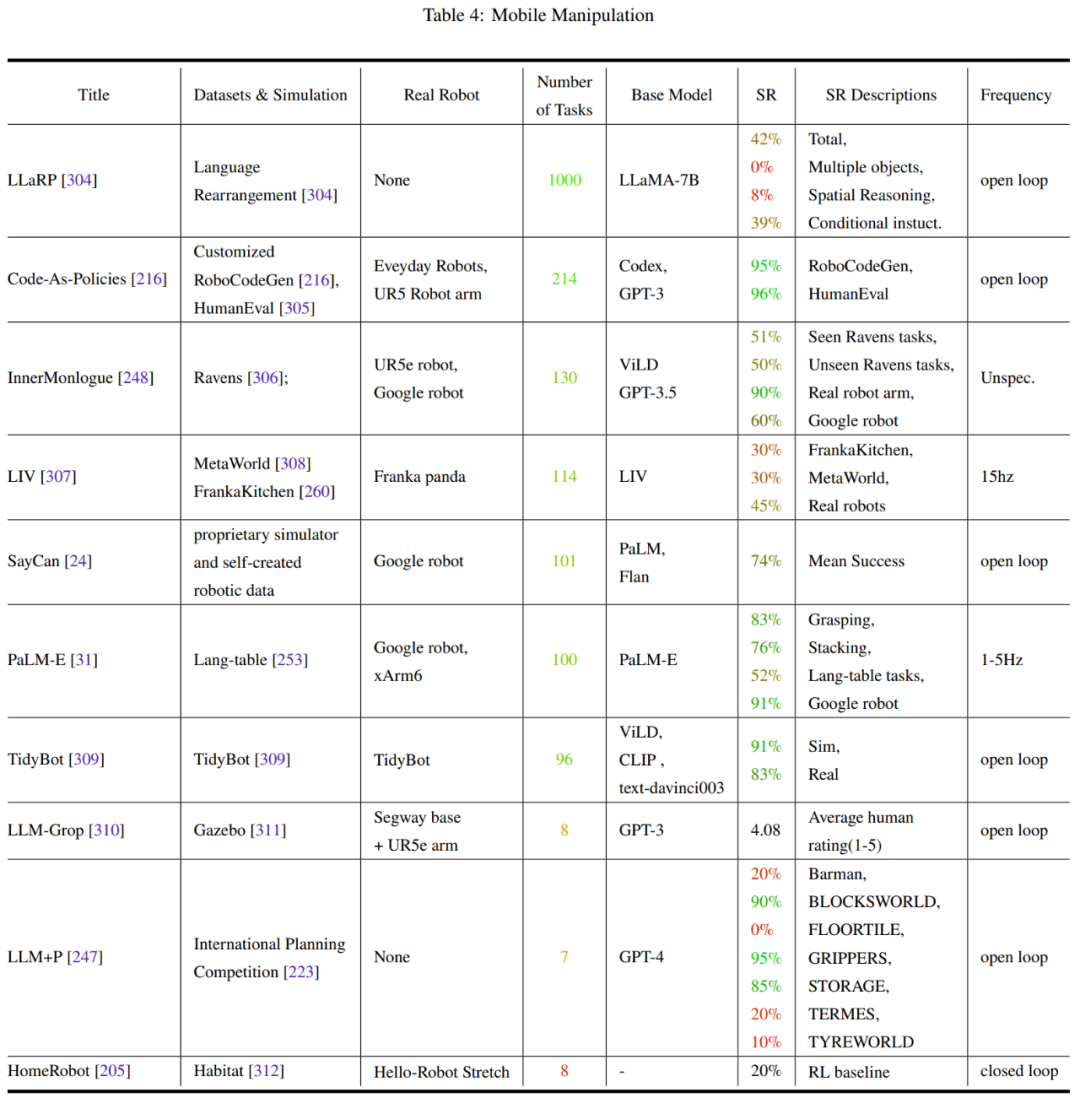

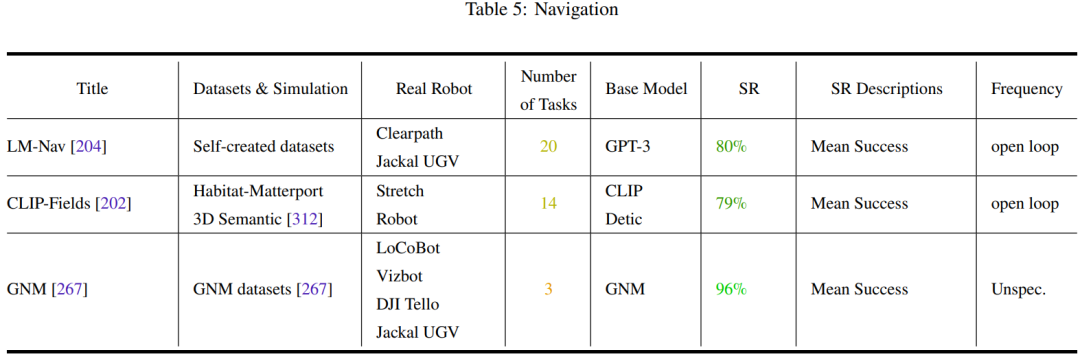

Dieser Abschnitt fasst die aktuellen Forschungsergebnisse zu Datensätzen, Benchmarks und Experimenten zusammen.

Es gibt Einschränkungen, sich ausschließlich auf Wissen zu verlassen, das aus Sprach- und visuellen Datensätzen gewonnen wird. Wie einige Forschungsergebnisse zeigen, können einige Konzepte wie Reibung und Gewicht nicht einfach durch diese Modalitäten allein erlernt werden.

Damit Roboteragenten die Welt besser verstehen können, adaptiert die Forschungsgemeinschaft nicht nur grundlegende Modelle aus den Bereichen Sprache und Sehen, sondern treibt auch die Entwicklung großer und vielfältiger multimodaler Roboter voran, um diese zu trainieren und zu verfeinern Modelle.

Derzeit sind diese Bemühungen in zwei Hauptrichtungen unterteilt: das Sammeln von Daten aus der realen Welt und das Sammeln von Daten aus der simulierten Welt und deren anschließende Migration in die reale Welt. Jede Richtung hat ihre Vor- und Nachteile. Zu den aus der realen Welt gesammelten Datensätzen gehören RoboNet, Bridge Dataset V1, Bridge-V2, Language-Table, RT-1 usw. Zu den häufig verwendeten Simulatoren gehören Habitat, AI2THOR, Mujoco, AirSim, Arrival Autonomous Racing Simulator, Issac Gym usw.

Ein weiterer wichtiger Beitrag dieses Teams ist eine Metaanalyse der Experimente in den in diesem Übersichtsbericht erwähnten Arbeiten, die den Autoren helfen kann, die folgenden Probleme zu klären:

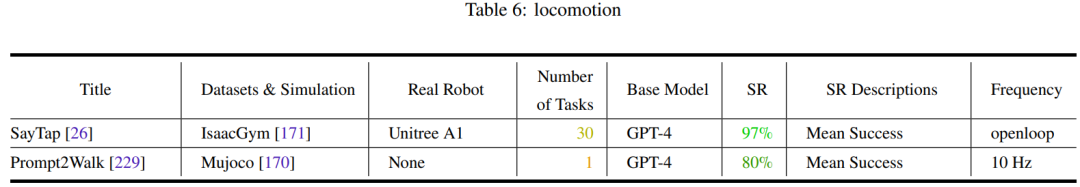

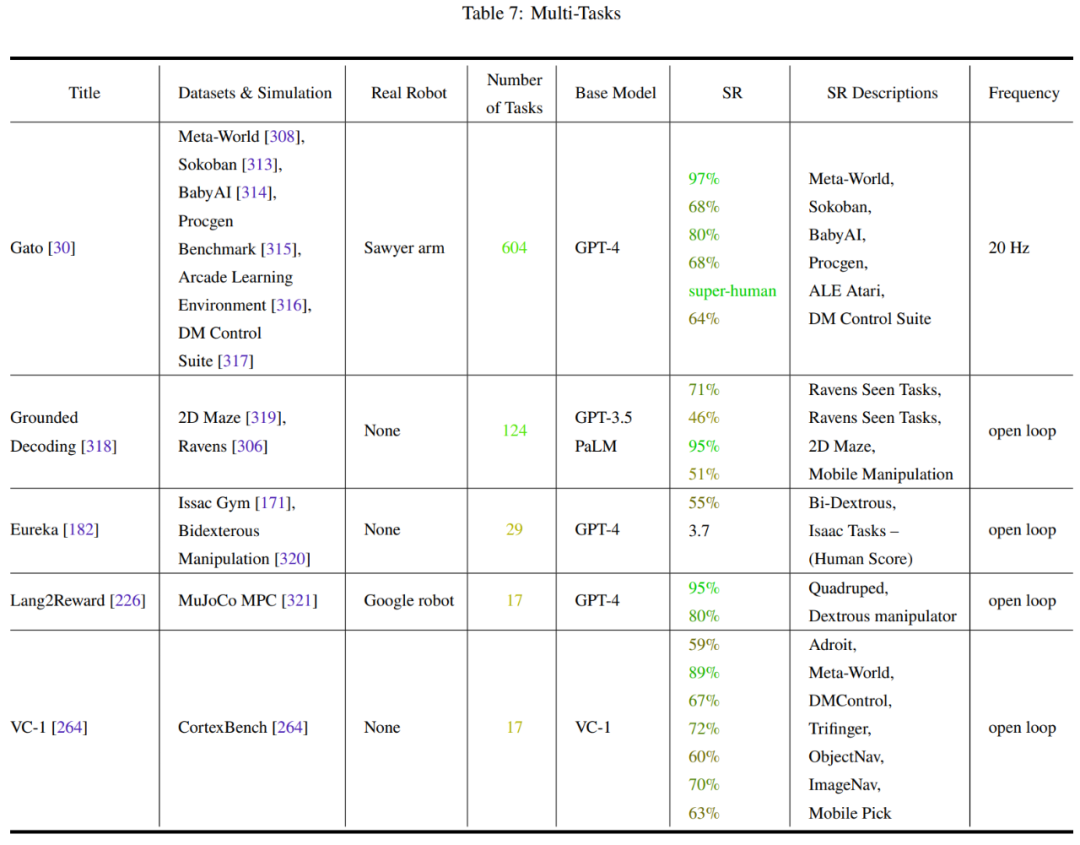

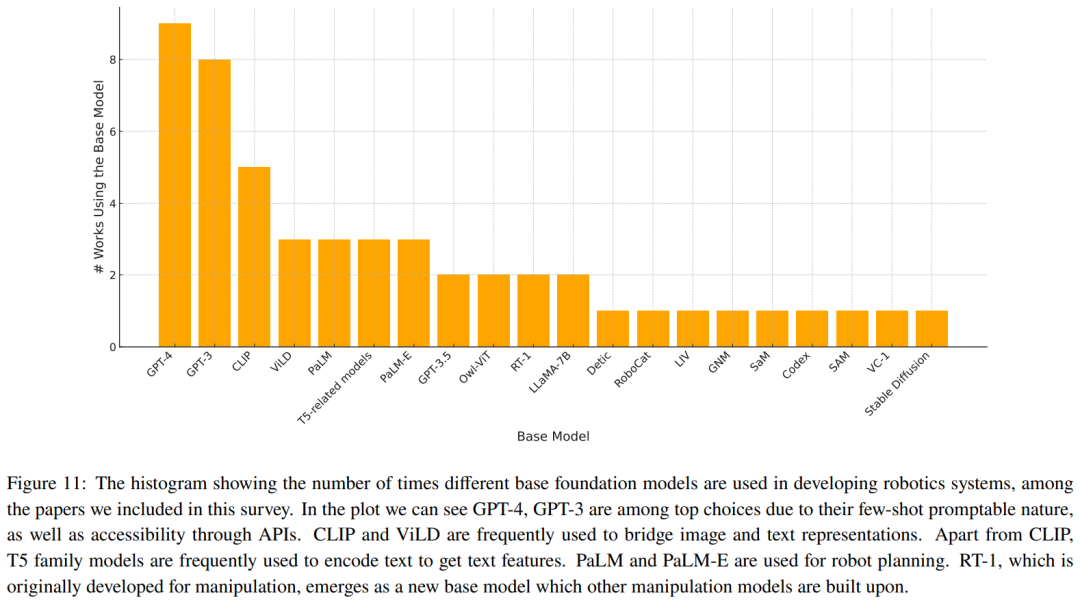

Tabelle 2-7 und Abbildung 11 geben die Analyseergebnisse wieder.

Das Team hat einige wichtige Trends identifiziert:

Das Team hat einige Herausforderungen zusammengefasst, die noch gelöst werden müssen, und Forschungsrichtungen, die eine Diskussion wert sind:

Festlegung einer Standardbasis für die Roboterverkörperung (Erdung) ) Sicherheit und UnsicherheitSind End-to-End-Ansätze und modulare Ansätze unvereinbar?Das obige ist der detaillierte Inhalt vonRobotik: Wie läuft das Basismodell?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!