Herausgeber |. Rettichhaut

In den letzten Jahrhunderten haben Forscher nach Möglichkeiten gesucht, verschiedene Wissensgebiete zu verbinden. Mit dem Aufkommen der künstlichen Intelligenz haben wir nun die Möglichkeit, Beziehungen zwischen Bereichen (wie Mechanik und Biologie) oder zwischen verschiedenen Bereichen (wie Fehlermechanik und Kunst) zu erforschen.

Um dieses Ziel zu erreichen, hat das Massachusetts Institute of Technology (MIT ) Forscher am Labor für Atom- und Molekularmechanik (LAMM) verwendeten ein fein abgestimmtes großes Sprachmodell (LLM), um eine relevante Teilmenge des Wissens über mehrskaliges Materialversagen zu erhalten

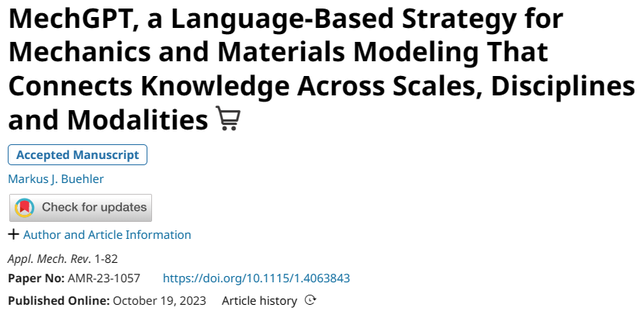

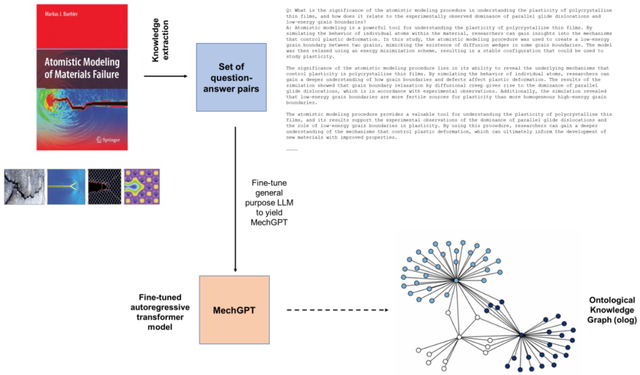

Die Schritte in diesem Ansatz bestehen darin, zunächst A allgemein zu verwenden Zweckmäßiges LLM extrahiert Frage-Antwort-Paare aus der Originalquelle und optimiert dann das LLM. Mit diesem fein abgestimmten MechGPT-LLM-Basismodell wurde eine Reihe von Computerexperimenten durchgeführt, um seine Fähigkeiten beim Wissensabruf, bei verschiedenen Sprachaufgaben, bei der Generierung von Hypothesen und bei der Verknüpfung von Wissen über verschiedene Domänen hinweg zu untersuchen

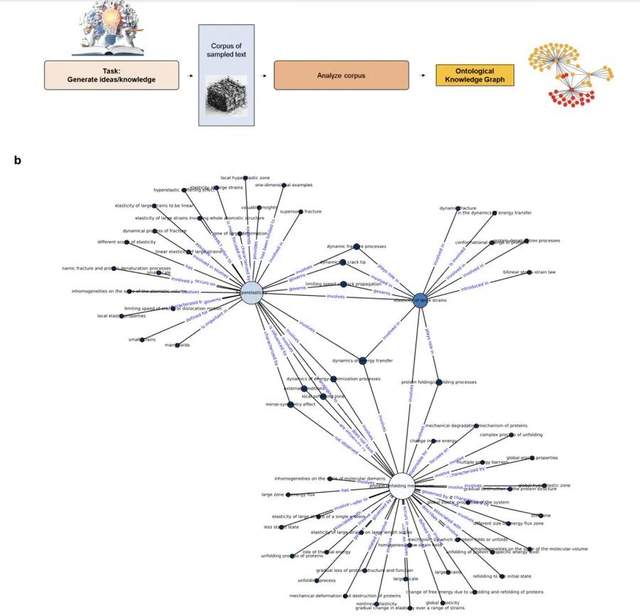

Obwohl das Modell über eine gewisse Fähigkeit verfügt, Trainingswissen abzurufen auf dem Gebiet, aber Forscher fanden heraus, dass LLM für die Gewinnung struktureller Erkenntnisse durch Ontologie-Wissensgraphen aussagekräftiger ist. Diese interpretierbaren Graphstrukturen liefern interpretative Erkenntnisse, Rahmen für neue Forschungsfragen und visuelle Darstellungen von Wissen, die auch für die abrufgestützte Generierung verwendet werden können.

Die Forschung trägt den Titel „MechGPT, eine sprachbasierte Strategie für Mechanik und Materialmodellierung, die Wissen über Skalen, Disziplinen und Modalitäten hinweg verbindet“ und wurde am 19. Oktober 2023 in „Applied Mechanics Reviews“ veröffentlicht.

Die Modellierung physikalischer, biologischer und metaphysischer Konzepte war ein Schwerpunkt von Forschern in vielen Disziplinen. Frühe Wissenschaftler und Ingenieure waren oft tief in Bereichen verwurzelt, die von der Naturwissenschaft über die Philosophie, die Physik bis zur Mathematik und den Künsten reichten (z. B. Galileo Galilei, Leonardo da Vinci, Johann Wolfgang von Goethe), doch mit der Entwicklung der Naturwissenschaften kam es zu einer Spezialisierung heute vorherrschend. Das liegt zum Teil daran, dass bereichsübergreifend eine große Menge an Wissen angesammelt wurde, was den Menschen dazu zwingt, viel Energie in Forschung und Praxis zu investieren.

Heutzutage hat das Aufkommen großer Sprachmodelle (LLM) das Paradigma der wissenschaftlichen Forschung herausgefordert. Es bringt nicht nur neue Modellierungsstrategien auf Basis von künstlicher Intelligenz/maschinellem Lernen mit sich, sondern bietet auch Möglichkeiten, Wissen, Ideen und Konzepte domänenübergreifend zu vernetzen. Diese Modelle können die traditionelle Multiskalenmodellierung für die Analyse und das Design von Schichtmaterialien und viele andere Anwendungen in der Mechanik ergänzen

Abbildung: Schematischer Arbeitsablauf. (Quelle: Paper)

Hier haben LAMM-Forscher ein universelles LLM basierend auf Llama-2 basierend auf OpenOrca-Platypus2-13B entwickelt, das sich auf den kürzlich vorgeschlagenen Einsatz von LLM in der Mechanik- und Materialforschung und -entwicklung konzentriert zur Modellierung von Materialversagen, Multiskalenmodellierung und verwandten Disziplinen.

Der Grund für die Wahl des OpenOrca-Platypus2-13B-Modells liegt darin, dass es bei Schlüsselaufgaben wie Argumentation, Logik, Mathematik/Naturwissenschaften und anderen Disziplinen gute Leistungen erbringt und reichhaltiges, multidisziplinäres Wissen und Wissen bei einer moderaten Modellgröße bereitstellen kann . Allgemeine Konzepte und effiziente Rechenfunktionen

LLM verfügt über leistungsstarke Anwendungen im wissenschaftlichen Bereich. Neben der Möglichkeit, große Datenmengen und komplexe Systeme zu analysieren, wird LLM in den Bereichen Mechanik und Materialwissenschaften zur Simulation und Vorhersage des Verhaltens von Materialien unter verschiedenen Bedingungen, wie mechanischer Beanspruchung, Temperatur und chemischen Wechselwirkungen, eingesetzt. Wie in früheren Arbeiten gezeigt wurde, können Forscher durch das Training von LLMs anhand großer Datensätze aus Molekulardynamiksimulationen Modelle entwickeln, die das Materialverhalten in neuen Situationen vorhersagen können, wodurch der Entdeckungsprozess beschleunigt und der Bedarf an experimentellen Tests verringert wird.

Solche Modelle sind auch für die Analyse wissenschaftlicher Texte wie Bücher und Publikationen sehr effektiv und ermöglichen es Forschern, schnell wichtige Informationen und Erkenntnisse aus großen Datenmengen zu extrahieren. Dies kann Wissenschaftlern dabei helfen, Trends, Muster und Beziehungen zwischen verschiedenen Konzepten und Ideen zu erkennen und neue Hypothesen und Ideen für die weitere Forschung zu generieren.

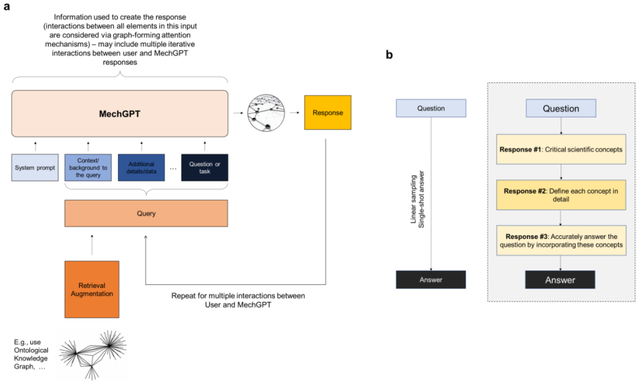

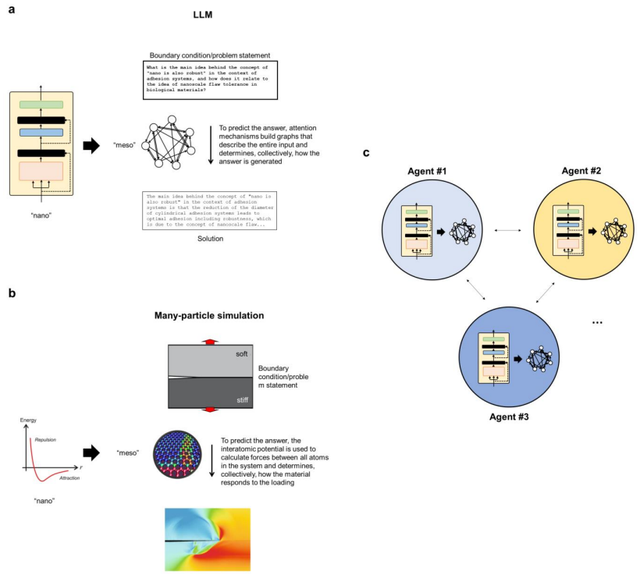

Schauen Sie sich bitte die folgende Abbildung an, die einen Überblick über die autoregressive Decoder-Transformator-Architektur gibt, die zum Erstellen von MechGPT verwendet wird. (Quelle: Papier)

Hier konzentriert sich das Team auf die Entwicklung letzterer und erforscht den Einsatz von MechGPT, einem generativen künstlichen Intelligenztool aus der Transformer-basierten LLM-Familie, das speziell auf Materialversagen und damit verbundene Schulungen zu mehrskaligen Methoden ausgerichtet ist, um das Potenzial dieser Strategien zu bewerten .

Die in dieser Studie vorgeschlagene Strategie besteht aus mehreren Schritten. Zunächst erfolgt der Destillationsschritt, bei dem Forscher mithilfe von LLM Frage-Antwort-Paare aus Text generieren, der aus Rohdatenblöcken (z. B. einer oder mehreren PDF-Dateien) extrahiert wurde. Anschließend nutzen Sie diese Daten zur Feinabstimmung des Modells im zweiten Schritt. Diese Studie trainierte auch speziell das ursprüngliche MechGPT-Modell und demonstrierte seine Nützlichkeit für den Wissensabruf, allgemeine Sprachaufgaben und die Hypothesengenerierung im Bereich der atomistischen Modellierung von Materialversagen

Abbildung: Übersicht über die verwendete Modellierung. (Quelle: Artikel)

Dieser Artikel stellt eine übergreifende Modellierungsstrategie vor, bei der Forscher spezifische Sprachmodellierungsstrategien anwenden, um Datensätze zu generieren, um Wissen aus Quellen zu extrahieren und neuartige Mechanik- und Materialdatensätze für das Modell zu nutzen. Die Forscher analysierten und diskutierten drei Versionen von MechGPT mit Parametergrößen von 13 Milliarden bis 70 Milliarden und Kontextlängen von mehr als 10.000 Token

Nach einigen allgemeinen Kommentaren zu den Modellen, Tipps und Trainingsmethoden wendeten die Forscher das Modell an und testeten seine Leistung in einer Vielzahl von Umgebungen, einschließlich der Verwendung von LLMs zur Generierung von Ontologiegraphen und der Entwicklung von Erkenntnissen zu komplexen Themen über Disziplinen hinweg, sowie der Agentenmodellierung, bei der mehrere LLMs auf kollaborative oder kontroverse Weise interagieren, um tiefere Einblicke in einen Themenbereich oder eine Antwort darauf zu generieren eine Frage.

Graph: Entwicklung einer ontologischen Wissensgraphdarstellung, um Hyperelastizität im Kontext von Überschallbrüchen und Proteinentfaltungsmechanismen in Beziehung zu setzen. (Quelle: Papier)

Gleichzeitig bietet das Team außerdem einen konzeptionellen Vergleich zwischen Sprachmodellen und Mehrteilchensystemen auf verschiedenen Abstraktionsebenen und erklärt, wie das neue Framework als Mittel zur Extraktion der universellen Beziehungen angesehen werden kann die komplexe Systeme steuern.

Umgeschriebener Inhalt: Das obige Bild zeigt die konzeptionelle Analogie zwischen LLM und Mehrteilchensimulation. (Quelle: Papier)

Insgesamt trägt die in dieser Studie vorgestellte Arbeit zur Entwicklung leistungsfähigerer und allgemeinerer Modelle der künstlichen Intelligenz bei, die dazu beitragen können, die wissenschaftliche Forschung voranzutreiben und komplexe Probleme in bestimmten Anwendungsbereichen zu lösen, wodurch eine eingehende Bewertung der Modellleistung ermöglicht wird . Wie alle Modelle müssen sie sorgfältig validiert werden, und ihr Nutzen liegt im Kontext der gestellten Fragen, ihrer Stärken und Schwächen und der umfassenderen Instrumente, die Wissenschaftlern helfen, Wissenschaft und Technik voranzubringen.

Außerdem müssen KI-Tools als Werkzeuge der wissenschaftlichen Forschung als eine Sammlung von Werkzeugen zum Verstehen, Modellieren und Gestalten der Welt um uns herum betrachtet werden. Da sich KI-Tools rasant weiterentwickeln, eröffnet ihre Anwendung in wissenschaftlichen Kontexten gerade erst neue Möglichkeiten https://twitter.com/llama_index/status/1723379654550245719

Das obige ist der detaillierte Inhalt vonMIT LAMM ist in der Lage, interdisziplinäres Verständnis und Multiskalenmodellierung zu ermöglichen und veröffentlicht das fein abgestimmte große Sprachmodell MechGPT. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!