LoRAShear ist eine neue von Microsoft entwickelte Methode zur Optimierung des Sprachmodells (LLM) und zum Erhalt von Wissen. Es ermöglicht eine Strukturbereinigung, reduziert den Rechenaufwand und verbessert die Effizienz.

LHSPG-Technologie (Lora Half-Space Projected Gradient) unterstützt progressives strukturiertes Bereinigen und dynamische Wissenswiederherstellung. Kann über Abhängigkeitsdiagrammanalyse und Sparsity-Optimierung auf verschiedene LLMs angewendet werden

LoRAPrune kombiniert LoRA mit iterativem strukturiertem Pruning, um eine effiziente Feinabstimmung von Parametern zu erreichen. Selbst bei starkem Bereinigen von LLAMA v1 bleibt die Leistung recht hoch

Im sich entwickelnden Bereich der künstlichen Intelligenz sind Sprachmodellmodelle (LLM) zu einem wichtigen Werkzeug für die Verarbeitung großer Textdatenmengen und den schnellen Abruf relevanter Daten geworden Informationen und Schlüsselwerkzeuge zur Verbesserung der Zugänglichkeit von Wissen. Ihre weitreichenden Auswirkungen reichen von der Verbesserung von Suchmaschinen und Frage-Antwort-Systemen bis hin zur Ermöglichung von Datenanalysen und kommen Forschern, Fachleuten und Wissenssuchenden gleichermaßen zugute.

Das größte Problem besteht derzeit darin, dass LLM das Wissen kontinuierlich aktualisieren muss, um den dynamischen Informationsanforderungen gerecht zu werden. Typischerweise optimieren Entwickler vorab trainierte Modelle mithilfe domänenspezifischer Daten, um sie auf dem neuesten Stand zu halten und die neuesten Erkenntnisse in das Modell einfließen zu lassen. Regelmäßige Aktualisierungen sind für Organisationen und Forscher von entscheidender Bedeutung, um sicherzustellen, dass LLM mit der sich ständig verändernden Informationslandschaft Schritt hält. Allerdings sind die Kosten für die Feinabstimmung hoch und der Zyklus lang

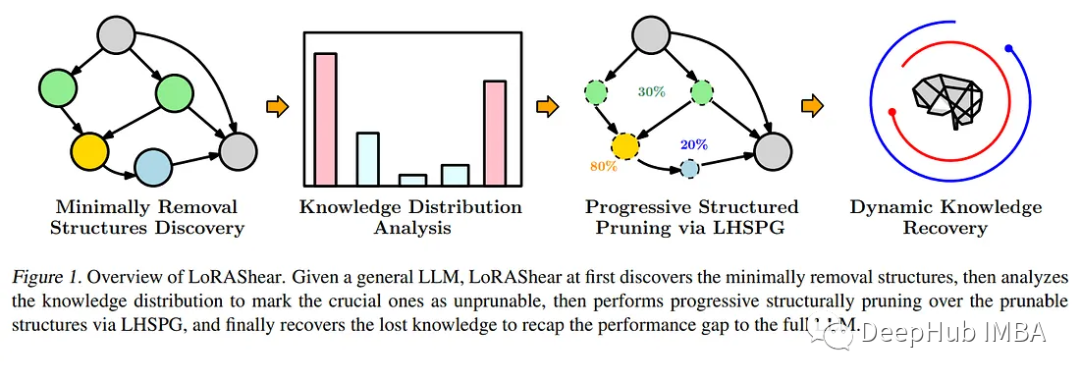

Als Reaktion auf diesen dringenden Bedarf haben Microsoft-Forscher eine bahnbrechende Methode eingeführt – LoRAShear. Dieser innovative Ansatz vereinfacht nicht nur das LLM, sondern erleichtert auch die Wiederherstellung strukturellen Wissens. Der Kern der Strukturbereinigung besteht darin, bestimmte Komponenten in der neuronalen Netzwerkarchitektur zu entfernen oder zu reduzieren, um Effizienz, Kompaktheit und Rechenanforderungen zu optimieren.

Microsofts LoRAShear nutzt die LHSPG-Technologie, um progressives strukturiertes Bereinigen zu unterstützen. Dieser Ansatz kann Wissen nahtlos zwischen LoRA-Modulen übertragen und integriert außerdem eine dynamische Wissenswiederherstellungsphase. Der Feinabstimmungsprozess ähnelt dem Vortraining und der geführten Feinabstimmung, um sicherzustellen, dass das LLM aktuell und relevant bleibt das LoRA-Modul. Die Methode verwendet Original-LLM- und LoRA-Module, um ein Abhängigkeitsdiagramm zu erstellen, und führt einen strukturierten Sparsity-Optimierungsalgorithmus ein, der die Informationen des LoRA-Moduls nutzt, um den Wissenserhalt während des Gewichtsaktualisierungsprozesses zu verbessern

In dem Artikel wird auch An Es wird eine integrierte Technik namens LoRAPrune erwähnt, die LoRA mit iterativem strukturiertem Pruning kombiniert, um eine effiziente Feinabstimmung von Parametern und eine direkte Hardwarebeschleunigung zu erreichen. Diese speichersparende Methode basiert vollständig auf den Gewichten und Gradienten von LoRA für die Bereinigungskriterien. Der spezifische Prozess umfasst die Erstellung eines Tracking-Diagramms, die Bestimmung der Knotengruppen, die komprimiert werden müssen, die Aufteilung der trainierbaren Variablen und schließlich deren Rückgabe an LLM

Das Papier beweist die Wirksamkeit von LoRAShear durch die Implementierung auf dem Open-Source-LLAMAv1. Bemerkenswert ist, dass LLAMAv1 mit 20 % Beschneidung nur einen Leistungsverlust von 1 % erleidet, während das Modell mit 50 % Beschneidung 82 % der Leistung im Bewertungsbenchmark beibehält.

LoRAShear stellt einen großen Fortschritt auf dem Gebiet der künstlichen Intelligenz dar. Es vereinfacht nicht nur die Art und Weise, wie LLM eingesetzt wird, macht es effizienter, sondern gewährleistet auch den Erhalt kritischen Wissens. Es ermöglicht KI-gesteuerten Anwendungen, mit der sich entwickelnden Informationsumgebung Schritt zu halten und gleichzeitig die Rechenressourcen zu optimieren. Da Unternehmen zunehmend auf künstliche Intelligenz für die Datenverarbeitung und den Wissensabruf angewiesen sind, werden Lösungen wie LoRAShear eine Schlüsselrolle auf dem Markt spielen und für Effizienz und Wissensstabilität sorgen.

Papieradresse: https://arxiv.org/abs/2310.18356

Das obige ist der detaillierte Inhalt vonDie neueste Studie von Microsoft untersucht die LoRAShear-Technologie zur LLM-Bereinigung und Wissenswiederherstellung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Anwendung künstlicher Intelligenz im Leben

Anwendung künstlicher Intelligenz im Leben

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?

So richten Sie einen sicheren VPS ein

So richten Sie einen sicheren VPS ein

Einführung in den Eröffnungsort von Win8

Einführung in den Eröffnungsort von Win8

Festplattenwiederherstellungsdaten

Festplattenwiederherstellungsdaten

Was bedeutet MLM-Münze? Wie lange dauert es normalerweise, bis es zusammenbricht?

Was bedeutet MLM-Münze? Wie lange dauert es normalerweise, bis es zusammenbricht?

Einführung in die Verwendung von Rowid in Oracle

Einführung in die Verwendung von Rowid in Oracle

Was sind die grundlegenden Datentypen in PHP?

Was sind die grundlegenden Datentypen in PHP?