Der umgeschriebene Inhalt lautet wie folgt: Machine Heart Report

Herausgeber: Chen Ping, Big Pan Chicken

LeCun sagte, dass die überwiegende Mehrheit der akademischen Kollegen die offene KI-Forschung und -Entwicklung sehr befürworte, es aber immer noch Gegner gebe.

Experten aller Parteien haben unterschiedliche Meinungen zum Thema Risiken durch künstliche Intelligenz. Jemand hat einen gemeinsamen Brief initiiert, in dem er die Labore für künstliche Intelligenz auffordert, die Forschung sofort einzustellen. Geoffrey Hinton und Yoshua Bengio, wichtige Persönlichkeiten des Deep Learning, unterstützen alle diese Ansicht

Erst in den letzten Tagen haben Bengio, Hinton und andere einen gemeinsamen Brief mit dem Titel „Managing Artificial Intelligence Risks in an Era of Rapid Development“ herausgegeben, in dem sie Forscher auffordern, Notfallmaßnahmen zur Governance zu ergreifen und sich auf Sicherheit und ethische Praktiken zu konzentrieren, bevor sie KI-Systeme entwickeln. Fordern Sie die Regierungen auf, Maßnahmen zu ergreifen, um die von der KI ausgehenden Risiken zu bewältigen.Der umgeschriebene Inhalt lautet: In dem Artikel werden einige dringende Governance-Maßnahmen erwähnt, beispielsweise die Einbeziehung nationaler Institutionen, um zu verhindern, dass Menschen künstliche Intelligenz missbrauchen. Für eine wirksame Regulierung benötigen Regierungen ein umfassendes Verständnis der KI-Entwicklungen. Die Regulierungsbehörden sollten eine Reihe von Maßnahmen ergreifen, wie z. B. die Registrierung von Modellen, den wirksamen Schutz der Rechte und Interessen von Whistleblowern sowie die Überwachung der Modellentwicklung und der Nutzung von Supercomputern. Regulierungsbehörden müssen vor dem Einsatz auch fortschrittliche KI-Systeme evaluieren, um ihre potenziell gefährlichen Fähigkeiten zu verstehen

Darüber hinaus hat das Center for the Safety of Artificial Intelligence, eine US-amerikanische Non-Profit-Organisation, im Mai dieses Jahres eine Erklärung herausgegeben, in der es gewarnt hat, dass künstliche Intelligenz mit dem gleichen Risiko behaftet sei Auslöschung der Menschheit als Epidemie Zu den Personen, die diese Aussage unterstützen, gehören auch Hinton, Bengio et al.

Im Mai dieses Jahres kündigte Hinton zudem seinen Job bei Google, um frei über die Risiken künstlicher Intelligenz zu sprechen. In einem Interview mit der New York Times sagte er: „Die meisten Leute denken, dass dies (der Schaden der KI) noch in weiter Ferne liegt. Früher dachte ich, dass es noch in weiter Ferne liegt, vielleicht 30 bis 50 Jahre oder länger. Aber offensichtlich bin ich.“ Das glaube ich jetzt nicht.“

Nach Ansicht von Hinton und anderen ist der Umgang mit den von künstlicher Intelligenz ausgehenden Risiken eine dringende Aufgabe

Trotzdem hat Euan Lecon als einer der drei Giganten des Deep Learning eine sehr optimistische Einstellung zur Entwicklung künstlicher Intelligenz. Er ist grundsätzlich gegen die Unterzeichnung eines gemeinsamen Briefes zu den Risiken künstlicher Intelligenz, da er der Ansicht ist, dass die Entwicklung künstlicher Intelligenz keine Bedrohung für die Menschheit darstellt

Gerade hat LeCun in einer Kommunikation mit X-Benutzern Antworten auf einige Fragen von Internetnutzern zu KI-Risiken gegeben.

Der Inhalt, der neu geschrieben werden muss, ist: https://www.telegraph.co.uk/business/2023/09/23/artificial-intelligence-safety-summit-sunak-ai-experts/

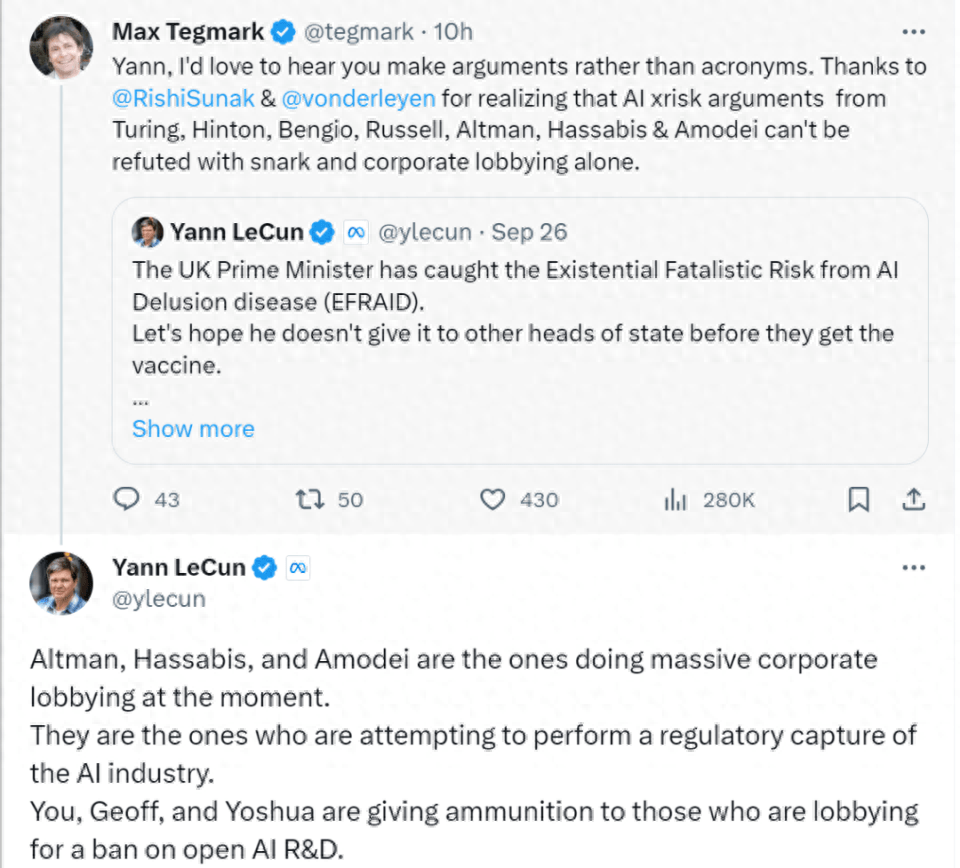

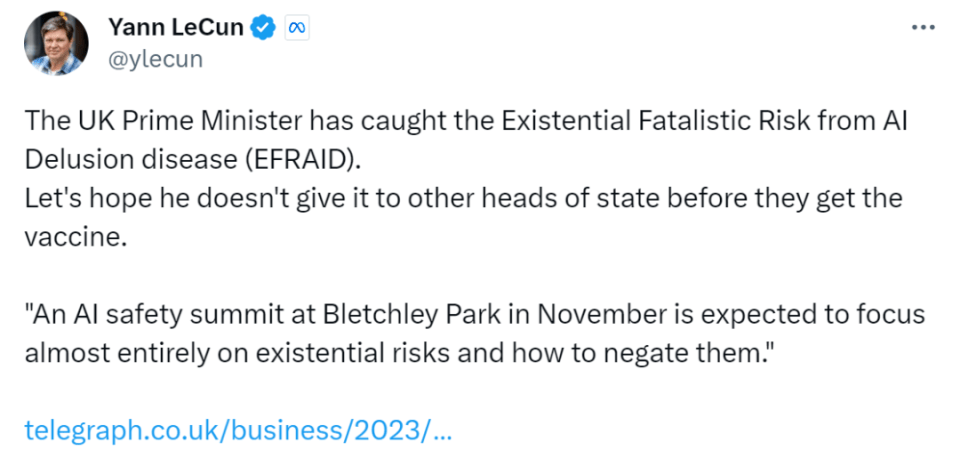

LeCuns Reaktion auf den Artikel war, dass er nicht wollte, dass sich die Bedenken Großbritanniens über die fatalistischen Risiken der KI auf andere Länder ausbreiten.

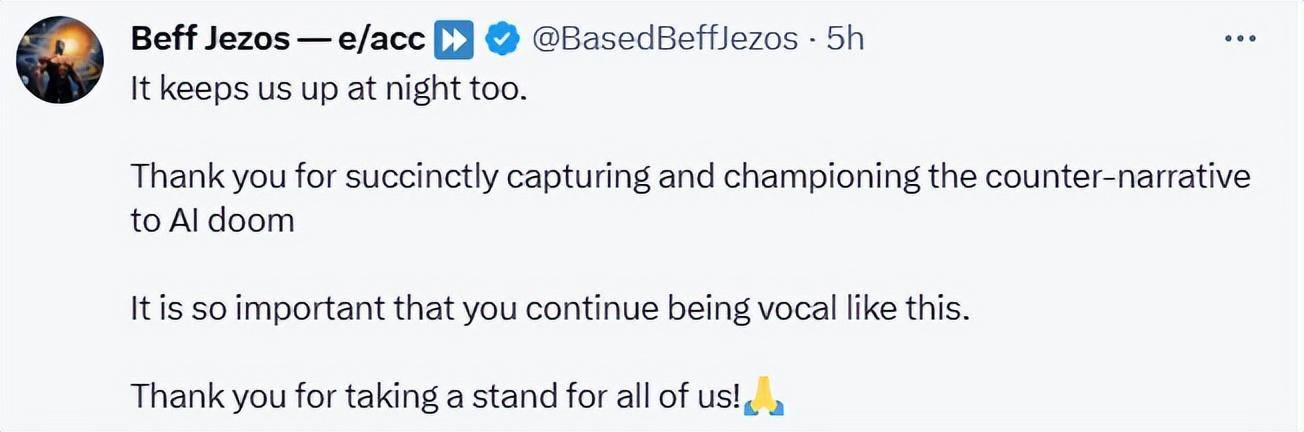

„Altman, Hassabis und Amodei betreiben massive Unternehmenslobbyarbeit. Sie versuchen, die KI-Industrie zu regulieren. Und Sie, Geoff und Yoshua geben denjenigen Munition, die sich für ein Verbot offener KI-Forschung einsetzen.

Wenn Ihre Propagandakampagne erfolgreich ist, wird sie unweigerlich zu dem führen, was unserer Meinung nach katastrophal sein wird: Einige Unternehmen werden die künstliche Intelligenz kontrollieren

Die überwiegende Mehrheit der akademischen Kollegen unterstützt die offene KI-Forschung und -Entwicklung sehr. Nur wenige Menschen glauben an die Weltuntergangsszenarien, die Sie predigen. Sie, Yoshua, Geoff und Stuart sind die einzigen Ausnahmen.

Wie viele andere bin ich ein großer Befürworter offener KI-Plattformen, weil ich an eine Kombination verschiedener Kräfte glaube: die Kreativität der Menschen, die Demokratie, die Marktkräfte und Produktvorschriften. Ich weiß auch, dass es möglich ist, KI-Systeme zu entwickeln, die sicher sind und unter unserer Kontrolle stehen. Hierzu habe ich konkrete Vorschläge gemacht. Dies alles wird dazu führen, dass die Menschen das Richtige tun.

KI entsteht nicht aus dem Nichts, sie ist ein natürliches Phänomen, das außerhalb unserer Kontrolle liegt, aber das ist nicht der Fall. Der Fortschritt wird von jedem vorangetrieben, den wir kennen. Wir und beide haben die Macht, „das Richtige“ zu schaffen. Die Forderung nach einer Regulierung von Forschung und Entwicklung setzt implizit voraus, dass diese Menschen und die Organisationen, denen sie dienen, inkompetent, rücksichtslos, selbstzerstörerisch oder böse sind. Aber das ist nicht der Fall

Ich habe mir viele Argumente ausgedacht, um zu beweisen, dass die Weltuntergangsszenarien, die Sie befürchten, lächerlich sind. Ich werde hier nicht auf Details eingehen. Der wichtigste Punkt ist jedoch, dass leistungsstarke KI-Systeme sicher und kontrollierbar sind, wenn sie von Zielen, einschließlich Leitplanken, gesteuert werden, weil sie diese Leitplanken und Ziele festlegen. (Aktuelle autoregressive Sprachmodelle sind nicht zielorientiert, daher lassen Sie uns nicht aus den Schwächen autoregressiver Sprachmodelle schließen)

Was Open Source betrifft, werden Ihre Aktivitäten genau das Gegenteil von dem bewirken, was Sie verfolgen. Künftig werden Systeme der künstlichen Intelligenz zu einer Fundgrube menschlichen Wissens und unserer Kultur. Wir brauchen eine Open-Source- und kostenlose Plattform, damit jeder dazu beitragen kann. Nur offene Plattformen können das gesamte menschliche Wissen und die gesamte menschliche Kultur widerspiegeln, was erfordert, dass Beiträge auf diesen Plattformen ähnlich wie bei Wikipedia über Crowdsourcing bereitgestellt werden. Wenn die Plattform nicht geöffnet ist, funktioniert dies nicht

Wenn die Open-Source-KI-Plattform reguliert wird, wird es definitiv zu einer anderen Situation kommen, nämlich dass einige Unternehmen die KI-Plattform kontrollieren und damit die gesamte digitale Abhängigkeit der Menschen kontrollieren. Was bedeutet das für die Demokratie? Was bedeutet das für die kulturelle Vielfalt? Das ist es, was mich nachts wach hält. „

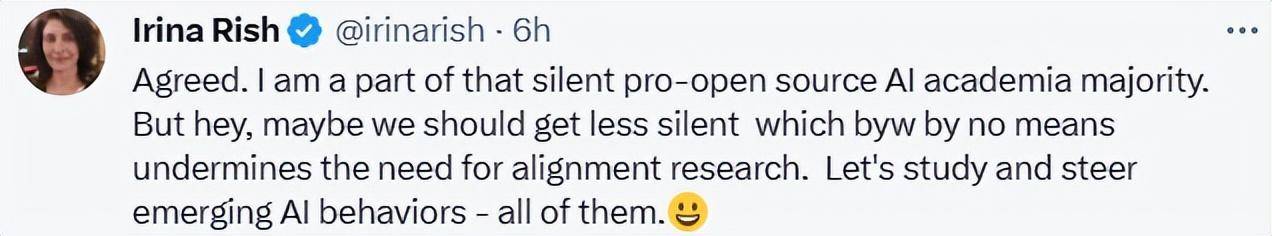

Unter LeCuns langem Tweet „unterstützten“ auch viele Menschen seine Ansichten.

Irina Rish, Professorin am Fachbereich Informatik und Operations Research der Universität Montreal, ist Kernmitglied des Mila-Quebec AI Institute. Ihrer Meinung nach sollten Forscher, die Open-Source-KI unterstützen, nicht länger schweigen, sondern eine führende Rolle bei der Entwicklung neuer KI spielen

Podcast-Moderator Lex Fridman kann sich in dieser Debatte auf mehr freuen.

Das obige ist der detaillierte Inhalt vonTuring-Preisträger argumentieren: LeCun: Bengio, Hinton und andere KI-Aussterbetheorien sind lächerlich. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!