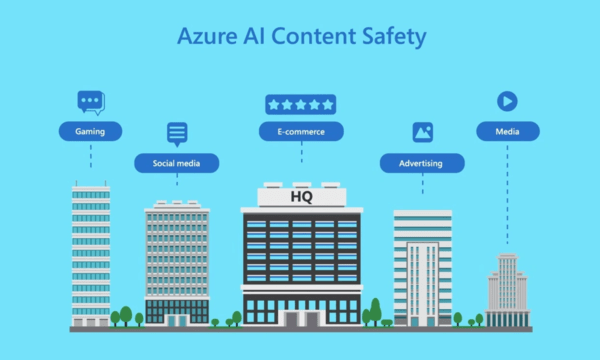

[CNMO News] Nach vielen Monaten des Testens hat Microsoft kürzlich offiziell das KI-Inhaltsüberprüfungstool Azure AI Content Safety veröffentlicht. Es wird berichtet, dass es sich bei diesem Produkt um ein Tool zur Inhaltsmoderation handelt, das im Mai dieses Jahres getestet wurde. Es enthält eine Reihe trainierter KI-Modelle, die negative Inhalte im Zusammenhang mit Vorurteilen, Hass, Gewalt usw. in Bildern oder Texten erkennen können verstehen und erkennen Enthält Bilder oder Text in acht Sprachen.

Darüber hinaus weist das Moderationstool markierten Inhalten einen Schweregrad zu und leitet menschliche Prüfer zu Inhalten, die Maßnahmen erfordern. Ursprünglich war dieses Audit-Tool in den Azure OpenAI-Dienst integriert, nun wird es als eigenständiges System eingeführt

Im offiziellen Blogbeitrag von Microsoft erwähnt: „Dies bedeutet, dass Benutzer es auf Inhalte mit künstlicher Intelligenz anwenden können, die von Open-Source-Modellen und anderen Unternehmensmodellen generiert wurden, und auch einige benutzergenerierte Inhalte aufrufen können, um ihren Nutzen weiter zu verbessern.“

Microsoft sagte, dass sich das Produkt zwar im Umgang mit Daten und Inhalten verbessert hat und den Kontext besser verstehen kann, es sich jedoch immer noch auf menschliche Prüfer verlassen muss, um Daten und Inhalte zu kennzeichnen. Es bedeutet auch, dass die ultimative Gerechtigkeit beim Menschen liegt. Allerdings kann es sein, dass menschliche Gutachter aufgrund persönlicher Vorurteile nicht völlig neutral und umsichtig im Umgang mit Daten und Inhalten sindDas obige ist der detaillierte Inhalt vonMicrosoft veröffentlicht ein KI-Content-Moderationstool namens Azure AI Content Safety. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So kehren Sie von einer HTML-Unterseite zur Startseite zurück

So kehren Sie von einer HTML-Unterseite zur Startseite zurück

Die Rolle von Pycharm

Die Rolle von Pycharm

So beheben Sie Fehler1

So beheben Sie Fehler1

Einführung in Tastenkombinationen zum Minimieren von Windows-Fenstern

Einführung in Tastenkombinationen zum Minimieren von Windows-Fenstern

Detaillierte Erläuterung der Verwendung der Oracle-Substr-Funktion

Detaillierte Erläuterung der Verwendung der Oracle-Substr-Funktion

Welche Plattform ist Kuai Tuan Tuan?

Welche Plattform ist Kuai Tuan Tuan?

WLAN ist verbunden, aber es gibt ein Ausrufezeichen

WLAN ist verbunden, aber es gibt ein Ausrufezeichen

So öffnen Sie eine MDF-Datei

So öffnen Sie eine MDF-Datei