Um den Inhalt neu zu schreiben, ohne die ursprüngliche Bedeutung zu ändern, muss die Sprache ins Chinesische umgeschrieben werden und der ursprüngliche Satz muss nicht erscheinen.

Rezension | Der Inhalt von Chonglou muss neu geschrieben werden Monate, generative künstliche Intelligenz Intelligenz hat mit ihrer Fähigkeit, einzigartige Texte, Töne und Bilder zu erstellen, großes Interesse geweckt. Das Potenzial der generativen KI beschränkt sich jedoch nicht nur auf die Erstellung neuer Daten

Die zugrunde liegenden Techniken der generativen KI (wie Transformer und Diffusionsmodelle) können viele andere Anwendungen unterstützen, einschließlich der Suche und Entdeckung von Informationen. Insbesondere könnte die generative KI die Bildsuche revolutionieren und es Menschen ermöglichen, visuelle Informationen auf eine Weise zu erkunden, die bisher nicht möglich war.

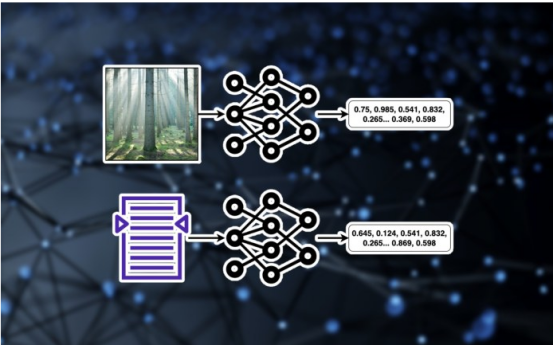

Einbettung von Bildern und Text

Herkömmliche Bildsuchmethoden basieren auf Textbeschreibungen, Tags und anderen Metadaten, die das Bild begleiten, wodurch die Suchoptionen des Benutzers auf Informationen beschränkt werden, die explizit an das Bild angehängt wurden. Personen, die Bilder hochladen, müssen die Art der von ihnen eingegebenen Suchanfragen sorgfältig abwägen, um sicherzustellen, dass ihre Bilder für andere auffindbar sind. Und bei der Suche nach einem Bild muss der Benutzer, der die Informationen abfragt, versuchen, sich vorzustellen, welche Art von Beschreibung der Bild-Uploader dem Bild hinzugefügt haben könnte

Herkömmliche Bildsuchmethoden basieren auf Textbeschreibungen, Tags und anderen Metadaten, die das Bild begleiten, wodurch die Suchoptionen des Benutzers auf Informationen beschränkt werden, die explizit an das Bild angehängt wurden. Personen, die Bilder hochladen, müssen die Art der von ihnen eingegebenen Suchanfragen sorgfältig abwägen, um sicherzustellen, dass ihre Bilder für andere auffindbar sind. Und bei der Suche nach einem Bild muss der Benutzer, der die Informationen abfragt, versuchen, sich vorzustellen, welche Art von Beschreibung der Bild-Uploader dem Bild hinzugefügt haben könnte

Wie das Sprichwort sagt: „Ein Bild sagt mehr als tausend Worte“. Es gibt jedoch Grenzen für das, was über Bildbeschreibungen geschrieben werden kann. Dies lässt sich natürlich auf unterschiedliche Weise beschreiben, je nachdem, wie die Leute das Bild betrachten. Menschen suchen manchmal anhand der Objekte im Bild und manchmal anhand von Merkmalen wie Stil, Licht, Standort usw. nach Bildern. Leider werden Bilder nur selten mit so umfangreichen Informationen versehen. Viele Menschen laden viele Bilder mit wenigen oder gar keinen Informationen hoch, was es schwierig macht, sie bei Suchanfragen zu finden.

Das Herzstück der Bildsuche mit künstlicher Intelligenz und vielen anderen Deep-Learning-Systemen sind Einbettungen. Einbettung ist eine Methode zur numerischen Darstellung verschiedener Datentypen. Beispielsweise enthält ein Bild mit einer Auflösung von 512 x 512 etwa 260.000 Pixel (oder Merkmale). Einbettungsmodelle lernen niedrigdimensionale Darstellungen visueller Daten durch Training an Millionen von Bildern. Das Einbetten von Bildern kann in vielen nützlichen Bereichen angewendet werden, einschließlich der Bildkomprimierung, der Generierung neuer Bilder oder dem Vergleich der visuellen Eigenschaften verschiedener Bilder. Der gleiche Mechanismus funktioniert auch für andere Formen wie Text. Texteinbettungsmodelle sind niedrigdimensionale Darstellungen des Inhalts von Textauszügen. Texteinbettungen haben viele Anwendungen, einschließlich der Verbesserung der Ähnlichkeitssuche und des Abrufs für große Sprachmodelle (LLMs).

Wie die Bildsuche mit künstlicher Intelligenz funktioniert

Aber interessanter wird es, wenn Bild- und Texteinbettungen gemeinsam trainiert werden. Open-Source-Datensätze wie LAION enthalten Millionen von Bildern und die entsprechenden Textbeschreibungen. Wenn Text- und Bildeinbettungen in diesen Bild-/Bildunterschriftenpaaren gemeinsam trainiert oder verfeinert werden, lernen sie den Zusammenhang zwischen visuellen und textlichen Informationen. Dies ist die Idee hinter Deep-Learning-Techniken wie Contrastive Image Language Pretraining (CLIP).

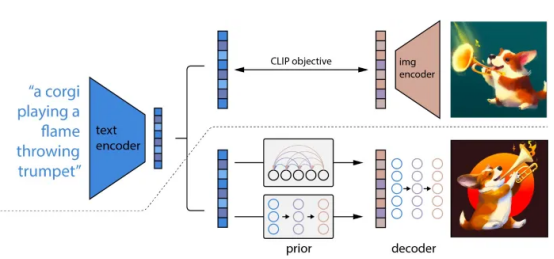

Comparative Language on Image Pre-trained (CLIP)-Modell lernt gemeinsame Einbettungen von Text und Bildern

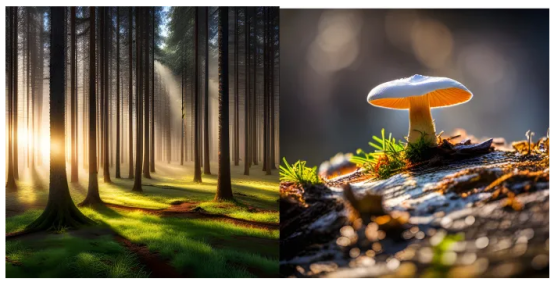

Im obigen Beispiel hat die KI-Suche eine Reihe von Bildern zurückgegeben, deren visuelle Eigenschaften mit dieser Abfrage übereinstimmten. Viele der Textbeschreibungen enthalten nicht die Suchbegriffe. Ihre Einbettung ähnelt jedoch der von Abfragen. Ohne KI-Bildsuche wäre es viel schwieriger, das richtige Bild zu finden.

Manchmal existiert das Bild, nach dem Menschen suchen, nicht und selbst eine KI-Suche kann es nicht finden. In diesem Fall kann generative KI Benutzern auf zwei Arten dabei helfen, die gewünschten Ergebnisse zu erzielen.

Zuerst können wir basierend auf der Anfrage des Benutzers ein neues Bild von Grund auf erstellen. Bei diesem Ansatz wird ein generatives Text-zu-Bild-Modell (z. B. Stable Diffusion oder DALL-E) verwendet, um eine Einbettung für die Anfrage des Benutzers zu erstellen und diese Einbettung zum Generieren des Bildes zu nutzen. Generative Modelle nutzen gemeinsame Einbettungsmodelle wie Contrastive Image Language Pre-Training (CLIP) und andere Architekturen wie Transformers oder Diffusionsmodelle, um eingebettete Werte in atemberaubende Bilder umzuwandeln

DALL-E nutzt Contrastive Image Language Pre-Training (CLIP) und Diffusion, um Bilder aus Text zu generieren

DALL-E nutzt Contrastive Image Language Pre-Training (CLIP) und Diffusion, um Bilder aus Text zu generieren

Die zweite Methode besteht darin, vorhandene Bilder zu nutzen und sie mithilfe eines generativen Modells nach persönlichen Vorlieben zu bearbeiten. Auf einem Bild, das einen Kiefernwald zeigt, fehlen beispielsweise Pilze im Gras. Benutzer können ein geeignetes Bild als Ausgangspunkt auswählen und über ein generatives Modell Pilze hinzufügen

Generative KI schafft ein völlig neues Paradigma, das die Grenzen zwischen Entdeckung und Kreativität verwischt. Und über eine einzige Benutzeroberfläche können Benutzer Bilder finden, Bilder bearbeiten oder völlig neue Bilder erstellen.

Originaltitel: Wie generative KI die Bildsuche neu definiert, Autor: Ben Dickson

Das obige ist der detaillierte Inhalt vonWie generative KI die Bildsuche neu definiert. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Anwendung künstlicher Intelligenz im Leben

Anwendung künstlicher Intelligenz im Leben

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?

Verwendung der Formatierungsfunktion

Verwendung der Formatierungsfunktion

Lösung für den Failedtofetch-Fehler

Lösung für den Failedtofetch-Fehler

So sehen Sie Live-Wiedergabeaufzeichnungen auf Douyin

So sehen Sie Live-Wiedergabeaufzeichnungen auf Douyin

So reparieren Sie eine SQL-Datenbank

So reparieren Sie eine SQL-Datenbank

Lösung für Sitzungsfehler

Lösung für Sitzungsfehler

Browser-Kompatibilität

Browser-Kompatibilität