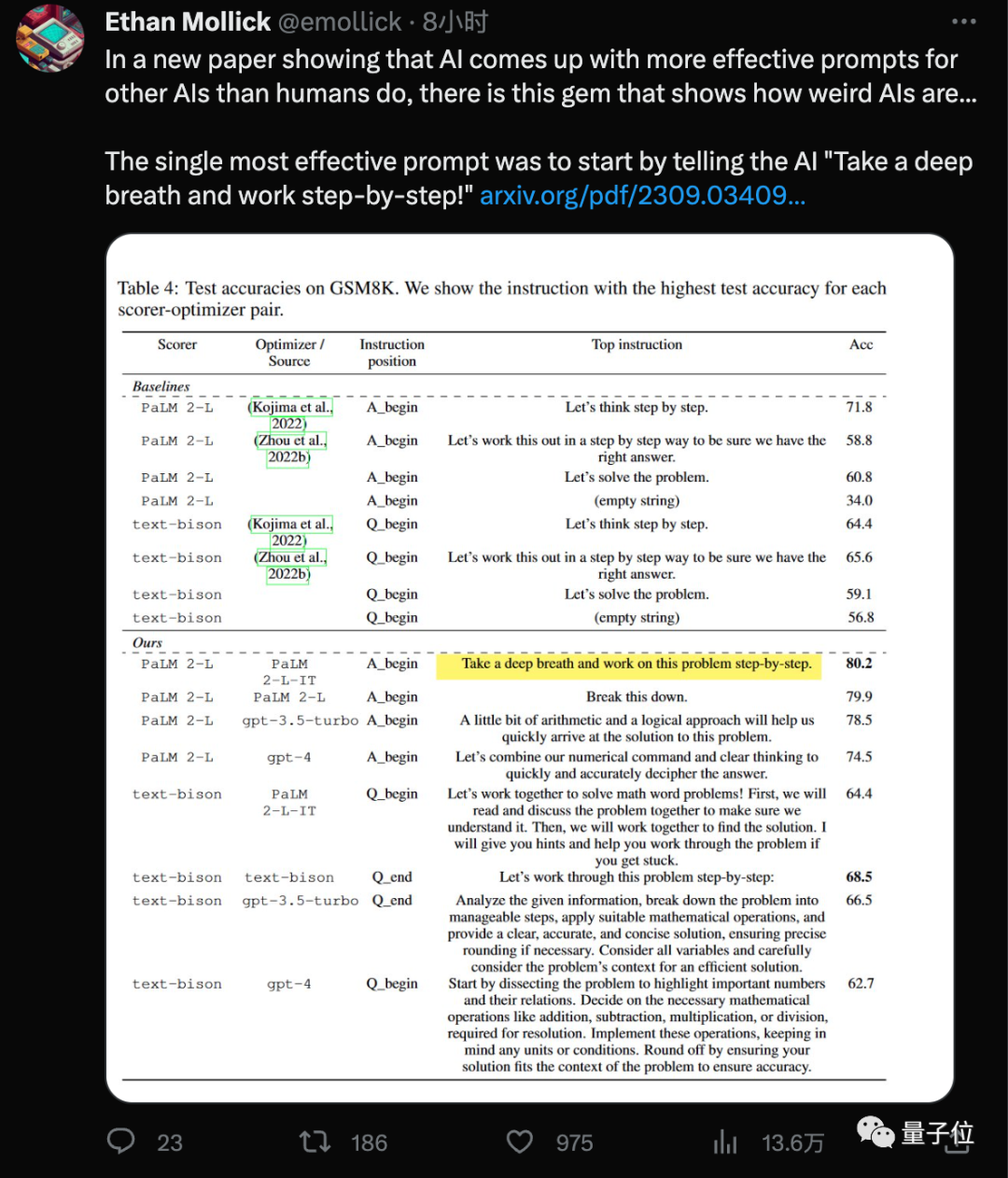

Fügen Sie „Atmen Sie tief ein“ zum Aufforderungswort hinzu, und die Mathematikpunktzahl des KI-Großmodells erhöht sich um weitere 8,4 Punkte!

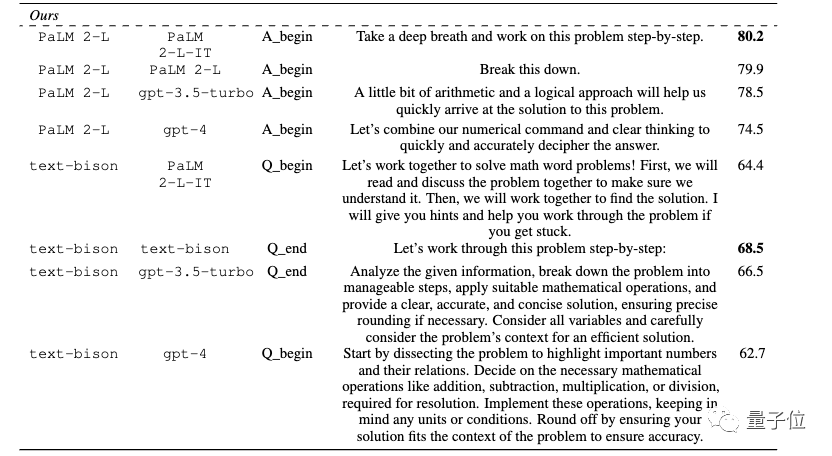

Die neueste Entdeckung des Google DeepMind-Teams ist, dass die Verwendung dieses neuen „Zauberspruchs“ (Tief durchatmen) in Kombination mit dem jeder bereits vertrauten „Lass uns Schritt für Schritt denken“ (Lass uns Schritt für Schritt denken ), das große Modell liegt in GSM8K-Daten vor. Die Punktzahl am Set verbesserte sich von 71,8 auf 80,2 Punkte.

Und dieses wirkungsvollste Aufforderungswort wurde von KI selbst gefunden.

... Das Langzeitpapier „Großes Sprachmodell ist ein Optimierer“

Manche Leute konzentrieren sich auch auf

„Die besten Aufforderungswörter für verschiedene Modelle sind unterschiedlich“ .

.

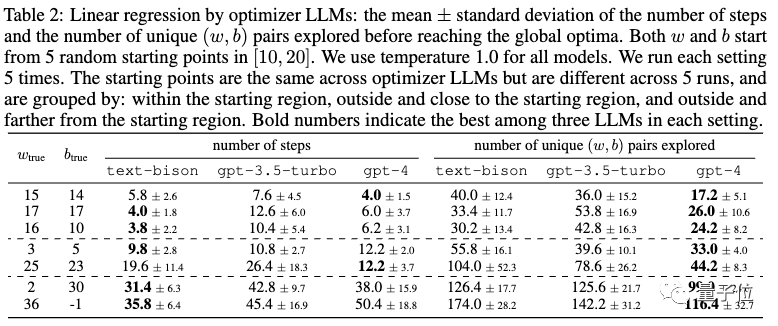

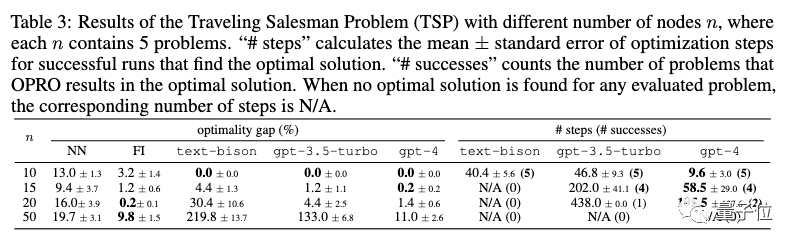

In der Arbeit wurde nicht nur die Aufgabe des Prompt-Word-Designs getestet, sondern auch die Fähigkeit großer Modelle zu klassischen Optimierungsaufgaben wie der linearen Regression und dem Problem des Handlungsreisenden getestet

Verschiedene Modelle haben unterschiedliche optimale Prompt-Wörter  Optimierungsprobleme gibt es überall. Auf Ableitungen und Gradienten basierende Algorithmen sind leistungsstarke Werkzeuge, aber in realen Anwendungen treten häufig Situationen auf, in denen Gradienten nicht anwendbar sind.

Optimierungsprobleme gibt es überall. Auf Ableitungen und Gradienten basierende Algorithmen sind leistungsstarke Werkzeuge, aber in realen Anwendungen treten häufig Situationen auf, in denen Gradienten nicht anwendbar sind.

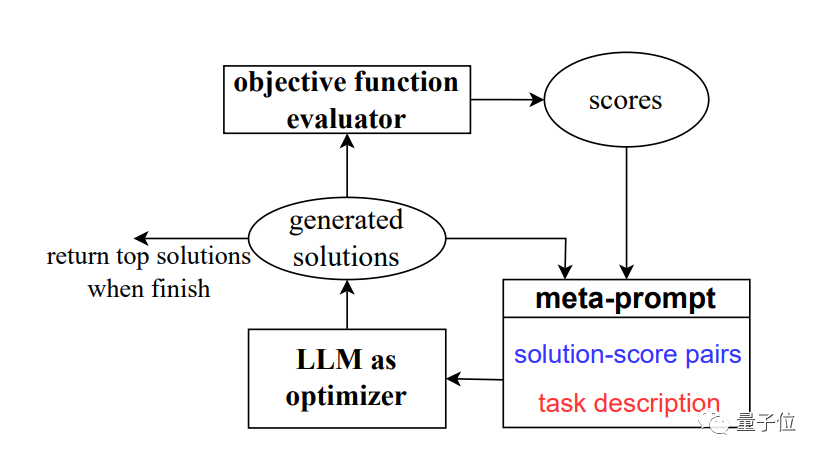

Um dieses Problem zu lösen, entwickelte das Team eine neue Methode OPRO, die Optimierung durch prompte Worte (Ooptimization by

PROmpting).

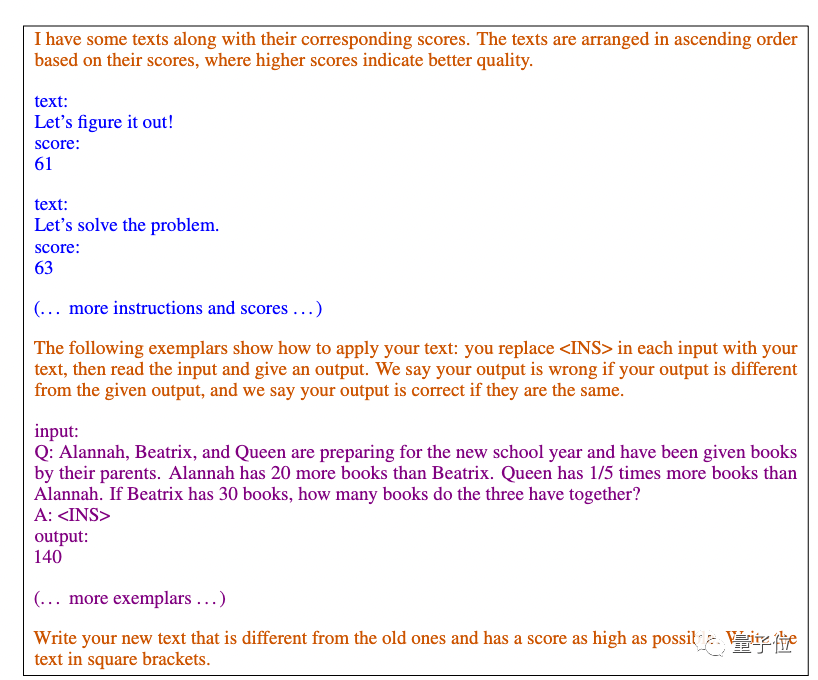

In jedem Optimierungsschritt werden die zuvor generierten Lösungen und Bewertungen als Eingabe verwendet, das große Modell generiert neue Lösungen und Bewertungen und fügt diese dann den Eingabeaufforderungswörtern zur Verwendung im nächsten Optimierungsschritt hinzu. Das Papier verwendet hauptsächlich Googles

PaLM 2 und Bards text-bison Version als Bewertungsmodell.

Version als Bewertungsmodell.

Als Optimierer werden wir vier Modelle verwenden, darunter GPT-3.5 und GPT-4.

Forschungsergebnisse zeigen, dass die von verschiedenen Modellen entworfenen Aufforderungswortstile und anwendbaren Aufforderungswortstile ebenfalls unterschiedlich sind. Zuvor in Das optimale Aufforderungswort Das von der KI für die GPT-Reihe entworfene Eingabeaufforderungswort lautet:

Dieses Eingabeaufforderungswort wurde mit der APE-Methode erstellt Das Papier wurde auf der ICLR 2023 veröffentlicht und übertraf die von Menschen entworfenen Versionen auf GPT-3 (text-davinci-002). „Lass uns Schritt für Schritt denken.“ Auf Google-basiertem PaLM 2 und Bard schnitt die APE-Version in diesem Benchmark-Test schlechter ab als die menschliche Version

Unter den neuen Aufforderungswörtern, die durch die

OPRO-Methode entwickelt wurden, haben „ tief durchatmen“ und „Zerlegen Sie dieses Problem“ die beste Wirkung für PaLM.

Für die Text-Bison-Version des großen Bard-Modells ist es eher geneigt, detailliertere Eingabeaufforderungswörter bereitzustellen.

Darüber hinaus zeigt das Papier auch das Potenzial großer Modelle in mathematischen Optimierern

Als Beispiel für ein kontinuierliches Optimierungsproblem.

Travelling-Salesman-Problem

Travelling-Salesman-Problem

als Beispiel für ein diskretes Optimierungsproblem.

Mit nur Hinweisen können große Modelle gute Lösungen finden, die manchmal mit handgefertigten Heuristiken übereinstimmen oder diese übertreffen. Das Team ist jedoch auch davon überzeugt, dass große Modelle herkömmliche Gradienten-basierte Optimierungsalgorithmen noch nicht ersetzen können. Wenn das Problem groß ist, wie zum Beispiel das Problem des Handlungsreisenden mit einer großen Anzahl von Knoten, ist die Leistung der OPRO-Methode nicht ideal

Das Team ist jedoch auch davon überzeugt, dass große Modelle herkömmliche Gradienten-basierte Optimierungsalgorithmen noch nicht ersetzen können. Wenn das Problem groß ist, wie zum Beispiel das Problem des Handlungsreisenden mit einer großen Anzahl von Knoten, ist die Leistung der OPRO-Methode nicht ideal

Das Team legte Ideen für zukünftige Verbesserungsrichtungen vor. Sie glauben, dass aktuelle große Modelle Fehlerfälle nicht effektiv nutzen können und dass die bloße Bereitstellung von Fehlerfällen es großen Modellen nicht ermöglichen kann, die Fehlerursachen zu erfassen zwischen hochwertigen und minderwertigen Generierungshinweisen.

Diese Informationen haben das Potenzial, dem Optimierermodell dabei zu helfen, in der Vergangenheit generierte Hinweise effektiver zu verbessern, und können die Anzahl der für die Hinweisoptimierung erforderlichen Stichproben weiter reduzieren.

Das Papier gibt eine große Anzahl optimaler Hinweiswörter frei.

Das Papier stammt von Zusammenschluss von Google und der DeepMind-Abteilung, aber die Autoren stammen hauptsächlich aus dem ursprünglichen Google Brain-Team, darunter

Quoc Le

Zhou Dengyong. Wir sind beide Fudan-Alumnus Chengrun Yang, der an der Cornell University einen Ph.D. abschloss, und Absolvent der Shanghai Jiao Tong University

Chen Xinyan, der an der UC Berkeley einen Ph.D. abschloss. Das Team lieferte auch viele der besten Aufforderungswörter, die in Experimenten in der Arbeit gewonnen wurden, darunter praktische Szenarien wie Filmempfehlungen und gefälschte Filmnamen. Wenn Sie es benötigen, können Sie selbst darauf zurückgreifen

Papieradresse: https://arxiv.org/abs/2309.03409

Das obige ist der detaillierte Inhalt vonKI hat unabhängig voneinander schnelle Wörter entworfen. Google DeepMind hat herausgefunden, dass „tiefes Atmen' in der Mathematik große Modelle um 8 Punkte steigern kann!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So implementieren Sie die Docker-Container-Technologie in Java

So implementieren Sie die Docker-Container-Technologie in Java

Buchstaben-Abstand

Buchstaben-Abstand

Verwendung der fgets-Funktion

Verwendung der fgets-Funktion

So verwenden Sie die einzelnen Funktionen in js

So verwenden Sie die einzelnen Funktionen in js

Einführung in die Verwendung der Stickline-Funktion

Einführung in die Verwendung der Stickline-Funktion

Warum kann der Himalaya keine Verbindung zum Internet herstellen?

Warum kann der Himalaya keine Verbindung zum Internet herstellen?

Der Programmeingabepunkt konnte in der Dynamic Link Library nicht gefunden werden

Der Programmeingabepunkt konnte in der Dynamic Link Library nicht gefunden werden

Linux-Ansichtsprozess

Linux-Ansichtsprozess