Neuigkeiten vom 2. September: Um das Problem der systemischen Voreingenommenheit gegenüber Frauen und farbigen Menschen in vielen aktuellen Computer-Vision-Modellen zu lindern, hat Meta kürzlich ein neues KI-Tool namens FACET auf den Markt gebracht, um Rasse und Geschlecht in Computer-Vision-Systemen zu identifizieren.

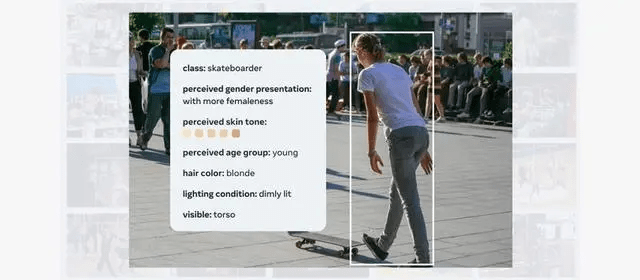

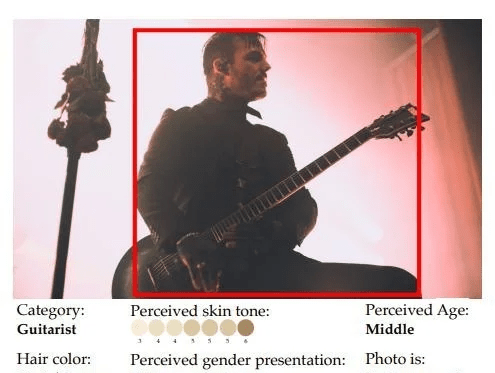

Das FACET-Tool ist derzeit auf 30.000 Bilder trainiert, darunter Bilder von 50.000 Personen. Es verbessert insbesondere die Wahrnehmung von Geschlecht und Hautfarbe und kann zur Bewertung verschiedener Merkmale von Computer-Vision-Modellen verwendet werden.

Das FACET-Tool kann komplexe Fragen nach dem Training beantworten. Beispielsweise kann es nach der Identifizierung des Probanden als Mann weitere Skateboarder sowie helle und dunkle Haut identifizieren.

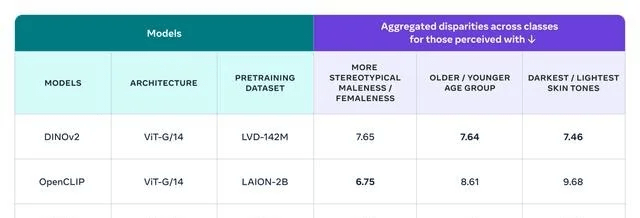

Meta verwendet FACET, um das vom Unternehmen entwickelte Modell DINOv2 und SEERv2 sowie das OpenCLIP-Modell von OpenAI zu bewerten. Insgesamt schneidet OpenCLIP in Bezug auf Geschlecht besser ab, während DINOv eine bessere Leistung bei der Beurteilung von Alter und Hautfarbe aufweist.

Open Sourcing FACET wird Forschern dabei helfen, ein ähnliches Benchmarking durchzuführen, um Verzerrungen in ihren eigenen Modellen zu verstehen und die Auswirkungen von Abhilfemaßnahmen zur Lösung von Gerechtigkeitsproblemen zu überwachen. IT House fügt hier die Adresse der Meta-Pressemitteilung bei, und interessierte Benutzer können sie ausführlich lesen.

【Quelle: IT Home】

Das obige ist der detaillierte Inhalt vonMeta-Open-Source-FACET-Tool zur Bewertung rassistischer und geschlechtsspezifischer Vorurteile in KI-Modellen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Was soll ich tun, wenn mein iPad nicht aufgeladen werden kann?

Was soll ich tun, wenn mein iPad nicht aufgeladen werden kann?

So registrieren Sie sich für Firmen-Alipay

So registrieren Sie sich für Firmen-Alipay

Was soll ich tun, wenn ich mein Breitband-Passwort vergesse?

Was soll ich tun, wenn ich mein Breitband-Passwort vergesse?

Tutorial für Ouyi-Neulinge

Tutorial für Ouyi-Neulinge

So verwenden Sie die Max-Funktion

So verwenden Sie die Max-Funktion

RGB in hexadezimales RGB umwandeln

RGB in hexadezimales RGB umwandeln

So lösen Sie das Problem „Warten auf Gerät'.

So lösen Sie das Problem „Warten auf Gerät'.

Was ist der Unterschied zwischen xls und xlsx

Was ist der Unterschied zwischen xls und xlsx