In den letzten Jahren ist die 2D-Bilderzeugungstechnologie mit künstlicher Intelligenz zu einem Hilfswerkzeug geworden, das von vielen Designern in tatsächlichen Projekten verwendet wird wird in verschiedenen Geschäftsszenarien angewendet und schafft immer mehr praktischen Wert. Gleichzeitig bewegen sich mit dem Aufstieg des Metaversums viele Branchen in Richtung der Schaffung groß angelegter virtueller 3D-Welten, und vielfältige, qualitativ hochwertige 3D-Inhalte werden für Branchen wie Spiele, Robotik, Architektur usw. immer wichtiger. und soziale Plattformen. Die manuelle Erstellung von 3D-Assets ist jedoch zeitaufwändig und erfordert besondere künstlerische und modellierende Fähigkeiten. Eine der größten Herausforderungen ist die Frage der Skalierung – trotz der großen Anzahl an 3D-Modellen, die auf dem 3D-Markt zu finden sind, erfordert die Bestückung einer Gruppe von Charakteren oder Gebäuden, die in einem Spiel oder Film alle unterschiedlich aussehen, immer noch einen erheblichen künstlerischen Aufwand Zeit. Infolgedessen wird der Bedarf an Tools zur Inhaltserstellung, die sich hinsichtlich Quantität, Qualität und Vielfalt von 3D-Inhalten skalieren lassen, immer deutlicher

Bilder

Bilder

Siehe Abbildung 1, dies ist ein Foto des Metaverse-Raums ( Quelle: Film „Wreck-It Ralph 2“)

Dank der Tatsache, dass generative 2D-Modelle bei der hochauflösenden Bildsynthese eine realistische Qualität erreicht haben, hat dieser Fortschritt auch die Forschung zur 3D-Inhaltsgenerierung inspiriert. Frühe Methoden zielten darauf ab, 2D-CNN-Generatoren direkt auf 3D-Voxelgitter zu erweitern, aber der hohe Speicherbedarf und die Rechenkomplexität von 3D-Faltungen behinderten den Generierungsprozess bei hohen Auflösungen. Als Alternative haben andere Forschungsarbeiten Punktwolken-, implizite oder Octree-Darstellungen untersucht. Diese Arbeiten konzentrieren sich jedoch hauptsächlich auf die Erzeugung von Geometrie und ignorieren das Erscheinungsbild. Ihre Ausgabedarstellungen müssen auch nachbearbeitet werden, um sie mit Standard-Grafik-Engines kompatibel zu machen.

Um für die Inhaltsproduktion praktisch zu sein, sollten ideale generative 3D-Modelle die folgenden Anforderungen erfüllen:

Die Fähigkeit haben, 3D-Grafiken mit Geometrie zu generieren Details und beliebige Topologie Fähigkeit von Formen

Inhalt umschreiben: (b) Die Ausgabe sollte ein texturiertes Netz sein, was ein allgemeiner Ausdruck ist, der von Standard-Grafiksoftware wie Blender und Maya verwendet wird

Kann mit 2D-Bildern in ihrer jetzigen Form überwacht werden viel kleiner als explizite 3D-Formen Allgemeiner

Um den Prozess der Inhaltserstellung zu erleichtern und praktische Anwendungen zu ermöglichen, sind generative 3D-Netzwerke zu einem aktiven Forschungsgebiet geworden, das in der Lage ist, qualitativ hochwertige und vielfältige 3D-Modelle zu erzeugen Vermögenswerte. Jedes Jahr werden viele generative 3D-Modelle auf ICCV, NeurlPS, ICML und anderen Konferenzen veröffentlicht, darunter die folgenden hochmodernen Modelle:

Textured3DGAN ist ein generatives Modell, das eine Erweiterung der Faltungsmethode zur Generierung texturierter 3D-Netze darstellt. Es kann lernen, mithilfe von GANs unter 2D-Überwachung Texturnetze aus physischen Bildern zu generieren. Im Vergleich zu früheren Methoden lockert Textured3DGAN die Anforderungen an Schlüsselpunkte im Schritt der Posenschätzung und verallgemeinert die Methode auf unbeschriftete Bildsammlungen und neue Kategorien/Datensätze wie ImageNet.

DIB-R: ist ein differenzierbarer Renderer, der auf Interpolation basiert und PyTorch verwendet Framework für maschinelles Lernen unten. Dieser Renderer wurde dem 3D Deep Learning PyTorch GitHub-Repository (Kaolin) hinzugefügt. Diese Methode ermöglicht die analytische Berechnung von Farbverläufen für alle Pixel im Bild. Die Kernidee besteht darin, die Vordergrundrasterung als gewichtete Interpolation lokaler Attribute und die Hintergrundrasterung als distanzbasierte Aggregation globaler Geometrie zu behandeln. Auf diese Weise können Informationen wie Form, Textur und Licht aus einem einzelnen Bild vorhergesagt werden.

PolyGen: PolyGen ist ein autoregressives generatives Modell basierend auf der Transformer-Architektur zur direkten Modellierung von Netzen. Das Modell sagt der Reihe nach die Scheitelpunkte und Flächen des Netzes voraus. Wir haben das Modell mit dem ShapeNet Core V2-Datensatz trainiert und die Ergebnisse kommen den von Menschen erstellten Netzmodellen bereits sehr nahe

SurfGen: Konfrontative 3D-Formsynthese mit einem expliziten Oberflächendiskriminator. Das durchgängig trainierte Modell ist in der Lage, hochauflösende 3D-Formen mit unterschiedlichen Topologien zu generieren.

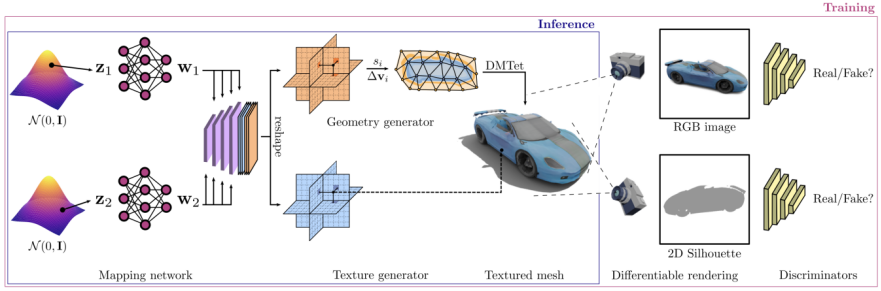

GET3D ist ein generatives Modell, das durch Lernen von Bildern hochwertige 3D-Texturformen erzeugen kann. Sein Kern ist differenzierbare Oberflächenmodellierung, differenzierbares Rendering und generative gegnerische 2D-Netzwerke. Durch Training an einer Sammlung von 2D-Bildern kann GET3D direkt explizit texturierte 3D-Netze mit komplexer Topologie, reichhaltigen geometrischen Details und hochauflösenden Texturen generieren (Quelle: Offizielle GET3D-Papier-Website https://nv-tlabs.github.io/GET3D/)

GET3D ist ein kürzlich vorgeschlagenes generatives 3D-Modell, das mehrere Modelle mit komplexen Geometrien wie ShapeNet, Turbosquid und Renderpeople verwendet Stühle, Motorräder, Autos, Menschen und Gebäude, die modernste Leistung bei der unbegrenzten Generierung von 3D-Formen demonstrieren

Bilder

Bilder

Die GET3D-Architektur stammt von der offiziellen GET3D-Papierwebsite.

Ein 3D-SDF (gerichtetes Distanzfeld) wird durch zwei mögliche Codierungen generiert und ein Texturfeld, verwenden Sie dann DMTet (Deep Marching Tetrahedra), um das 3D-Oberflächennetz aus SDF zu extrahieren, und fragen Sie das Texturfeld in der Oberflächenpunktwolke ab, um die Farbe zu erhalten. Der gesamte Prozess wird mithilfe eines auf 2D-Bildern definierten gegnerischen Verlusts trainiert. Insbesondere RGB-Bilder und -Konturen werden mithilfe eines auf Rasterung basierenden differenzierbaren Renderers erhalten. Schließlich werden zwei 2D-Diskriminatoren verwendet, jeweils für RGB-Bilder und Konturen, um zu unterscheiden, ob die Eingabe echt oder gefälscht ist. Das gesamte Modell kann End-to-End trainiert werden.

GET3D ist auch in anderen Aspekten sehr flexibel und kann neben der Darstellung expliziter Netze als Ausgabe auch problemlos an andere Aufgaben angepasst werden, darunter:

Getrennte Geometrie- und Texturimplementierung: Gute Entkopplung zwischen Geometrie und Textur wird erreicht, was eine sinnvolle Interpolation von latenten Geometriecodes und latenten Texturcodes ermöglicht

Durch die Durchführung eines zufälligen Spaziergangs im latenten Raum, bei der Erzeugung glatter Übergänge zwischen verschiedenen Formklassen und der Generierung entsprechender 3D-Formen, um dies zu erreichen

Neue Formen generieren: Dies kann durch das Hinzufügen von kleinem Rauschen zum lokalen latenten Code gestört werden, wodurch Formen erzeugt werden, die ähnlich aussehen, sich aber lokal leicht unterscheiden.

Unüberwachte Materialgenerierung: In Kombination mit DIBR++ können Materialien völlig unbeaufsichtigt generiert und produziert werden aussagekräftige, ansichtsabhängige Lichteffekte

Textgesteuerte Formgenerierung: Durch die Kombination von StyleGAN NADA, die Nutzung rechnerisch gerenderter 2D-Bilder und vom Benutzer bereitgestellter Texte. Mithilfe des gerichteten CLIP-Verlusts zur Feinabstimmung des 3D-Generators können Benutzer eine große Anzahl sinnvoller generieren Formen durch Textaufforderungen

Bilder

Bilder

Bitte beachten Sie Abbildung 4, die den Prozess der Generierung von Formen basierend auf Text zeigt. Die Quelle dieser Abbildung ist die offizielle Website des GET3D-Papiers, die URL lautet https://nv-tlabs.github.io/GET3D/

Obwohl GET3D einen Schritt in Richtung eines praktischen 3D gemacht hat Modell zur Texturformerzeugung Ein wichtiger Schritt, der jedoch noch einige Einschränkungen aufweist. Insbesondere basiert der Trainingsprozess immer noch auf der Kenntnis von 2D-Silhouetten und Kameraverteilungen. Daher kann GET3D derzeit nur auf Basis synthetischer Daten ausgewertet werden. Eine vielversprechende Erweiterung besteht darin, Fortschritte bei der Instanzsegmentierung und der Kamerapositionsschätzung zu nutzen, um dieses Problem zu lindern und GET3D auf reale Daten auszuweiten. GET3D wird derzeit nur nach Kategorien trainiert und wird in Zukunft auf mehrere Kategorien erweitert, um die Vielfalt zwischen den Kategorien besser darzustellen. Hoffentlich bringt diese Forschung die Menschen der Nutzung künstlicher Intelligenz für die kostenlose Erstellung von 3D-Inhalten einen Schritt näher

Das obige ist der detaillierte Inhalt vonEin ausführlicher fünfminütiger technischer Vortrag über die generativen Modelle von GET3D. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Computer-404-Fehlerseite

Computer-404-Fehlerseite

Lösung für die Meldung „Ungültige Partitionstabelle' beim Start von Windows 10

Lösung für die Meldung „Ungültige Partitionstabelle' beim Start von Windows 10

So lösen Sie das Problem der fehlenden ssleay32.dll

So lösen Sie das Problem der fehlenden ssleay32.dll

So stellen Sie die IP ein

So stellen Sie die IP ein

So öffnen Sie eine Statusdatei

So öffnen Sie eine Statusdatei

Warum öffnet sich die mobile Festplatte so langsam?

Warum öffnet sich die mobile Festplatte so langsam?

Was sind die Grundeinheiten der C-Sprache?

Was sind die Grundeinheiten der C-Sprache?

Welche Plattform ist Kuai Tuan Tuan?

Welche Plattform ist Kuai Tuan Tuan?