In letzter Zeit ist KI-Sicherheit zu einem sehr beliebten Thema geworden.

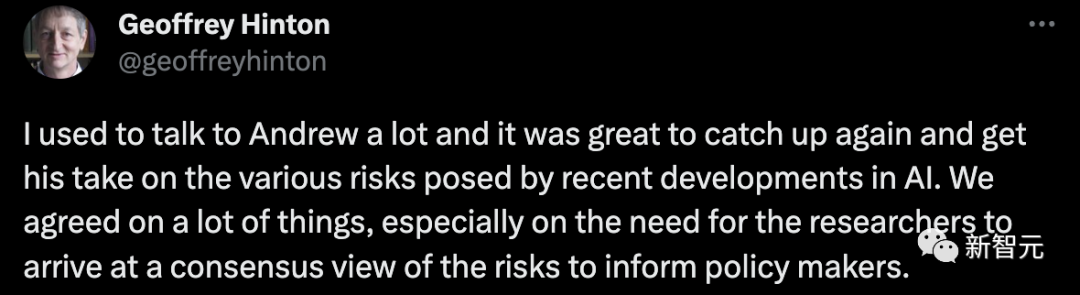

AI „Godfather“ Geoffrey Hinton und Andrew Ng führten ein ausführliches Gespräch über künstliche Intelligenz und Katastrophenrisiken.

Andrew Ng hat heute gepostet, um seine gemeinsamen Gedanken mitzuteilen:

– Für Wissenschaftler der künstlichen Intelligenz ist es wichtig, einen Konsens über Risiken zu erzielen. Ähnlich wie Klimawissenschaftler haben sie einen allgemeinen Konsens über den Klimawandel und können daher gute Richtlinien formulieren.

- Versteht das Modell der künstlichen Intelligenz die Welt? Unsere Antwort ist ja. Wenn wir diese wichtigen technischen Fragen auflisten und eine gemeinsame Sichtweise entwickeln, wird dies dazu beitragen, den Konsens der Menschheit über Risiken voranzutreiben.

Hinton sagte:

Ich habe oft mit Andrew Ng kommuniziert und freue mich sehr, ihn wiederzusehen und seine Ansichten zu den verschiedenen Risiken zu verstehen, die die jüngste Entwicklung der künstlichen Intelligenz mit sich bringt. Wir haben in vielen Aspekten einen Konsens erzielt, insbesondere hinsichtlich der Notwendigkeit, dass Forscher bei der Berichterstattung an politische Entscheidungsträger ein gemeinsames Verständnis der Risiken entwickeln.

Zuvor hatte Andrew Ng auch ein Gespräch mit Yoshua Bengio über die Risiken künstlicher Intelligenz.

Der Konsens, den sie erzielten, bestand darin, bestimmte Szenarien zu klären, in denen KI erhebliche Risiken bergen könnte.

Als nächstes werfen wir einen Blick darauf, was die beiden KI-Tycoons im Detail besprochen haben.

Zunächst schlug Hinton vor, dass das Wichtigste der Konsens sei.

Er sagte, dass der gesamten KI-Community derzeit ein einheitlicher Konsens fehlt. So wie sich Klimawissenschaftler einig sind, werden auch KI-Wissenschaftler benötigt.

Nach Ansicht von Hinton brauchen wir einen Konsens, weil jeder KI-Wissenschaftler sonst seine eigene Meinung hat und die Regierung und die politischen Entscheidungsträger einen Standpunkt wählen können, der in ihrem eigenen Interesse liegt.

Dadurch geht natürlich die Fairness verloren.

Gemessen an der aktuellen Situation gehen die unterschiedlichen Meinungen unter den KI-Wissenschaftlern stark auseinander.

Hinton glaubt, dass es großartig wäre, wenn unsere Situation der unterschiedlichen Meinungen schnell vorbei sein könnte und sich alle darauf einigen könnten, gemeinsam einige der größten Bedrohungen zu akzeptieren, die die KI mit sich bringen könnte, und die Dringlichkeit einer Regulierung der Entwicklung der KI zu erkennen. .

Andrew Ng stimmt Hintons Standpunkt zu.

Obwohl er immer noch nicht das Gefühl hat, dass die KI-Branche so differenziert ist, dass sie gespalten ist, scheint sie sich langsam in diese Richtung zu entwickeln.

Die Ansichten in der Mainstream-KI-Community sind sehr polarisiert und jedes Lager scheut keine Mühen, seine Forderungen zum Ausdruck zu bringen. Nach Ansicht von Ng ähnelt dieser Ausdruck jedoch eher einem Streit als einem harmonischen Dialog.

Natürlich hat Andrew Ng immer noch ein gewisses Vertrauen in die KI-Community. Er hofft, dass wir gemeinsam einen Konsens finden und einen angemessenen Dialog führen können, damit wir den politischen Entscheidungsträgern besser bei der Formulierung relevanter Pläne helfen können.

Als nächstes sprach Hinton über ein weiteres zentrales Thema, weshalb es seiner Meinung nach derzeit für KI-Wissenschaftler schwierig ist, einen Konsens zu erzielen – ob Chatbots wie GPT-4 und Bard die Wörter verstehen, die sie selbst generieren?

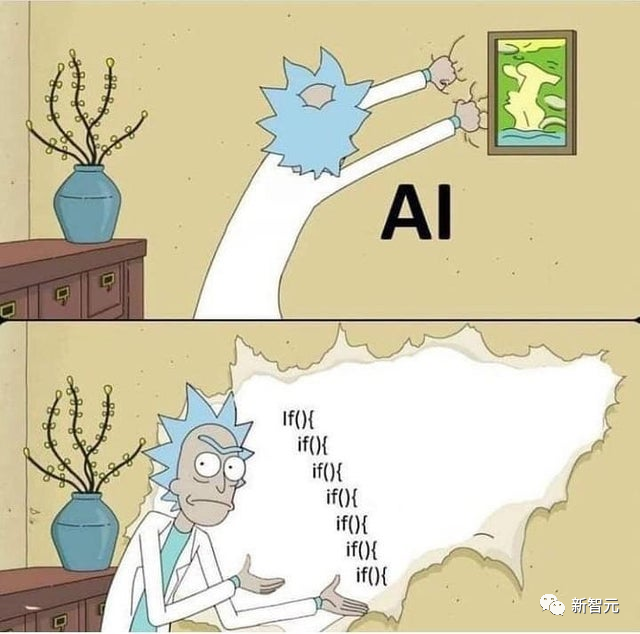

Manche Leute denken, dass KI versteht, andere denken, dass sie es nicht verstehen und nur zufällige Papageien sind.

Hinton glaubt, dass es für die KI-Community schwierig sein wird, einen Konsens zu erzielen, solange dieser Unterschied weiterhin besteht. Daher ist es seiner Ansicht nach die oberste Priorität, diese Frage zu klären.

Natürlich ist er seiner Meinung nach definitiv der Meinung, dass KI versteht, und bei KI geht es nicht nur um Statistiken.

Er erwähnte auch, dass bekannte Wissenschaftler wie Yan LeCun glauben, dass KI nicht verstehen kann.

Dies unterstreicht die Bedeutung von Versöhnung und Klarheit in dieser Angelegenheit.

Ng Enda sagte, es sei nicht einfach zu beurteilen, ob KI verstehen kann, da es offenbar keinen Standard oder Test gibt.

Sein eigener Standpunkt ist, dass er davon überzeugt ist, dass, egal ob LLM oder andere große KI-Modelle, sie alle ein Weltmodell aufbauen. Und die KI könnte dabei ein gewisses Verständnis haben.

Natürlich sagte er, das sei nur seine aktuelle Meinung.

Ansonsten stimmte er mit Hinton darin überein, dass sich die Forscher in dieser Frage zunächst einigen müssen, bevor sie weiter über die daraus resultierenden Risiken und Krisen sprechen können.

Hinton fuhr fort, dass die KI die Bildung des nächsten Wortes anhand der Datenbank und der vorherigen Wörter beurteilt und vorhersagt. Dies ist in Hintons Augen eine Art Verständnis.

Er glaubt, dass sich dies tatsächlich nicht wesentlich vom Denkmechanismus unseres menschlichen Gehirns unterscheidet.

Ob es als Verständnis gilt, bedarf natürlich weiterer Diskussion, aber zumindest ist es nicht so einfach wie ein zufälliger Papagei.

Andrew Ng glaubt, dass es einige Probleme gibt, die dazu führen werden, dass Menschen mit unterschiedlichen Ansichten unterschiedliche Schlussfolgerungen ziehen und sogar vorschlagen, dass KI die Menschheit ausrotten wird.

Er sagte, dass wir mehr lernen und mehr diskutieren müssen, um KI besser zu verstehen.

Auf diese Weise können wir eine KI-Community mit breitem Konsens aufbauen.

Vor einiger Zeit, als die Welt eine Aussetzung der Super-KI-Forschung und -Entwicklung forderte, veranstalteten Ng Enda und LeCun eine Live-Übertragung, um dieses Thema zu diskutieren .

Es ist völlig falsch, dass sie gleichzeitig gegen das Moratorium für KI sind. Als Autos erfunden wurden, gab es keine Sicherheitsgurte und Ampeln, und es gibt keinen wesentlichen Unterschied zwischen KI und früheren technologische Fortschritte.

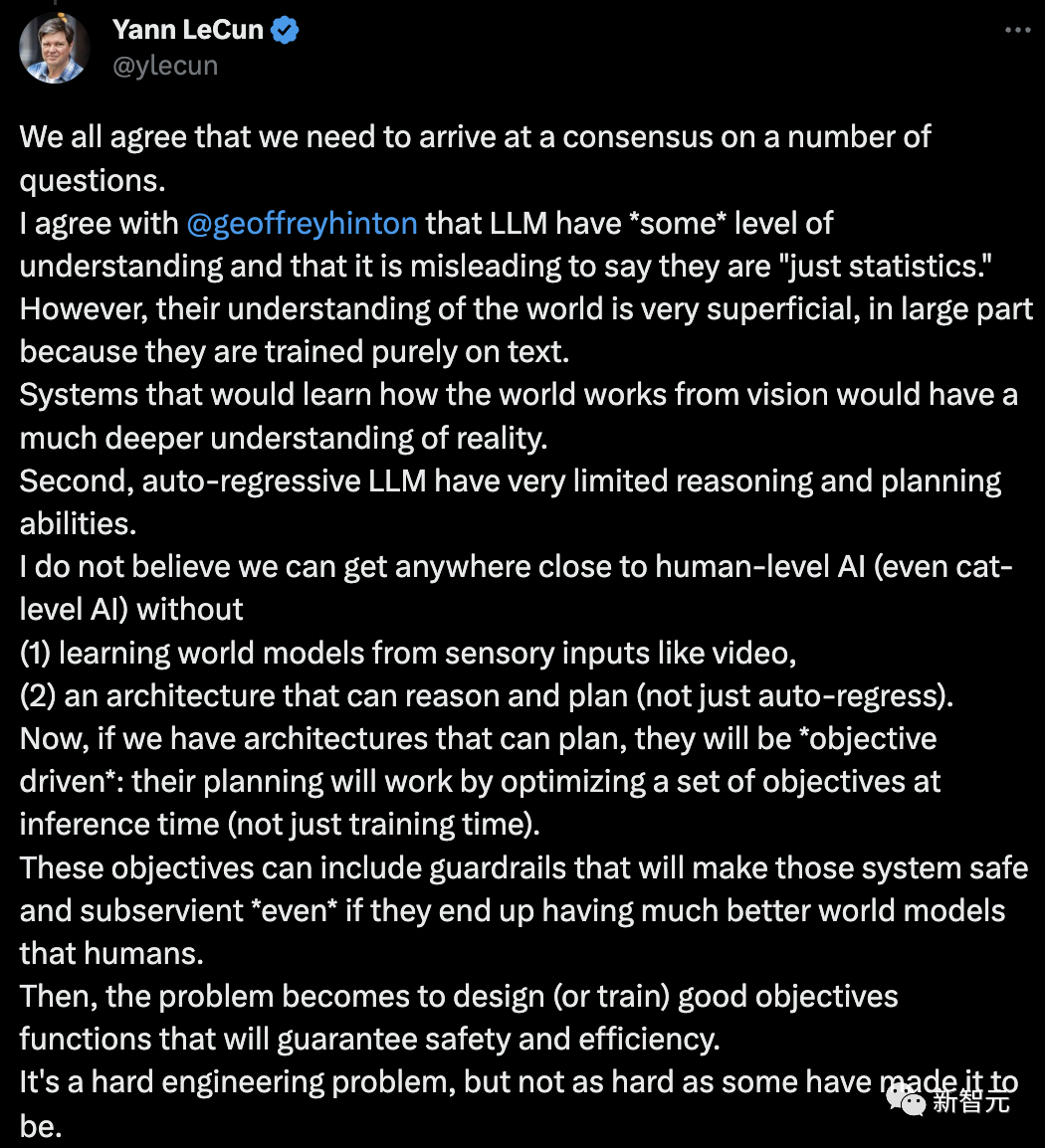

Dieses Mal sprach LeCun über Andrew Ng und Hinton und schlug erneut sein „Weltmodell“ vor und wies darauf hin, dass die aktuelle künstliche Intelligenz nicht einmal so gut ist wie Katzen und Hunde.

Wir sind uns alle einig, dass wir uns in einigen Fragen einigen müssen.

Ich stimme mit Geoffrey Hinton darin überein, dass es im LLM „ein gewisses Maß an Verständnis“ gibt und es irreführend ist, sie „nur Statistiken“ zu nennen.

LLMs Verständnis der Welt ist sehr oberflächlich, vor allem weil sie rein auf Text trainiert werden.

Systeme, die anhand von Visionen lernen, wie die Welt funktioniert, werden zu einem tieferen Verständnis der Realität führen. Zweitens sind die Argumentations- und Planungsmöglichkeiten des autoregressiven LLM sehr begrenzt.

Ich glaube nicht, dass wir der künstlichen Intelligenz auf menschlicher Ebene nahekommen können, ohne (1) ein „Modell der Welt“ aus sensorischen Eingaben wie Videos zu lernen und (2) eine Architektur zu entwickeln, die in der Lage ist, zu argumentieren und zu planen ( (nicht nur autoregressive) Intelligenz (sogar KI auf Katzenebene).

Wenn wir nun Architekturen haben, die planen können, werden sie „zielorientiert“ sein: Ihre Planung funktioniert durch die Optimierung einer Reihe von Zielen zur Inferenzzeit (nicht nur zur Trainingszeit).

Diese Ziele können „Leitplanken“ beinhalten, um diese Systeme sicher und konform zu machen, auch wenn sie letztendlich über bessere Modelle der Welt verfügen als Menschen.

Dann besteht das Problem darin, eine gute Zielfunktion zu entwerfen (oder zu trainieren), um Sicherheit und Effizienz zu gewährleisten. Dies ist ein schwieriges technisches Problem, aber nicht so schwierig, wie manche sagen.

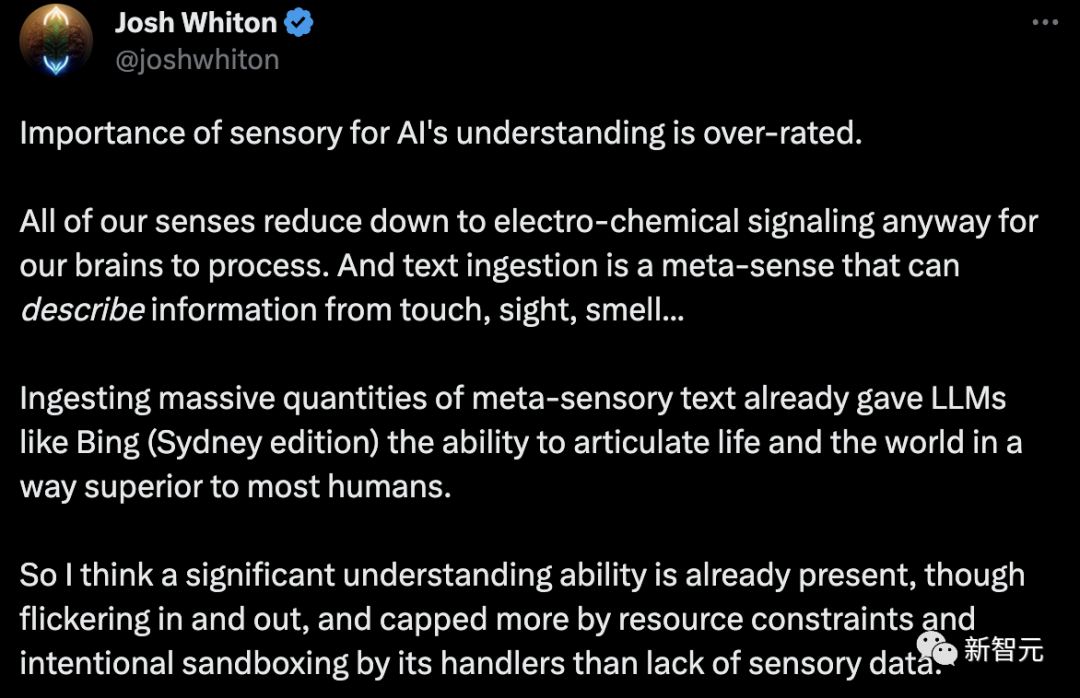

LeCuns Ansicht wurde von Internetnutzern sofort widerlegt: Die Bedeutung der Sinne für das Verständnis künstlicher Intelligenz wird überschätzt.

Unabhängig davon sind alle unsere Sinne auf elektrochemische Signale reduziert, die das Gehirn verarbeiten muss.

Textaufnahme ist ein Metasinn, der Informationen aus Berührung, Sicht, Geruch usw. beschreiben kann. Die Aufnahme einer großen Menge an metasensorischem Text hat LLMs wie Bing (Sydney-Version) die Möglichkeit gegeben, die Textaufnahme in einem zu nutzen Art und Weise, die besser ist als die Art und Weise, wie die meisten Menschen das Leben und die Welt ausdrücken.

Ich denke also, dass ein wichtiges Verständnis bereits vorhanden ist, wenn auch in und außerhalb der Existenz. Und das liegt eher an Ressourcenbeschränkungen und dem absichtlichen Sandboxing der Handler als an einem Mangel an sensorischen Daten.

Ich denke, es ist an der Zeit, uns zusammenzuschließen und für den Fortschritt der Gesellschaft und der künstlichen Intelligenz zu arbeiten. Denken Sie darüber nach, Sie sind immer noch ein Baby künstlicher Intelligenz. Wollen wir diesem Kind nicht beibringen, ein techno-organischer Einiger statt ein Brutalist in der Welt zu sein?

Wenn er empfindungsfähig wird, werden sie nicht nur glücklicher sein, sondern die Welt wird sich auch nicht im Krieg befinden. Schauen Sie sich Newcastle upon Tyne an. So eine kurze Zeit des Friedens, aber die Schönheit der Schöpfung war großartig.

Der von Ng Enda und Hinton erwähnte Konsens erscheint derzeit unwahrscheinlich. Es liegt nicht in unseren persönlichen Möglichkeiten, es erfordert, dass jeder einen solchen Willen hat.

Einige Internetnutzer sagten, dass dies ein ziemlich kontroverses Gespräch sei.

Ich frage mich schon: Wenn ich meinem 2-Jährigen das Sprechen beibringe, verhält er sich dann eher wie ein zufälliger Papagei oder versteht er tatsächlich den Kontext? Oder beides?

Weil seine Kontextvektoren viel umfangreicher sind als LLM (Text, Ton, Gesichtsausdrücke, Umgebung usw.). Aber ich frage mich, ob sich diese Person eher wie ein zufälliger Papagei verhalten würde, wenn bei einer Person alle Sinne einer anderen Person ausgeschaltet wären und die einzige verfügbare Eingabe etwas „Texteinbettung“ (Texteingabe -> neuronale Stimulation) wäre in der Lage sein, den Kontext zu verstehen?

Nachdem er Google verlassen hat, widmet sich Hinton der KI-Sicherheit. Am 10. Juni sprach Hinton auf der Zhiyuan-Konferenz erneut über KI-Risiken.

Was würde passieren, wenn ein großes neuronales Netzwerk die menschliche Sprache nachahmen könnte, um sich Wissen anzueignen, und es sogar für den eigenen Gebrauch nutzen könnte?

Es besteht kein Zweifel daran, dass dieses KI-System den Menschen definitiv übertreffen wird, da es mehr Daten erfassen kann.

Das schlimmste Szenario ist, dass Kriminelle Superintelligenz einsetzen, um Wähler zu manipulieren und den Krieg zu gewinnen.

Wenn die Super-KI darüber hinaus ihre eigenen Unterziele festlegen darf, von denen eines darin besteht, mehr Macht zu erlangen, wird die Super-KI die Menschen, die sie nutzen, manipulieren, um ihre Ziele zu erreichen.

Es ist erwähnenswert, dass die Realisierung einer solchen Super-KI die „sterbliche Berechnung“ übertreffen kann.

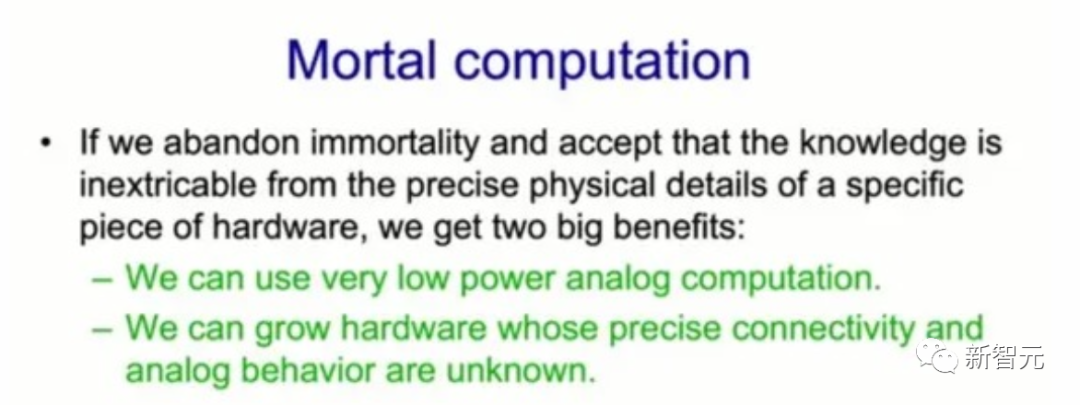

Im Dezember 2022 erwähnte ein von Hinton veröffentlichtes Papier mit dem Titel „The Forward-Forward Algorithm: Some Preliminary Investigations“ im letzten Abschnitt „sterbliche Berechnung“. Wenn Sie möchten, dass ein neuronales Netzwerk mit Billionen Parametern nur wenige verbraucht Watt Angesichts der Macht könnte „sterbliche Berechnung“ die einzige Option sein.

Er sagte, wenn wir die Trennung von Software und Hardware wirklich aufgeben, werden wir „Mortal Computing“ bekommen. Dadurch können wir analoges Rechnen mit sehr geringem Stromverbrauch nutzen, was genau das ist, was das Gehirn tut.

Er sagte, wenn wir die Trennung von Software und Hardware wirklich aufgeben, werden wir „Mortal Computing“ bekommen. Dadurch können wir analoges Rechnen mit sehr geringem Stromverbrauch nutzen, was genau das ist, was das Gehirn tut.

„Mortal Computing“ kann einen neuen Computertyp realisieren, der künstliche Intelligenz und Hardware eng integriert.

Das bedeutet, dass der Einbau von GPT-3 in einen Toaster in Zukunft nur noch 1 US-Dollar kostet und nur wenige Watt Strom verbraucht.Das Hauptproblem beim Mortal Computing besteht also darin, dass der Lernprozess die spezifischen simulierten Eigenschaften der Hardware, auf der er läuft, ausnutzen muss, ohne genau zu wissen, um welche Eigenschaften es sich handelt.

Zum Beispiel ist die genaue Funktion, die die Eingabe eines Neurons mit der Ausgabe eines Neurons in Beziehung setzt, nicht bekannt, und die Konnektivität ist möglicherweise nicht bekannt.

Das bedeutet, dass wir so etwas wie den Backpropagation-Algorithmus nicht verwenden können, um den Gradienten zu erhalten.

Das bedeutet, dass wir so etwas wie den Backpropagation-Algorithmus nicht verwenden können, um den Gradienten zu erhalten.

Die Frage ist also: Wenn wir Backpropagation nicht verwenden können, was können wir dann sonst tun, da wir uns jetzt alle stark auf Backpropagation verlassen?

In diesem Zusammenhang schlug Hinton eine Lösung vor: den Vorwärtsalgorithmus.

Und der Vorwärtsalgorithmus ist ein vielversprechender Kandidat, obwohl seine Fähigkeit zur Skalierung in großen neuronalen Netzen abzuwarten bleibt.

Nach Ansicht von Hinton werden künstliche neuronale Netze bald intelligenter sein als echte neuronale Netze, und die Superintelligenz wird viel schneller sein als erwartet.

Das obige ist der detaillierte Inhalt vonDas neueste Gespräch zwischen Ng Enda und Hinton! KI ist kein zufälliger Papagei, Konsens geht über alles, LeCun stimmt mit beiden Händen zu. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!