Meinung dieser Woche

1.1 NVIDIA: Verkörperter Intelligenzpfad mit Omniversum als Kern

NVIDIA hat den Weg der verkörperten Intelligenz gewählt, der durch die Entwicklung vom Rand bis zur Cloud gekennzeichnet ist. Seine Hauptprodukte sind VIMA-Roboterarme und mobile Isaac AMR-Roboterplattformen. NVIDIA hat auf der ITF2023 einen Roboterarm vorgestellt, der auf dem VIMA-Großmodell basiert. Laut NVIDIA kann VIMA auch in Omniverse ausgeführt werden, um die physische Welt zu verstehen, zu verstehen und mit ihr zu interagieren Simulieren Sie die Physik und interagieren Sie mit der physischen Welt. Machen Sie Vorhersagen im Einklang mit den Gesetzen der Physik. Isaac AMR ist eine Plattform zum Simulieren, Validieren, Bereitstellen, Optimieren und Verwalten von Flotten autonomer mobiler Roboter. Sie umfasst Edge-to-Cloud-Softwaredienste, Computer sowie eine Reihe von Referenzsensoren und Roboterhardware, um groß angelegte Einsätze zu beschleunigen Die Verbindung mit den Cloud-Diensten von DeepMap reduziert die Zeit, die Roboter für die Kartierung großer Einrichtungen benötigen, von Wochen auf Tage und erreicht eine Genauigkeit im Zentimeterbereich, ohne dass ein erfahrenes technisches Team erforderlich ist. Durch die Generierung umfangreicher 3D-Voxelkarten können Belegungskarten und semantische Karten für viele Arten der adaptiven Netzverfeinerung (AMR) erstellt werden.

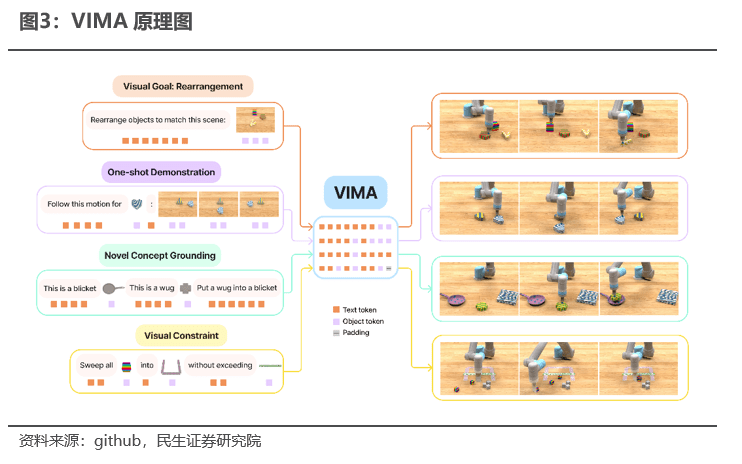

Verkörperte Intelligenz bezieht sich auf das Training von Algorithmen durch Nachahmung der Arbeitsweise des menschlichen Gehirns, wodurch Selbstverständnis, Selbstoptimierung und letztendlich menschenähnliches Lernen und Wachstum erreicht werden. NVIDIA VIMA unterstützt multimodale Modi wie Text, Vision und Stimme als Aufgabeneingabe des Roboters und verwendet systematische Generalisierungstests, einschließlich Simulations-Benchmark-Tests, mehr als 600.000 Expertentrajektorien und mehrstufige Bewertungsprotokolle als Zielausgabesatz Das trainierte T5-Modell kodiert multimodale Hinweise und moduliert die Robotersteuerung auf die Hinweise über eine Queraufmerksamkeitsschicht, wobei motorische Befehle abhängig von Hinweisen und Interaktionsverlauf als Satz vorhergesagter Ausgaben und Ziele durch den Ausgabevergleich des Modells vorhergesagt werden Selbstoptimierung fördert das autonome Lernen von VIMA. Bei der schwierigsten Generalisierungstrainingsaufgabe ohne Stichprobe ist die Aufgabenerfolgsrate von VIMA bis zu 2,9-mal höher als bei der vorherigen optimalen Methode, während 10-mal weniger Trainingsdaten verwendet werden. Die Leistung von VIMA beträgt immer noch das 2,7-fache besser als die Top-Konkurrenzmethoden.

Mit realen Datensätzen ist die verkörperte Intelligenz von entscheidender Bedeutung für die Wettbewerbsfähigkeit, und NVIDIA Omniverse ist der Branchenmaßstab. Für die Durchführung eines Embodied-Intelligence-Trainings sind spezielle Datensätze erforderlich. Für den VIMA-Roboterarm sind beispielsweise folgende Daten erforderlich:

1) Multimodaler Aufgabensatz: 17 Metaaufgaben, jede Metaaufgabe kann in 1000 separate Aufgaben aufgeteilt werden, darunter verschiedene multimodale Aufgaben wie semantisches Verständnis und visuelle Segmentierung

2) Erfolgsgeschichten: NVIDIA hat 650.000 Erfolgskurven vorbereitet

3) Belohnungs-Benchmark: Richten Sie VIMA-Bench ein, um Methoden der Wahrscheinlichkeitstheorie zu verwenden, um die Ergebnisse der Aufgaben-KI-Vorhersage angemessen zu bewerten und der KI korrektes Feedback zu geben

NVIDIA Omnivers ist die weltweit führende Plattform für digitale Zwillinge und umfasst fünf wichtige Komponenten: Nucleus, Connect, Kit, Simulation und RTX-Renderer. Diese Komponenten sowie interoperable DCC-Tools (Digital Content Creation) und Renderer von Drittanbietern sowie Erweiterungen. Von Drittanbietern und NVIDIA erstellte Anwendungen und Microservices bilden ein vollständiges Omniverse-Ökosystem. Durch reale Datensätze wie USD können digitale Zwillinge physikalischen Gesetzen genau entsprechen, auf Objektbewegungen genau reagieren und mit Displays synchronisiert werden. Diese realen Daten sind eine wichtige Grundlage für die Implementierung der verkörperten Intelligenz von NVIDIA.

Der verkörperte Intelligenzpfad für NVIDIAs Edge-KI-Durchbruch wurde von Grund auf eröffnet. In Kombination mit Cloud Computing kann es umfassende technische Unterstützung in allen Aspekten der Edge-KI von der Entwicklung bis zur Bereitstellung bieten. NVIDIA hat Microsoft Azure als ersten Cloud-Dienstanbieter für Omniverse Cloud ausgewählt. Microsoft Azure wird es Unternehmen ermöglichen, auf den gesamten Satz von Omniverse-Softwareanwendungen und NVIDIA OVX™-Rechnersystemen zuzugreifen und gleichzeitig die Skalierungsanalysefunktionen und die Sicherheit der Azure-Cloud-Dienste zu nutzen und Kunden eine Reihe von Tools zur Verfügung zu stellen, die zum Entwerfen, Entwickeln und Bereitstellen verwendet werden können und verwalten Sie industrielle Elemente. Die Full-Stack-Cloud-Umgebung und Plattformfunktionen von Universe Application verbinden und nutzen verwandte Produkte aus dem Partner-Ökosystem von NVIDIA, wie z. B. NVIDIA-zertifizierte Workstations, Edge-Computing-Module usw.

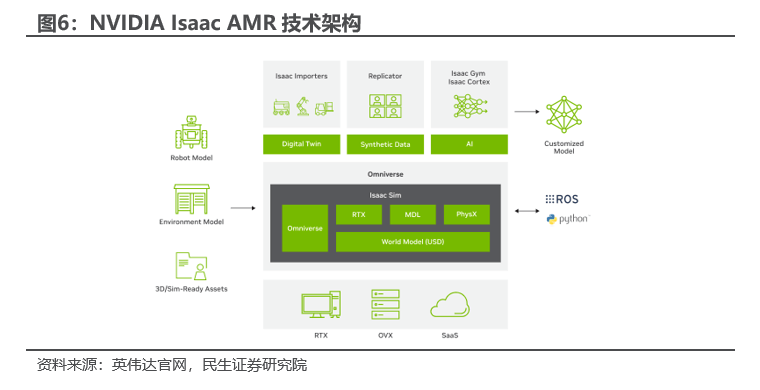

NVIDIA Isaac ist eine Beschleunigungsplattform, die speziell für die Roboterentwicklung und KI entwickelt wurde, und die mobile Roboterplattform AMR war die erste, die auf den Markt kam. Die NVIDIA Isaac-Plattform beginnt mit einem vorab trainierten Modell, das mit in Isaac Replicator generierten synthetischen Daten erweitert und mit NVIDIA TAO trainiert wird, um die Zielleistung zu erreichen. Nutzen Sie NVIDIA Isaac Sim, das vor Ort und in der Cloud verfügbar ist, um physikalisch genaue und realistische Umgebungen zu erstellen um alle Aspekte im Zusammenhang mit dem Betrieb Ihres Roboters zu entwickeln und zu testen; sparen Sie Zeit mit Nova Ori und bringen Sie KI auf NVIDIA Jetson-basierte Roboter mit Hardwarebeschleunigungs-SDKs, wie z. B. Isaac ROS GEM für ROS-basierte Roboter, Isaac ROS GEM für die Videostream-Analyse von NVIDIA DeepStream SDK, NVIDIA Riva für die Verarbeitung natürlicher Sprache; Verwalten Sie Roboterflotten zur Optimierung der Produktivität mit EGX Fleet Command und Isaac für AMR, einschließlich Metropolis, CuOpt und DeepMap. Isaac AMR ist eine Plattform zur Simulation, Validierung, Bereitstellung, Optimierung und Verwaltung von Flotten autonomer mobiler Roboter. Sie umfasst Edge-to-Cloud-Training für digitale Zwillinge, Softwaredienste, Rechenleistung sowie eine Reihe von Referenzsensoren und Roboterhardware, um die Entwicklung zu beschleunigen Bereitstellungsgeschwindigkeit, Reduzierung der Kosten und Zeit bis zur Markteinführung.

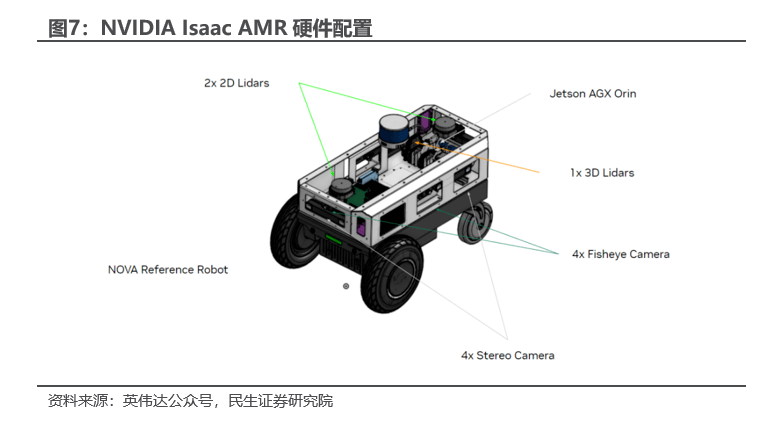

Isaac AMR basiert auf der NVIDIA Nova Orin-Referenzarchitektur. Nova Orin integriert mehrere Sensoren und Systemmodule, darunter Stereokameras, Fischaugenkameras, 2D- und 3D-Lidar, unterstützt fortschrittliche KI- und Hardwarebeschleunigungsalgorithmen und bietet 275 TOPS Echtzeit-Edge-Computing-Leistung. Synchronisierte und kalibrierte Sensorsuiten bieten Sensorvielfalt und -redundanz für 3D-Erfassung und -Kartierung in Echtzeit. Cloud-native Tools zum Aufzeichnen, Hochladen und Wiedergeben, die das Debuggen, Kartenerstellen, Training und Analyse erleichtern.

1.2 Qualcomm: Hybrider KI-Pfad, der Cloud und Edge integriert

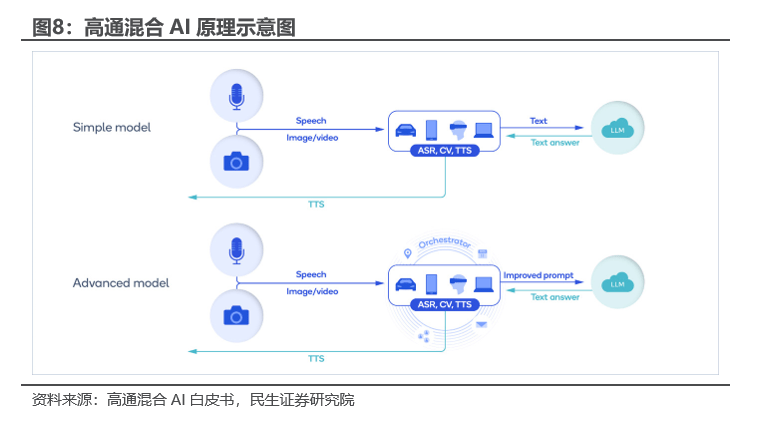

Qualcomm kündigte die Einführung einer Cloud-Edge-Hybrid-KI-Lösung an, die sich der tiefgreifenden Entwicklung von Edge-KI widmet und gleichzeitig mit Microsoft und anderen Unternehmen bei der Entwicklung von Cloud-KI zusammenarbeitet. Laut dem Hybrid-KI-Whitepaper von Qualcomm ist in Hybrid-KI-Szenarien das Edge-Large-Modell das Sinnesorgan des Cloud-Large-Modells. Beispielsweise spricht der Benutzer mit dem Mobiltelefon und das KI-Modell mit automatischer Spracherkennung (ASR). Während Whisper die Sprache auf dem Gerät in Text umwandelt und an die Cloud sendet, führen Sie große Modelle in der Cloud aus und senden Textantworten zurück. In der erweiterten Version schützt die Geräte-KI die Privatsphäre weiter, übernimmt mehr Verarbeitung und stellt der Cloud personalisiertere Eingabeaufforderungen zur Verfügung: Durch Gerätelernen und persönliche Daten erstellt das Gerät ein Benutzerprofil, arbeitet mit dem Planer zusammen und bietet eine bessere kontextbasierte Bereitstellung Eingabeaufforderungen; der Benutzer bittet beispielsweise um eine Mobiltelefonreservierung, um mit Freunden in einem Lieblingsrestaurant zu essen. Bei einfachen Abfragen kann ein kleineres großes Modell ohne Cloud-Interaktion ausgeführt werden Lokal in Eingabeaufforderungen umgewandelt und an das große Modell in der Cloud gesendet und detaillierte Antworten zurückgeben.

Laut Qualcomm Hybrid AI Whitepaper hat Hybrid AI vor allem die folgenden Vorteile:

1) Wirtschaftlichkeit: Reduzieren Sie die Cloud-Inferenzkosten, nutzen Sie die Edge-Computing-Leistung effizient und senken Sie die Schwelle für die Entwicklung von KI-Anwendungen

;2) Geringer Energieverbrauch: Edge-Geräte können große Modelle mit geringerem Energieverbrauch betreiben. Wenn Faktoren wie Verarbeitung und Datenübertragung berücksichtigt werden, sind die Einsparungen beim Energieverbrauch größer;

3) Zuverlässigkeit: Edge AI wird nicht von Netzwerkbedingungen beeinflusst und läuft stabiler;4) Datenschutz: Die Daten werden vollständig lokal abgeleitet, wodurch das Risiko von Lecks erheblich reduziert wird;

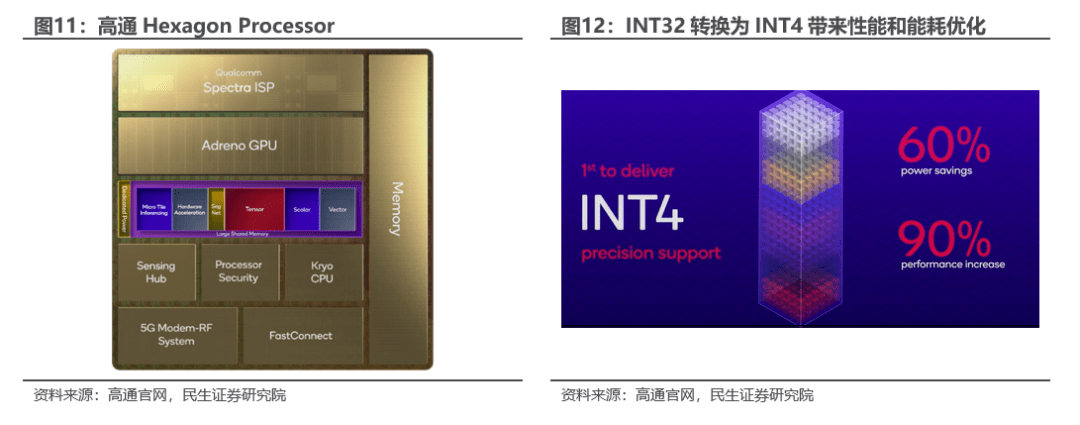

5) Personalisierung: Edge-Geräte können das reale Verhalten, die Werte, Schwachstellen, Bedürfnisse, Bedenken und andere Informationen der Benutzer erfassen, um maßgeschneiderte Dienste zu erstellen. Softwareseite: Der Qualcomm AI-Entwicklungsstack wurde veröffentlicht. Der KI-Entwicklungsstack von Qualcomm unterstützt gängige KI-Frameworks wie TensorFlow, PyTorch, ONNX und Keras sowie Laufzeiten wie TensorFlow Lite, TensorFlow Lite Micro und ONNX Runtime. Darüber hinaus umfasst es Inferenz-Software-Entwicklungskits (SDKs) wie das beliebte Qualcomm® Neural Processing SDK für Android, Linux und Windows. Entwicklerbibliotheken und -dienste unterstützen die neuesten Programmiersprachen, virtuellen Plattformen und Compiler. Auf einer niedrigeren Ebene umfasst die KI-Entwicklungsstack-Systemsoftware von Qualcomm ein grundlegendes Echtzeitbetriebssystem (RTOS), Systemschnittstellen und Treiber. Der Qualcomm AI-Entwicklungsstack bietet umfangreiche und vielfältige Betriebssystemunterstützung in verschiedenen Produktlinien, darunter Android, Windows, Linux und QNX, sowie Bereitstellungs- und Überwachungsinfrastrukturen wie Prometheus, Kubernetes und Docker, einschließlich AI Studio unterstützt alles von einem kompletten Arbeitsablauf für große Modelle vom Entwurf bis zur Optimierung, Bereitstellung und Analyse, integriert alle Tools in einer einzigen grafischen Benutzeroberfläche und bietet Visualisierungstools, um die Entwicklererfahrung zu vereinfachen und ihnen die Anzeige der Modellentwicklung in Echtzeit zu ermöglichen, einschließlich der Effizienz von KI-Modellen Tools-Paket (AIMET), AIMET Model Repository, Model Analyzer und Neural Architecture Search (NAS).Hardwareseite: Qualcomm Hexagon Prozessorkern. Der Qualcomm-Hexagon-Prozessor verwendet eine neue Architektur und ein dediziertes Stromversorgungssystem. Er fügt spezielle Hardware hinzu, um die Gruppenfaltung und Aktivierungsfunktionsbeschleunigung bei der KI-Inferenz zu verbessern, und verdoppelt die Leistung des Tensorbeschleunigers. Er verwendet eine einzigartige Methode zur Konvertierung komplexer KI Das Modell wird in Mikrokacheln zerlegt, um den Inferenzprozess zu beschleunigen. Skalar-, Vektor- und Tensorbeschleuniger können gleichzeitig arbeiten, ohne jedes Mal Speicher zu beanspruchen, wodurch Stromverbrauch und Zeit gespart werden. Darüber hinaus wird eine nahtlose Multi-IP-Kommunikation mit Hexagon durch physische Brücken erreicht. Diese Verbindung kann verwendet werden, um Anwendungen mit hoher Bandbreite und geringer Latenz wie kognitive ISPs anzutreiben oder niedrige Auflösungen in Gaming-Szenarien zu steigern. Qualcomm Hexagon Processor hat mehrere Deep-Learning-Modelle erfolgreich von FP32 auf INT4 konvertiert und dabei den Energieverbrauch um bis zu 60 % gesenkt und gleichzeitig die Leistung um 90 % gesteigert.

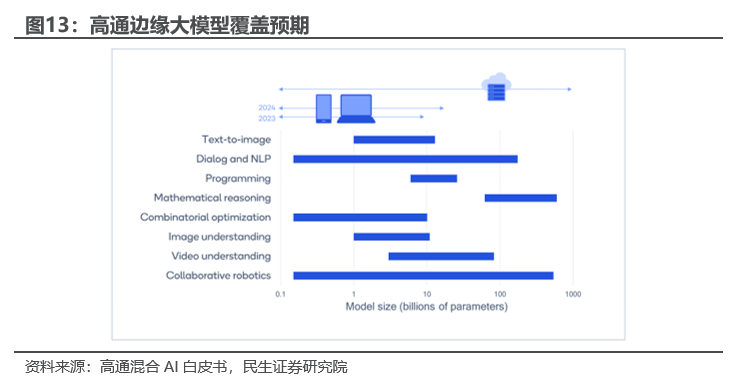

Qualcomm hat das stabile Diffusionsmodell bereits in der Praxis eingesetzt und seine Zukunftspläne für den groß angelegten Edge-Einsatz künstlicher Intelligenz sind sehr klar. Im Februar 2023 nutzte Qualcomm den Qualcomm AI Stack, um eine Full-Stack-KI-Optimierung durchzuführen und stellte Stable Diffusion erstmals auf Android-Smartphones bereit. Qualcomm veröffentlichte im Mai 2023 ein Whitepaper zur hybriden künstlichen Intelligenz, in dem prognostiziert wurde, dass die Spitzentechnologie der künstlichen Intelligenz bis Ende 2023 verschiedene Modelle mit Parametern unter 1 Milliarde abdecken wird.

1.3 Zhongke Chuangda: Integrierte Entwicklung von Software und Hardware eines großen Modells + einer großen Plattform

Am 18. Mai 2023 veröffentlichte Thunderbolt das Rubik-Großmodell, den Prototyp des ersten einheitlichen Betriebssystems für Edge-KI-Terminals in China. Gleichzeitig gründete Thunderstar gemeinsam mit ihm ein Innovationsexperiment für künstliche Intelligenz Amazon Cloud Technology-Raum und zeigte eine Reihe von Chuangda Rubik's Cube-Produkten wie TurboX-Module, Referenzdesigns für intelligente Lautsprecher und Rubik GeniusCanvas. Laut dem Jahresbericht 2022 des Unternehmens hat das Unternehmen seit seiner Gründung immer mehr Terminal-, Edge- und Cloud-seitige Technologien angesammelt und ist mittlerweile zum weltweit führenden Technologiehersteller in den oben genannten Bereichen geworden. Darüber hinaus decken die Roboterprodukte des Unternehmens nahezu alle derzeit existierenden Roboterszenarien ab und werden von vielen Roboterherstellern auf der ganzen Welt bevorzugt. Darüber hinaus pflegt das Unternehmen eine intensive Zusammenarbeit mit führenden Unternehmen der Technologie- und Produktkette der Industriekette und baut so einen ökologischen Vorteil auf. Das Unternehmen verfügt über große Modelle auf der Softwareseite der Edge-KI und ist auf der Hardwareseite stark in die Ökologie von Technologiegiganten wie Qualcomm und Amazon eingebunden. Der Entwicklungspfad integrierter Software und Hardware birgt großes Potenzial.

1.3.1 Horizontale Ansicht: Chuangda Rubik baut ein KI-Ökosystem rund um das bestehende Geschäft auf

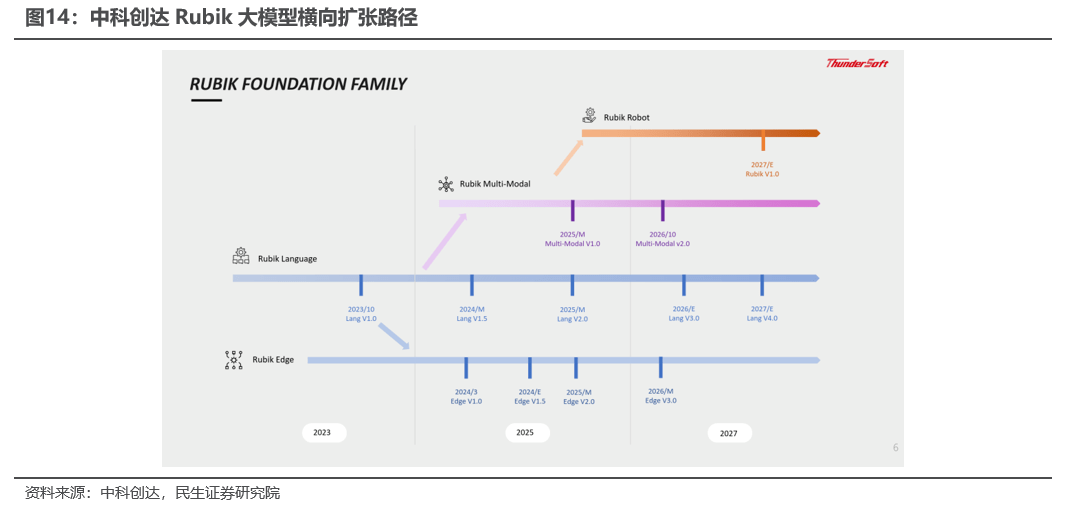

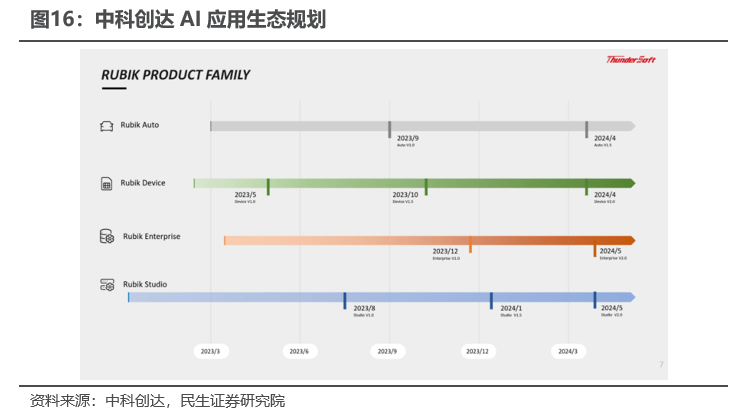

Das Kernprodukt der großen Rubik-Modellreihe ist das große Rubik-Sprachmodell. Der Vorsitzende prognostiziert, dass es im Jahr 2024 das ChatGPT3.5-Niveau erreichen wird. Rubik Edge, Rubik Multi-Modal und der Rubit Robot, der voraussichtlich im Jahr 2027 auf den Markt kommt, werden alle die Bereiche Smartphones und intelligentes Fahren bedienen und das Interaktionserlebnis zwischen Mensch und Computer verbessern. Gleichzeitig baut die Rubik-Reihe ein Ökosystem rund um die Mensch-Computer-Interaktion und bestehende Unternehmen auf: RubikStudio, RubikAuto, RubikDevice und Rubik Enterprise. Während es über ein leistungsstarkes großes Modell verfügt, wird es auch das große Modell in eine Vielzahl kleiner und mittlerer Modelle umwandeln, um der Aufteilung verschiedener Szenarien und Kenntnisse gerecht zu werden und die Anpassungsfähigkeit gegenüber Kunden zu verbessern.

Ähnlich wie bei Google wird Chuangdas großes Rubik-Modell voraussichtlich das erste sein, das einen Roboter landet. Unter den vielen intelligenten Hardwareprodukten können die Roboterprodukte von Thunderstar eine Vielzahl unterschiedlicher Anwendungsszenarien abdecken und haben vielen Roboterherstellern auf der ganzen Welt dabei geholfen, die Massenproduktion ihrer Produkte zu erreichen. Basierend auf seiner umfassenden Erfahrung im Bereich Roboter hat Thunderstar intelligente Lautsprecher in Roboter integriert und durch kontinuierliches Training mit dem Rubik-Großmodell einen intelligenten Verkaufsroboter realisiert, der frei sprechen und Kundenfragen zum Unternehmen selbstständig beantworten kann und Produkte.

1.3.2 Vertikale Ansicht: Das KI-Anwendungsökosystem von Chuangda ist einsatzbereit

Die Smart to Intelligent-Strategie von Thunderstar wurde ins Leben gerufen, um eine neue intelligente Welt von intelligenter anwendungszentrierter bis hin zu modellgesteuerter Maschine-Maschine- und Maschine-Mensch-Interaktion zu verwirklichen. Das Rubik-Großmodell wird in die bestehenden Smart-Car- und IoT-Geschäfte des Unternehmens integriert und erfüllt die Anforderungen verschiedener Branchen durch privatisierte Bereitstellung und Systemoptimierung. Es wird erwartet, dass das Unternehmen Roboter durch kontinuierliche Optimierung großer Modelle in die Realität umsetzen und seine wichtigsten Wettbewerbsvorteile im toBtoC-Bereich der zukünftigen intelligenten Computerindustrie ausspielen wird.

RUBIK Auto: Ein Auto ist im Wesentlichen ein Roboter. Das erste ist die endseitige Bedienung, die beste Leistung und die beste Möglichkeit, die Privatsphäre der Kunden zu schützen. Allerdings sind die Hardware-Anforderungen höher; das zweite ist eine private Cloud + Plugin, die flexibel angepasst werden kann; das dritte ist die Koexistenz mehrerer offener Modelle. RUBIK Auto des Unternehmens wird die Kundenprivatisierung unterstützen (es hat mit führenden ausländischen Automobilherstellern zusammengearbeitet, um POC-Forschung und -Entwicklung auf der Grundlage des Unternehmensmodells durchzuführen), außerdem die Modellquantifizierung und -anpassung unterstützen und sich dann an verschiedene Chips anpassen, um eine flexible Schnittstelle zum Auto herzustellen Hersteller.

RUBIK-Gerät: Solange es sich um große Computerprodukte handelt, können Chuangdas führende intelligente Hardware-Betriebssysteme direkt KI hinzufügen Szene. Ganz gleich, ob es sich um eine Heimszene, eine Gebäudeszene oder eine Fabrikszene handelt, jede Szene kann durch Edge-Bereitstellung zu einem intelligenten Zentrum werden.

RUBIK Enterprise (Enterprise Edition): Einer der offensichtlichen Vorteile von Chuangda ist die Internationalisierung. Das Unternehmen verfügt über Forschungs- und Entwicklungszentren und -teams in 15 Ländern und Regionen auf der ganzen Welt. Der zweite offensichtliche Vorteil des Unternehmens ist die Integration von Software und Hardware. Unabhängig davon, ob es sich um Schlussfolgerungen oder Schulungen handelt, verfügt das Unternehmen über ein sehr gutes Verständnis der gesamten zugrunde liegenden Plattform Es handelt sich um das AI-Framework oder die anderen Open-Source-Frameworks, die im Wesentlichen Teil des Betriebssystems sind. Unabhängig davon, ob es sich um Datenparallelität oder Modellparallelität handelt, ist das Unternehmen der Ansicht, dass es sich bei allen um Middleware handelt. Diese offensichtlichen Vorteile ermöglichen es uns, letztendlich die Leistung und Effizienz von Modellen zu optimieren, den Modellmaßstab zu optimieren, es am Rande zu betreiben und Tausende von Branchen zu stärken.

RUBIK Studio: Basierend auf dem tiefen Verständnis des Unternehmens für das Betriebssystem differenziert und modelliert das Unternehmen jedes Segment des Betriebssystems und sammelt Tausende erfolgreich veröffentlichter Pakete, Hunderte Milliarden Codezeilen und langjährige Entwicklungserfahrung. Verwandeln Sie Android-Wissen in eine riesige Wissensdatenbank und entfalten Sie einen enormen Wert. Rubik Studio wird ein großes Werkzeug und eine Umgebung sein, die die gesamte Zukunft verändern wird. Benutzer können über Rubik Studio direkt und schnell PC-Anwendungen, mobile Anwendungen und Websites mit relativ geschlossenen Funktionen entwickeln.

1.4 Apple: ChatGPT ist erstmals mit IOS verbunden, es lohnt sich, sich auf die WWDC 2023 zu freuen

Am 18. Mai 2023 veröffentlichte OpenAI die IOS-Version der ChatGPT-APP (gleichzeitig wurde offiziell bekannt gegeben, dass sich die Android-Version der APP in der Entwicklung befindet, die Anwendung unterstützt nur Englisch und hat ein Alter). Altersfreigabe „12 Jahre und älter“ und unterstützt Netzwerksynchronisierung von Chat-Aufzeichnungen, Flüster-Spracheingabe und andere Funktionen. Die IOS-Version der ChatGPT-Downloadanwendung ist kostenlos, es wird jedoch ein kostenpflichtiger „ChatGPT Plus“-Artikel zum Preis von 19,99 US-Dollar innerhalb der APP bereitgestellt, um die Nutzung großer GPT4-Modelle mit stärkerer Leistung zu ermöglichen.

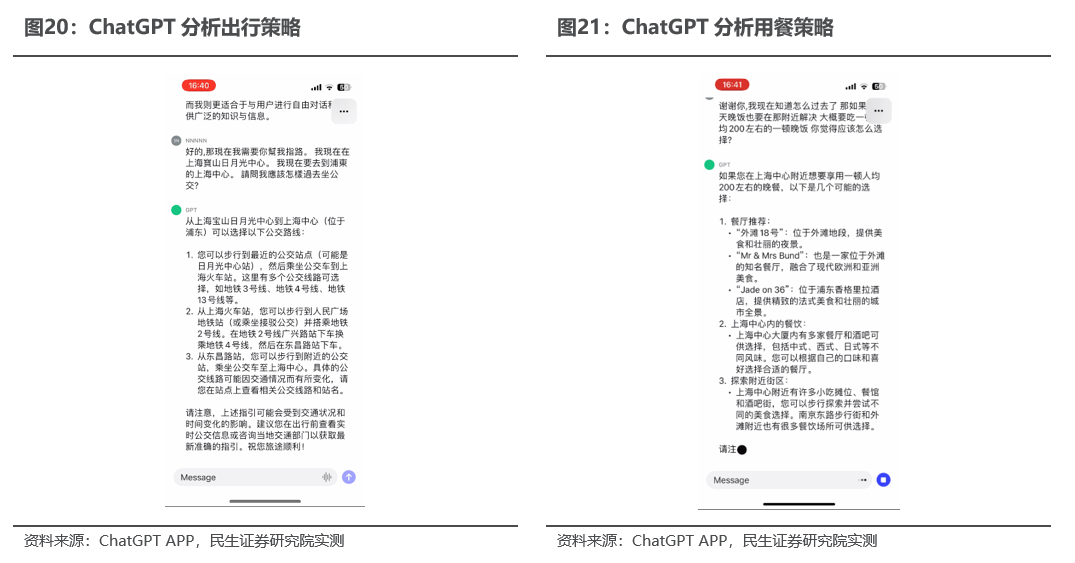

Umgeschriebener Satz: Die ChatGPT-App könnte zum Prototyp der Super-App für Mobiltelefone werden und auf dieser Grundlage das Anwendungsökosystem für künstliche Intelligenz rekonstruieren. Laut Jiupai Finance bietet die IOS-Version der ChatGPT-App bereits die Möglichkeit, verschiedene alltägliche Probleme flexibel zu lösen, und Benutzer können genaue Informationen erhalten, ohne Werbung oder mehrere Ergebnisse zu filtern, und Benutzer können sich umdrehen Sie können ihnen Ratschläge zum Kochen, zur Reiseplanung oder zum Verfassen einer nachdenklichen Botschaft geben; sie bieten kreative Inspiration, generieren Geschenkideen für Benutzer, skizzieren eine Präsentation oder schreiben schöne Gedichte. Darüber hinaus kann die ChatGPT-APP Benutzern auch dabei helfen, ihre Arbeitseffizienz durch professionelle Informationen wie Ideen-Feedback, Notizzusammenfassungen und technische Themen zu verbessern, und Benutzern Lernmöglichkeiten bieten, die ihnen dabei helfen, neue Sprachen, moderne Geschichte usw. zu erkunden eigenes Tempo. Wir glauben, dass unter der Voraussetzung der erfolgreichen Implementierung des ChatGPT+Plugin-KI-Anwendungsökosystems die ChatGPT-APP in Zukunft durch das Training umfangreicher interaktiver Daten von Mobiltelefonbenutzern zum Kern des mobilen KI-Anwendungsökosystems werden wird Von Benutzern wird erwartet, dass sie über die ChatGPT-App andere Anwendungen aufrufen, um verschiedene starre Aufgaben zu erfüllen. Die ChatGPT-App wird sich zu einer beispiellosen Super-App entwickeln.

Das Motto der Apple WWDC 2023 lautet „Code new worlds“. Als wichtiger Einstieg in die Mensch-Computer-Interaktion wird erwartet, dass Siri für Apple ein wichtiger Ausgangspunkt für den Einstieg in die KI wird. Laut IT House, Xinzhiyuan und Tencent Cloud wird Apple spätestens im Februar 2023 mit der Entwicklung von Anwendungen beginnen, die es Benutzern ermöglichen, Siri zum Erstellen von Programmen für MR zu verwenden. Die Technologie hinter dieser Anwendungskonstruktionsmethode stammt aus der Übernahme von MR durch Apple im Jahr 2017. Fabric-Software: Benutzer können Siri zum Erstellen von AR-Apps verwenden und den KI-Assistenten bitten, beim Erstellen von Apps zu helfen, die es virtuellen Tieren ermöglichen, sich in einem Raum auf und um reale Objekte herum zu bewegen, ohne das Tier von Grund auf neu entwerfen zu müssen Seine Animationen und die Berechnung seiner Bewegungen im 3D-Raum mit Hindernissen umfassen das „Scannen und Importieren realer Objekte in das Headset, damit sie genau in 3D dargestellt werden können und sich so verhalten, als ob sie im wirklichen Leben existieren würden.“

1.5 Huawei: IEF+Gaußsche Datenbank deckt Edge-KI-Szenarien vollständig ab

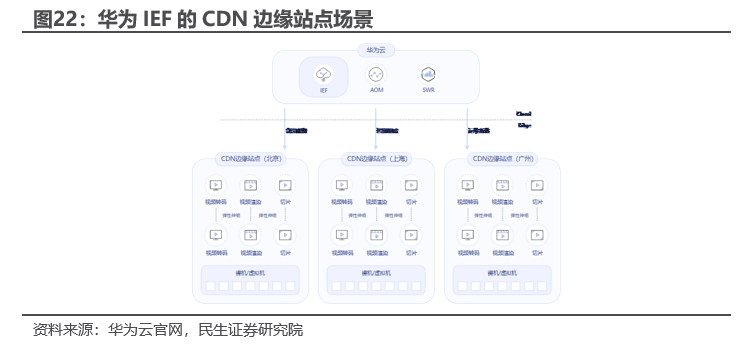

Huawei Intelligent Edge Platform IEF ist ein kollaboratives Edge-Cloud-Betriebssystem, das auf Cloud-nativer Technologie basiert. Es kann auf einer großen Anzahl heterogener Edge-Geräte ausgeführt werden und umfangreiche KI, Datenanalyse, Middleware und andere Anwendungen aus der Cloud auf einfache Weise bereitstellen Weise an den Rand, um die geschäftlichen Anforderungen der Benutzer an die Edge-Cloud-Zusammenarbeit intelligenter Anwendungen zu erfüllen. IEF kann die KI-/Big-Data-Funktionen von Huawei Cloud auf den Edge erweitern, intelligente Videoanalyse, Texterkennung, Bilderkennung, Big-Data-Stream-Verarbeitung und andere Funktionen unterstützen und intelligente Edge-Dienste in Echtzeit bereitstellen. Es unterstützt zwei Betriebsmodi: Container und Funktion erfüllt die Anforderungen der Benutzer an ein einfaches Anwendungsmanagement; es unterstützt nativ Kubernetes und Docker-Ökologie und unterstützt darüber hinaus Funktions-Engines wie Python und NodeJS; Es zeichnet sich durch hervorragende Kompatibilität, Sicherheit und Zuverlässigkeit aus.

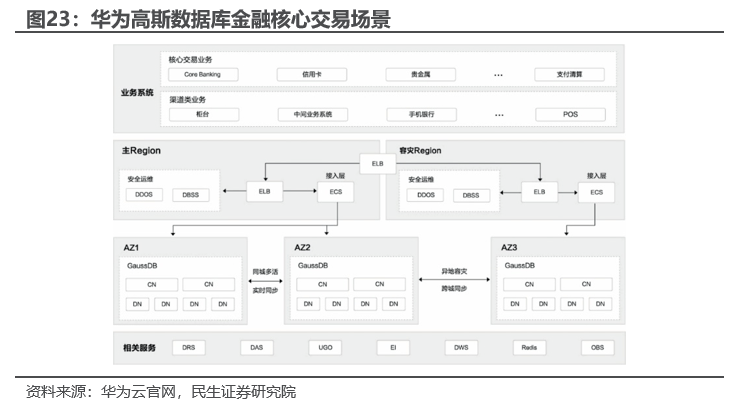

Huawei Gauss Database ist eine verteilte relationale Datenbank auf Unternehmensebene, die auf dem openGaussDB-Selbstforschungs-Ökosystem basiert. Sie verfügt über komplexe Transaktions-Mixed-Load-Funktionen auf Unternehmensebene, unterstützt eine starke Konsistenz verteilter Transaktionen und kann über AZs hinweg bereitgestellt werden Stadt, hat keinen Datenverlust und unterstützt mehr als 1000 Kapazitätserweiterungen, Massenspeicher auf PB-Ebene. Gleichzeitig verfügt es über wichtige Funktionen wie hohe Verfügbarkeit, hohe Zuverlässigkeit, hohe Sicherheit, elastische Skalierung, Bereitstellung mit einem Klick, schnelle Sicherung und Wiederherstellung sowie Überwachung und Alarmierung in der Cloud. Es kann Unternehmen ein Unternehmensniveau bieten Datenbank mit umfassenden Funktionen, Stabilität, Zuverlässigkeit, starker Skalierbarkeit und überlegener Leistung. Am 7. Juni 2023 wird Huawei Goss eine Konferenz zum Thema Datenbankbeschleunigung bei Upgrades von Kernfinanzgeschäften abhalten.

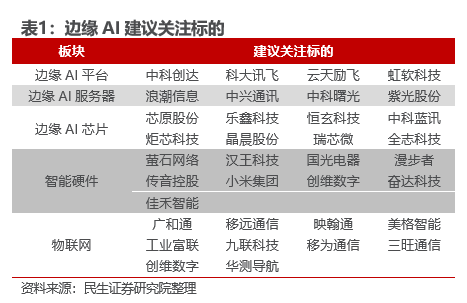

Investitionsempfehlung: Der allgemeine Trend der KI von der Cloud zum Edge ist etabliert und unsere frühen Urteile wurden kontinuierlich überprüft: Edge-KI ist ein Branchentrend, verkörperte Intelligenz ist die interne Logik (KI-Selbstverbesserung erfordert die Interaktionsdaten zwischen Menschen und die Umgebung, die auf dem Terminal konzentriert werden soll), sind Roboter die ultimative Anwendung. Wir haben am 13. Mai 2023 einen Bericht mit dem Titel „Chungda: Große Modelle von der Cloud bis zum Edge, Terminal-Interaktionsrevolution bringt historische Chancen“ veröffentlicht, in dem klar dargelegt wurde, dass Google energisch in den Markt für große Terminalmodelle einsteigen wird und Terminal-KI zum nächsten Muss wird -haben für Militärstrategen veröffentlicht; dann wurde am 14. Mai „Googles „Empire Strikes Back“: The Inflection Point of AI from Cloud to Edge“ veröffentlicht, in dem Googles KI-Plan von der Cloud bis zum Edge detailliert beschrieben und klargestellt wurde, dass der KI-Edge-Einsatz begonnen hat Realität; durch die Veröffentlichung von KI-Erfahrungsberichten zur IOS-Version von ChatGPT, Windows+AI und anderen KI-Erfahrungsberichten haben wir am 21. Mai „ChatGPT APP Marks a New Stage of AI Market“ veröffentlicht und deutlich gemacht, dass große Modelle das ultimative Betriebssystem sind System in der KI-Ära ist ChatGPT Super APP nur der erste Schritt, der den Fortschritt der traditionellen KI von der Cloud bis zum Ende beschleunigt. Diese Woche haben Unternehmen wie Nvidia, Qualcomm und Thunderstar verwandte Produkte veröffentlicht, um die Implementierung von Edge-KI zu beschleunigen. Nächste Woche werden Huawei und Apple Konferenzen veröffentlichen, bei denen Terminal-KI voraussichtlich im Mittelpunkt stehen wird Von der Cloud zum Edge ist es äußerst klar geworden, dass es empfohlen wird, auf führende Unternehmen wie Chuangda, iFlytek und EZVIZ Network zu achten.

Quelle: Ausgewählte Brokerage-Forschungsberichte

Das obige ist der detaillierte Inhalt vonMinsheng Securities: Edge AI ist ein Branchentrend. Es wird empfohlen, auf diese Ziele zu achten.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!