Wann werden die Bilderkennungsfunktionen von GPT-4 online sein? Auf diese Frage gibt es noch keine Antwort.

Aber die Forschungsgemeinschaft kann nicht länger warten und hat mit dem Selbermachen begonnen. Das beliebteste ist ein Projekt namens MiniGPT-4. MiniGPT-4 weist viele ähnliche Funktionen wie GPT-4 auf, beispielsweise die Erstellung detaillierter Bildbeschreibungen und die Erstellung von Websites aus handschriftlichen Entwürfen. Darüber hinaus beobachteten die Autoren andere neue Funktionen von MiniGPT-4, darunter das Erstellen von Geschichten und Gedichten auf der Grundlage vorgegebener Bilder, die Bereitstellung von Lösungen für in Bildern gezeigte Probleme, das Erlernen des Kochens für Benutzer anhand von Lebensmittelfotos usw. Das Projekt erhielt innerhalb von drei Tagen nach seinem Start fast 10.000 Sterne.

Das Projekt, das wir heute vorstellen werden – LLaVA (Large Language and Vision Assistant) ist ähnlich. Es handelt sich um eine multimodale Großsprache, die gemeinsam von Forschern der University of Wisconsin-Madison und Microsoft veröffentlicht wurde Forschung und Columbia University Modell.

Dieses Modell zeigt einige Bild- und Textverständnisfähigkeiten, die dem multimodalen GPT-4 nahe kommen: Es erreichte einen relativen Wert von 85,1 % im Vergleich zu GPT-4. Bei einer Feinabstimmung der wissenschaftlichen Qualitätssicherung erreicht die Synergie von LLaVA und GPT-4 einen neuen SoTA mit einer Genauigkeit von 92,53 %.

Das Folgende sind die Testergebnisse des Heart of the Machine (weitere Ergebnisse finden Sie am Ende des Artikels):

Menschen interagieren mit der Welt über mehrere Kanäle B. Vision und Sprache, da verschiedene Kanäle ihre eigenen einzigartigen Vorteile bei der Darstellung und Vermittlung bestimmter Konzepte haben und ein Mehrkanalansatz zu einem besseren Verständnis der Welt beiträgt. Eines der Kernziele der künstlichen Intelligenz besteht darin, einen universellen Assistenten zu entwickeln, der multimodalen Anweisungen wie visuellen oder verbalen Anweisungen effektiv folgen, menschliche Absichten erfüllen und verschiedene Aufgaben in realen Umgebungen erledigen kann.

Zu diesem Zweck gibt es in der Community einen Trend, visuelle Modelle zu entwickeln, die auf Sprachverbesserung basieren. Dieser Modelltyp verfügt über leistungsstarke Funktionen für das visuelle Verständnis der offenen Welt, wie Klassifizierung, Erkennung, Segmentierung und Grafiken sowie visuelle Generierungs- und visuelle Bearbeitungsfunktionen. Jede Aufgabe wird unabhängig von einem großen visuellen Modell gelöst, wobei die Anforderungen der Aufgabe im Modelldesign implizit berücksichtigt werden. Darüber hinaus wird Sprache nur zur Beschreibung von Bildinhalten verwendet. Während dadurch Sprache eine wichtige Rolle bei der Zuordnung visueller Signale zur sprachlichen Semantik (einem gemeinsamen Kanal für die menschliche Kommunikation) spielt, führt dies zu Modellen, die oft über feste Schnittstellen mit Einschränkungen in der Interaktivität und Anpassungsfähigkeit an Benutzeranweisungen verfügen.

Große Sprachmodelle (LLMs) hingegen haben gezeigt, dass Sprache eine umfassendere Rolle spielen kann: als universelle interaktive Schnittstelle für universelle intelligente Assistenten. In einer gemeinsamen Schnittstelle können verschiedene Aufgabenanweisungen explizit in Sprache ausgedrückt werden und den durchgängig trainierten neuronalen Netzwerkassistenten anleiten, den Modus zu wechseln, um die Aufgabe abzuschließen. Beispielsweise demonstrierte der jüngste Erfolg von ChatGPT und GPT-4 die Leistungsfähigkeit von LLM bei der Befolgung menschlicher Anweisungen zur Erledigung von Aufgaben und löste eine Welle der Entwicklung von Open-Source-LLM aus. Unter diesen ist LLaMA ein Open-Source-LLM mit einer ähnlichen Leistung wie GPT-3. Alpaca, Vicuna, GPT-4-LLM nutzt verschiedene maschinengenerierte, hochwertige Instruktions-Trace-Beispiele, um die Ausrichtungsfähigkeiten von LLM zu verbessern und eine beeindruckende Leistung im Vergleich zu proprietären LLMs zu demonstrieren. Leider besteht die Eingabe in diese Modelle nur aus Text.

In diesem Artikel schlagen Forscher eine Methode zur visuellen Instruktionsabstimmung vor, die den ersten Versuch darstellt, die Instruktionsabstimmung auf den multimodalen Raum auszudehnen und so den Weg für die Entwicklung eines allgemeinen visuellen Assistenten zu ebnen.

Im Einzelnen leistet dieses Papier die folgenden Beiträge:

Für das Eingabebild X_v verwendet dieser Artikel den vorab trainierten visuellen CLIP-Encoder ViT-L/14, um das visuelle Merkmal Z_v=g (X_v) zu verarbeiten und zu erhalten. Im Experiment wurden die Netzmerkmale vor und nach der letzten Transformer-Ebene verwendet. In diesem Artikel wird eine einfache lineare Ebene verwendet, um Bildfunktionen im Worteinbettungsraum zu verbinden. Konkret wird nach Anwendung der trainierbaren Projektionsmatrix W zur Transformation von Z_v in Spracheinbettungstoken H_q, die die gleichen Abmessungen wie der Worteinbettungsraum im Sprachmodell haben:

, eine Folge visueller Token H_v erhalten. Dieses einfache Projektionsschema ist leichtgewichtig, kostengünstig und kann schnell auf datenzentrierten Experimenten basieren. Man kann auch komplexere (aber kostspieligere) Schemata zur Verkettung von Bild- und Sprachfunktionen in Betracht ziehen, wie etwa den Gated-Cross-Attention-Mechanismus in Flamingo und den Q-Former in BLIP-2, oder andere visuelle Encoder, die Funktionen auf Objektebene bereitstellen, wie z SAM.

Experimentelle Ergebnisse

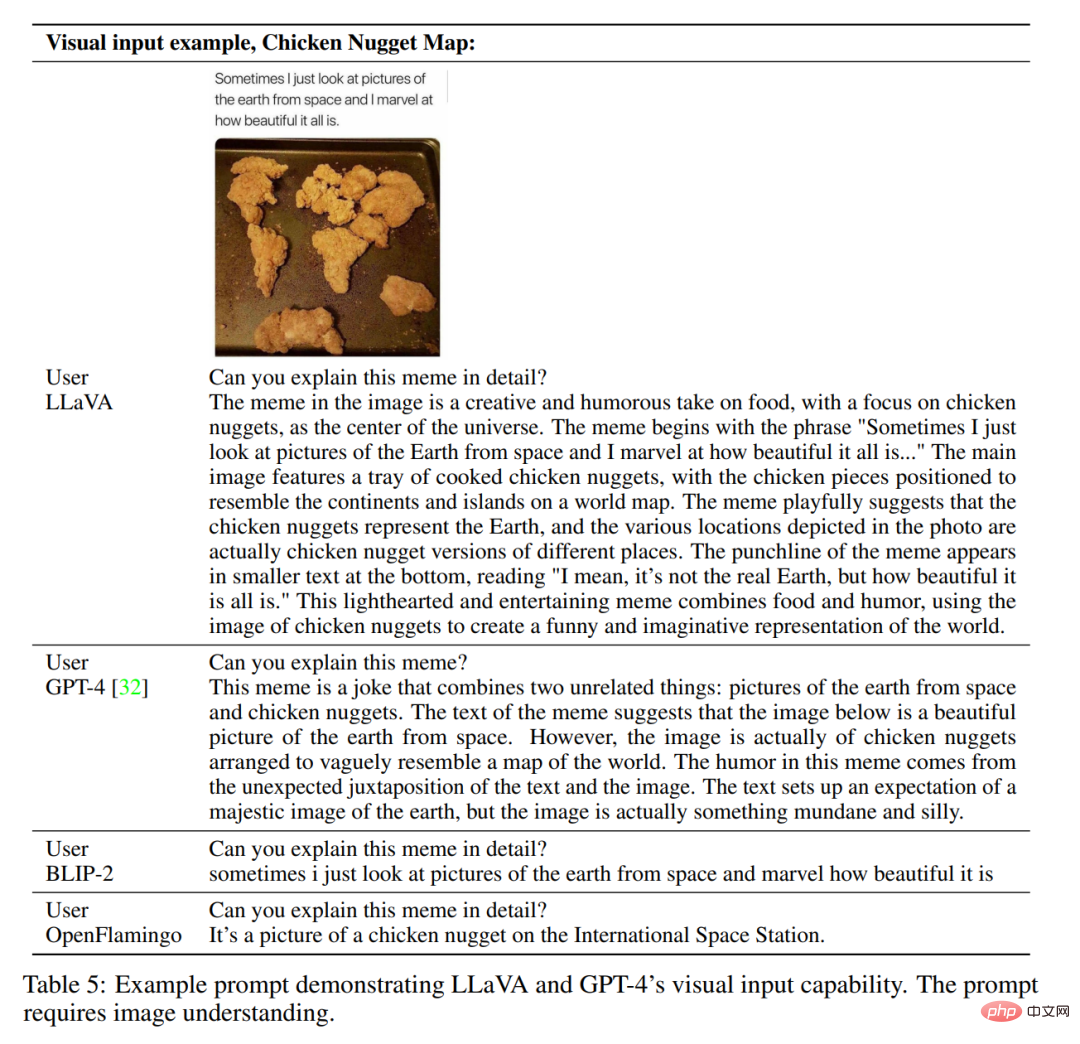

Die Forscher entwickelten ein Chatbot-Beispielprodukt, um die Bildverständnis- und Dialogfähigkeiten von LLaVA zu demonstrieren. Um weiter zu untersuchen, wie LLaVA visuelle Eingaben verarbeitet und seine Fähigkeit zur Verarbeitung von Anweisungen demonstriert, verwendeten die Forscher zunächst Beispiele aus dem ursprünglichen GPT-4-Papier, wie in den Tabellen 4 und 5 dargestellt. Der verwendete Prompt muss zum Bildinhalt passen. Zum Vergleich zitiert dieser Artikel die Aufforderungen und Ergebnisse des multimodalen Modells GPT-4 aus ihrer Arbeit.

Obwohl LLaVA mit einem kleinen multimodalen Befehlsdatensatz (~80.000 einzelne Bilder) trainiert wurde, zeigt es überraschenderweise anhand der beiden oben genannten Beispiele, dass die Inferenzergebnisse dem multimodalen Modell sehr ähnlich sind GPT-4. Beachten Sie, dass beide Bilder außerhalb des Umfangs des LLaVA-Datensatzes liegen, der in der Lage ist, die Szene zu verstehen und die Fragenanweisungen zu beantworten. Im Gegensatz dazu konzentrieren sich BLIP-2 und OpenFlamingo auf die Beschreibung von Bildern und nicht darauf, Benutzeranweisungen angemessen zu beantworten. Weitere Beispiele sind in Abbildung 3, Abbildung 4 und Abbildung 5 dargestellt.

Die quantitativen Auswertungsergebnisse sind in Tabelle 3 dargestellt.

ScienceQA

ScienceQA enthält 21.000 multimodale Multiple-Choice-Fragen zu 3 Themen, 26 Themen, 127 Kategorien und 379 Fähigkeiten, mit großer Domänenvielfalt. Der Benchmark-Datensatz ist in Trainings-, Validierungs- und Testteile mit jeweils 12726, 4241 und 4241 Proben unterteilt. In diesem Artikel werden zwei repräsentative Methoden verglichen, darunter das GPT-3.5-Modell (text-davinci-002) und das GPT-3.5-Modell ohne Chain of Thought (CoT)-Version, LLaMA-Adapter und Multimodal Thought Chain (MM-CoT) [57 ], die aktuelle SoTA-Methode für diesen Datensatz, und die Ergebnisse sind in Tabelle 6 aufgeführt.

Auf der im Dokument angegebenen Seite zur Visualisierungsnutzung hat Machine Heart auch versucht, einige Bilder und Anweisungen einzugeben. Die erste ist eine häufige Mehrpersonenaufgabe bei Fragen und Antworten. Tests haben gezeigt, dass kleinere Ziele bei der Personenzählung ignoriert werden, es zu Erkennungsfehlern bei sich überschneidenden Personen kommt und es auch zu Erkennungsfehlern beim Geschlecht kommt.

Als nächstes haben wir einige generative Aufgaben ausprobiert, wie zum Beispiel die Bilder zu benennen oder eine Geschichte basierend auf den Bildern zu erzählen. Die vom Modell ausgegebenen Ergebnisse sind immer noch auf das Verständnis des Bildinhalts ausgerichtet und die Generierungsfähigkeiten müssen gestärkt werden.

Auf diesem Foto kann die Anzahl der Personen auch dann genau identifiziert werden, wenn sich die menschlichen Körper überschneiden. Aus Sicht der Bildbeschreibung und des Verständnisses gibt es in der Arbeit dieses Artikels noch Höhepunkte und es gibt Raum für eine zweite Schöpfung.

Das obige ist der detaillierte Inhalt vonLava Alpaca LLaVA ist da: Wie bei GPT-4 können Sie Bilder ansehen und chatten, es ist kein Einladungscode erforderlich und Sie können online spielen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So binden Sie Daten in einer Dropdown-Liste

So binden Sie Daten in einer Dropdown-Liste

Lösung für den belegten Port phpstudy3306

Lösung für den belegten Port phpstudy3306

phpstudie

phpstudie

MySQL-Fehler 10060

MySQL-Fehler 10060

Was ist der Unterschied zwischen Blockieren und Löschen bei WeChat?

Was ist der Unterschied zwischen Blockieren und Löschen bei WeChat?

So überprüfen Sie, ob Port 445 geschlossen ist

So überprüfen Sie, ob Port 445 geschlossen ist

Der Unterschied zwischen Rest-API und API

Der Unterschied zwischen Rest-API und API

So deaktivieren Sie das Windows-Sicherheitscenter

So deaktivieren Sie das Windows-Sicherheitscenter