Neuigkeiten vom 2. Mai: Die meisten aktuellen KI-Chatbots müssen zur Verarbeitung mit der Cloud verbunden werden, und selbst diejenigen, die lokal ausgeführt werden können, haben extrem hohe Konfigurationsanforderungen. Gibt es also leichtgewichtige Chatbots, die keine Internetverbindung benötigen?

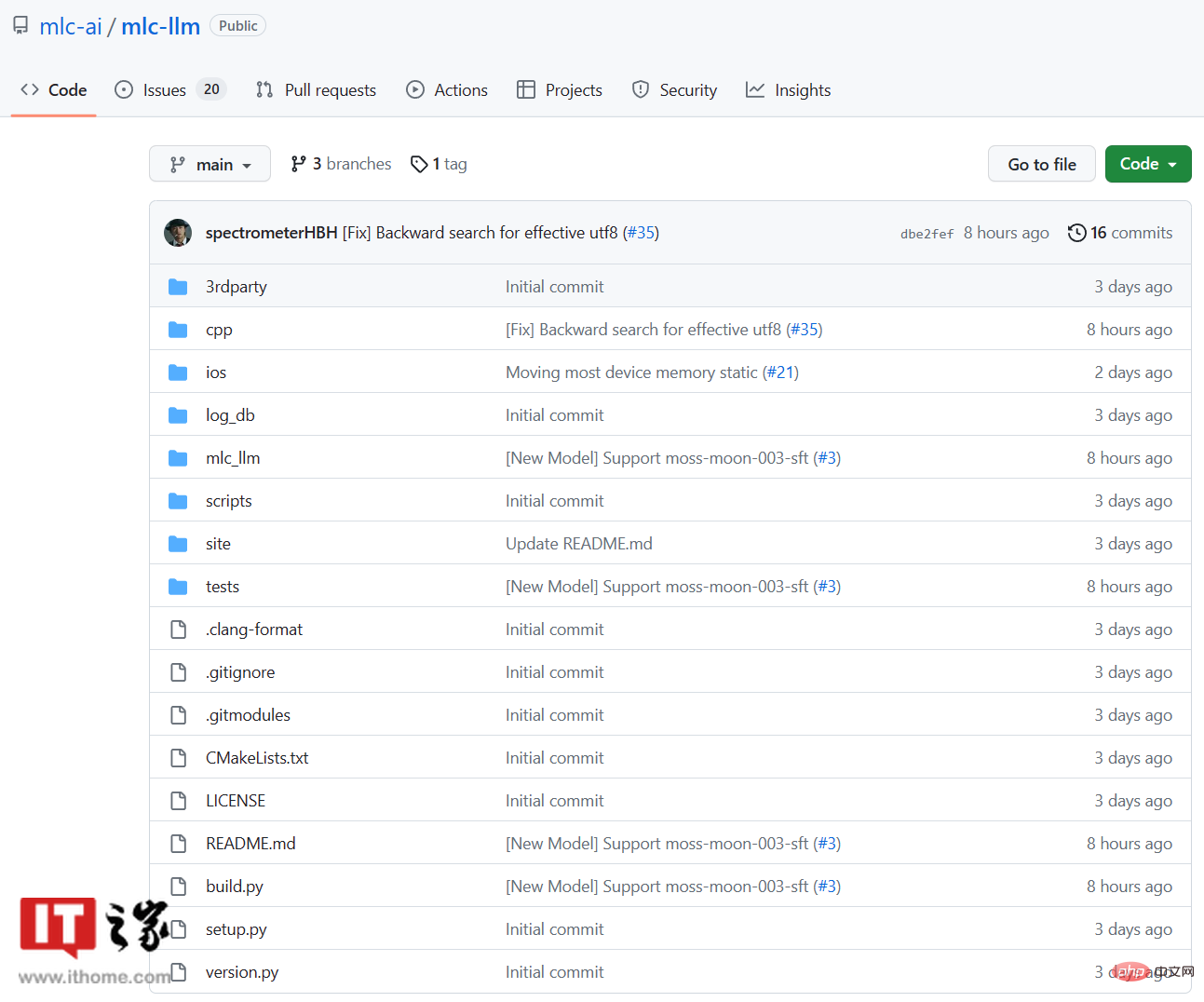

Ein neues Open-Source-Projekt namens MLC LLM wurde auf GitHub gestartet. Es läuft vollständig lokal, ohne dass eine Internetverbindung erforderlich ist. Es kann sogar auf alten Computern und Apple-Mobiltelefonen ausgeführt werden.

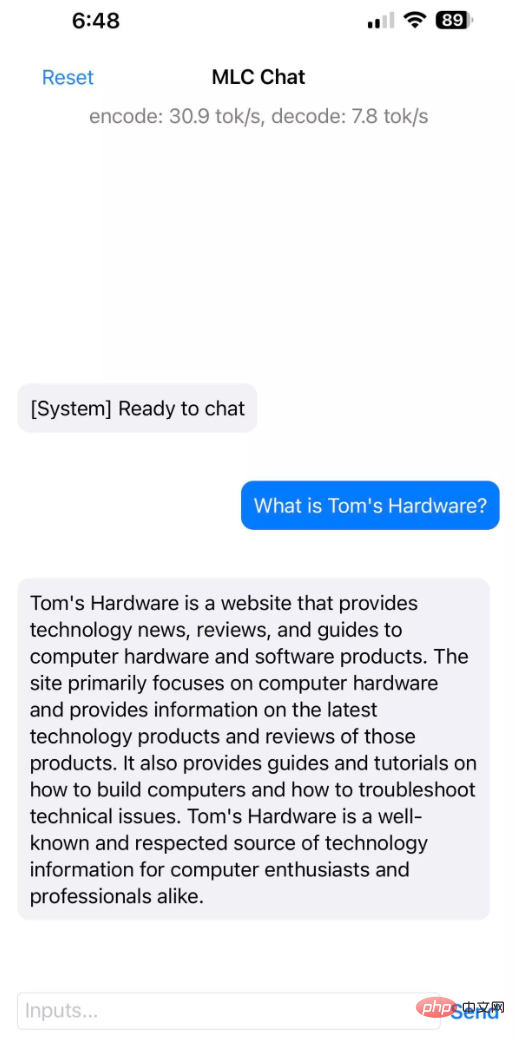

In der Einführung zum MLC LLM-Projekt heißt es: „MLC LLM ist eine universelle Lösung, die die lokale Bereitstellung jedes Sprachmodells auf einer Reihe verschiedener Hardware-Backends und nativer Anwendungen zusätzlich zu einem effizienten Framework ermöglicht, damit jeder das Modell weiter optimieren kann.“ Leistung für den eigenen Anwendungsfall. Alles läuft lokal, ohne Serverunterstützung, und wird durch lokale GPUs auf Mobiltelefonen und Laptops beschleunigt. Unsere Mission ist es, jedem die Möglichkeit zu geben, lokal zu entwickeln und zu optimieren ▲ Offizielle Demo des MLC LLM-Projekts

In der Einführung zum MLC LLM-Projekt heißt es: „MLC LLM ist eine universelle Lösung, die die lokale Bereitstellung jedes Sprachmodells auf einer Reihe verschiedener Hardware-Backends und nativer Anwendungen zusätzlich zu einem effizienten Framework ermöglicht, damit jeder das Modell weiter optimieren kann.“ Leistung für den eigenen Anwendungsfall. Alles läuft lokal, ohne Serverunterstützung, und wird durch lokale GPUs auf Mobiltelefonen und Laptops beschleunigt. Unsere Mission ist es, jedem die Möglichkeit zu geben, lokal zu entwickeln und zu optimieren ▲ Offizielle Demo des MLC LLM-Projekts

Auf der GitHub-Seite von IT House wurde festgestellt, dass die Entwickler dieses Projekts vom Catalyst Program der Carnegie Mellon University, der SAMPL Machine Learning Research Group und der Washington University, der Shanghai Jiao Tong University und OctoML usw. stammen. Sie haben auch ein Tool namens Web LLM. MLC ist die Abkürzung für Machine Learning Compilation. MLC LLM verwendet Vicuna-7B-V1.1, ein leichtes LLM, das auf Metas LLaMA basiert So gut wie GPT3.5 oder GPT4, ist es hinsichtlich der Größe vorteilhafter.

Derzeit ist MLC LLM für Windows-, Linux-, macOS- und iOS-Plattformen verfügbar. Für  Android

Android

iPhone 14 Pro Max

und iPhone 12 Pro Max-Telefone mit 6 GB Speicher erfolgreich MLC LLM mit einer Installationsgröße von 3 GB aus. Das Apple iPhone 11 Pro Max mit 4 GB Speicher kann MLC LLM nicht ausführen.

▲ Bildquelle tomshardwareMLC LLMs GitHub-Seite:

Klicken Sie hier, um es anzuzeigen

Das obige ist der detaillierte Inhalt vonMLC LLM: Ein Open-Source-KI-Chatbot, der den Offline-Betrieb unterstützt und für Computer und iPhones mit integrierten Grafikkarten geeignet ist.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!