2022 ist ein großes Jahr für KI, aber auch für Datenwettbewerbe, mit einem Gesamtpreisgeld von über 5 Millionen US-Dollar auf allen Plattformen.

Kürzlich hat die Analyseplattform für maschinelles Lernen-Wettbewerbe ML Contests eine groß angelegte Statistik zum Datenwettbewerb 2022 durchgeführt. Neuer Bericht wirft einen Blick auf alle bemerkenswerten Ereignisse im Jahr 2022. Im Folgenden finden Sie eine Zusammenstellung des Originaltextes.

Highlights:

Der Wettbewerb mit dem höchsten Preisgeld ist der Snow Cast Showdown Contest von Drivendata, der vom U.S. Bureau of Reclamation gesponsert wird. Die Teilnehmer erhalten ein Preisgeld von 500.000 US-Dollar und sollen dazu beitragen, das Wasserversorgungsmanagement zu verbessern, indem sie genaue Schätzungen des Schneewasserflusses für verschiedene Regionen im Westen liefern. Wie immer hat Drivendata einen ausführlichen Artikel zum Matchup geschrieben und einen ausführlichen Lösungsbericht, der durchaus lesenswert ist.

Der beliebteste Wettbewerb des Jahres 2022 ist der American Express Default Prediction-Wettbewerb von Kaggle, der darauf abzielt, vorherzusagen, ob Kunden ihre Kredite zurückzahlen werden. Mehr als 4.000 Teams nahmen teil, die vier besten Teams erhielten ein Preisgeld von insgesamt 100.000 US-Dollar. Zum ersten Mal in diesem Jahr wurde ein Erstbeitrag von einem Ein-Personen-Team gewonnen, das ein Ensemble aus neuronalen Netzen und LightGBM-Modellen nutzte.

Der größte unabhängige Wettbewerb ist die AI Audit Challenge der Stanford University, die einen Belohnungspool von 71.000 US-Dollar für die besten „Modelle, Lösungen, Datensätze und Tools“ bietet, um Wege zur Lösung des Problems „unrechtmäßige Diskriminierung“ zu finden .

Drei Wettbewerbe, die auf Finanzprognosen basieren, finden alle auf Kaggle statt: die Prognosen der Tokyo Stock Exchange von JPX, die Marktprognosen von Ubiquant und die Kryptoprognosen von G-Research.

Bei Vergleichen in verschiedene Richtungen hat Computer Vision den höchsten Anteil, NLP liegt an zweiter Stelle und sequentielle Entscheidungsprobleme (Reinforcement Learning) nehmen zu. Kaggle reagierte auf diese wachsende Popularität mit der Einführung von Simulationswettbewerben im Jahr 2020. Aicrowd veranstaltet auch viele Wettbewerbe zum verstärkten Lernen. Im Jahr 2022 beliefen sich die Gesamteinnahmen von 25 dieser interaktiven Veranstaltungen auf mehr als 300.000 US-Dollar.

Bei der Real Robot Challenge, dem offiziellen NeurIPS 2022-Wettbewerb, müssen die Teilnehmer lernen, einen dreifingrigen Roboter zu steuern, um einen Würfel an einen Zielort zu bewegen oder ihn an einem bestimmten Punkt im Raum zu positionieren, während er in die richtige Richtung blickt. Die Strategien der Teilnehmer werden jede Woche auf dem physischen Roboter ausgeführt und die Ergebnisse werden in der Bestenliste aktualisiert. Der Preis ist mit 5.000 US-Dollar dotiert und die akademische Ehre, auf dem NeurIPS-Symposium zu sprechen.

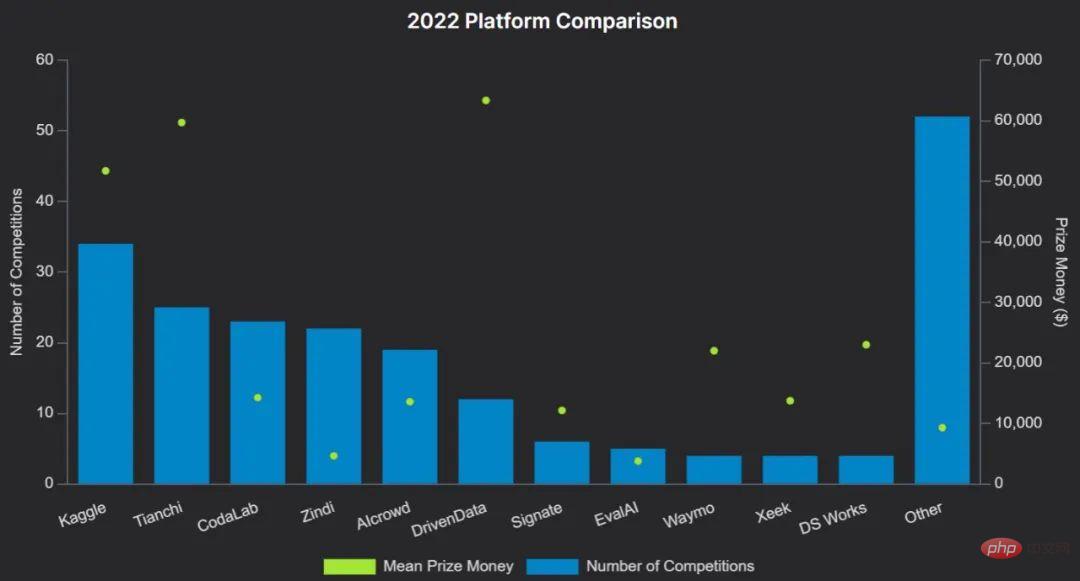

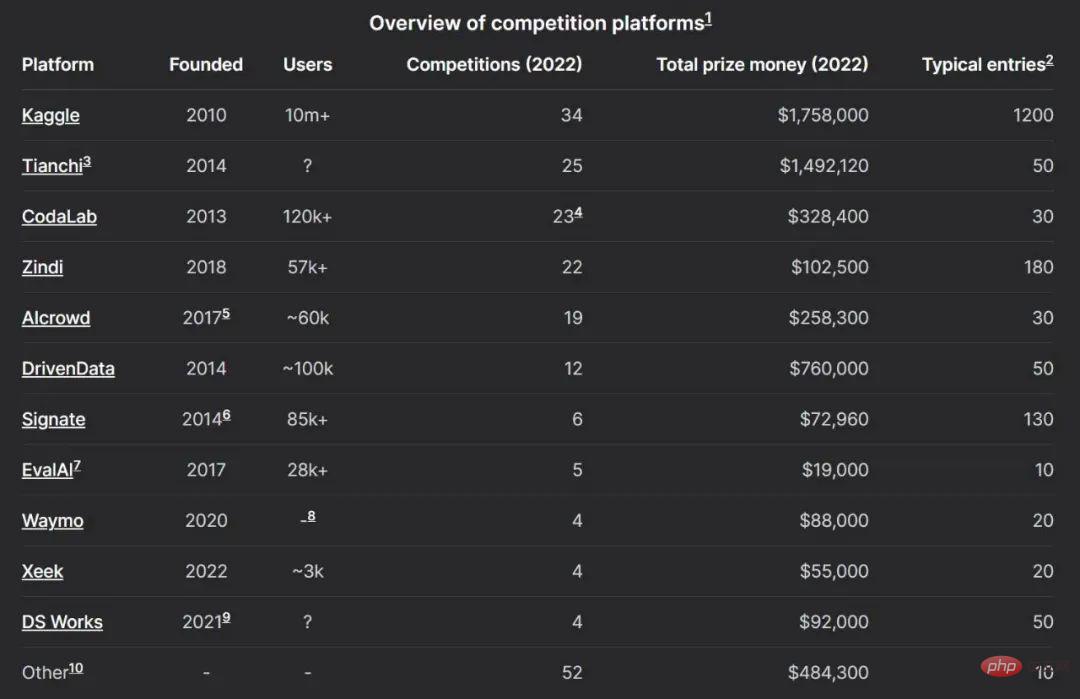

Obwohl die Leute mit Kaggle und Tianchi vertraut sind, gibt es derzeit viele Wettbewerbsplattformen für maschinelles Lernen, die ein aktives Ökosystem bilden.

Das Bild unten zeigt den Plattformvergleich 2022:

Nennen Sie einige Beispiele:

Der Großteil der Preisgelder für Wettbewerbe, die auf großen Plattformen laufen, kommt aus der Industrie, aber Wettbewerbe für maschinelles Lernen haben in der Wissenschaft eindeutig eine reichere Geschichte, wie Isabelle Guyon dieses Jahr bei NeurIPS tat. Wie bereits erwähnt in der Einladungsrede.

NeurIPS ist eine der renommiertesten akademischen Konferenzen zum Thema maschinelles Lernen weltweit, auf der regelmäßig die wichtigsten Beiträge zum maschinellen Lernen des letzten Jahrzehnts präsentiert werden, darunter AlexNet, GAN, Transformer und GPT-3.

NeurIPS veranstaltete 2014 erstmals einen Data Challenge in Machine Learning (CIML)-Workshop, seit 2017 gibt es eine Wettbewerbskomponente. Seitdem sind der Wettbewerb und das Gesamtpreisgeld weiter gewachsen und erreichten im Dezember 2022 fast 400.000 US-Dollar.

Andere Konferenzen zum Thema maschinelles Lernen veranstalten ebenfalls Wettbewerbe, darunter CVPR, ICPR, IJCAI, ICRA, ECCV, PCIC und AutoML.

Etwa die Hälfte aller Wettbewerbe für maschinelles Lernen haben Preispools von über 10.000 US-Dollar. Es besteht kein Zweifel, dass es bei vielen interessanten Wettbewerben kleine Preise gibt, und in diesem Bericht werden nur solche mit Geldpreisen oder akademischen Auszeichnungen berücksichtigt. Bei Datenwettbewerben im Zusammenhang mit prestigeträchtigen akademischen Konferenzen erhalten die Gewinner häufig Reisestipendien für die Teilnahme an der Konferenz.

Während einige Turnierplattformen im Durchschnitt tendenziell größere Preispools haben als andere (siehe Plattform-Vergleichstabelle), veranstalteten viele Plattformen im Jahr 2022 mindestens ein Turnier mit einem sehr großen Preispool – Gesamtpreise Die Top-Ten-Wettbewerbe umfassen diese laufen auf DrivenData, Kaggle, CodaLab und AIcrowd.

Diese Umfrage analysiert die vom Gewinneralgorithmus verwendeten Techniken anhand von Fragebögen und Codebeobachtungen.

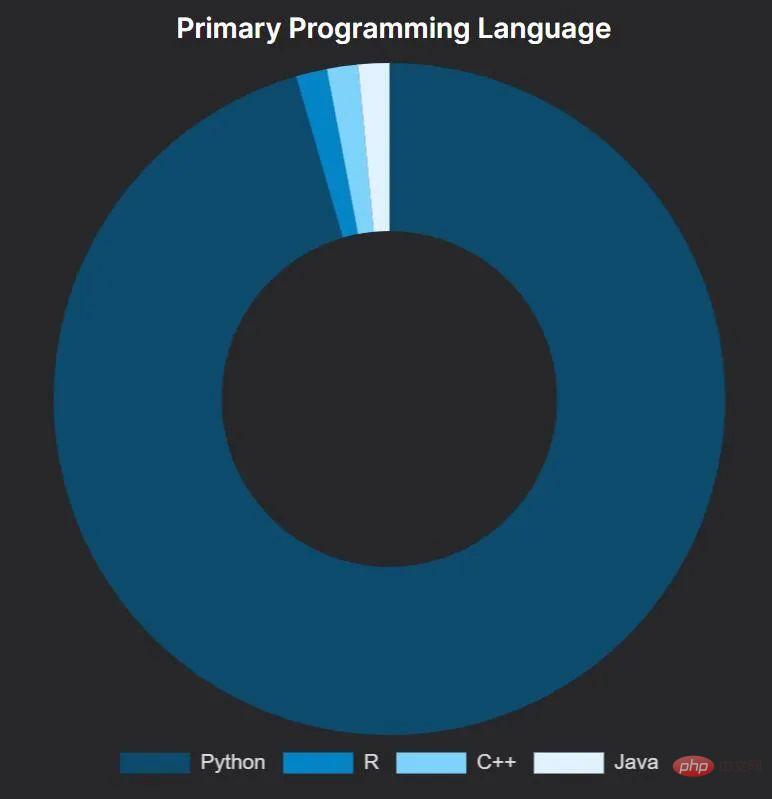

Ganz konsequent war Python die Sprache der Wahl für die Gewinner des Wettbewerbs, was für die Leute vielleicht kein unerwartetes Ergebnis ist. Von denen, die Python verwenden, verwendet etwa die Hälfte hauptsächlich Jupyter Notebook und die andere Hälfte Standard-Python-Skripte.

Eine erfolgreiche Lösung, die hauptsächlich R verwendet: Amir Ghazi gewann den Kaggle-Wettbewerb, um den Gewinner der US Men’s College Basketball Championship 2022 vorherzusagen. Er tat dies, indem er Code aus einer wettbewerbsgekrönten Lösung von Kaggle-Großmeister Darius Barušauskas aus dem Jahr 2018 verwendete – offenbar wörtlich kopierte. Unglaublich, dass Darius auch 2022 an diesem Rennen teilnahm, einen neuen Ansatz verfolgte und den 593. Platz belegte.

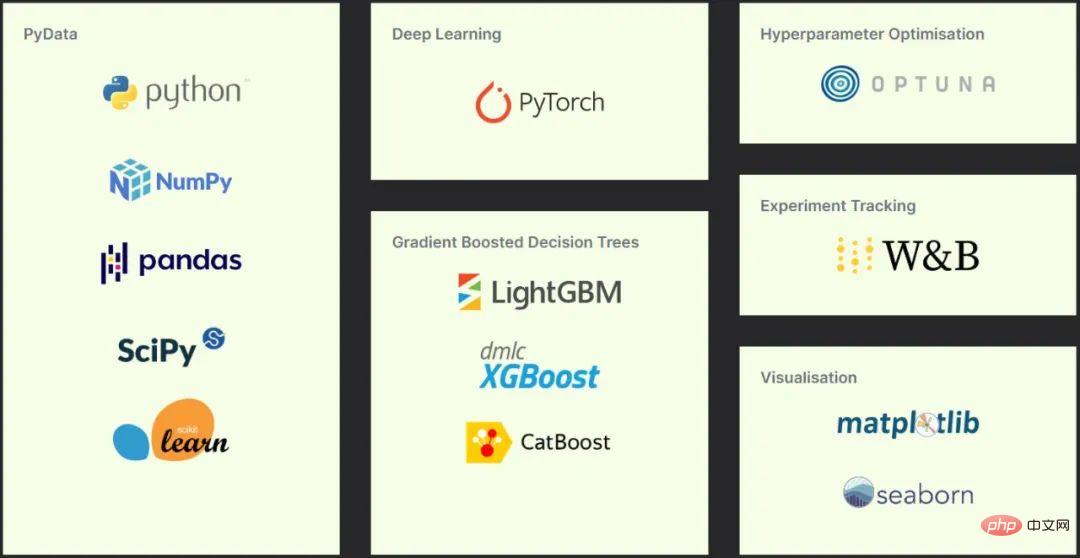

Bei der Betrachtung der in den Gewinnerlösungen verwendeten Pakete stellte sich heraus, dass alle Gewinner, die Python verwendeten, in gewissem Umfang den PyData-Stack nutzten.

Die beliebtesten Softwarepakete sind in drei Kategorien unterteilt: Kern-Toolkits, NLP-Kategorien und Computer-Vision-Kategorien.

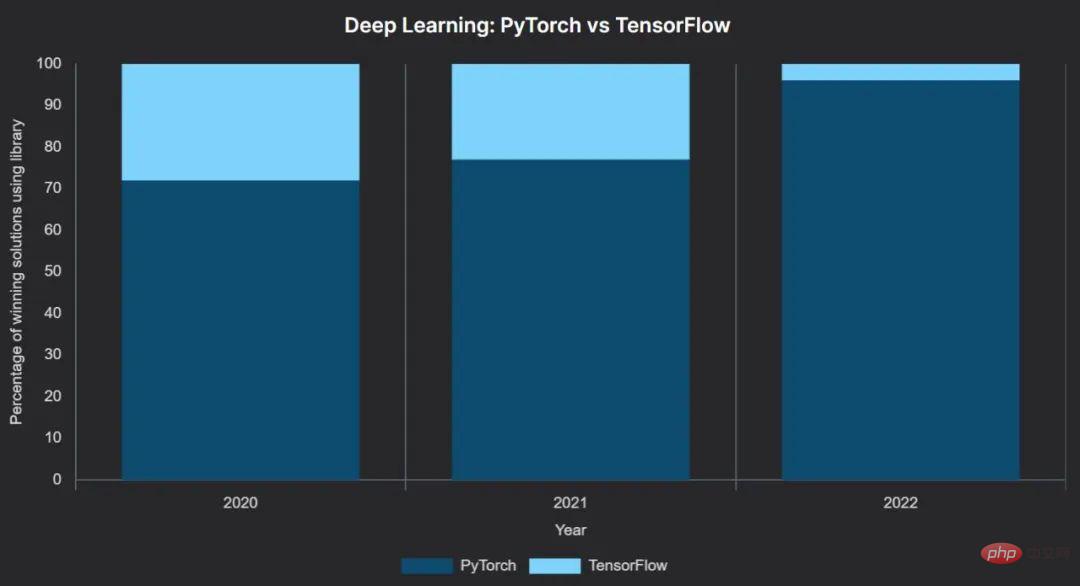

Unter ihnen war das Wachstum des Deep-Learning-Frameworks PyTorch stetig und sein Sprung von 2021 auf 2022 ist sehr offensichtlich: PyTorch stieg von 77 % auf 96 % der Gewinnerlösungen.

Von den 46 Gewinnerlösungen mit Deep Learning verwendeten 44 PyTorch als primäres Framework und nur zwei verwendeten TensorFlow. Noch aussagekräftiger ist, dass einer der beiden Wettbewerbe, die mit TensorFlow gewonnen wurden, der Great Barrier Reef-Wettbewerb von Kaggle, dem Gewinnerteam, das TensorFlow nutzt, ein zusätzliches Preisgeld von 50.000 US-Dollar bietet. Ein weiterer mit TensorFlow gewonnener Wettbewerb nutzte die High-Level-Keras-API.

Während 3 Gewinner Pytorch-Lightning und 1 Fastai nutzten – beide bauten auf PyTorch auf – nutzte die überwiegende Mehrheit PyTorch direkt.

Nun kann man sagen, dass PyTorch zumindest im Datenwettlauf den Kampf der Machine-Learning-Frameworks gewonnen hat. Dies steht im Einklang mit breiteren Forschungstrends zum maschinellen Lernen.

Es ist erwähnenswert, dass wir keine Instanzen des Gewinnerteams gefunden haben, die andere neuronale Netzwerkbibliotheken wie JAX (von Google entwickelt und von DeepMind verwendet), PaddlePaddle (von Baidu entwickelt) oder MindSpore (von Huawei entwickelt) verwendet haben ).

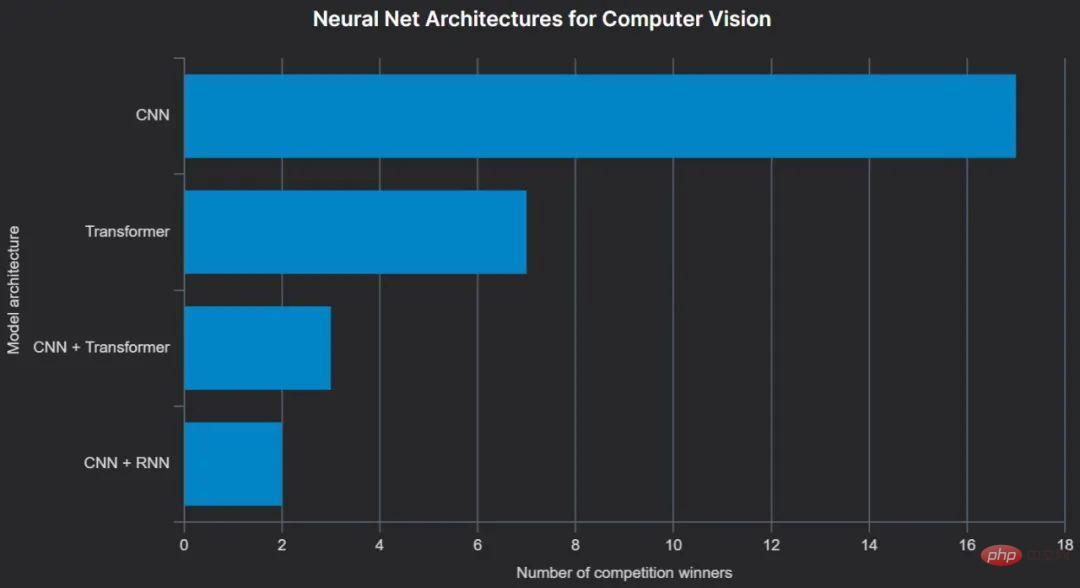

Werkzeuge neigen dazu, die Welt zu dominieren, Technologie jedoch nicht. Auf der CVPR 2022 wurde die ConvNext-Architektur als „ConvNet der 2020er Jahre“ vorgestellt und zeigte, dass sie aktuelle Transformer-basierte Modelle übertrifft. Es wurde in mindestens zwei preisgekrönten Computer-Vision-Lösungen verwendet, und CNN bleibt insgesamt bis heute die beliebteste neuronale Netzwerkarchitektur unter den Gewinnern von Computer-Vision-Wettbewerben.

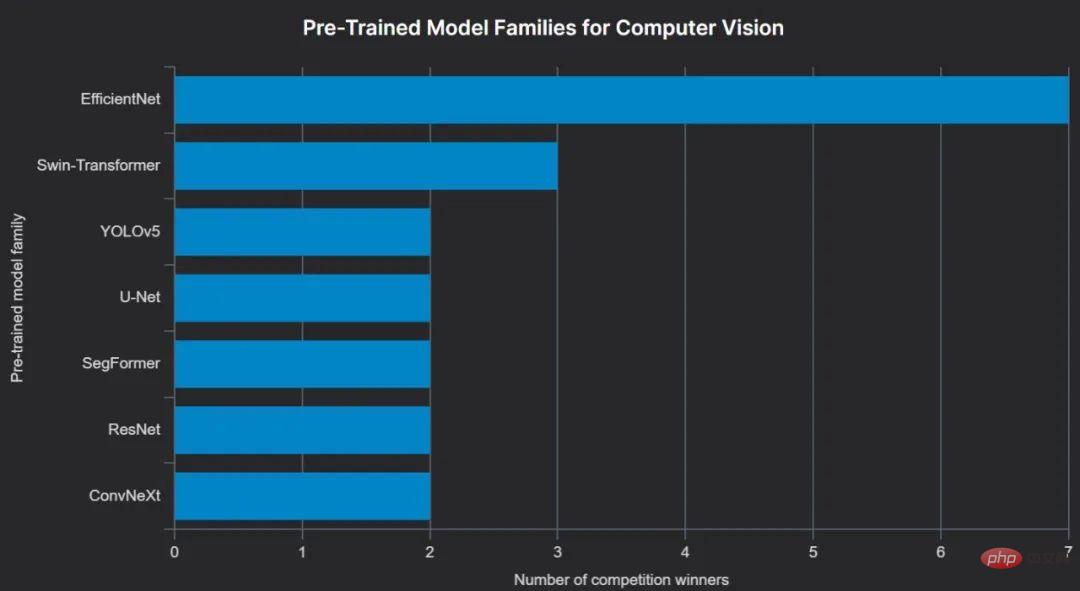

Computer Vision ist der Sprachmodellierung bei der Verwendung vorab trainierter Modelle sehr ähnlich: leicht verständliche Architekturen, die auf öffentlichen Datensätzen wie ImageNet trainiert werden. Das beliebteste Repository ist Hugging Face Hub, auf das über timm zugegriffen werden kann und das das Laden vorab trainierter Versionen von Dutzenden verschiedener Computer-Vision-Modelle äußerst bequem macht.

Die Vorteile der Verwendung vorab trainierter Modelle liegen auf der Hand: Bilder aus der realen Welt und von Menschen erstellter Text weisen einige gemeinsame Merkmale auf, und die Verwendung vorab trainierter Modelle kann zu gesundem Menschenverstand führen, ähnlich wie bei der Verwendung größerer und allgemeinerer Modelle. Trainingsdatensatz.

Oftmals werden vorab trainierte Modelle auf der Grundlage aufgabenspezifischer Daten (z. B. von Wettbewerbsorganisatoren bereitgestellte Daten) verfeinert – weiter trainiert –, aber nicht immer. Der Gewinner der Image Matching Challenge verwendete ein vorab trainiertes Modell ohne jegliche Feinabstimmung: „Aufgrund der (unterschiedlichen) Qualität der Trainings- und Testdaten in diesem Wettbewerb haben wir das bereitgestellte Training nicht zur Feinabstimmung verwendet.“ weil wir dachten, es wäre nicht sehr effektiv.“ Die Entscheidung hat sich ausgezahlt.

Der bisher beliebteste vorab trainierte Computer-Vision-Modelltyp unter den Gewinnern 2022 ist EfficientNet, das, wie der Name schon sagt, den Vorteil hat, dass es weniger ressourcenintensiv ist als viele andere Modelle.

Seit ihrer Einführung im Jahr 2017 dominieren Transformer-basierte Modelle den Bereich der Verarbeitung natürlicher Sprache (NLP). Transformer ist das „T“ in BERT und GPT und auch der Kern von ChatGPT.

Es ist also keine Überraschung, dass alle Gewinnerlösungen in Wettbewerben zur Verarbeitung natürlicher Sprache im Kern auf Transformer-basierten Modellen basieren. Es ist keine Überraschung, dass sie alle in PyTorch implementiert sind. Sie alle verwendeten vorab trainierte Modelle, die mithilfe der Transformers-Bibliothek von Hugging Face geladen wurden, und fast alle verwendeten die Version des DeBERTa-Modells von Microsoft Research – normalerweise deberta-v3-large.

Viele davon erfordern große Mengen an Rechenressourcen. Beispielsweise ließ der Google AI4Code-Gewinner einen A100 (80 GB) etwa 10 Tage lang laufen, um einen einzelnen Deberta-v3-large für seine endgültige Lösung zu trainieren. Dieser Ansatz ist die Ausnahme (unter Verwendung eines einzelnen Mastermodells und einer festen Zug-/Bewertungsaufteilung) – alle anderen Lösungen nutzen intensiv Ensemblemodelle und fast alle verwenden irgendeine Form der k-fachen Kreuzvalidierung. Beispielsweise verwendete der Gewinner des Jigsaw Toxic Comments-Wettbewerbs einen gewichteten Durchschnitt der Ergebnisse von 15 Modellen.

Transformer-basierte Ensembles werden manchmal in Verbindung mit LSTM oder LightGBM verwendet, und es gibt auch mindestens zwei Fälle von Pseudo-Labeling, die effektiv für die Gewinnerlösung verwendet wurden.

XGBoost war früher ein Synonym für Kaggle. Allerdings ist LightGBM eindeutig die beliebteste GBDT-Bibliothek für die Gewinner des Jahres 2022 – die Gewinner erwähnten LightGBM so oft in ihren Lösungsberichten oder Fragebögen wie CatBoost und XGBoost zusammen, CatBoost belegte den zweiten Platz und XGBoost überraschenderweise den dritten Platz.

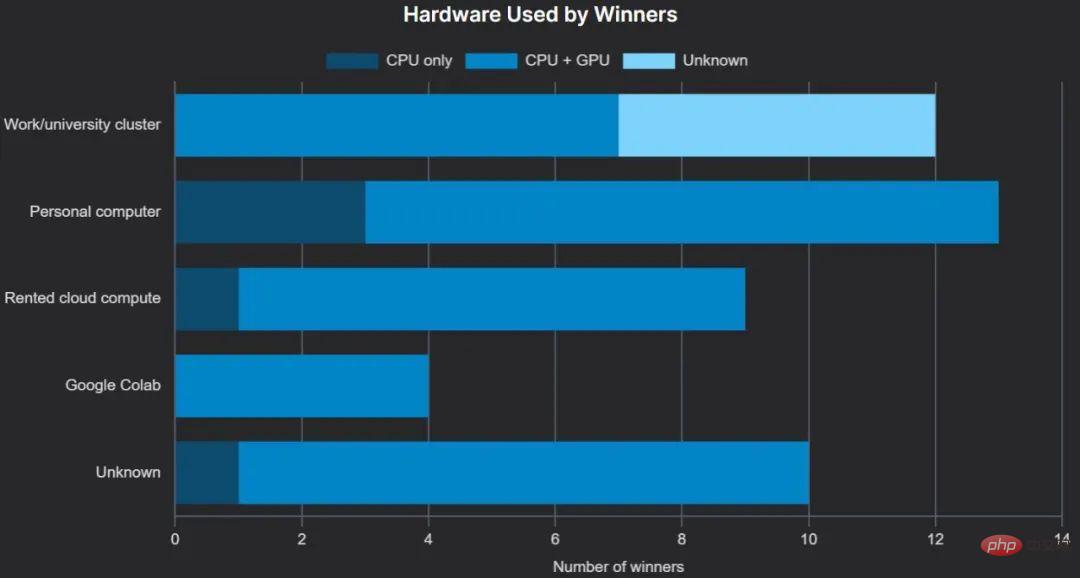

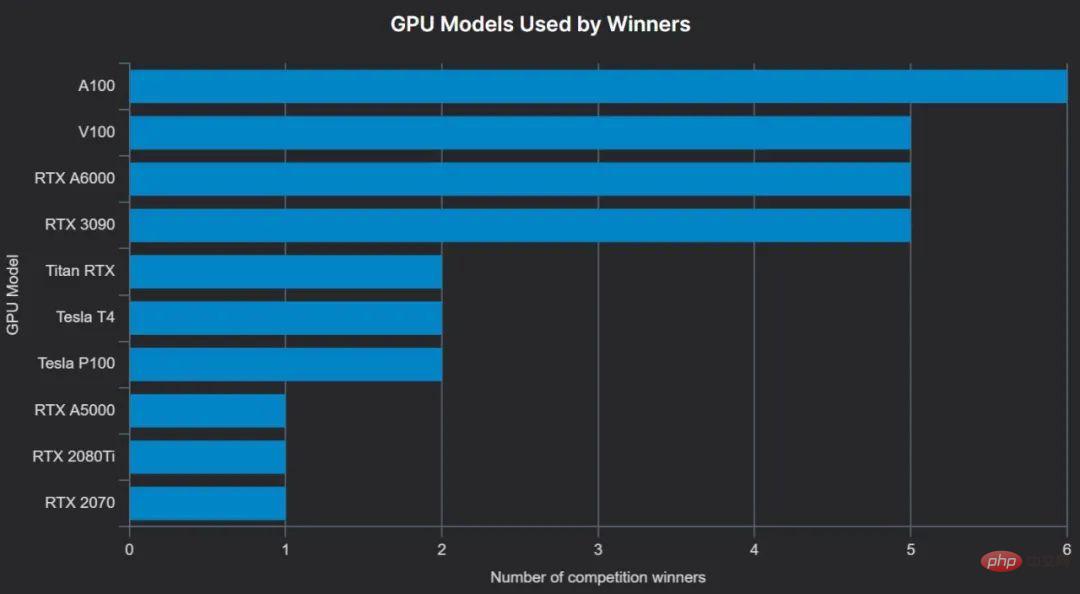

Wie grob erwartet verwendeten die meisten Gewinner GPUs für das Training – dies kann die Trainingsleistung von Gradient-Boosted-Bäumen erheblich verbessern und ist tatsächlich für tiefe neuronale Netze von erforderlich. Eine beträchtliche Anzahl von Preisträgern hat Zugriff auf Cluster, die von ihrem Arbeitgeber oder ihrer Universität bereitgestellt werden, häufig einschließlich GPUs.

Etwas überraschenderweise haben wir keine Fälle gefunden, in denen die Tensor Processing Unit (TPU) von Google zum Trainieren eines erfolgreichen Modells verwendet wurde. Wir haben auch keine Gewinnermodelle gesehen, die auf den Chips der M-Serie von Apple trainiert wurden, die seit Mai 2022 von PyTorch unterstützt werden.

Die Cloud-Notebook-Lösung von Google, Colab, ist beliebt, mit einem Gewinner im kostenlosen Plan, einem im Pro-Plan und einem weiteren im Pro+ (wir können nicht bestätigen, auf welchem Plan der vierte Gewinner Colab verwendet).

Lokale persönliche Hardware war beliebter als Cloud-Hardware, und obwohl neun Gewinner die GPU nannten, die sie für das Training verwendeten, gaben sie nicht an, ob sie eine lokale GPU oder eine Cloud-GPU verwendeten.

Die beliebteste GPU ist die neueste High-End-KI-Beschleunigerkarte NVIDIA A100 (A100 40 GB und A100 80 GB werden hier zusammengefasst, da der Gewinner nicht immer zwischen den beiden unterscheiden kann) und wird häufig verwendet Mehrere A100s – Beispielsweise nutzte der Gewinner von Zindis Turtle Recall-Wettbewerb 8 A100 (40 GB) GPUs und die anderen beiden Gewinner nutzten 4 A100.

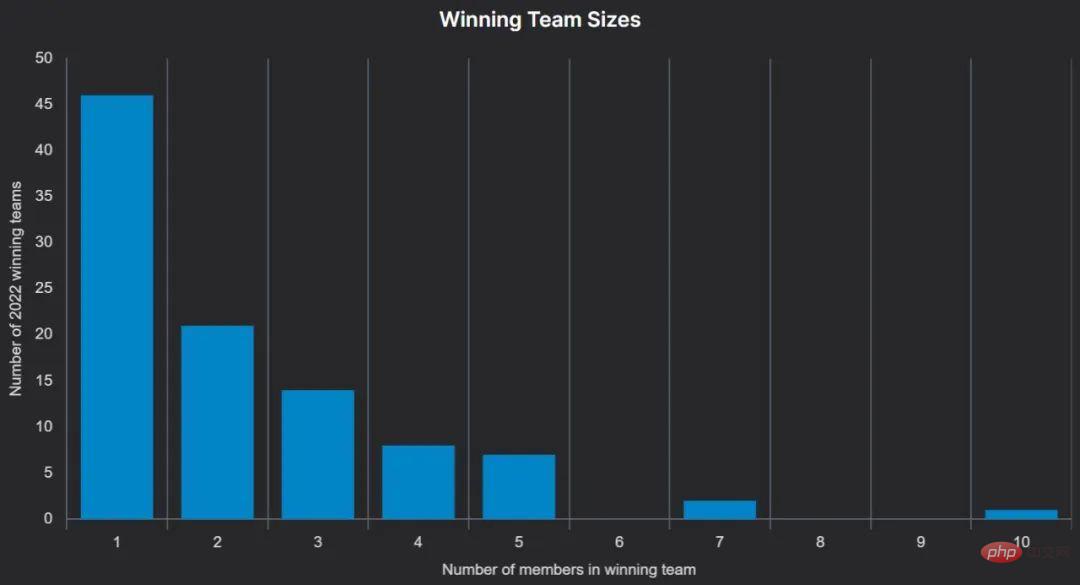

Viele Wettbewerbe erlauben bis zu 5 Teilnehmer pro Team, und Teams können aus Einzelpersonen oder kleineren Teams gebildet werden, die bis zu einer bestimmten Frist vor dem Abgabetermin der Ergebnisse „zusammengeführt“ werden.

Einige Wettbewerbe erlauben größere Teams, zum Beispiel sind bei der Open Data Challenge von Waymo bis zu 10 Personen pro Team zugelassen.

Dies ist ein grober Blick auf den maschinellen Lernwettbewerb 2022. Ich hoffe, Sie finden darin einige nützliche Informationen.

Im Jahr 2023 stehen viele spannende neue Wettbewerbe an und wir freuen uns darauf, nach ihrem Ende weitere Erkenntnisse zu veröffentlichen.

Das obige ist der detaillierte Inhalt vonDas Geheimnis des Sieges im Datenwettbewerb lüften: Analyse der Vorteile von A100 in 200 Spielen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So binden Sie Daten in einer Dropdown-Liste

So binden Sie Daten in einer Dropdown-Liste So sortieren Sie in Excel

So sortieren Sie in Excel Quantitativer Handel mit digitalen Währungen

Quantitativer Handel mit digitalen Währungen App Store kann nicht geöffnet werden

App Store kann nicht geöffnet werden Häufige Verwendungen von set

Häufige Verwendungen von set Verwendung der ppf-Funktion in Python

Verwendung der ppf-Funktion in Python Kein Service für mobile Daten

Kein Service für mobile Daten Tutorial zum Deaktivieren des Windows 11-Sicherheitscenters

Tutorial zum Deaktivieren des Windows 11-Sicherheitscenters