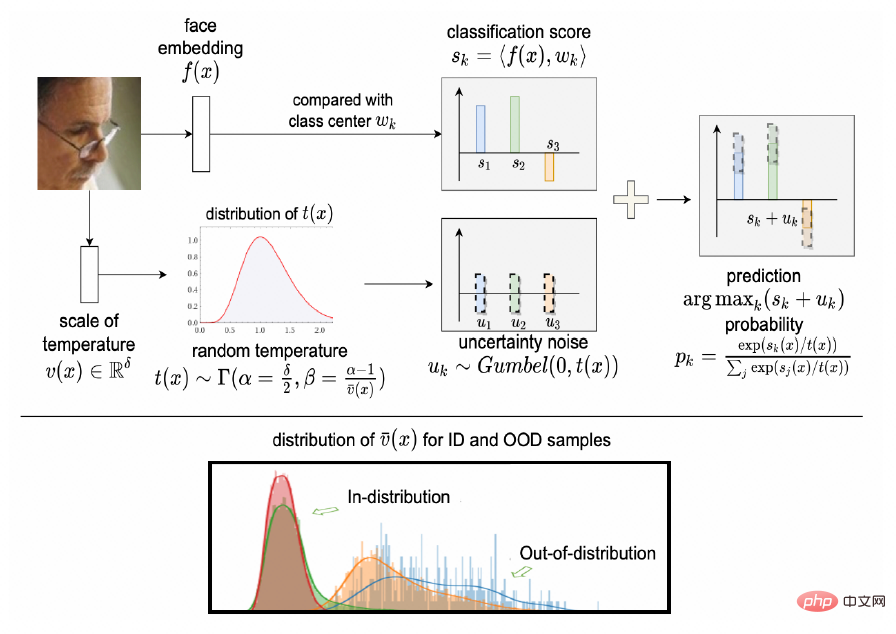

In diesem Artikel wird das Papier „Improving Training and Inference of Face Recognition Models via Random Temperature Scaling“ vorgestellt, das von AAAI 2023, der führenden internationalen Konferenz zum Thema maschinelles Lernen, angenommen wurde. Dieser Artikel analysiert auf innovative Weise die intrinsische Beziehung zwischen dem Temperaturanpassungsparameter und der Klassifizierungsunsicherheit in der Klassifizierungsverlustfunktion aus einer probabilistischen Perspektive und zeigt, dass der Temperaturanpassungsfaktor der Klassifizierungsverlustfunktion der Skalenkoeffizient der Unsicherheitsvariablen ist, die der Gumbel-Verteilung folgt. Daher wird ein neues Trainingsframework namens RTS vorgeschlagen, um die Zuverlässigkeit der Merkmalsextraktion zu modellieren. Basierend auf dem RTS-Trainingsrahmen wird ein zuverlässigeres Erkennungsmodell trainiert, das den Trainingsprozess stabiler macht und einen Messwert für die Probenunsicherheit während des Einsatzes liefert, um hochunsichere Proben zurückzuweisen und zum Aufbau eines robusteren visuellen Identifikationssystems beizutragen. Umfangreiche Experimente zeigen, dass RTS stabil trainieren und Unsicherheitsmaße ausgeben kann, um ein robustes visuelles Erkennungssystem aufzubauen.

Unsicherheitsproblem: Visuelle Erkennungssysteme stoßen in realen Szenen normalerweise auf eine Vielzahl von Störungen. Zum Beispiel: Verdeckung (Dekoration oder komplexer Vordergrund), Bildunschärfe (Fokusunschärfe oder Bewegungsunschärfe), extreme Beleuchtung (Über- oder Unterbelichtung usw.). Diese Störungen können als Auswirkung von Rauschen zusammengefasst werden. Darüber hinaus gibt es falsch erkannte Bilder, normalerweise Katzengesichter oder Hundegesichter. Diese falsch erkannten Daten werden als Out-of-Distribution-Daten (OOD) bezeichnet. Bei der visuellen Erkennung stellen die oben genannten Rausch- und OOD-Daten eine Unsicherheitsquelle dar. Die betroffenen Proben überlagern die auf dem Tiefenmodell extrahierten Merkmale mit Unsicherheiten, was zu Störungen des visuellen Erkennungssystems führt. Wenn beispielsweise das Bild der Basisbibliothek durch Proben mit unsicherer Interferenz verunreinigt wird, entsteht ein „Merkmalsschwarzes Loch“, das versteckte Gefahren für das visuelle Erkennungssystem mit sich bringt. Es besteht daher die Notwendigkeit, die Darstellungszuverlässigkeit zu modellieren.

Traditionelle Multimodelllösung

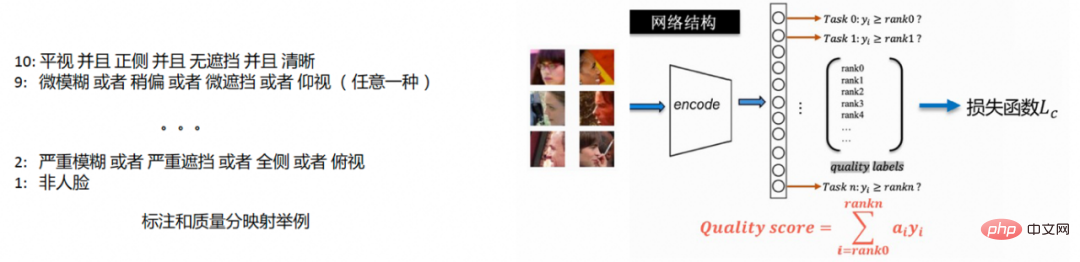

Die traditionelle Methode zur Steuerung der Zuverlässigkeit in der visuellen Erkennungsverbindung erfolgt über ein unabhängiges Qualitätsmodell. Die typische Methode zur Bildqualitätsmodellierung ist wie folgt:

1 Sammeln Sie Anmerkungsdaten und kommentieren Sie bestimmte Faktoren, die sich auf die Qualität auswirken, wie z. B. Klarheit, Vorhandensein oder Nichtvorhandensein von Okklusion und Körperhaltung.

2. Ordnen Sie den Qualitätsfaktor von 1 bis 10 entsprechend der Bezeichnung der Einflussfaktoren zu. Konkrete Beispiele finden Sie im Beispiel auf der linken Seite der Abbildung .

3. Nachdem Sie die Qualitätsbewertungsanmerkung aus den ersten beiden Schritten erhalten haben, führen Sie ein geordnetes Regressionstraining durch, um die Qualitätsbewertung während der Bereitstellungsphase vorherzusagen, wie im Beispiel auf der rechten Seite der Abbildung unten gezeigt.

Die unabhängige Qualitätsmodelllösung erfordert die Einführung eines neuen Modells im visuellen Erkennungslink, und das Training basiert auf Anmerkungsinformationen.

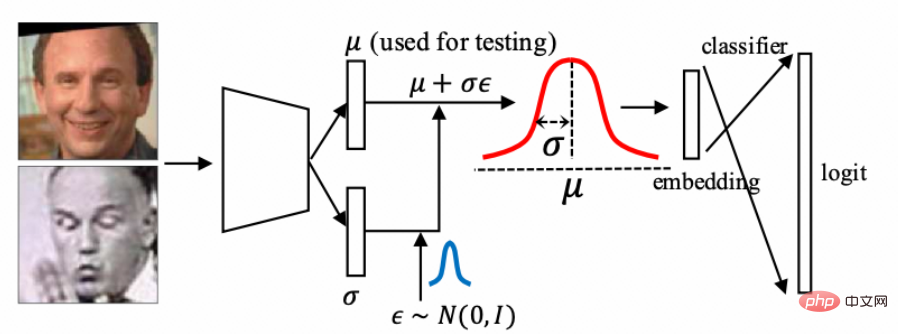

DUL

Zu den Unsicherheitsmodellierungsmethoden gehört „Data Uncertainty Learning in Face Recognition“, das Merkmale als Summe aus Mittelwert und Varianz einer Gaußschen Verteilung modelliert und Merkmale, die Unsicherheit enthalten, nach dem Senden in diese umwandelt zum Klassifikator zum Training. Somit kann der Unsicherheitswert in Bezug auf die Bildqualität während der Bereitstellungsphase ermittelt werden.

DUL verwendet eine Summationsmethode zur Beschreibung der Unsicherheit, und der Maßstab der Rauschschätzung hängt auch eng mit der charakteristischen Verteilung eines bestimmten Datentyps zusammen. Wenn die Datenverteilung relativ eng ist, ist auch das von DUL geschätzte Ausmaß des Rauschens relativ klein. Arbeiten auf dem Gebiet der OOD weisen darauf hin, dass die Dichte der Datenverteilung kein guter Maßstab für die Identifizierung von OOD ist.

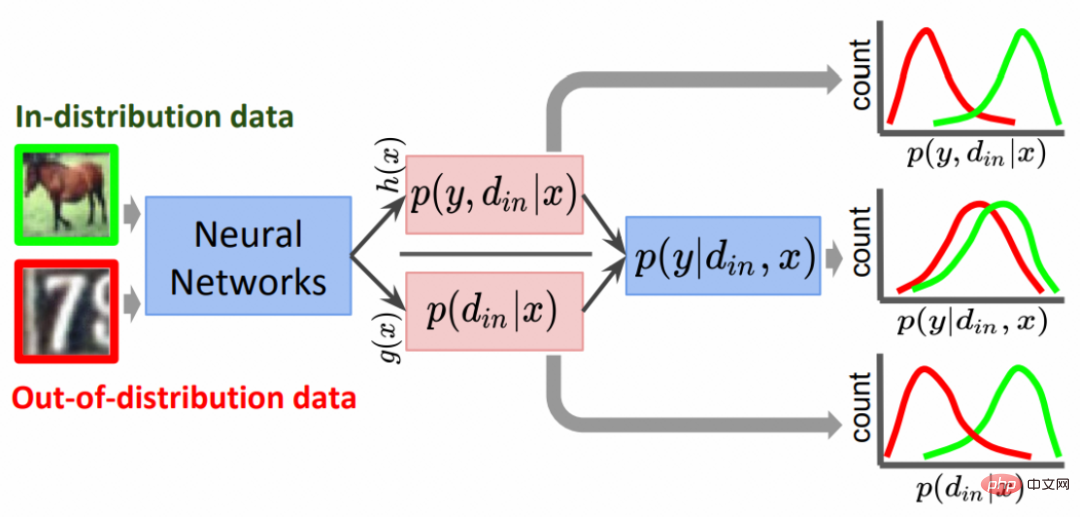

GODIN

Die Arbeit im Bereich OOD „Generalized odin: Detecting out-of-distribution image without learning from out-of-distribution data“ verwendet die Form der gemeinsamen Wahrscheinlichkeitsverteilung, um OOD-Daten zu verarbeiten, wobei zwei unabhängige Zweige h(x) verwendet werden. bzw. g (x) Schätzen Sie die Klassifizierungswahrscheinlichkeitswerte und die Temperaturanpassungswerte.

Da der Temperaturwert als Wahrscheinlichkeitswert modelliert wird, ist der Bereich zwischen 0-1 begrenzt, was keine bessere Modellierung der Temperatur ermöglicht.

Als Reaktion auf die oben genannten Probleme und die damit verbundene Arbeit analysiert dieser Artikel die Beziehung zwischen dem Temperaturanpassungsfaktor und der Unsicherheit in der Klassifizierungsverlustfunktion aus einer probabilistischen Perspektive und schlägt einen RTS-Trainingsrahmen vor.

Analyse von Temperaturanpassungsfaktoren basierend auf einer Wahrscheinlichkeitsperspektive

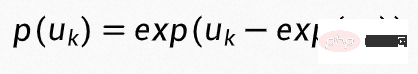

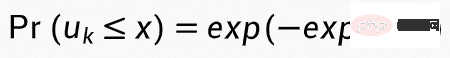

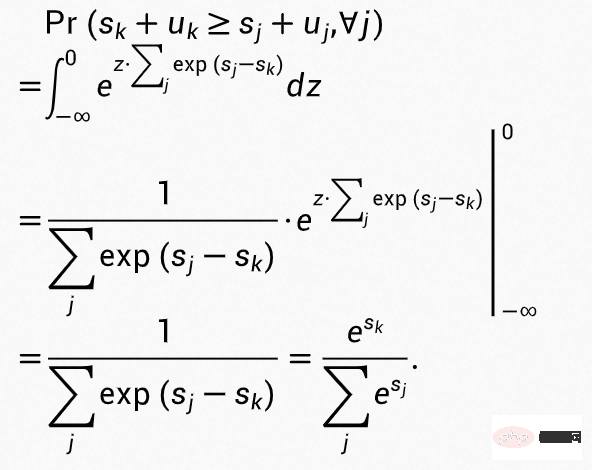

Analysieren Sie zunächst die Beziehung zwischen Temperaturanpassungsfaktoren und Unsicherheit. Angenommen, die Unsicherheit  ist eine Zufallsvariable, die der Standard-Gumbel-Verteilung entspricht, dann kann die Wahrscheinlichkeitsdichtefunktion als

ist eine Zufallsvariable, die der Standard-Gumbel-Verteilung entspricht, dann kann die Wahrscheinlichkeitsdichtefunktion als

geschrieben werden, die kumulative Verteilungsfunktion von ist

geschrieben werden, die kumulative Verteilungsfunktion von ist  und die Wahrscheinlichkeit Der Wert von wird in k Klassen eingeteilt:

und die Wahrscheinlichkeit Der Wert von wird in k Klassen eingeteilt:

Einsetzen von  in die obige Formel ergibt:

in die obige Formel ergibt:

Es ist ersichtlich, dass der Wahrscheinlichkeitswert eingeteilt in Die k-Klasse ist die Punktzahl, die der Softmax-Funktion entspricht. Gleichzeitig können wir a t verwenden, um die Unsicherheitsskala anzupassen, das heißt, es entspricht der Standard-Gumbel-Verteilung:

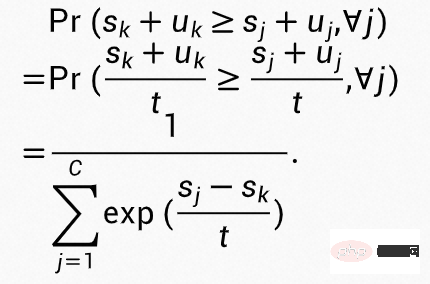

Das ist möglich Es ist ersichtlich, dass der Wahrscheinlichkeitswert der K-Klasse zu diesem Zeitpunkt mit dem Temperaturanpassungswert übereinstimmt, der der Softmax-Funktionsbewertung von t entspricht.

Modelliertemperatur

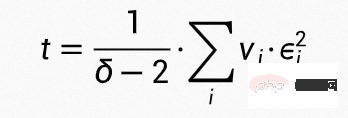

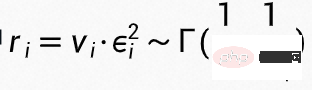

Um den Einfluss der Unsicherheitsschätzung auf die Klassifizierung zu verringern, muss die Temperatur t nahe 1 liegen, daher modellieren wir die Temperatur t als die Summe von  unabhängigen Gammaverteilungsvariablen:

unabhängigen Gammaverteilungsvariablen:  wobei

wobei  , so dass t Befolgen Sie

, so dass t Befolgen Sie

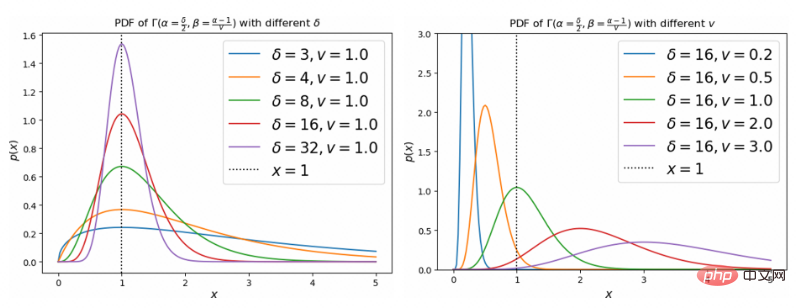

, Beta = frac {alpha - 1}{v})$-Verteilung. Der Einfluss von v und  auf die Verteilung ist wie folgt.

auf die Verteilung ist wie folgt.

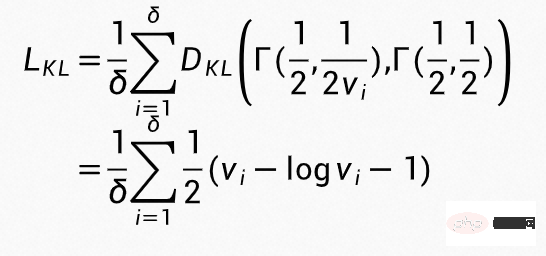

Die Einschränkungen bei der Temperaturmodellierung werden unter Verwendung der folgenden regulären Begriffe während des Trainings implementiert

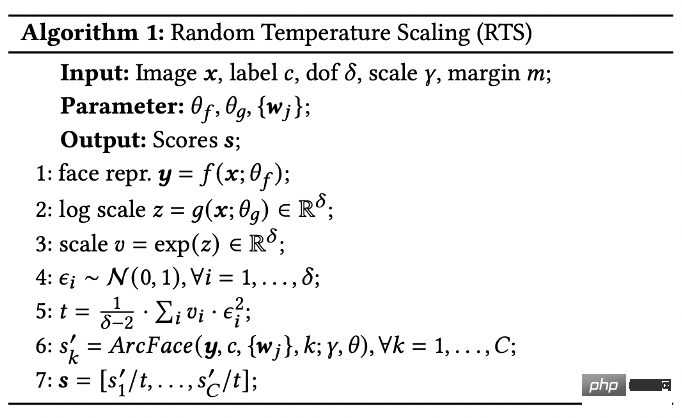

Der Gesamtalgorithmus ist wie folgt organisiert:

Eine detailliertere Analyse und theoretische Beweise finden Sie im Artikel.

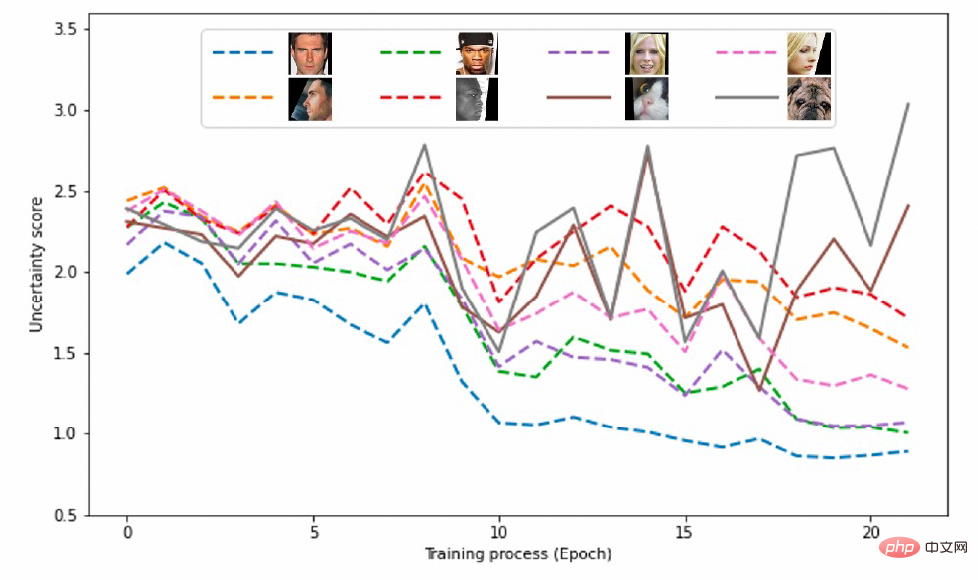

In der Trainingsphase enthalten die Trainingsdaten nur Gesichtstrainingsdaten. Die OOD-Daten von fälschlicherweise erkannten Katzen- und Hundegesichtern werden verwendet, um den Erkennungseffekt von OOD-Daten während des Tests zu überprüfen, und der Test veranschaulicht den dynamischen Prozess der OOD-Probenunsicherheit in verschiedenen Phasen des Trainingsprozesses.

Trainingsphase

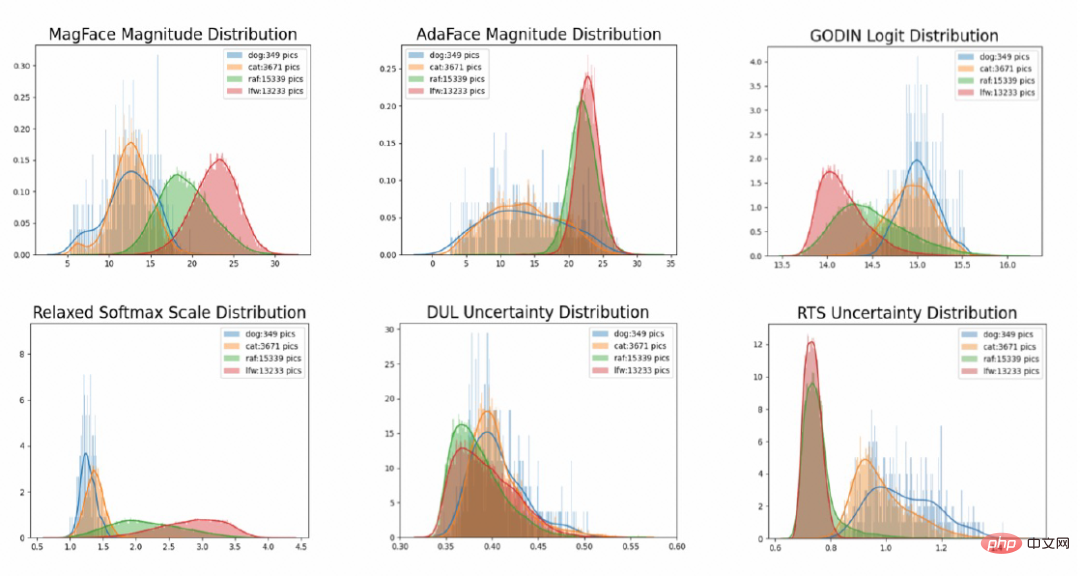

Wir zeichnen die Unsicherheit von In-Distribution-Daten (Gesicht) und Out-of-Distribution-Daten (Katzengesichter und Hundegesichter, die fälschlicherweise als Gesichter erkannt wurden) bei unterschiedlichen Gradwerten für Epochenzahlen. Aus der folgenden Abbildung können Sie ersehen, dass die Unsicherheitswerte aller Stichproben im Anfangsstadium in der Nähe größerer Werte verteilt sind. Mit fortschreitendem Training nimmt die Unsicherheit der OOD-Proben allmählich zu und die Unsicherheit der Gesichtsdaten nimmt allmählich zu nimmt ab und je besser die Gesichtsqualität, desto geringer ist die Unsicherheit. ID-Daten und OOD-Daten können durch Festlegen eines Schwellenwerts unterschieden werden, und die Bildqualität wird durch den Unsicherheitswert widergespiegelt.

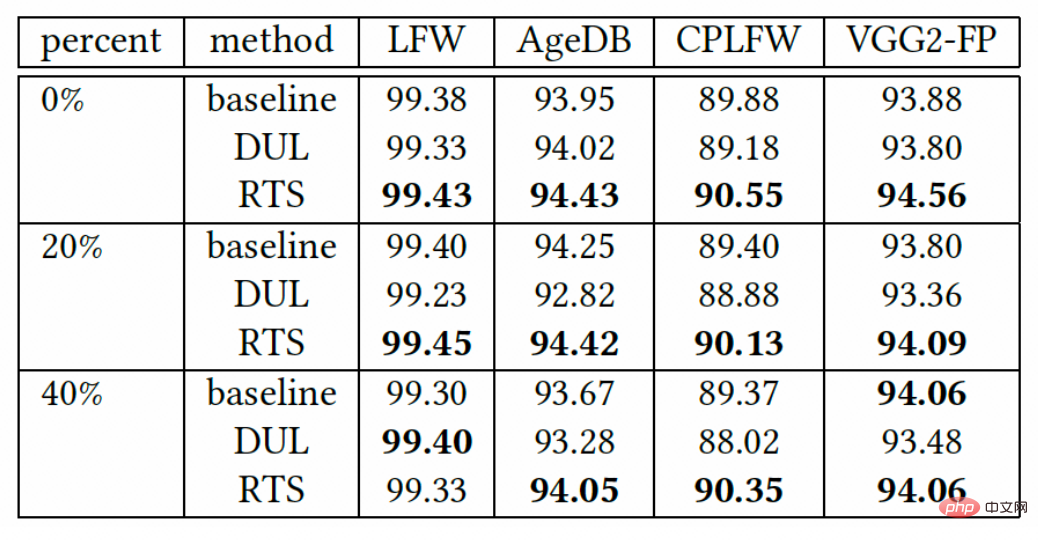

Zur Veranschaulichung der Robustheit gegenüber verrauschten Trainingsdaten während der Trainingsphase. In diesem Artikel werden unterschiedliche Anteile von Rauschen auf den Trainingssatz angewendet. Die auf unterschiedlichen Anteilen von Rauschdaten basierenden Modellerkennungseffekte sind wie folgt. Es ist ersichtlich, dass RTS auch beim Training basierend auf Rauschdaten bessere Erkennungsergebnisse erzielen kann.

Bereitstellungsphase

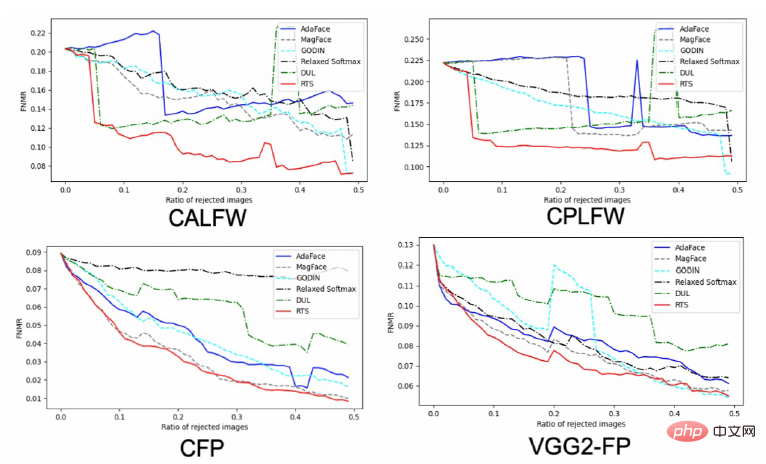

Die folgende Abbildung zeigt, dass der vom RTS-Framework während der Bereitstellungsphase erhaltene Unsicherheitswert eine hohe Korrelation mit der Gesichtsqualität aufweist Gleichzeitig wird die Fehleranpassungskurve nach dem Entfernen minderwertiger Proben auf dem Benchmark aufgezeichnet. Basierend auf den erhaltenen Unsicherheitswerten werden Stichproben mit höherer Unsicherheit im Benchmark in der Reihenfolge der Unsicherheit von hoch nach niedrig entfernt, und dann werden die Fehleranpassungskurven der verbleibenden Stichproben gezeichnet. Wie aus der folgenden Abbildung ersichtlich ist, gibt es weniger falsche Übereinstimmungen, je mehr Proben mit höherer Unsicherheit gefiltert werden, und wenn die gleiche Anzahl von Unsicherheitsproben entfernt wird, weist RTS weniger falsche Übereinstimmungen auf.

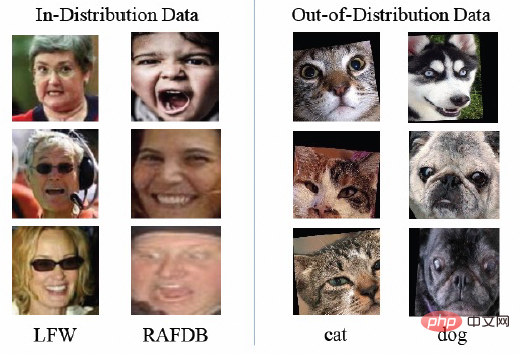

Um den Identifikationseffekt von Unsicherheitswerten auf OOD-Proben zu überprüfen, wurden ein Datensatz innerhalb der Verteilung (Gesicht) und ein Datensatz außerhalb der Verteilung (Katzen, die fälschlicherweise als Gesichter erkannt wurden) erstellt beim Testen von Gesicht und Hundegesicht). Das Datenbeispiel ist wie folgt.

Wir erklären die Wirkung von RTS aus zwei Aspekten. Zeichnen Sie zunächst das Verteilungsdiagramm der Unsicherheit. Wie Sie der folgenden Abbildung entnehmen können, verfügt die RTS-Methode über eine starke Unterscheidungsfähigkeit für OOD-Daten.

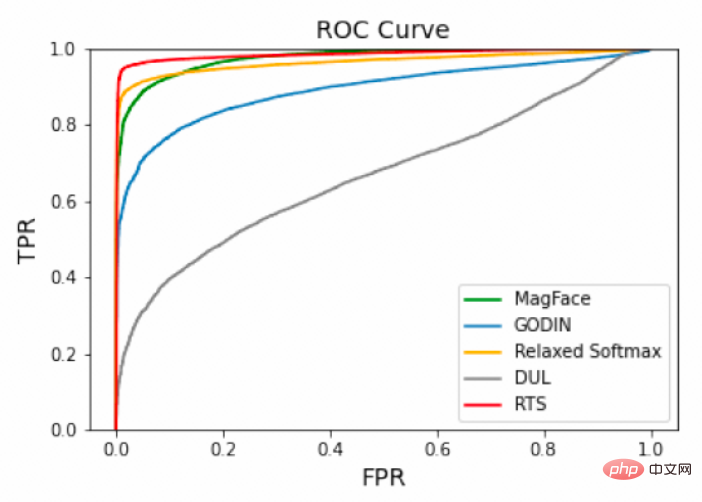

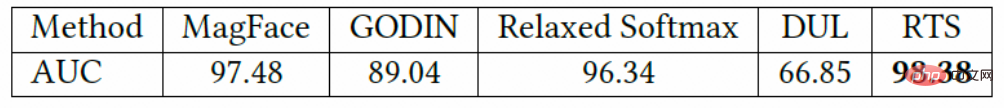

Gleichzeitig wurde die ROC-Kurve des OOD-Testsatzes aufgezeichnet und der AUC-Wert der ROC-Autorität berechnet. Es ist ersichtlich, dass der Unsicherheitswert von RTS OOD besser identifizieren kann Daten.

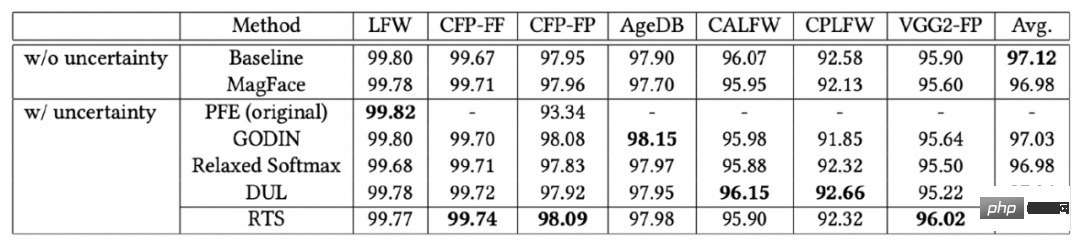

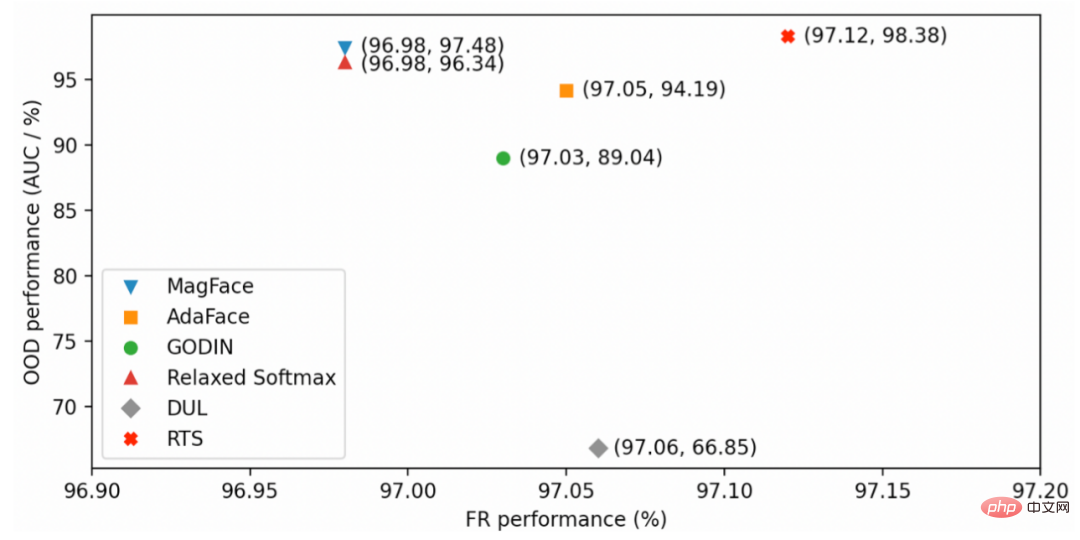

Universelle Erkennungsfähigkeit

Testen Sie die universelle Erkennungsfähigkeit auf dem Benchmark. RTS fügt die Erkennungsfähigkeit von OOD-Daten hinzu, ohne die Gesichtserkennungsfähigkeit zu beeinträchtigen. Mit dem RTS-Algorithmus kann ein ausgewogenes Ergebnis bei der Identifizierung und der OOD-Datenidentifizierung erzielt werden.

Das Modell in diesem Artikel wurde als Open Source in Modelscope bereitgestellt. Darüber hinaus möchte ich Ihnen das kostenlose Open-Source-Modell auf der CV-Domain vorstellen (Sie können es auf den meisten Mobiltelefonen erleben):

1. cn/models/damo/cv_resnet50_face-detection_retinaface/ summary

2.https://modelscope.cn/models/damo/cv_resnet101_face-detection_cvpr22papermogface/summary

3.https://modelscope.cn/models/ damo/cv_manual_face-detection_tinymog/summary

4.https://modelscope.cn/models/damo/cv_manual_face-detection_ulfd/summary

5.https://modelscope.cn/models/damo/cv_manual_face- Erkennung_mtcnn/summary

6.https://modelscope.cn/models/damo/cv_resnet_face-recognition_facemask/summary

7.https://modelscope.cn/models/damo/cv_ir50_face-recognition_arcface/summary

8. https://modelscope .cn/models/damo/cv_manual_face-liveness_flir/summary

9.https://modelscope.cn/models/damo/cv_manual_face-liveness_flrgb/summary

10 .https://modelscope.cn/models /damo/cv_manual_facial-landmark-confidence_flcm/summary

11.https://modelscope.cn/models/damo/cv_vgg19_facial-expression-recognition_fer/summary

12 .https://modelscope.cn/models /damo/cv_resnet34_face-attribute-recognition_fairface/summary

Das obige ist der detaillierte Inhalt vonDa die Bildqualität die visuelle Erkennung beeinträchtigt, schlägt die DAMO Academy ein robusteres Framework vor. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Welches System ist Honor?

Welches System ist Honor?

So ändern Sie die IP-Adresse unter Linux

So ändern Sie die IP-Adresse unter Linux

So installieren Sie Bibliotheken von Drittanbietern in Sublime

So installieren Sie Bibliotheken von Drittanbietern in Sublime

Gründe, warum die Homepage nicht geändert werden kann

Gründe, warum die Homepage nicht geändert werden kann

Wie kaufe und verkaufe ich Bitcoin? Tutorial zum Bitcoin-Handel

Wie kaufe und verkaufe ich Bitcoin? Tutorial zum Bitcoin-Handel

Abfragetool für Registrierungsdomänennamen

Abfragetool für Registrierungsdomänennamen

Verwendung von Telnet-Befehlen

Verwendung von Telnet-Befehlen

So lesen Sie eine Spalte in Excel in Python

So lesen Sie eine Spalte in Excel in Python