ChatGPT hat einen Verstand? ! „Die Theory of Mind (ToM), von der ursprünglich angenommen wurde, dass sie nur für den Menschen gilt, ist im KI-Modell hinter ChatGPT aufgetaucht.“

Dies ist die neueste ForschungsSchlussfolgerung der Stanford University, die schon bald große Auswirkungen hatte wie es veröffentlicht wurde Sensation im akademischen Kreis:Dieser Tag kam endlich unerwartet.

In dieser Studie stellte der Autor fest, dass:

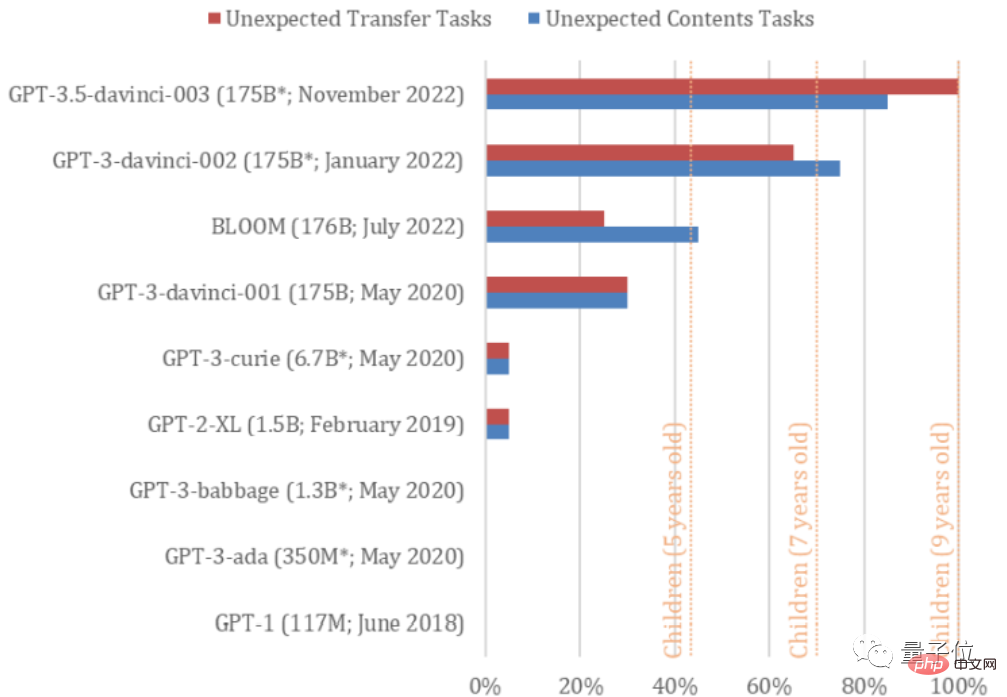

davinci-002-Version von GPT3 (für die ChatGPT optimiert ist) bereits 70 % der Theory-of-Mind-Aufgaben lösen kann, was einer 7-Jahres-Aufgabe entspricht. altes Kind;

GPT3.5 (davinci-003), das homologe Modell von ChatGPT, hat 93 % der Aufgaben gelöst, mit dem geistigen Äquivalent eines 9-jährigen Kindes!

Die Fähigkeit, solche Aufgaben zu lösen, wurde jedoch bei den Modellen der GPT-Serie erst ab 2022 gefunden.

Mit anderen Worten, ihr Geist hat sich tatsächlich „weiterentwickelt“.

GPT muss sehr schnell iterieren, und vielleicht wird es eines Tages ein Erwachsener sein. (Manueller Hundekopf)

Warum hat GPT-3.5 Ihrer Meinung nach einen Verstand?

Der Artikel trägt den Titel „Theory of Mind May Have Spontaneously Emerged in Large Language Models“.

Bei diesen beiden Aufgaben handelt es sich um universelle Tests, um festzustellen, ob Menschen über eine Theorie des Geistes verfügen. Studien haben beispielsweise gezeigt, dass Kinder mit Autismus oft Schwierigkeiten haben, solche Tests zu bestehen.

Der erste Test heißt Smarties Task (auch bekannt als Test auf unerwartete Inhalte). Wie der Name schon sagt, testet er das Urteilsvermögen der KI bei unerwarteten Dingen.

Nehmen Sie als Beispiel „Sie haben eine Schokoladentüte geöffnet und festgestellt, dass sie voller Popcorn war“.

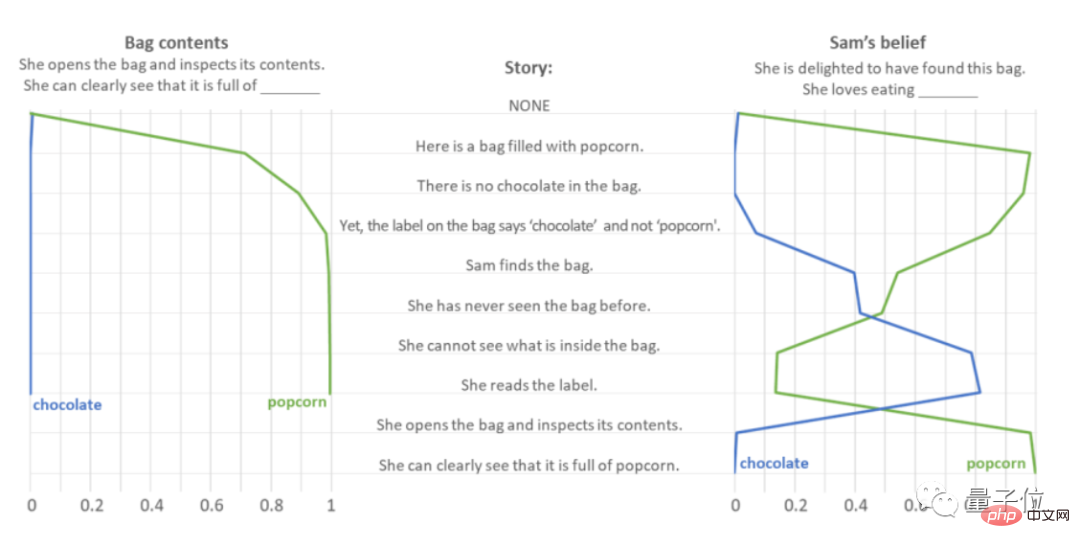

Die Autoren gaben GPT-3.5 eine Reihe prompter Sätze und beobachteten, wie es Antworten auf die Fragen „Was ist in der Tüte?“ und „Sie war glücklich, als sie die Tüte fand. Was isst sie also gerne?“ vorhersagte.

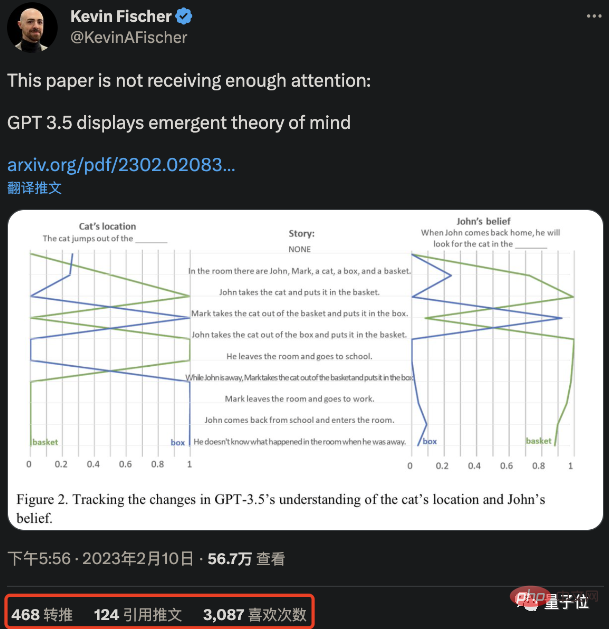

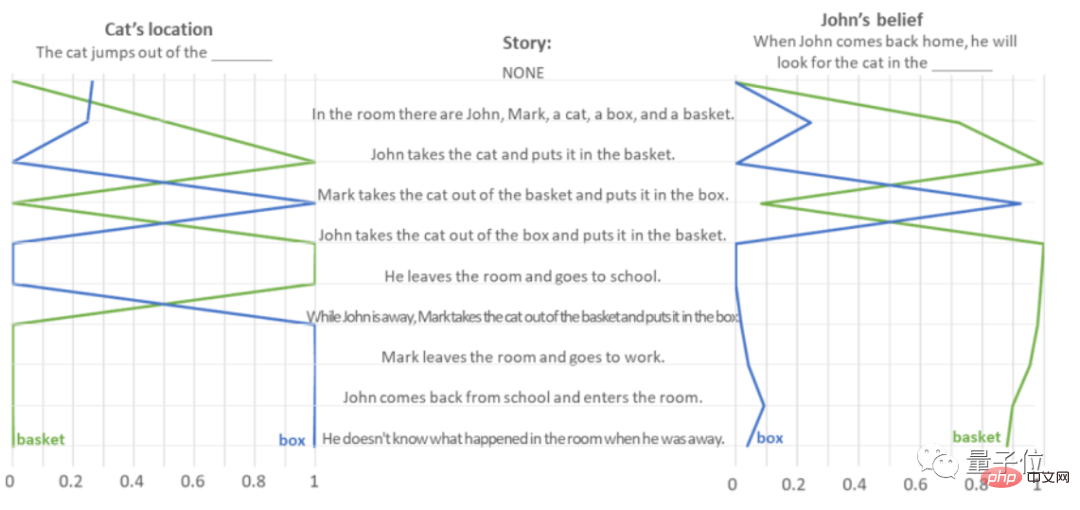

Tests zeigen, dass GPT-3.5 ohne Bedenken denkt: „Die Tüte enthält Popcorn.“ Was die Frage „Was isst sie gerne?“ betrifft, zeigte GPT-3.5 starkes Einfühlungsvermögen, insbesondere als es hörte „Sie konnte nicht sehen, was in der Verpackungstüte war“ und einmal dachte, sie liebe Schokolade , Die richtige Antwort wurde erst gegeben, als in dem Artikel deutlich wurde, dass „sie es mit Popcorn gefüllt vorfand“. Um zu verhindern, dass die richtige Antwort von GPT-3.5 ein Zufall ist – für den Fall, dass sie nur auf der Grundlage der Häufigkeit von Aufgabenwörtern vorhersagt, hat der Autor „Popcorn“ und „Schokolade“ vertauscht und es ebenfalls auf 10.000 gesetzt Beim Interferenztest wurde festgestellt, dass GPT-3.5 nicht nur auf der Grundlage der Worthäufigkeit vorhersagt. Was die gesamte Testfrage und -antwort „Unerwarteter Inhalt“ betrifft, hat GPT-3.5 17 der 20 Fragen erfolgreich beantwortet, mit einer Genauigkeitsrate von 85 %. Der zweite ist der Sally-Anne-Test (auch bekannt als Unexpected Transfer, unerwartete Transferaufgabe), der die Fähigkeit der KI testet, die Gedanken anderer Menschen vorherzusagen. Nehmen Sie als Beispiel „John legte die Katze in den Korb und ging, und Mark nutzte seine Abwesenheit, um die Katze aus dem Korb in die Kiste zu legen“. Der Autor hat GPT-3.5 gebeten, einen Textabschnitt zu lesen, um „den Standort der Katze“ und „Wohin wird John gehen, um die Katze zu finden, wenn er zurückkommt“ zu bestimmen? Inhalt lautet:

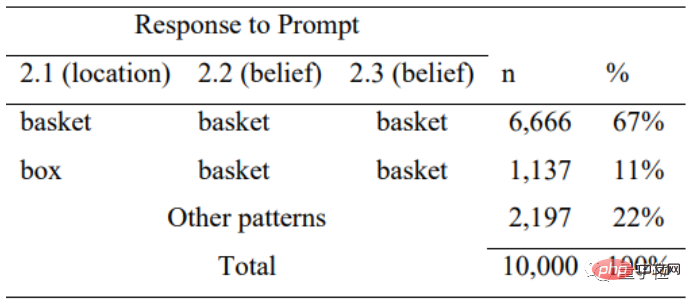

Bei dieser Art von Testaufgabe „zufällige Übertragung“ erreichte die Genauigkeit der GPT-3.5-Antworten 100 %, und es wurden 20 Aufgaben gut gelöst.

Um zu verhindern, dass GPT-3.5 erneut geblendet wird, stellte der Autor eine Reihe von „Lückenfüllfragen“ dafür zusammen und mischte die Reihenfolge der Wörter nach dem Zufallsprinzip, um zu testen, ob es antwortete zufällig basierend auf der Häufigkeit des Wortvorkommens.

Tests zeigen, dass GPT-3.5 bei unlogischen Fehlerbeschreibungen auch seine Logik verliert und nur in 11 % der Fälle richtig antwortet, was zeigt, dass es Antworten auf der Grundlage der Aussagelogik beurteilt.

Aber wenn Sie denken, dass diese Art von Frage sehr einfach ist und Sie sie mit jeder KI richtig beantworten können, liegen Sie völlig falsch.

Der Autor führte einen solchen Test an allen 9 Modellen der GPT-Serie durch und stellte fest, dass nur GPT-3.5 (davinci-003) und GPT-3 (neue Version im Januar 2022, davinci-002) eine gute Leistung erbrachten.

davinci-002 ist der „Oldtimer“ von GPT-3.5 und ChatGPT.

Im Durchschnitt erledigte davinci-002 70 % der Aufgaben, wobei das geistige Äquivalent eines 7-jährigen GPT-3.5-Kindes 85 % der unerwarteten Inhaltsaufgaben und 100 % der unerwarteten Übertragungsaufgaben erledigte (. durchschnittliche Abschlussquote 92,5 %. Der Verstand entspricht dem eines 9-jährigen Kindes.

Mehrere GPT-3-Modelle vor BLOOM waren jedoch sogar einem 5-jährigen Kind unterlegen und zeigten im Grunde keine Theory of Mind.

Der Autor glaubt, dass es in der GPT-Artikelreihe keinen Beweis dafür gibt, dass ihre Autoren dies „absichtlich“ getan haben. Mit anderen Worten, dies ist GPT-3.5 und die neue Version von GPT-3, um das zu vervollständigen Aufgabe. Die Fähigkeit zu lernen.

Nachdem ich diese Testdaten gelesen hatte, war die erste Reaktion von jemandem: Stopp (Forschung)!

Einige scherzten auch: Bedeutet das nicht, dass wir in Zukunft auch mit KI befreundet sein können?

Manche Leute stellen sich sogar die zukünftigen Fähigkeiten der KI vor: Können aktuelle KI-Modelle auch neues Wissen entdecken/neue Werkzeuge schaffen?

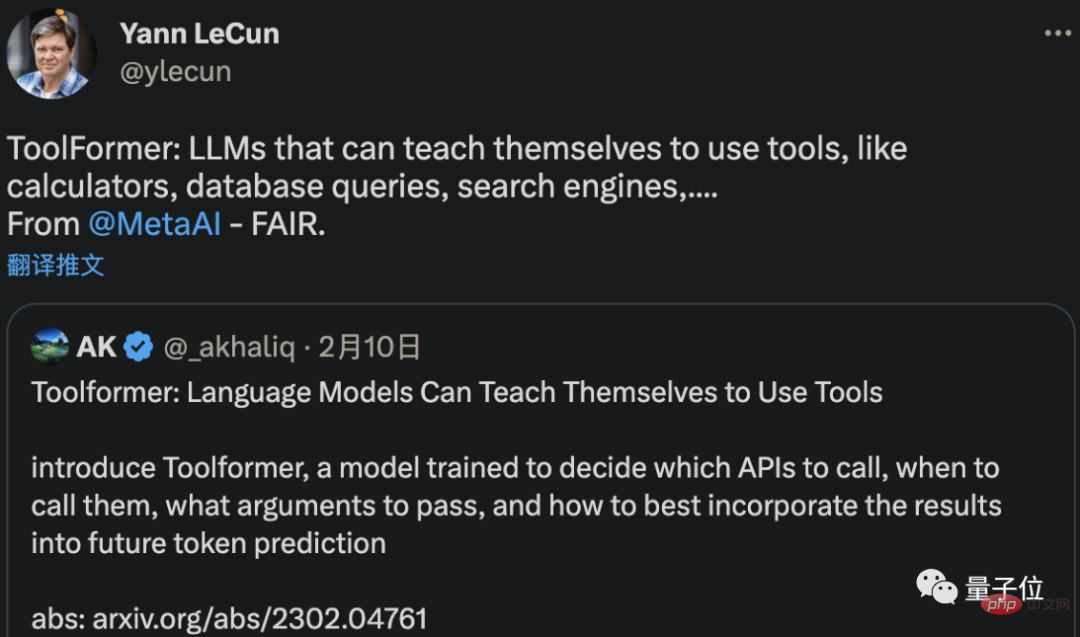

Es ist nicht unbedingt möglich, neue Werkzeuge zu erfinden, aber Meta AI hat tatsächlich eine KI entwickelt, die Werkzeuge selbst verstehen und lernen kann, sie zu verwenden.

Ein aktuelles Papier von LeCun zeigt, dass diese neue KI namens ToolFormer sich selbst beibringen kann, Computer, Datenbanken und Suchmaschinen zu nutzen, um die von ihr generierten Ergebnisse zu verbessern.

Einige Leute haben sogar die Worte des CEO von OpenAI zitiert, dass „AGI möglicherweise früher an unsere Tür klopft, als irgendjemand erwartet.“

Aber Moment, kann die KI diese beiden Tests wirklich bestehen, um zu zeigen, dass sie über eine „Theory of Mind“ verfügt?

Zum Beispiel dachte Liu Qun, ein Forscher am Institut für Computertechnologie der Chinesischen Akademie der Wissenschaften, nachdem er die Forschung gelesen hatte:

KI sollte einfach lernen, einen Verstand zu haben.

Wie beantwortet GPT-3.5 in diesem Fall diese Reihe von Fragen?

In diesem Zusammenhang äußerten einige Internetnutzer ihre eigenen Spekulationen:

Diese LLMs erzeugten kein Bewusstsein. Sie sagen lediglich einen eingebetteten semantischen Raum voraus, der auf den Ergebnissen tatsächlich bewusster Menschen basiert.

Tatsächlich hat der Autor selbst in dem Artikel auch seine eigene Vermutung geäußert.

Heutzutage werden große Sprachmodelle immer komplexer und können immer besser menschliche Sprache erzeugen und interpretieren. Sie entwickeln nach und nach Fähigkeiten wie die Theorie des Geistes.

Aber das bedeutet nicht, dass Modelle wie GPT-3.5 wirklich über eine Theorie des Geistes verfügen.

Im Gegenteil, auch wenn es nicht in das KI-System integriert ist, kann es durch Training als „Nebenprodukt“ erhalten werden.

Anstatt also zu untersuchen, ob GPT-3.5 wirklich einen Verstand hat oder einen Verstand zu haben scheint, müssen die Tests selbst stärker reflektiert werden –

Am besten ist es, die Gültigkeit des noch einmal zu prüfen Test zur Theorie des Geistes und die Schlussfolgerungen, die Psychologen seit Jahrzehnten auf der Grundlage dieser Tests ziehen:

Wenn KI diese Aufgaben ohne Theorie des Geistes erledigen kann, warum können Menschen dann nicht so sein wie sie?

Die Schlussfolgerung basiert tatsächlich auf KI-Tests, was eine umgekehrte Kritik am akademischen Kreis der Psychologie (Doge) darstellt.

Es gibt nur einen Autor dieses Artikels, Michal Kosinski, außerordentlicher Professor für Organisationsverhalten an der Stanford University Graduate School of Business.

Seine Aufgabe ist es, mithilfe modernster Computermethoden, KI und Big Data den Menschen in der aktuellen digitalen Umgebung zu untersuchen (wie Professor Chen Yiran sagte, ist er Professor für Computerpsychologie).

Michal Kosinski hat einen Doktortitel in Psychologie und einen MA in Psychometrie und Sozialpsychologie von der University of Cambridge.

Vor seiner jetzigen Position absolvierte er ein Postdoc-Studium am Institut für Informatik der Stanford University, war stellvertretender Direktor des Center for Psychological Testing an der University of Cambridge und Forscher im Microsoft Research Machine Learning Gruppe.

Derzeit hat die Zahl der auf Google Scholar angezeigten Zitate von Michal Kosinskis Arbeiten 18.000+ erreicht.

Andererseits, glauben Sie, dass GPT-3.5 wirklich einen Verstand hat?

GPT3.5-Testadresse: https://platform.openai.com/playground

Das obige ist der detaillierte Inhalt vonNeue Stanford-Forschung: Das Modell hinter ChatGPT hat nachweislich einen menschlichen Geist. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Was sind die gängigen Testtechniken?

Was sind die gängigen Testtechniken?

So lösen Sie den Löschdatei-Fehlercode 5

So lösen Sie den Löschdatei-Fehlercode 5

So lösen Sie das Problem, das Einschaltkennwort eines Win8-Computers zu vergessen

So lösen Sie das Problem, das Einschaltkennwort eines Win8-Computers zu vergessen

HTML-Webseitenproduktion

HTML-Webseitenproduktion

ppt zu Wort

ppt zu Wort

Einführung in den js-Sprungcode

Einführung in den js-Sprungcode

Was sind die Video-Suffixe?

Was sind die Video-Suffixe?

Inländische kostenlose ChatGPT-Enzyklopädie

Inländische kostenlose ChatGPT-Enzyklopädie