Im Allgemeinen wird kontinuierliches Lernen durch katastrophales Vergessen eindeutig eingeschränkt, und das Erlernen neuer Aufgaben führt oft zu einem starken Leistungsabfall bei alten Aufgaben.

Darüber hinaus gab es in den letzten Jahren immer mehr Fortschritte, die das Verständnis und die Anwendung von kontinuierlichem Lernen erheblich erweitert haben.

Das wachsende und weit verbreitete Interesse an dieser Richtung zeigt ihre praktische Bedeutung und Komplexität.

Papieradresse //m.sbmmt.com/link/82039d16dce0aab3913b6a7ac73deff7

Dieser Artikel bietet eine umfassende Einführung in kontinuierliches Lernen Die Befragung versucht Zusammenhänge zwischen Grundeinstellungen, theoretischen Grundlagen, repräsentativen Methoden und praktischen Anwendungen herzustellen.

Basierend auf vorhandenen theoretischen und empirischen Ergebnissen werden die allgemeinen Ziele des kontinuierlichen Lernens wie folgt zusammengefasst: Gewährleistung angemessener Stabilitäts-Plastizitäts-Kompromisse und ausreichender Intra-/Inter-Task-Generalisierungsfähigkeiten im Kontext der Ressourceneffizienz.

Bietet eine hochmoderne und detaillierte Taxonomie, die umfassend analysiert, wie repräsentative Strategien kontinuierliches Lernen ansprechen und wie sie sich an spezifische Herausforderungen in verschiedenen Anwendungen anpassen.

Durch eine ausführliche Diskussion aktueller Trends im kontinuierlichen Lernen, richtungsübergreifender Perspektiven und interdisziplinärer Verbindungen mit den Neurowissenschaften wird davon ausgegangen, dass diese ganzheitliche Perspektive die spätere Erforschung dieses und anderer Bereiche erheblich erleichtern kann.

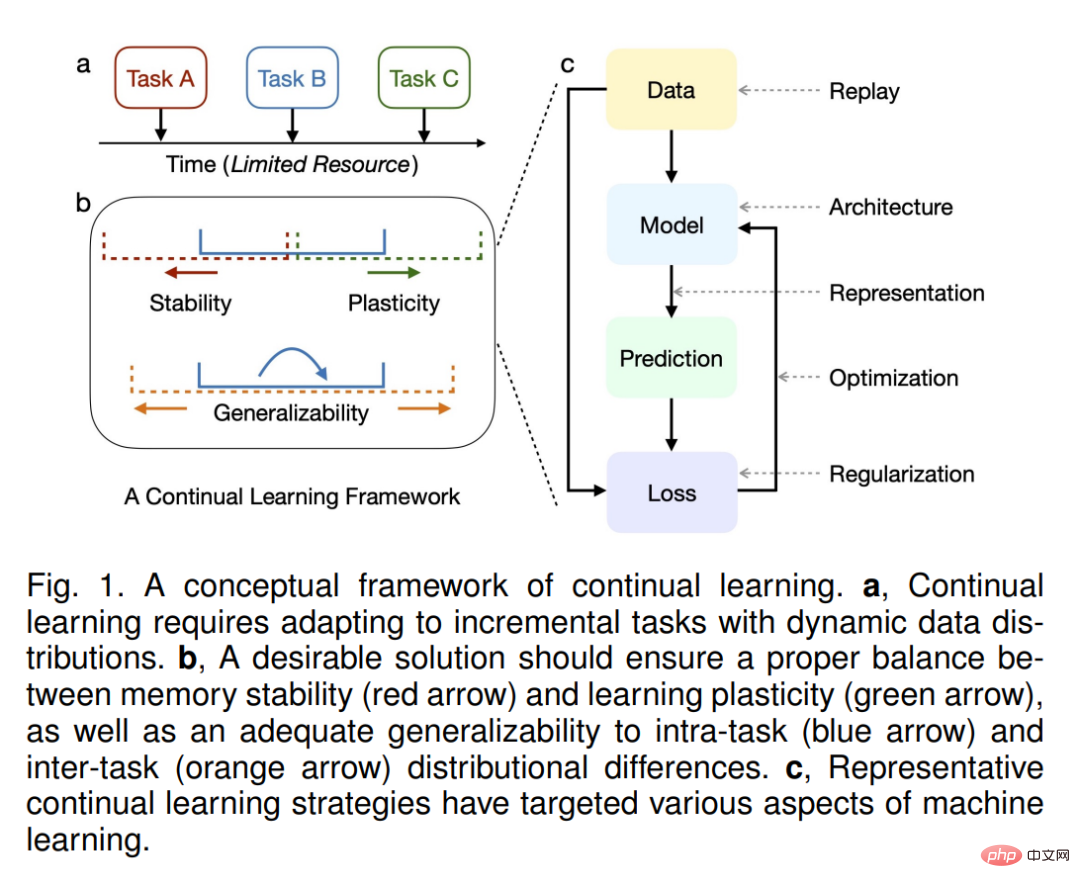

Lernen ist die Grundlage dafür, dass sich intelligente Systeme an die Umgebung anpassen. Um mit Veränderungen in der Außenwelt zurechtzukommen, hat die Evolution den Menschen und andere Organismen in hohem Maße anpassungsfähig und in der Lage gemacht, kontinuierlich Wissen zu erwerben, zu aktualisieren, zu akkumulieren und zu nutzen [148], [227], [322]. Natürlich erwarten wir, dass sich Systeme der künstlichen Intelligenz (KI) in ähnlicher Weise anpassen. Dies hat die Forschung zum kontinuierlichen Lernen inspiriert, bei der eine typische Situation darin besteht, eine Abfolge von Inhalten nacheinander zu lernen und sich so zu verhalten, als ob sie gleichzeitig beobachtet würden (Abbildung 1, a). Dies können neue Fähigkeiten, neue Beispiele alter Fähigkeiten, unterschiedliche Umgebungen, unterschiedliche Kontexte usw. sein und spezifische Herausforderungen aus der realen Welt beinhalten [322], [413]. Da Inhalte im Laufe eines Lebens schrittweise bereitgestellt werden, wird kontinuierliches Lernen in vielen Literaturen auch als inkrementelles Lernen oder lebenslanges Lernen bezeichnet, eine strikte Unterscheidung erfolgt jedoch nicht [70], [227].

Im Gegensatz zu herkömmlichen Modellen des maschinellen Lernens, die auf statischer Datenverteilung basieren, zeichnet sich kontinuierliches Lernen durch Lernen aus dynamischer Datenverteilung aus. Eine große Herausforderung ist das sogenannte katastrophale Vergessen [291], [292], bei dem die Anpassung an eine neue Verteilung häufig zu einer stark eingeschränkten Fähigkeit führt, die alte Verteilung zu erfassen. Dieses Dilemma ist ein Aspekt des Kompromisses zwischen Lernplastizität und Gedächtnisstabilität: Zu viel von ersterem beeinträchtigt letzteres und umgekehrt. Über das einfache Ausbalancieren des „Verhältnisses“ dieser beiden Aspekte hinaus sollte eine ideale Lösung für kontinuierliches Lernen starke Generalisierungsfähigkeiten erreichen, um sich an Verteilungsunterschiede innerhalb und zwischen Aufgaben anzupassen (Abbildung 1, b). Als naive Basis kann die Umschulung aller alten Trainingsbeispiele (falls zulässig) die oben genannten Herausforderungen leicht lösen, verursacht jedoch einen enormen Rechen- und Speicheraufwand (und potenzielle Datenschutzprobleme). Tatsächlich besteht der Hauptzweck des kontinuierlichen Lernens darin, die Ressourceneffizienz von Modellaktualisierungen sicherzustellen, vorzugsweise so weit, dass nur neue Trainingsbeispiele gelernt werden.

Viele Anstrengungen wurden unternommen, um die oben genannten Herausforderungen zu lösen, die konzeptionell in fünf Gruppen unterteilt werden können (Abbildung 1, c): Hinzufügen von Regularisierungstermen unter Bezugnahme auf das alte Modell (Regularisierungsbasierte Methoden); alte Datenverteilung (basierend auf dem Wiedergabeansatz); explizites Betreiben des Optimierers (optimierungsbasierter Ansatz); Lernen von Darstellungen, die robust sind und sich gut verallgemeinern lassen (darstellungsbasierter Ansatz); (basierter Ansatz) Methode). Diese Taxonomie erweitert die jüngsten Fortschritte bei häufig verwendeten Taxonomien und bietet verfeinerte Unterrichtungen für jede Kategorie. Es fasst zusammen, wie diese Methoden die vorgeschlagenen allgemeinen Ziele erreichen, und bietet eine umfassende Analyse ihrer theoretischen Grundlagen und typischen Implementierungen. Insbesondere sind diese Methoden eng miteinander verknüpft, so dass Regularisierung und Replay letztlich die Gradientenrichtung bei der Optimierung korrigieren, und sind hochgradig synergistisch, so kann beispielsweise der Replay-Effekt durch die Extraktion von Wissen aus dem alten Modell verbessert werden.

Reale Anwendungen stellen besondere Herausforderungen für kontinuierliches Lernen dar, die in Szenenkomplexität und Aufgabenspezifität unterteilt werden können. Bei Ersterem kann es beispielsweise sein, dass das Aufgabenorakel (d. h. welche Aufgabe ausgeführt werden soll) im Training und Test fehlt und die Trainingsbeispiele möglicherweise in kleinen Mengen oder sogar auf einmal eingeführt werden. Aufgrund der Kosten und der Knappheit der Datenkennzeichnung muss kontinuierliches Lernen in Szenarien mit wenigen Schüssen, halbüberwachten oder sogar unbeaufsichtigten Szenarien effektiv sein. Während sich der aktuelle Fortschritt hauptsächlich auf die visuelle Klassifizierung konzentriert, werden bei Letzterem auch andere visuelle Bereiche wie Objekterkennung, semantische Segmentierung und Bilderzeugung sowie andere verwandte Bereiche wie Reinforcement Learning (RL), Natural Language Processing (NLP) und Ethik berücksichtigt Überlegungen) erhält immer mehr Aufmerksamkeit, seine Chancen und Herausforderungen.

Angesichts des deutlich wachsenden Interesses an kontinuierlichem Lernen glauben wir, dass diese neueste und umfassende Umfrage eine ganzheitliche Perspektive für die nachfolgende Arbeit bieten kann. Obwohl es einige frühe Untersuchungen zum kontinuierlichen Lernen mit relativ breiter Abdeckung gibt [70], [322], wurden die wichtigen Fortschritte der letzten Jahre nicht berücksichtigt. Im Gegensatz dazu haben neuere Umfragen im Allgemeinen nur lokale Aspekte des kontinuierlichen Lernens im Hinblick auf seine biologischen Grundlagen [148], [156], [186], [227] und spezielle Einstellungen für die visuelle Klassifizierung [85], [283], [ 289], [346] und Erweiterungen in NLP [37], [206] oder RL [214]. Nach unserem besten Wissen ist dies die erste Umfrage, die die jüngsten Fortschritte beim kontinuierlichen Lernen systematisch zusammenfasst. Aufbauend auf diesen Stärken bieten wir eine ausführliche Diskussion über kontinuierliches Lernen zu aktuellen Trends, richtungsübergreifenden Perspektiven (wie Diffusionsmodellen, groß angelegtem Vortraining, visuellen Transformatoren, verkörperter KI, neuronaler Komprimierung usw.) und interdisziplinäre Verbindungen zur Neurowissenschaft.

Zu den Hauptbeiträgen gehören:

(1) Eine aktuelle und umfassende Übersicht über kontinuierliches Lernen, um Fortschritte in Theorie, Methoden und Anwendungen zu verbinden;

(2) Basierend Auf dem aktuellen Stand fassen einige theoretische und empirische Ergebnisse die allgemeinen Ziele des kontinuierlichen Lernens zusammen und klassifizieren repräsentative Strategien im Detail wie sich kontinuierliche Lernstrategien an diese Herausforderungen anpassen;

Dieses Papier ist wie folgt aufgebaut: In Abschnitt 2 stellen wir das Setting des kontinuierlichen Lernens vor, einschließlich seiner Grundformel, typischen Szenarien und Bewertungsmetriken. In Abschnitt 3 fassen wir einige theoretische Bemühungen zum kontinuierlichen Lernen mit ihren allgemeinen Zielen zusammen. In Abschnitt 4 bieten wir eine aktuelle und detaillierte Klassifizierung repräsentativer Strategien und analysieren ihre Motivationen und typischen Umsetzungen. In den Abschnitten 5 und 6 beschreiben wir, wie sich diese Strategien an reale Herausforderungen der Szenenkomplexität und Aufgabenspezifität anpassen. In Abschnitt 7 diskutieren wir aktuelle Trends, Perspektiven für interdisziplinäre Richtungen und interdisziplinäre Verbindungen in den Neurowissenschaften.

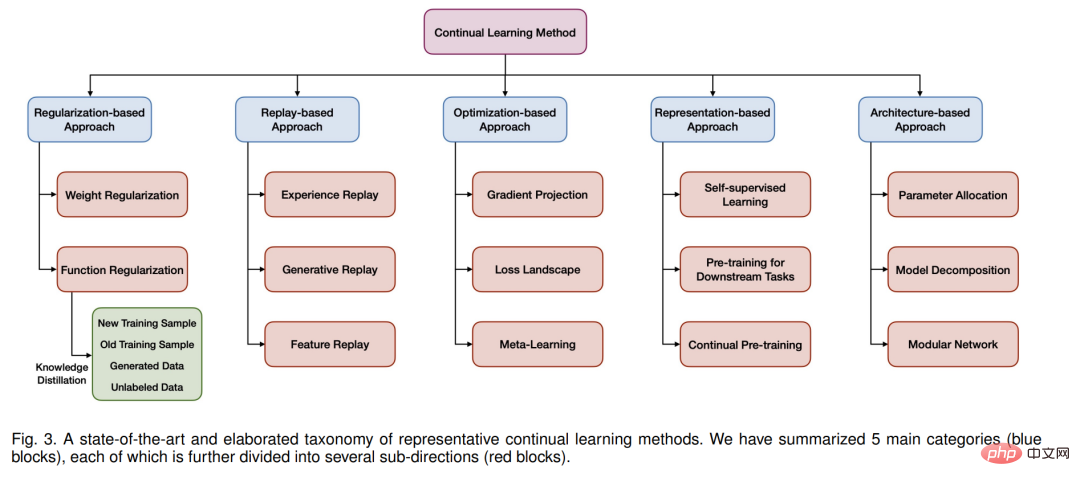

In diesem Abschnitt beschreiben wir die Klassifizierung repräsentativer kontinuierlicher Lernmethoden (siehe Abbildung 3 und Abbildung 1, c) und analysieren ausführlich ihre Hauptmotivationen, typischen Implementierungen und empirischen Eigenschaften.

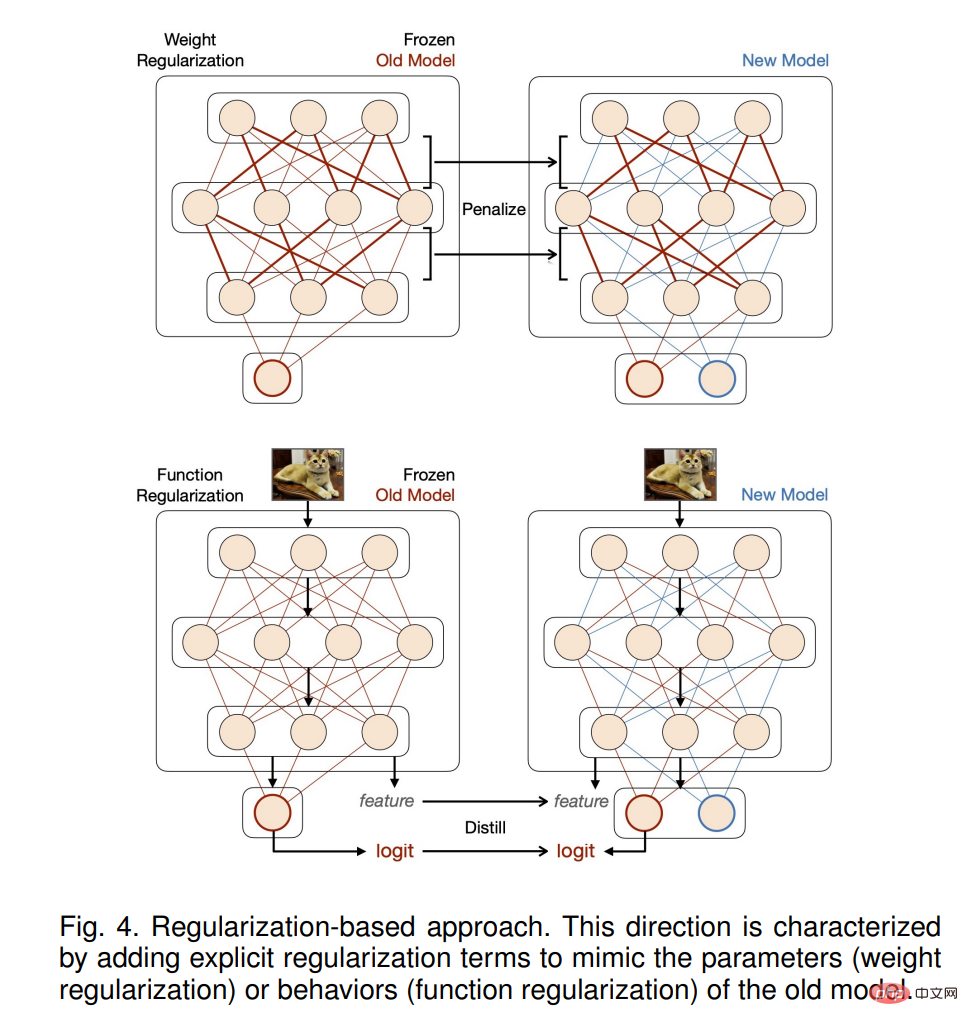

Regularisierungsbasierte Methode

Diese Richtung zeichnet sich durch das Hinzufügen expliziter Regularisierungsterme aus, um alte und neue Aufgaben auszugleichen, was häufig das Speichern einer eingefrorenen Kopie des alten Modells als Referenz erfordert (siehe Abbildung 4). Entsprechend dem Ziel der Regularisierung lassen sich solche Methoden in zwei Kategorien einteilen.

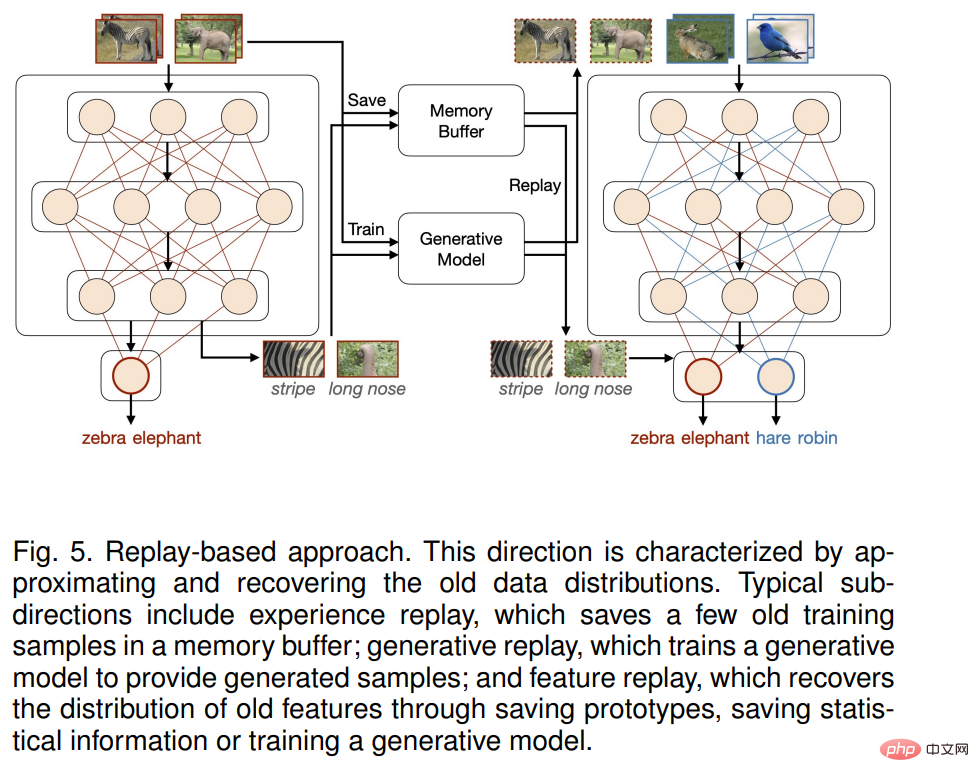

Replay-basierte Methoden

Methoden, die die alte Datenverteilung annähern und wiederherstellen, werden in diese Richtung gruppiert (siehe Abbildung 5). Je nach Inhalt der Wiedergabe lassen sich diese Methoden weiter in drei Unterrichtungen unterteilen, die jeweils ihre eigenen Herausforderungen mit sich bringen.

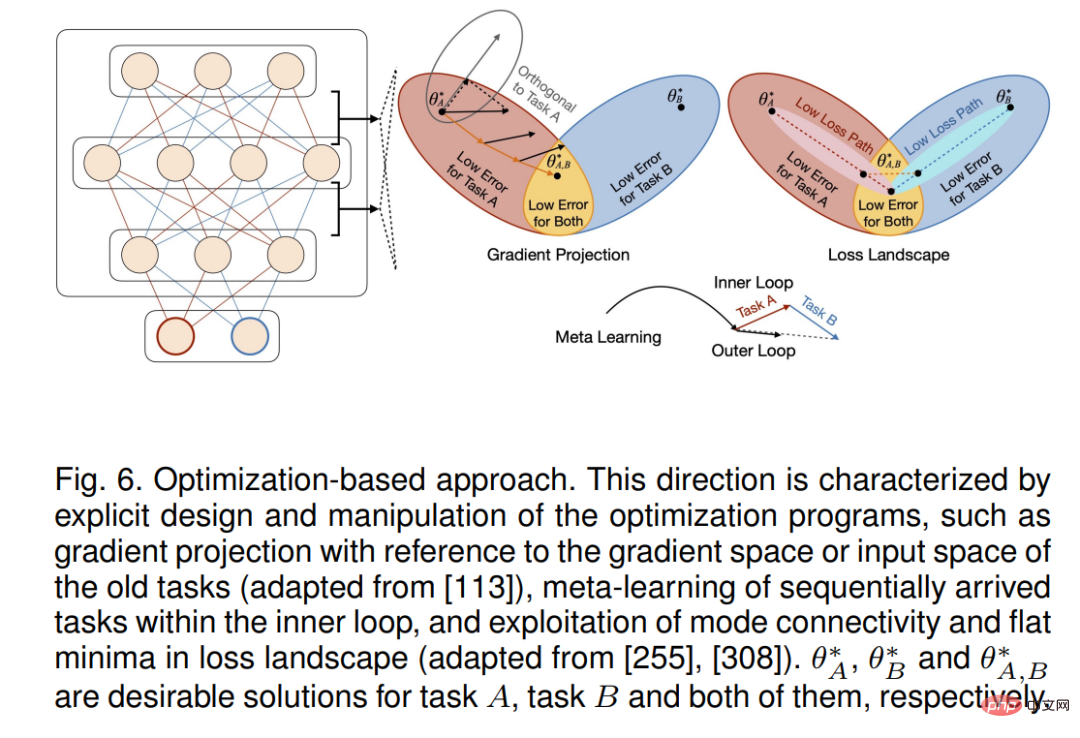

Optimierungsbasierter Ansatz

Kontinuierliches Lernen kann nicht nur durch Hinzufügen zusätzlicher Begriffe zur Verlustfunktion (z. B. Regularisierung und Wiederholung) erreicht werden, sondern auch durch explizites Design und Es werden betriebliche Optimierungsverfahren implementiert.

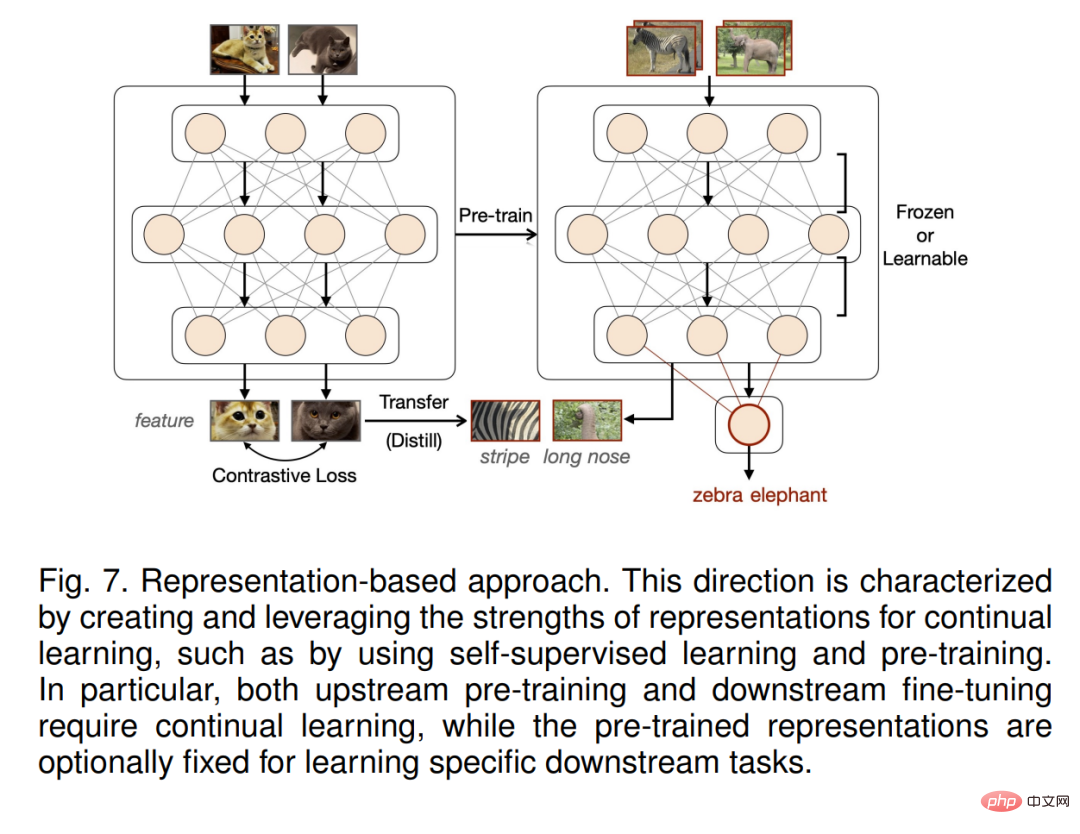

Repräsentationsbasierte Methoden

Methoden, die die Vorteile kontinuierlich lernender Darstellungen erstellen und nutzen, fallen in diese Kategorie. Zusätzlich zu frühen Arbeiten zum Erhalten spärlicher Darstellungen durch Meta-Training [185] wurde in neueren Arbeiten versucht, selbstüberwachtes Lernen (SSL) [125], [281], [335] und groß angelegtes Vortraining [295] zu kombinieren ], [380], [456] zur Verbesserung der Darstellung bei der Initialisierung und beim fortlaufenden Lernen. Beachten Sie, dass diese beiden Strategien eng miteinander verbunden sind, da die Daten vor dem Training oft riesig sind und nicht explizit gekennzeichnet werden, während die Leistung von SSL selbst hauptsächlich durch die Feinabstimmung (einer Reihe) nachgelagerter Aufgaben bewertet wird. Im Folgenden besprechen wir repräsentative Unterrichtungen.

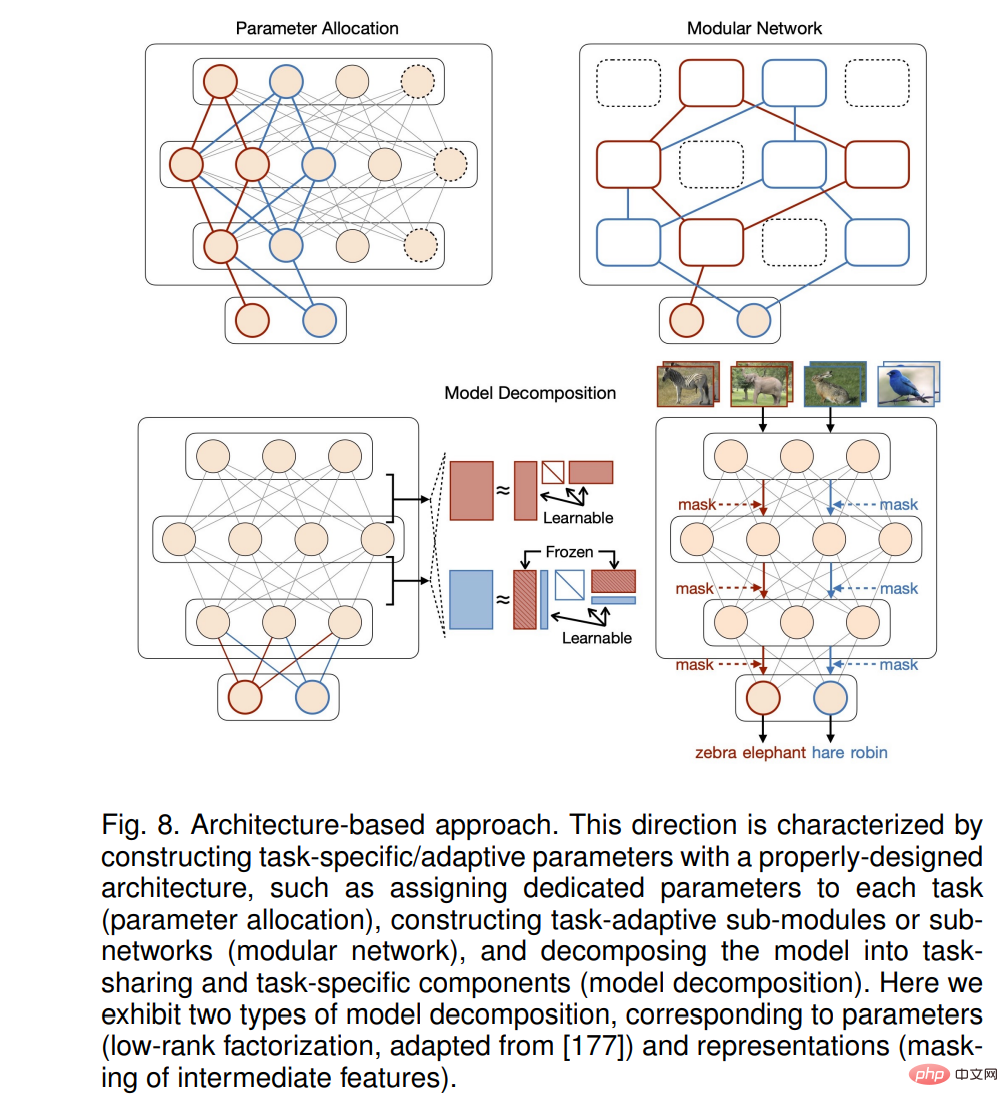

Architekturbasierter Ansatz

Die obige Strategie konzentriert sich hauptsächlich auf das Erlernen aller inkrementellen Aufgaben mit einem gemeinsamen Parametersatz (d. h. einem einzelnen Modell und einem Parameterraum), dem Hauptaufgabe Hauptursache der Störung. Stattdessen kann die Konstruktion aufgabenspezifischer Parameter dieses Problem explizit lösen. Frühere Arbeiten unterteilen diese Richtung normalerweise in Parameterisolation und dynamische Architektur, basierend darauf, ob die Netzwerkarchitektur fest ist oder nicht. Dieses Papier konzentriert sich auf Möglichkeiten zur Implementierung aufgabenspezifischer Parameter und erweitert die oben genannten Konzepte auf Parameterzuweisung, Modellzerlegung und modulare Netzwerke (Abbildung 8).

Das obige ist der detaillierte Inhalt vonTsinghuas neueste Rezension zum Thema „Kontinuierliches Lernen', 32 Seiten mit detaillierten Informationen zu Theorien, Methoden und Anwendungen des kontinuierlichen Lernens. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Welche Antivirensoftware gibt es?

Welche Antivirensoftware gibt es?

Inländische Plattform für digitale Währungen

Inländische Plattform für digitale Währungen

So konfigurieren Sie Tomcat-Umgebungsvariablen

So konfigurieren Sie Tomcat-Umgebungsvariablen

Was bedeutet c#?

Was bedeutet c#?

So stellen Sie dauerhaft gelöschte Dateien auf dem Computer wieder her

So stellen Sie dauerhaft gelöschte Dateien auf dem Computer wieder her

So öffnen Sie HTML-Dateien auf einem Mobiltelefon

So öffnen Sie HTML-Dateien auf einem Mobiltelefon

Methode zur Wiederherstellung der Oracle-Datenbank

Methode zur Wiederherstellung der Oracle-Datenbank

So lösen Sie Probleme beim Parsen von Paketen

So lösen Sie Probleme beim Parsen von Paketen