Die Lightweight-Version von ChatGPT basierend auf dem Meta-Modell ist da?

Meta hat die Einführung von LLaMA erst vor drei Tagen angekündigt, und die Branche hat bereits eine Open-Source-Trainingsmethode entwickelt, um sie in ChatGPT zu integrieren, die angeblich bis zu 15-mal schneller ist als das ChatGPT-Training.

LLaMA ist ein ultraschnelles und ultrakleines GPT-3, das von Meta eingeführt wurde. Die Anzahl der Parameter beträgt nur 10 % und es ist nur eine einzige GPU erforderlich.

Die Methode zur Umwandlung in ChatGPT heißt ChatLLaMA. Sie basiert auf RLHF (Reinforcement Learning basierend auf menschlichem Feedback) und wurde schnell zu einem heißen Thema im Internet.

Also kommt Metas Open-Source-Version von ChatGPT wirklich?

Moment mal, so einfach ist das nicht.

Klicken Sie auf die Homepage des ChatLLaMA-Projekts und Sie werden feststellen, dass es tatsächlich vier Teile integriert:

DeepSpeed, RLHF-Methode, LLaMA und den auf dem LangChain-Agenten generierten Datensatz.

DeepSpeed ist eine Open-Source-Bibliothek zur Optimierung des Deep-Learning-Trainings, einschließlich einer vorhandenen Optimierungstechnologie namens Zero, die zur Verbesserung der Trainingsfähigkeiten großer Modelle verwendet wird. Dies bezieht sich insbesondere darauf, dem Modell dabei zu helfen, die Trainingsgeschwindigkeit zu verbessern und die Kosten zu senken , Modellverfügbarkeit verbessern usw.

RLHF wird das Belohnungsmodell verwenden, um das vorab trainierte Modell zu verfeinern. Das Belohnungsmodell verwendet zunächst mehrere Modelle, um Fragen und Antworten zu generieren, und verlässt sich dann auf die manuelle Sortierung der Fragen und Antworten, damit es lernen kann, Punkte zu erzielen. Anschließend bewertet es die vom Modell generierten Antworten auf der Grundlage des Belohnungslernens und verbessert die Ergebnisse Modellfähigkeiten durch verstärkendes Lernen.

LangChain ist eine große Entwicklungsbibliothek für Sprachmodellanwendungen, die darauf abzielt, verschiedene große Sprachmodelle zu integrieren und in Kombination mit anderen Wissensquellen oder Rechenleistung eine praktische Anwendung zu erstellen. Der LangChain-Agent wird den gesamten Prozess des GPT-3-Denkens wie eine Gedankenkette freigeben und die Vorgänge aufzeichnen.

Zu diesem Zeitpunkt werden Sie feststellen, dass das Modellgewicht von LLaMA immer noch das Wichtigste ist. Woher kommt es?

Hey, gehen Sie zu Meta und bewerben Sie sich selbst, ChatLLaMA bietet es nicht. (Obwohl Meta behauptet, Open-Source-LLaMA zu sein, müssen Sie sich dennoch bewerben.)

ChatLLaMA ist also im Wesentlichen kein Open-Source-ChatGPT-Projekt, sondern nur eine auf LLaMA basierende Trainingsmethode sind Open Source.

Tatsächlich wurde ChatLLaMA nicht von Meta entwickelt, sondern von einem Start-up-KI-Unternehmen namens Nebuly AI.

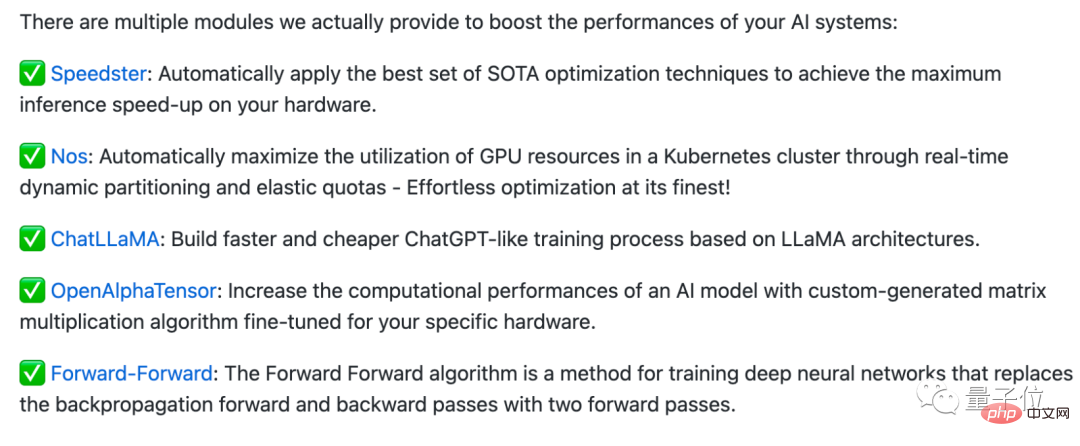

Nebuly AI hat eine Open-Source-Bibliothek namens Nebullvm erstellt, die eine Reihe von Plug-and-Play-Optimierungsmodulen integriert, um die Leistung des KI-Systems zu verbessern.

Dies sind zum Beispiel einige Module, die derzeit in Nebullvm enthalten sind, darunter OpenAlphaTensor, das auf dem Open-Source-AlphaTensor-Algorithmus von DeepMind basiert, Optimierungsmodule, die Hardware automatisch erkennen und beschleunigen ...

ChatLLaMA ist auch in dieser Modulreihe enthalten, Es ist jedoch zu beachten, dass die Open-Source-Lizenz nicht im Handel erhältlich ist.

Wenn Sie also das „inländische selbst entwickelte ChatGPT“ direkt verwenden möchten, ist dies möglicherweise nicht so einfach (Doge).

Nachdem sie dieses Projekt gelesen hatten, sagten einige Internetnutzer, dass es großartig wäre, wenn jemand wirklich die Modellgewichte (Code) von LLaMA bekommen könnte ...

Aber einige Internetnutzer wiesen darauf hin, dass es „15-mal schneller ist als die ChatGPT-Trainingsmethode“ Diese Aussage ist rein irreführend:

Die sogenannte 15-mal schnellere Geschwindigkeit liegt nur daran, dass das LLaMA-Modell selbst klein ist und sogar auf einer einzigen GPU laufen kann, aber das sollte nicht daran liegen, dass irgendetwas darin gemacht wurde dieses Projekt, oder?

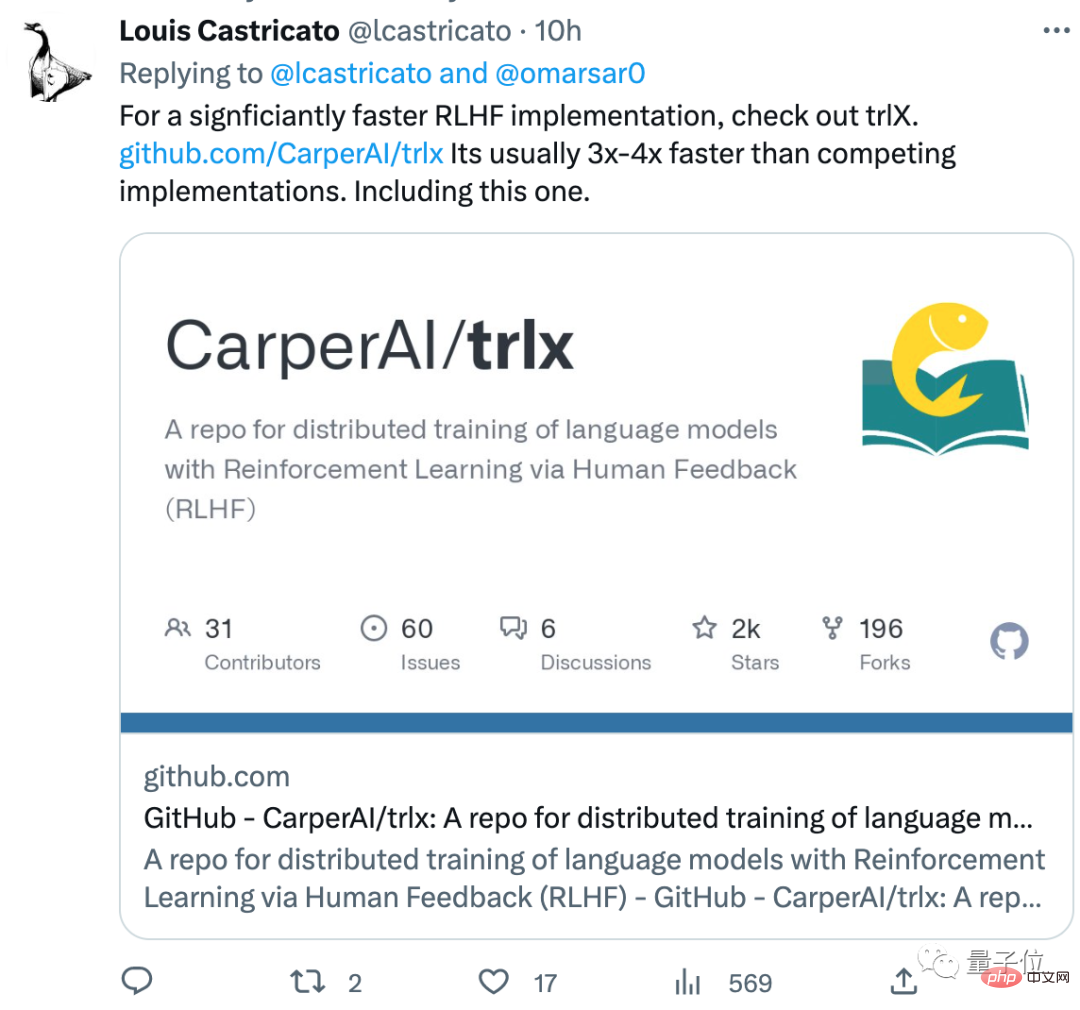

Dieser Internetnutzer hat auch eine RLHF-Trainingsmethode namens trlx empfohlen, die besser ist als die in der Bibliothek. Die Trainingsgeschwindigkeit ist 3 bis 4 Mal schneller als die übliche RLHF-Methode:

Sie nehmen es Hast du den Code für LLaMA? Was halten Sie von dieser Trainingsmethode?

ChatLLaMA-Adresse://m.sbmmt.com/link/fed537780f3f29cc5d5f313bbda423c4

Referenzlink://m.sbmmt.com/link/fe27f92b1e3f4997567807f38d567a35

Das obige ist der detaillierte Inhalt vonDie leichtgewichtige Version der ChatGPT-Trainingsmethode ist Open Source! Die Trainingsgeschwindigkeit wurde rund um LLaMA in nur drei Tagen entwickelt und soll 15-mal schneller sein als bei OpenAI. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Einführung in die Verwendung des gesamten VBS-Codes

Einführung in die Verwendung des gesamten VBS-Codes

Mathematische Modellierungssoftware

Mathematische Modellierungssoftware

Welche Rolle spielt der SIP-Server?

Welche Rolle spielt der SIP-Server?

Welcher Ordner ist AppData, der gelöscht werden kann?

Welcher Ordner ist AppData, der gelöscht werden kann?

Empfohlene Reihenfolge zum Erlernen von C++ und der C-Sprache

Empfohlene Reihenfolge zum Erlernen von C++ und der C-Sprache

So heben Sie Gebühren auf WeChat ab

So heben Sie Gebühren auf WeChat ab

Webstorm passt die Schriftgröße an

Webstorm passt die Schriftgröße an

Browser-Kompatibilität

Browser-Kompatibilität