OpenAI, ein Forschungslabor für künstliche Intelligenz, hat am 30. November 2022 das Modell zur Erzeugung natürlicher Sprache, ChatGPT, veröffentlicht. Innerhalb von zwei Monaten nach seiner Einführung hat es die 100-Millionen-Nutzer-Marke überschritten und ist damit zu einer wohlverdienten Super-Internet-Berühmtheit im Bereich der künstlichen Intelligenz geworden Industrie. ChatGPT setzte sich mit seinen leistungsstarken anthropomorphen und zeitnahen Reaktionsfähigkeiten schnell durch und löste hitzige Diskussionen in allen Lebensbereichen aus. Einfach ausgedrückt ist ChatGPT ein Chatbot mit künstlicher Intelligenz, der automatisch Antworten basierend auf der Texteingabe des Benutzers generieren kann. Dann werden einige Leute definitiv sagen, dass dies Siri ist. Obwohl es sich bei beiden um interaktive Roboter handelt, ist der Unterschied zwischen den beiden riesig. Warum schneidet ChatGPT bei der Mensch-Computer-Interaktion so gut ab? Wird es Suchmaschinen ersetzen? Besteht durch das Aufkommen von ChatGPT wirklich die Gefahr, dass 90 % der Menschen ihren Arbeitsplatz verlieren? Lassen Sie uns mit diesen Fragen einen Blick darauf werfen, was ChatGPT so besonders macht und welche Veränderungen es in Zukunft für die Branche mit sich bringen wird.

Mein Verständnis dieses Satzes ist, dass das Internet über das gesamte menschliche Wissen und die gesamte Erfahrung verfügt und umfangreiche Lerndaten für die künstliche Intelligenz bereitstellt. Wenn dieses Wissen und diese Erfahrung in geordneter Weise organisiert sind, bietet es auch reichlich Datengrundlage für das Training einer „Knowing King“-Anwendung für künstliche Intelligenz. Nachdem ChatGPT mit den riesigen Textdaten und Sprachdatenbankdaten im Internet gefüttert und trainiert wurde, kann es entsprechende Antworten basierend auf dem Inhalt des von Ihnen eingegebenen Textes generieren, genau wie zwei Personen, die miteinander chatten. Abgesehen von der Möglichkeit, ohne Hindernisse mit Ihnen zu kommunizieren, kann es Ihnen sogar das Gefühl geben, dass Sie nicht mit einem Chatbot sprechen, sondern mit einer echten Person, die sachkundig und ein bisschen lustig ist. Die Antworten haben sogar einen gewissen menschlichen Ton Das war bei früheren Chatbots unvorstellbar.

Hier ist eine kurze Erklärung der wörtlichen Bedeutung von ChatGPT. Es handelt sich um ein allgemeines Modell zur Generierung natürlicher Sprache, und der sogenannte GPT ist Genarative Pre-Trained Transformer, was Generative Pre-Trained bedeutet Klingt das nicht etwas unklar?

Darüber hinaus können Sie ihn auch bitten, Ihnen bei der Erledigung einiger praktischer Arbeiten zu helfen, z. B. beim Schreiben von Texten, beim Schreiben von Skripten und sogar beim direkten Schreiben von Code und bei der Suche nach Fehlern im Code. Dies ist ein Programm Mitglieder wollen ihre eigenen Jobs zerstören und es in Stücke reißen. Man kann sagen, dass es auf Text- und Codeebene allmächtig ist. Diese interaktive Methode, Fragen einzugeben und sofort Antworten zu geben, ist weitaus besser als die Erfahrung, traditionelle Suchmaschinen zu verwenden, um in riesigen Datenmengen das zu finden, was Sie suchen. Daher ist es absehbar, dass ChatGPT in naher Zukunft traditionelle Suchmaschinen untergraben und völlig verändern wird die Art und Weise der Informationsbeschaffung.

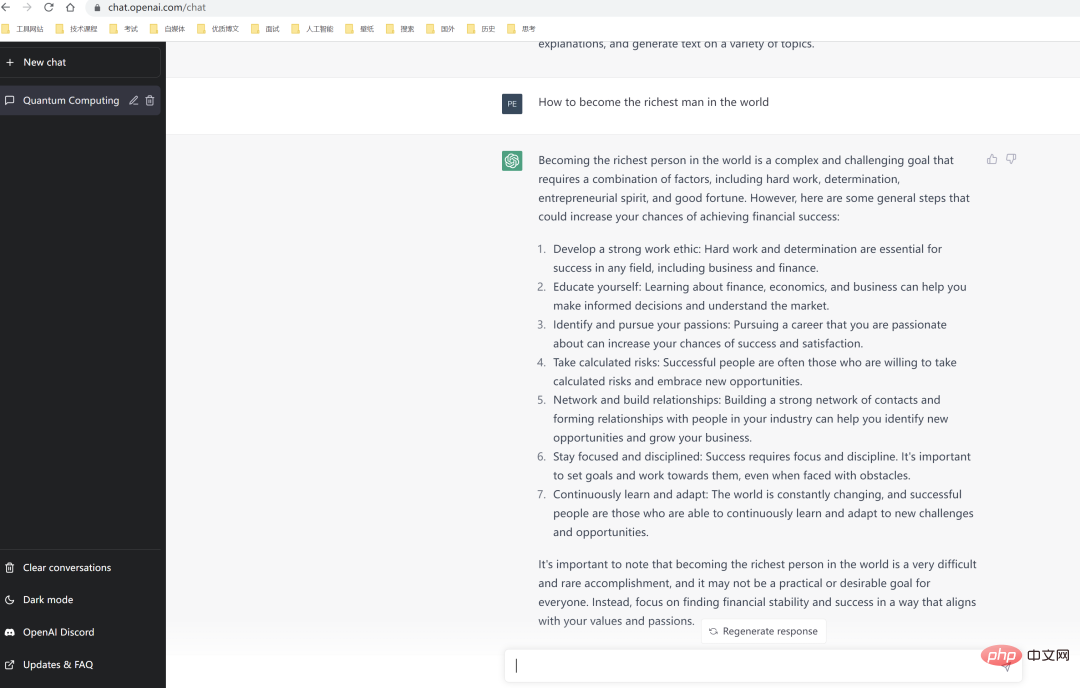

Darüber hinaus kann ChatGPT Fragen auch im Kontext beantworten und gleichzeitig seine eigenen Mängel proaktiv eingestehen und die Rationalität von Fragen in Frage stellen. Im Folgenden lehnt ChatGPT die von mir gestellte Frage ab.

PS: Ich habe ChatGPT gefragt, wie man der reichste Mann der Welt wird. Das Geheimnis ist unten.

Gerade weil ChartGPT über solch leistungsstarke Verständnis-, Lern- und Kreativfähigkeiten verfügt, ist es seit der Geburt der künstlichen KI-Intelligenz zum am schnellsten wachsenden intelligenten Anwendungsprodukt für C-End-Benutzer geworden. In der Vergangenheit galten Produkte der künstlichen Intelligenz auf der C-Seite immer als nicht intelligent genug oder wurden sogar als „künstlich zurückgeblieben“ verspottet. Selbst auf der B-Seite konnten normale Menschen die Macht der KI einfach nicht spüren Das Aufkommen von ChatGPT könnte jedoch darauf hindeuten, dass künstliche Intelligenz in Zukunft in das Leben der einfachen Menschen integriert wird.

PS: Ich habe wirklich Angst, dass er mit Ja antworten wird.

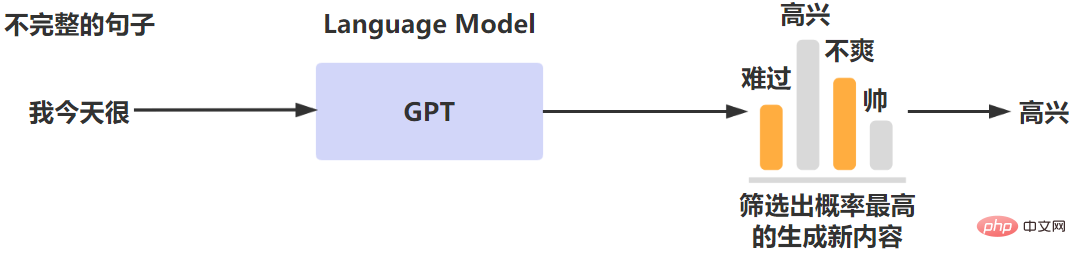

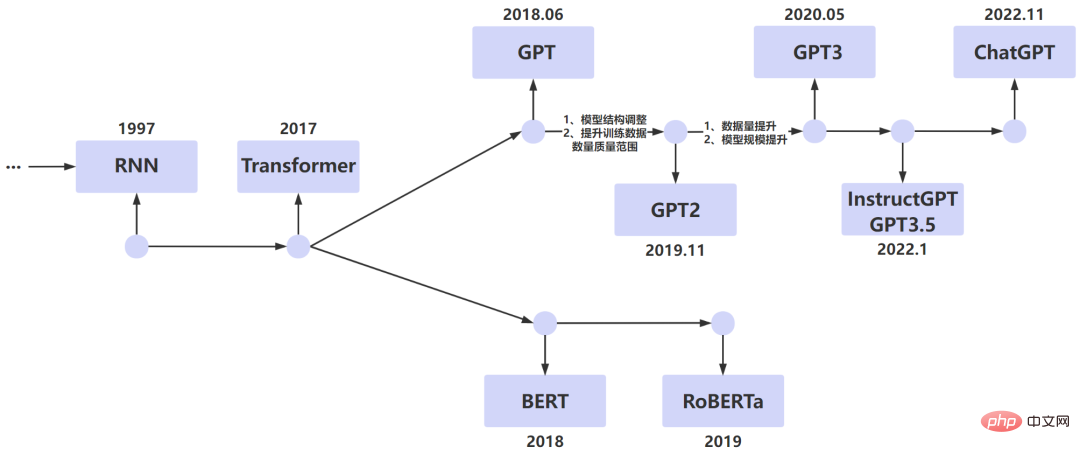

Wir alle wissen, dass natürliche Sprache das wichtigste Werkzeug für die menschliche Kommunikation ist. Daher war es schon immer eine unermüdliche Suche auf dem Gebiet, Maschinen durch natürliche Sprache barrierefrei mit Menschen kommunizieren zu lassen Ziel der künstlichen Intelligenz. NLP (Natural Language Processing) ist eine wichtige Forschungsrichtung im Bereich der Informatik und künstlichen Intelligenz, die sich darauf spezialisiert hat, Maschinen die Möglichkeit zu geben, natürliche Sprache zu verstehen und auf dieser Grundlage zu reagieren. Wenn Sie möchten, dass ein Computer natürliche Sprache erkennt, benötigen Sie ein entsprechendes Sprachmodell, um den Text zu analysieren und zu verarbeiten. Das allgemeine Prinzip des -Sprachmodells besteht darin, eine Wahrscheinlichkeitsmodellierung von Sprachtexten durchzuführen und das Modell zu verwenden, um die Wahrscheinlichkeit des nächsten Ausgabeinhalts vorherzusagen. Der allgemeine Prozess ist wie folgt. Das Sprachmodell wird verwendet, um den Satz mit der höchsten Auftrittswahrscheinlichkeit nach einem Absatz auszugeben. Sprachmodelle können in statistische Sprachmodelle und neuronale Netzwerk-Sprachmodelle unterteilt werden. ChatGPT ist ein neuronales Netzwerk-Sprachmodell, das nach iterativer Optimierung in mehreren Versionen die herausragende Leistung erzielte, die heute alle schockiert. Wir können einen kurzen Blick auf die Entwicklungsgeschichte von LM (Sprachmodell) werfen und sehen, wie sich das Sprachmodell Schritt für Schritt entwickelt. Dies ist für uns sehr hilfreich, um die technischen Prinzipien von ChatGPT zu verstehen.

RNN

RNN (Recurrent Neural Network, rekurrentes neuronales Netzwerk) ist im Bereich NPL weit verbreitet. Das oben erwähnte NLP zielt darauf ab, das Problem zu lösen, die Maschine die natürliche Sprache verstehen zu lassen. Wenn die Maschine die Bedeutung eines Satzes verstehen darf, muss sie daher nicht nur die Bedeutung jedes Wortes im Satz verstehen, sondern auch verarbeiten Was ist die Bedeutung der verbundenen Sequenzen? RNN löst das Problem der Modellierung der Sequenz von Beispieldaten.

RNN (Recurrent Neural Network, rekurrentes neuronales Netzwerk) ist im Bereich NPL weit verbreitet. Das oben erwähnte NLP zielt darauf ab, das Problem zu lösen, die Maschine die natürliche Sprache verstehen zu lassen. Wenn die Maschine die Bedeutung eines Satzes verstehen darf, muss sie daher nicht nur die Bedeutung jedes Wortes im Satz verstehen, sondern auch verarbeiten Was ist die Bedeutung der verbundenen Sequenzen? RNN löst das Problem der Modellierung der Sequenz von Beispieldaten.

RNN weist jedoch Effizienzprobleme auf. Bei der Verarbeitung von Sprachsequenzen erfolgt die Verarbeitung durch Serialisierung, was bedeutet, dass die Verarbeitung des nächsten Wortes warten muss, bis der Status des vorherigen Wortes ausgegeben wird. Um fortzufahren, gibt es auch Probleme wie Gradientenexplosion und Vergessen. Daher optimieren Experten für künstliche Intelligenz weiterhin Modelle auf dieser Basis.

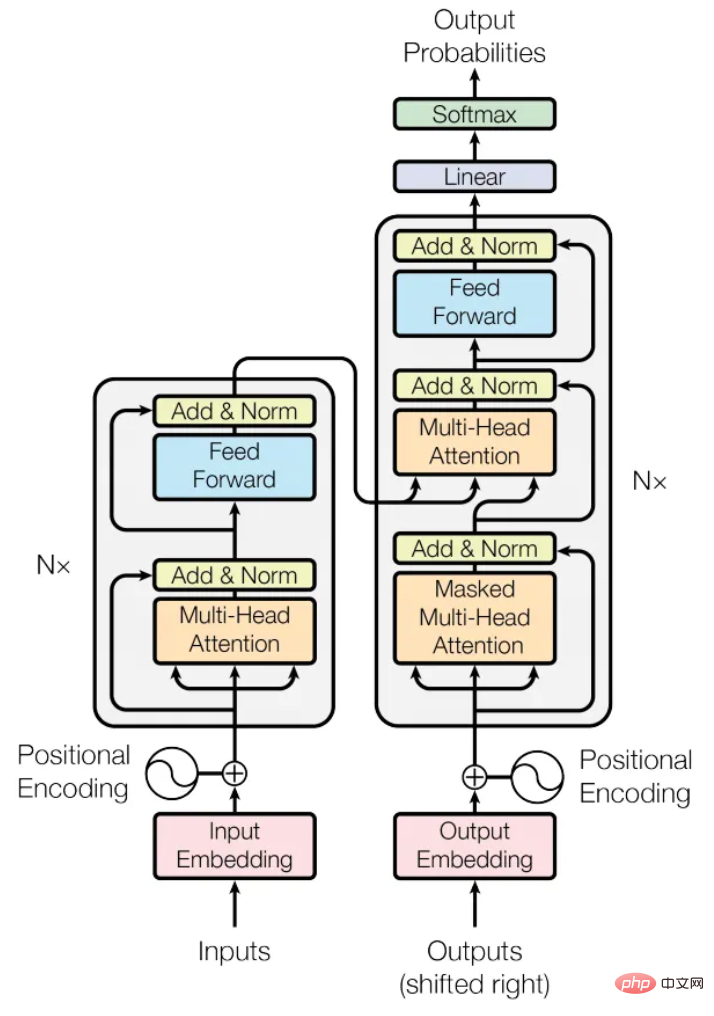

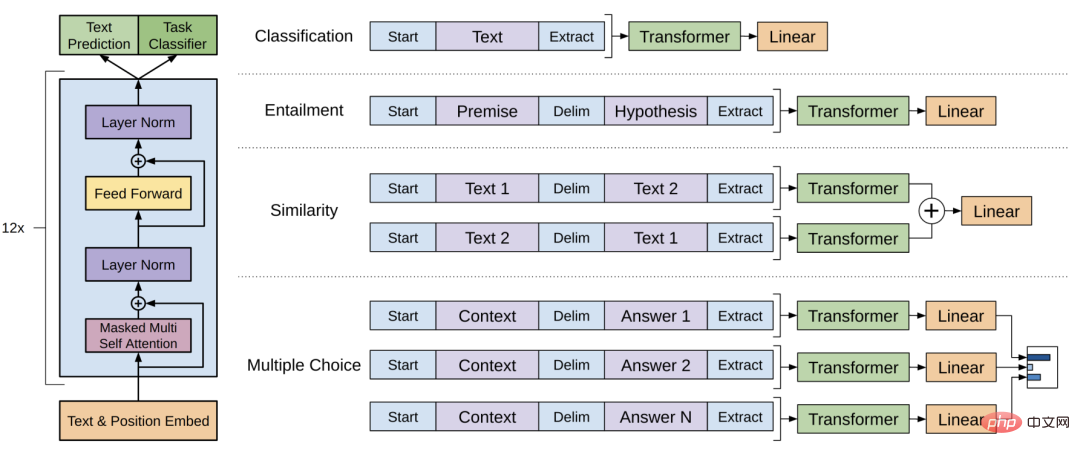

Google Brain hat 2017 im Artikel „Attention Is All You Need“ das Transformer-Modell vorgeschlagen. Dabei handelt es sich um ein Deep-Learning-Modell, das auf dem Selbstaufmerksamkeitsmechanismus basiert und hauptsächlich für RNN optimiert ist Probleme. Insbesondere das Problem der Serialisierung von Textsequenzen. Das Transformer-Modell kann alle Wörter in der Textsequenz gleichzeitig verarbeiten. Gleichzeitig beträgt der Abstand jedes Wortes in der Sequenz 1, wodurch der durch die Sequenz verursachte große Abstand vermieden wird lange im RNN-Modell. Die Einführung des Transformer-Modells kann als wichtiges Symbol für die sprunghafte Entwicklung im Bereich NLP angesehen werden, da das nachfolgende berühmte BERT-Modell und das GPT-Modell alle auf der Grundlage des Transformer-Modells entwickelt wurden. Die folgende Abbildung zeigt die Struktur des Transformer-Modells. Sowohl das ursprüngliche GPT-Modell als auch das neueste ChatGPT-Modell sind tatsächlich Sprachmodelle mit dem Transformer-Modell als Kernstruktur. GPT verwendet die Decoder-Komponente des Transformer-Modells, die sich besser für die Beantwortung der folgenden, auf den oben genannten Szenarien basierenden Szenarien eignet.

Die tatsächliche Modellstruktur von GPT-2 hat sich nicht wesentlich geändert, es handelt sich lediglich um eine einfache Anpassung. Der Hauptgrund ist, dass GPT-2 mehr Modellparameter und mehr Trainingsdaten verwendet. Sein Ziel ist es, ein Sprachmodell mit stärkerer Generalisierungsfähigkeit zu trainieren. Die sogenannte Generalisierung ist die Fähigkeit, mit Problemen umzugehen, auf die man noch nie zuvor gestoßen ist.

GPT-3

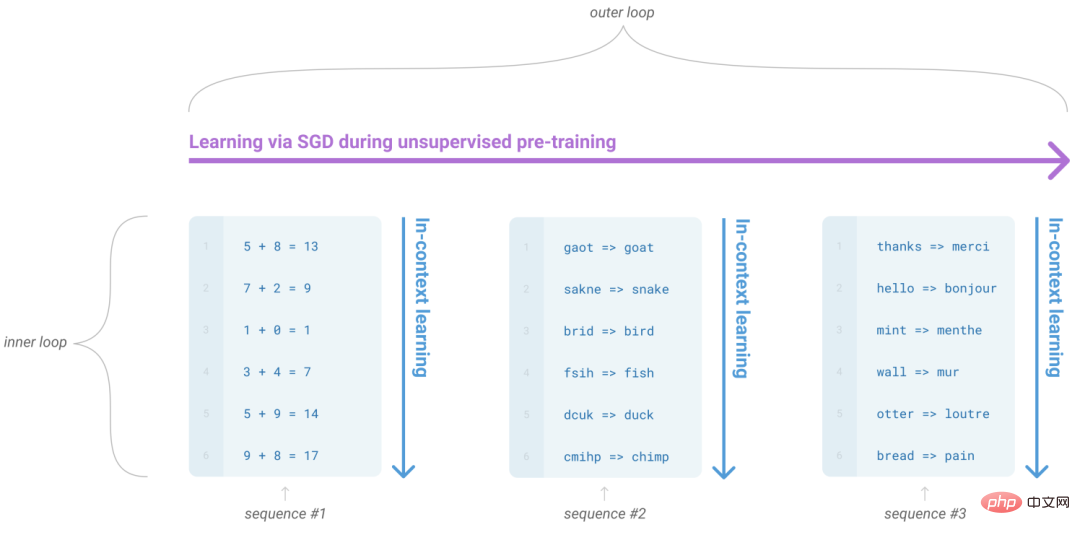

Im Jahr 2020 schlug OpenAI das GPT-3-Modell in der Arbeit „Language Models are Few-Shot Learners“ vor. Es verwendet zwei Modellparameter und eine sehr große Menge an Trainingsdaten. Es schlägt hauptsächlich die Kontextlernfähigkeit von LLM vor.

GPT-3 untersucht die Wirkung des Modells unter drei verschiedenen Eingabeformen: Zero-Shot, One-Shot und Few-Shot. Es geht hauptsächlich darum, wie man mögliche Antworten anhand bestehender Fragen vorhersagen kann. Hier finden Sie eine kurze Erläuterung der Begriffe „Zero-Shot“, „One-Shot“ und „Few-Shot“. Schuss Soll mehrere Beispiele nennen. Es wird jedoch nicht berücksichtigt, ob der Inhalt der Antwort den menschlichen Erwartungen entspricht. Dies ist auch die Hauptoptimierungsrichtung von InstructGTP im späteren Zeitraum.

Aus der folgenden Tabelle können Sie ersehen, dass die Parametergröße und die Datengröße des GPT-Trainings explosionsartig gewachsen sind. Wenn das Modell auf GPT-3 iteriert, hat die Anzahl der Parameter 100 Milliarden überschritten Daten vor dem Training Die Kapazität erreicht 45 TB, was als echtes Super-LLM-Modell bezeichnet werden kann. Die enorme Menge an Modellparametern und Vortrainingsdaten hat auch zu steigenden Trainingskosten geführt. Die Trainingskosten von GPT-3 belaufen sich auf bis zu 1.200 US-Dollar.

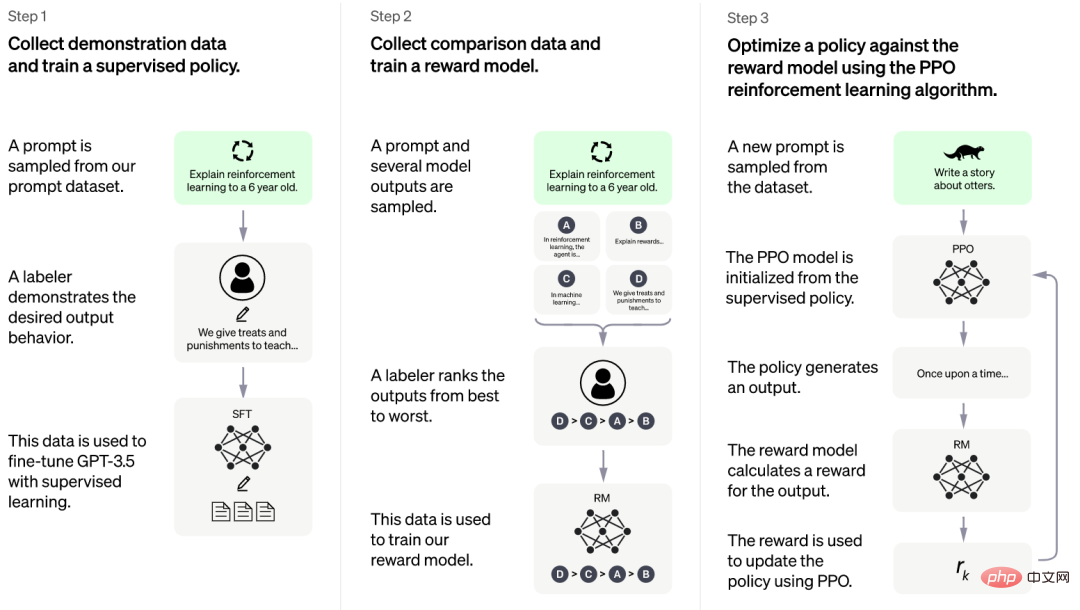

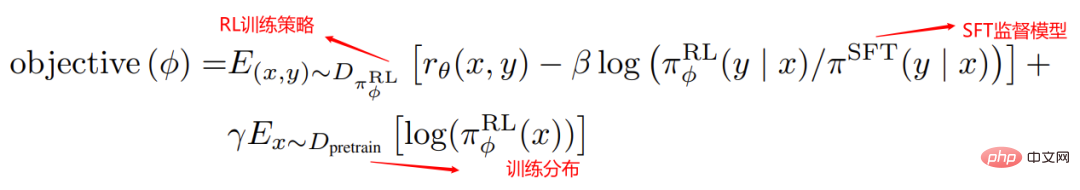

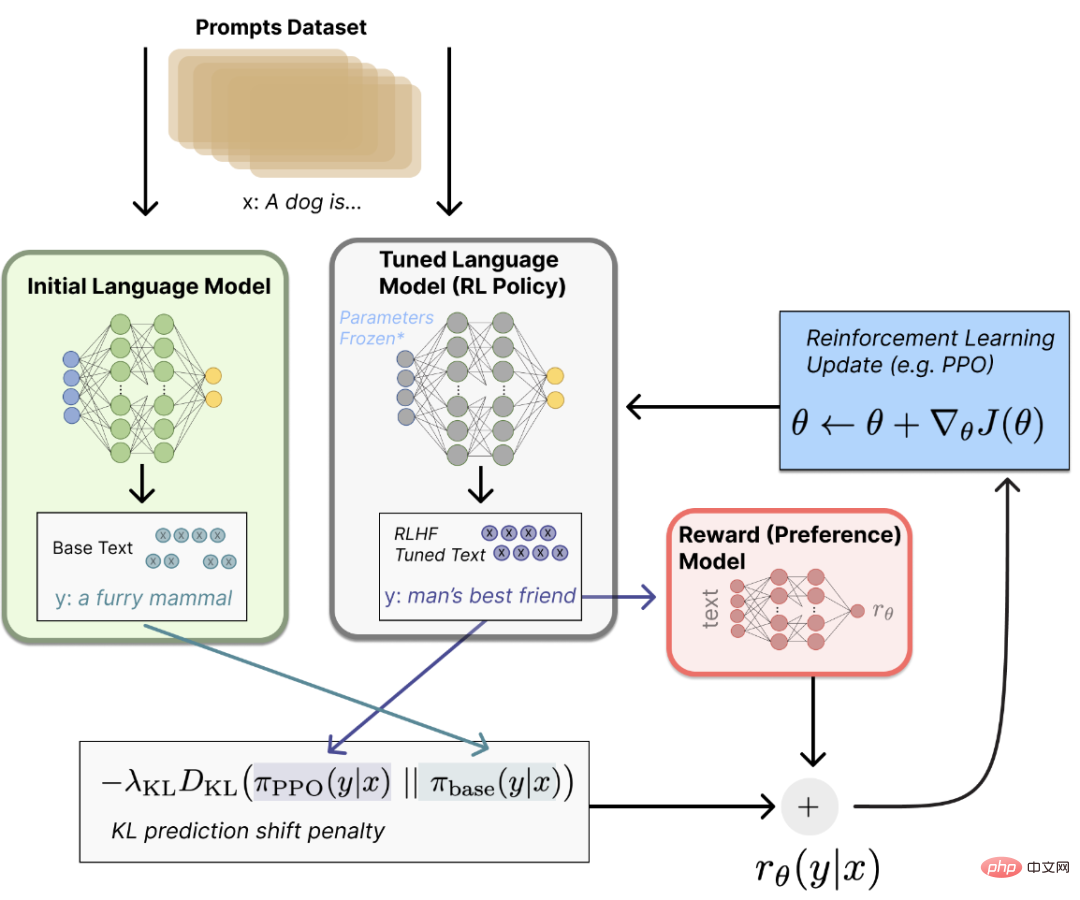

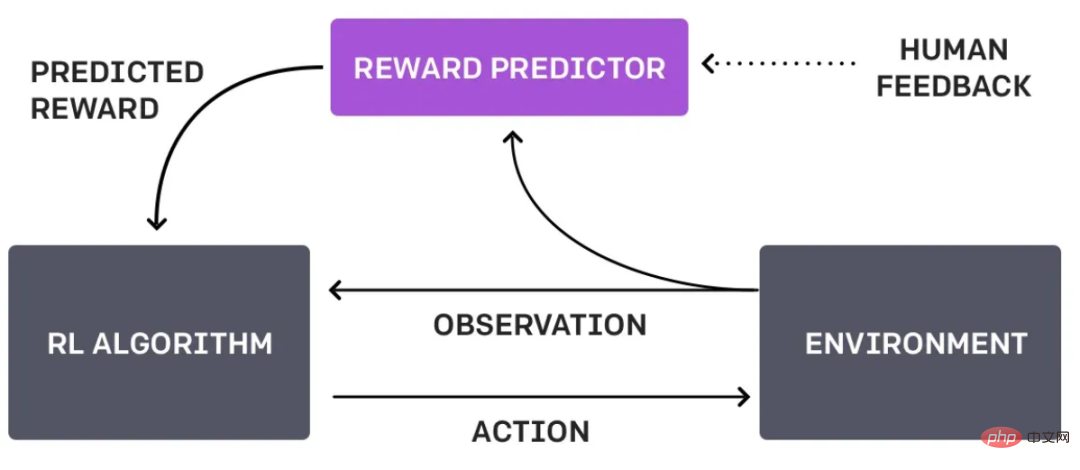

Derzeit hat OpenAI kein entsprechendes Papier zu ChatGPT veröffentlicht, aber tatsächlich ist seine Kernidee im Wesentlichen dieselbe wie das von OpenAI veröffentlichte Papier „Sprachmodelle trainieren, um Anweisungen mit menschlichem Feedback zu befolgen“. 2022. Konsequenterweise ist die wichtigste Optimierung von InstructGPT die Einführung der RLHF-Technologie (Reinforcement Learning from Human Feedback, Verstärkungslernen basierend auf menschlichem Feedback). Die Feinabstimmung des ursprünglichen Modells erfolgt dadurch, dass das Modell den Prozess des menschlichen Dialogs erlernen kann und es Menschen ermöglicht wird, die Ergebnisse der Rangfolge der Modellantworten zu kommentieren und auszuwerten, sodass das konvergierte Modell bei der Beantwortung von Fragen besser mit den menschlichen Absichten übereinstimmen kann. Darüber hinaus ist die in diesem Artikel vorgeschlagene InstructGPT-Trainingsmethode im Wesentlichen dieselbe wie ChatGPT, mit Ausnahme des geringfügigen Unterschieds in der Art und Weise, wie Daten abgerufen werden. Daher kann man sagen, dass InstructGPT ein Paar Brudermodelle ist mit ChatGPT. Schauen wir uns genauer an, wie ChatGPT trainiert wird und wie ChatGPT das Problem löst, die vom Modell beantworteten Antworten besser mit menschlichen Absichten oder Vorlieben in Einklang zu bringen. Der obige Trainingsprozess scheint etwas kompliziert zu sein, er ist in der folgenden Abbildung dargestellt. Dies soll es den Schülern erleichtern, zu verstehen, wie das ChatGPT-Modell trainiert wird . Gemäß den auf der offiziellen Website angegebenen Schritten besteht die Kernidee des Trainings darin, Feedback-Daten zu sammeln – „Trainingsbelohnungsmodell –“ PPO-Verstärkungslernen. Der ChatGPT-Trainingsprozess ist hauptsächlich in drei Phasen unterteilt: Phase 1: Feinabstimmung des GPT-3.5-Anfangsmodells durch überwachtes Lernen LM (Großes Sprachmodell, großes Sprachmodell) bedeutet nicht, dass es umso besser ist, je mehr Beispieldaten für das Training vorhanden sind. Da großsprachige Pre-Training-Modelle wie ChatGPT mit extrem großen Parametern und riesigen Datenmengen trainiert werden, sind diese riesigen Beispieldaten für Experten für künstliche Intelligenz tatsächlich transparent und unkontrollierbar. Wenn die Beispieldaten daher einige schlechte Daten wie Rassendiskriminierung und Gewalt enthalten, weist das vorab trainierte Modell möglicherweise diese schlechten Inhaltsattribute auf. Für Experten für künstliche Intelligenz muss jedoch sichergestellt werden, dass künstliche Intelligenz objektiv und fair und ohne Voreingenommenheit ist, und ChatGPT ist in diesem Aspekt geschult. PPO ist ein Vertrauensregion-Optimierungsalgorithmus, der Gradientenbeschränkungen verwendet, um sicherzustellen, dass der Aktualisierungsschritt nicht zerstört wird Stabilität des Lernprozesses. Nachdem Sie in dieser Phase mit dem Extrahieren einer Reihe von Eingabeaufforderungsdaten fortfahren, verwenden Sie das in Phase 2 erstellte Belohnungsmodell, um die Antworten des fein abgestimmten Trainingsmodells zu bewerten und die vorab trainierten Parameter zu aktualisieren. Antworten mit hoher Punktzahl werden durch das Belohnungsmodell belohnt, und der resultierende Richtliniengradient kann die Parameter des PPO-Modells aktualisieren. Iterieren Sie kontinuierlich, bis das Modell schließlich konvergiert. Es ist ersichtlich, dass der Trainingsprozess von ChatGPT tatsächlich der Prozess der Anwendung von überwachtem Lernen in Kombination mit der RLHF-Technologie ist, um eine Antwort zu generieren, die eher den menschlichen Erwartungen entspricht . Durch den oben genannten Modelltrainingsprozess sind wir zu dem Schluss gekommen, dass der Grund, warum ChatGPT über starke Kontextverständnisfähigkeiten verfügt, hauptsächlich in drei Schlüsselfähigkeiten liegt, nämlich einem leistungsstarken Grundmodell, hochwertigen Beispieldaten und verstärkendem Lernen basierend auf menschlichem Feedback. Der Kern ist die RLHF-Technologie, die mithilfe von Training die Belohnungsfunktion findet, die das menschliche Urteilsvermögen am besten erklärt, und dann kontinuierlich trainiert, um die Kognition zu stärken.

Ersetzt den manuellen Kundenservice , anstatt voreingestellte Fragen mechanisch zu beantworten, und es kann Benutzern helfen, tatsächliche Kundendienstprobleme zu lösen und die Nutzung des manuellen Kundendienstes zu maximieren auf ein Minimum. Ersetzen Sie die Inhaltserstellung Die Trainingsdaten von ChatGPT basieren auf umfangreichen Textdaten in der Internetwelt. Das aktuelle ChatGPT ist nicht in der Lage, zu unterscheiden, daher wird diese Ungenauigkeit und Voreingenommenheit bei der Beantwortung von Fragen unweigerlich zum Ausdruck kommen. Derzeit kann ChatGPT hauptsächlich Fragen und Antworten und Aufgaben in natürlicher Sprache verarbeiten, in anderen Bereichen wie Bilderkennung, Spracherkennung usw. verfügt es nicht unbedingt über eine entsprechende Verarbeitung Funktionen, aber ich glaube, dass es in naher Zukunft verfügbar sein wird. Möglicherweise wird es in Zukunft VoiceGPT und ViewGPT geben, jeder wird abwarten. ChatGPT ist ein sehr großes Deep-Learning-Modell im NPL-Bereich. Seine Trainingsparameter und Trainingsdaten sind sehr umfangreich. Wenn Sie also ChatGPT trainieren möchten, müssen Sie große Datenmengen verwenden Rechenzentren und Cloud-Computing-Ressourcen sowie eine große Menge an Rechenleistung und Speicherplatz für die Verarbeitung riesiger Trainingsdaten. Einfach ausgedrückt sind die Kosten für Schulung und Nutzung von ChatGPT immer noch sehr hoch. KI künstliche Intelligenz wird seit vielen Jahren diskutiert, befindet sich in der Entwicklungsphase und hat in einigen spezifischen Bereichen Anwendungsergebnisse erzielt. Für C-End-Benutzer gibt es jedoch grundsätzlich keine echten Anwendungsprodukte für künstliche Intelligenz, die verwendet werden können. Allerdings ist die Veröffentlichung von ChatGPT dieses Mal ein Meilenstein, denn für normale Menschen ist KI-künstliche Intelligenz kein entfernter Fachbegriff mehr, sondern ein echtes intelligentes Anwendungstool in Reichweite, mit dem normale Menschen die Kraft der KI wirklich spüren können . Darüber hinaus möchte ich sagen, dass ChatGPT derzeit nur die entsprechenden Aufgaben gemäß den Anweisungen des Menschen ausführt, aber in Zukunft kann es mit der kontinuierlichen Iteration des Selbstlernens bewusst werden Dinge autonom erledigen Zu diesem Zeitpunkt wird unklar sein, ob die Menschheit einem allmächtigen Helfer oder einem unkontrollierbaren bösen Drachen gegenübersteht. Schlüsselfunktionen von ChatGPT

Phase 3: PPO (Proximale Richtlinienoptimierung, proximale Richtlinienoptimierung) Reinforcement-Learning-Feinabstimmungsmodell

Welche Änderungen bringt ChatGPT mit sich? Die Ergebnisse zeigen, dass Suchmaschinen wie Baidu Ihnen immer einige Anzeigen schalten. Benutzer müssen unter den zurückgegebenen Informationen immer noch das finden, was sie am meisten suchen. Aber ChatGPT ist anders. Die Antwort ist die Frage und spart Benutzern viel Zeit und Energie beim Filtern ungültiger Suchergebnisse. ChatGPT kann die tatsächliche Absicht des Benutzers sehr genau erfassen. Herkömmliche Suchmaschinen verwenden jedoch immer noch Suchmethoden mit Schlüsselwörtern und verstehen nicht die wahre Bedeutung der vom Benutzer eingegebenen Suchanweisung die Eingabe des Benutzers. Darüber hinaus gibt er kreative Antworten, die den Benutzern helfen, komplizierte Arbeiten zu erledigen.

PS: Die Bing-Suchmaschine von Microsoft hat begonnen, eine Verbindung zu ChatGPT herzustellen.

die wahre Absicht des Benutzers verstehen

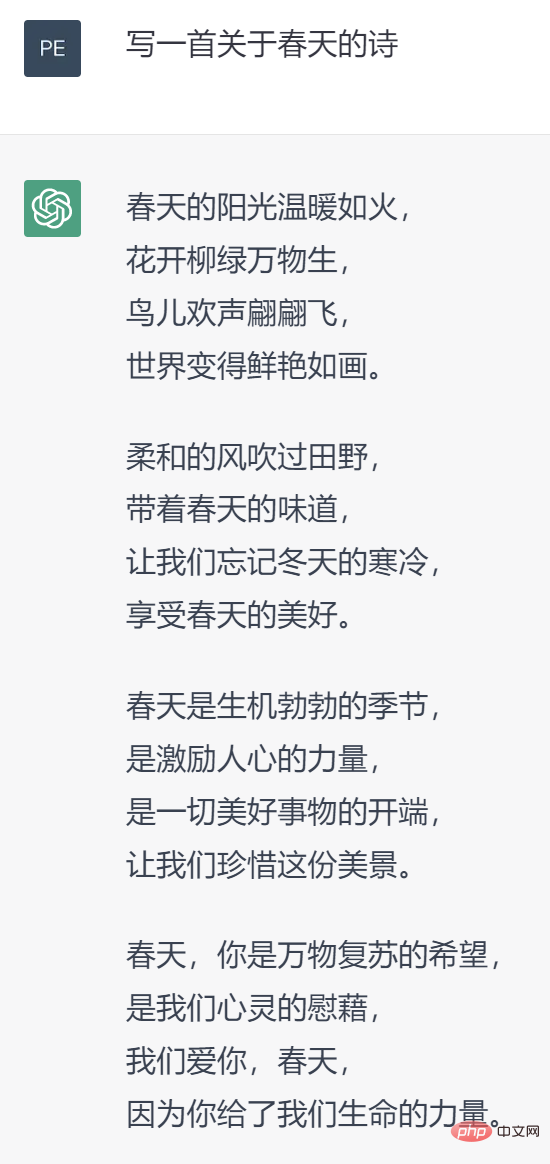

ChatGPT kann nicht nur Fragen beantworten, sondern auch die Inhaltserstellung durchführen, z. B. ein Lied schreiben, ein Gedicht schreiben, einen Veranstaltungsplan schreiben usw. Daher fühlen sich viele Studenten, die sich mit der Erstellung von Textinhalten befassen, in einer tiefen Krise. Früher dachten sie, dass Roboter zuerst die Arbeiter ersetzen sollten, aber wer hätte gedacht, dass das Aufkommen von ChatGPT die Arbeitsplätze vieler geistiger Arbeiter beseitigen würde.

ChatGPT-Einschränkungen

Trainingsdatenverzerrung

Die anwendbaren Szenarien sind begrenzt

Hohe Trainingskosten

Zusammenfassung

Das obige ist der detaillierte Inhalt vonWie großartig ist ChatGPT, das 90 % der Jobs der Menschen ersetzen kann?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

ChatGPT-Registrierung

ChatGPT-Registrierung

Inländische kostenlose ChatGPT-Enzyklopädie

Inländische kostenlose ChatGPT-Enzyklopädie

So installieren Sie ChatGPT auf einem Mobiltelefon

So installieren Sie ChatGPT auf einem Mobiltelefon

Kann Chatgpt in China verwendet werden?

Kann Chatgpt in China verwendet werden?

So lösen Sie die Ausnahme „IllegalArgument'.

So lösen Sie die Ausnahme „IllegalArgument'.

So ändern Sie Pycharm auf Chinesisch

So ändern Sie Pycharm auf Chinesisch

So importieren Sie ein altes Telefon von einem Huawei-Mobiltelefon in ein neues Telefon

So importieren Sie ein altes Telefon von einem Huawei-Mobiltelefon in ein neues Telefon

Ordner unter Linux löschen

Ordner unter Linux löschen