3D-Rekonstruktionstechnologie war schon immer ein zentrales Forschungsgebiet im Bereich Computergrafik und Computer Vision.

Einfach ausgedrückt besteht die 3D-Rekonstruktion darin, die 3D-Szenenstruktur basierend auf 2D-Bildern wiederherzustellen.

Es heißt, dass sein Gesichtsrekonstruktionsplan nach einem Autounfall von Jimmy Lin eine dreidimensionale Rekonstruktion verwendete.

Tatsächlich wird die 3D-Rekonstruktionstechnologie häufig in Spielen, Filmen, Vermessung und Kartierung, Positionierung, Navigation, autonomem Fahren, VR/AR und in der Industrie eingesetzt Herstellung und Konsumgüter. Breites Anwendungsspektrum.

Mit der Entwicklung von GPU und verteiltem Computing sowie der allmählichen Reife von Tiefenkameras wie Microsofts Kinect, ASUSs XTion und Intels RealSense in der Hardware zeigen die Kosten für die 3D-Rekonstruktion einen Abwärtstrend.

Bedienungstechnisch lässt sich der 3D-Rekonstruktionsprozess grob in fünf Schritte unterteilen.

Der erste Schritt ist die Bildaufnahme.

Da es sich bei der 3D-Rekonstruktion um den umgekehrten Vorgang einer Kamera handelt, ist es notwendig, zunächst eine Kamera zu verwenden, um ein 2D-Bild eines 3D-Objekts zu erhalten.

Dieser Schritt kann nicht ignoriert werden, da Lichtverhältnisse, geometrische Eigenschaften der Kamera usw. einen großen Einfluss auf die anschließende Bildverarbeitung haben.

Der zweite Schritt ist die Kamerakalibrierung.

In diesem Schritt werden die von der Kamera aufgenommenen Bilder verwendet, um die Objekte im Raum wiederherzustellen.

Normalerweise wird davon ausgegangen, dass zwischen dem von der Kamera aufgenommenen Bild und dem Objekt im dreidimensionalen Raum eine lineare Beziehung besteht. Der Prozess der Lösung der Parameter der linearen Beziehung wird als Kamerakalibrierung bezeichnet.

Der dritte Schritt ist die Merkmalsextraktion.

Features umfassen hauptsächlich Feature-Punkte, Feature-Linien und Flächen.

In den meisten Fällen werden Feature-Punkte als Matching-Grundelemente verwendet. Die Form, in der Feature-Punkte extrahiert werden, hängt eng mit der verwendeten Matching-Strategie zusammen.

Daher müssen Sie beim Extrahieren von Feature-Punkten zunächst bestimmen, welche Matching-Methode verwendet werden soll.

Der vierte Schritt ist das Stereo-Matching.

Stereo-Matching bezieht sich auf die Herstellung einer Korrespondenz zwischen Bildpaaren basierend auf den extrahierten Merkmalen, d.

Der fünfte Schritt, dreidimensionale Rekonstruktion.

Mit relativ genauen Matching-Ergebnissen, kombiniert mit den internen und externen Parametern der Kamerakalibrierung, können die dreidimensionalen Szeneninformationen wiederhergestellt werden.

Diese fünf Schritte sind ineinandergreifend. Nur wenn jede Verbindung mit hoher Präzision und kleinen Fehlern ausgeführt wird, kann ein relativ genaues stereoskopisches Bildverarbeitungssystem entworfen werden.

In Bezug auf den Algorithmus kann die 3D-Rekonstruktion grob in zwei Kategorien unterteilt werden. Die eine ist der 3D-Rekonstruktionsalgorithmus, der auf der traditionellen Multi-View-Geometrie basiert.

Der andere ist ein dreidimensionaler Rekonstruktionsalgorithmus, der auf Deep Learning basiert.

Aufgrund der enormen Vorteile von CNN beim Bildmerkmalsabgleich richten derzeit immer mehr Forscher ihre Aufmerksamkeit auf die dreidimensionale Rekonstruktion auf Basis von Deep Learning.

Allerdings handelt es sich bei dieser Methode meist um eine überwachte Lernmethode und sie ist stark datensatzabhängig.

Das Sammeln und Kennzeichnen von Datensätzen war schon immer eine Problemquelle für überwachtes Lernen. Daher wird die dreidimensionale Rekonstruktion auf Basis von Deep Learning hauptsächlich in Richtung der Rekonstruktion kleinerer Objekte untersucht.

Darüber hinaus weist die auf Deep Learning basierende 3D-Rekonstruktion eine hohe Wiedergabetreue und eine bessere Leistung hinsichtlich der Genauigkeit auf.

Aber das Training des Modells nimmt viel Zeit in Anspruch und 3D-Faltungsschichten für die 3D-Rekonstruktion sind sehr teuer.

Daher begannen einige Forscher, die traditionelle dreidimensionale Rekonstruktionsmethode erneut zu untersuchen.

Obwohl die traditionelle dreidimensionale Rekonstruktionsmethode Leistungsmängel aufweist, ist die Technologie relativ ausgereift.

Dann kann eine gewisse Integration der beiden Methoden zu besseren Ergebnissen führen.

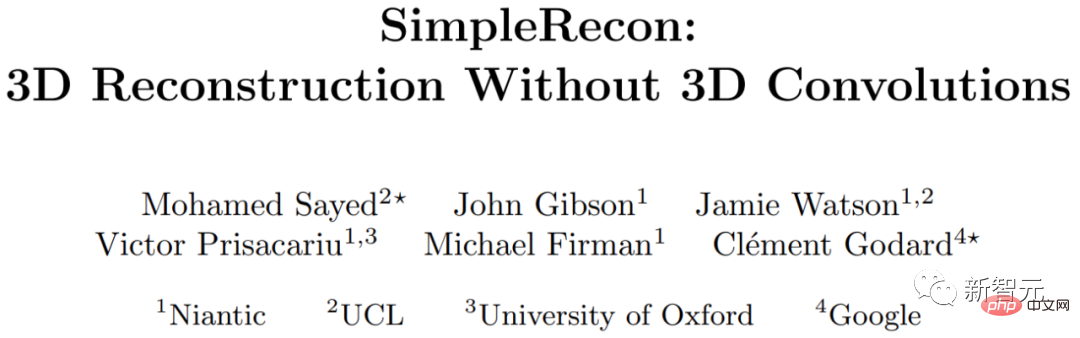

Forscher von Institutionen wie der University of London, der Oxford University, Google und Niantic (einem aus Google hervorgegangenen Unicorn-Unternehmen, das sich mit AR beschäftigt), erforschen eine 3D-Rekonstruktionsmethode ohne 3D-Faltung.

Sie schlagen einen einfachen, hochmodernen Multi-View-Tiefenschätzer vor.

Dieser Multi-View-Tiefenschätzer weist zwei Durchbrüche auf.

Erstens kann ein gut gestaltetes 2D-CNN leistungsstarke Bildprioritäten nutzen und Ebenenscan-Merkmalsmengen und geometrische Verluste ermitteln.

Zweitens kann es Schlüsselbilder und geometrische Metadaten in das Kostenvolumen integrieren und so informierte Informationen ermöglichen Tiefenebenenbewertung.

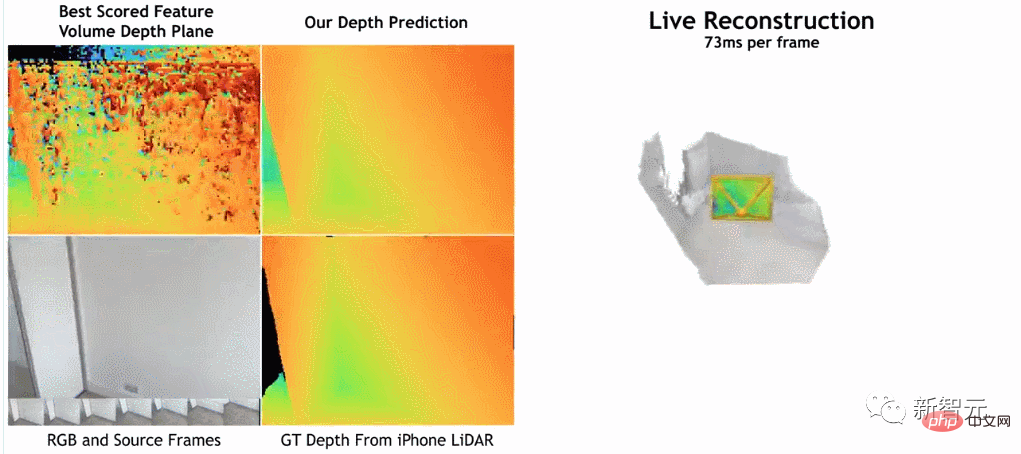

Nach Angaben der Forscher hat ihre Methode in der Tiefenschätzung einen klaren Vorsprung gegenüber den aktuellen State-of-the-Art-Methoden.

und eignet sich gut oder besser für die 3D-Rekonstruktion auf ScanNet und 7-Scenes, ermöglicht aber dennoch eine Online-Rekonstruktion in Echtzeit mit geringem Speicherbedarf.

Darüber hinaus ist die Rekonstruktionsgeschwindigkeit sehr hoch und dauert nur etwa 73 ms pro Frame.

Die Forscher glauben, dass dadurch eine genaue Rekonstruktion durch schnelle Tiefenfusion möglich ist.

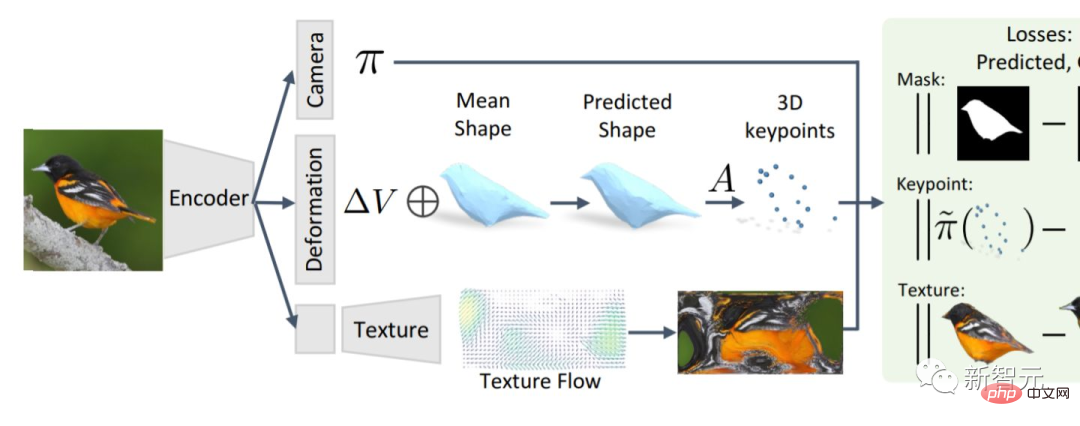

Nach Angaben der Forscher besteht ihre Methode darin, mithilfe eines Bildcodierers übereinstimmende Merkmale aus dem Referenzbild und dem Quellbild zu extrahieren, diese dann in das Kostenvolumen einzugeben und anschließend eine 2D-Faltung zu verwenden Encoder/Decoder-Netzwerk Verarbeiten Sie die Ausgabeergebnisse des Kostenvolumens.

Diese Recherche wurde mit PyTorch implementiert und ResNet18 für die Matching-Feature-Extraktion verwendet. Außerdem wurden zwei 40-GB-A100-GPUs verwendet. Die gesamte Arbeit dauerte 36 Stunden.

Obwohl das Modell keine 3D-Faltungsschichten verwendet, übertrifft es das Basismodell hinsichtlich der Tiefenvorhersageindikatoren.

Dies zeigt, dass ein gut konzipiertes und trainiertes 2D-Netzwerk für eine qualitativ hochwertige Tiefenschätzung ausreicht.

Interessierte Leser können den Originaltext des Papiers lesen:

https://nianticlabs.github.io/simplerecon/resources/SimpleRecon.pdf

Allerdings muss es so sein Ich möchte Sie daran erinnern, dass es für die Lektüre dieses Artikels eine berufliche Hürde gibt und einige Details möglicherweise nicht leicht zu erkennen sind.

Wir könnten genauso gut einen Blick darauf werfen, was ausländische Internetnutzer aus diesem Artikel herausgefunden haben.

Ein Internetnutzer namens „stickshiftplease“ sagte: „Obwohl die Inferenzzeit beim A100 etwa 70 Millisekunden beträgt, kann diese durch verschiedene Techniken verkürzt werden, und der Speicherbedarf muss nicht 40 GB betragen, das kleinste Modell läuft mit 2,6 GB.“ Erinnerung".

Ein anderer Internetnutzer namens „IrreverentHippie“ wies darauf hin: „Bitte beachten Sie, dass diese Studie immer noch auf der LiDAR-Tiefensensor-Probenahme basiert. Aus diesem Grund erreicht diese Methode eine so gute Qualität und Genauigkeit.“

Es gibt auch einen relativ langen Kommentar von einem Internetnutzer namens „nickthorpie“. Er sagte: „Die Vor- und Nachteile von ToF-Kameras sind gut dokumentiert. ToF löst verschiedene Probleme, die die Rohbildverarbeitung plagen. Darunter sind die beiden Hauptprobleme Skalierbarkeit und Details wie Tischkanten oder dünne Stangen sind mit ToF immer schwer zu erkennen.

Darüber hinaus ist ToF ein aktiver Sensor B. an einer überfüllten Kreuzung oder in einem selbstgebauten Lagerhaus, lässt die Bildqualität schnell nach.

Je mehr Daten Sie in einer Szene sammeln, desto schlechter ist natürlich die von Ihnen erstellte Beschreibung Studieren Sie rohe Bilddaten, weil es flexibler ist.

Das obige ist der detaillierte Inhalt vonDie 3D-Rekonstruktion von Jimmy Lins Gesicht kann mit zwei A100 und einem 2D-CNN erreicht werden!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!