Das Human-Machine Intelligence Fusion Laboratory (HCP) der Sun Yat-sen University hat fruchtbare Erfolge in AIGC und multimodalen Großmodellen erzielt. Es wurde für mehr als zehn Arbeiten im aktuellen AAAI 2023 und CVPR 2023 ausgewählt die ersten Ebenen globaler Forschungseinrichtungen.

Eine der Arbeiten implementierte den Einsatz von Kausalmodellen, um die Steuerbarkeit und Generalisierung multimodaler großer Modelle beim Tuning deutlich zu verbessern – „Masked Images Are Counterfactual Samples for Robust Fine-tuning“.

Link: https://arxiv.org/abs/2303.03052

Die Verwendung vorab trainierter Großmodelle zur Feinabstimmung nachgelagerter Aufgaben ist derzeit ein beliebtes Deep-Learning-Paradigma . Insbesondere die jüngste herausragende Leistung von ChatGPT, einem großen vorab trainierten Sprachmodell, hat diesem technischen Paradigma weithin Anerkennung verschafft. Nach dem Vortraining mit umfangreichen Daten können sich diese großen vorab trainierten Modelle an die sich ändernde Datenverteilung in der realen Umgebung anpassen und zeigen daher in allgemeinen Szenarien eine hohe Robustheit.

Wenn jedoch das vorab trainierte große Modell mit nachgelagerten Szenendaten verfeinert wird, um es an bestimmte Anwendungsaufgaben anzupassen, sind diese Daten in den allermeisten Fällen singulär. Die Verwendung dieser Daten zur Feinabstimmung des vorab trainierten großen Modells verringert häufig die Robustheit des Modells, was die Anwendung auf der Grundlage des vorab trainierten großen Modells erschwert. Insbesondere im Hinblick auf visuelle Modelle ist das Problem des nachgelagerten Feinabstimmungstrainings, das zu einer Verringerung der Robustheit visueller vorab trainierter großer Modelle führt, besonders ausgeprägt, da die Vielfalt der Bilder die der Sprache bei weitem übersteigt.

Frühere Forschungsmethoden bewahren die Robustheit des fein abgestimmten vorab trainierten Modells normalerweise implizit auf der Ebene der Modellparameter durch Modellintegration und andere Methoden. In diesen Arbeiten wurden jedoch weder die wesentlichen Gründe analysiert, warum die Feinabstimmung zu einer Leistungsverschlechterung des Modells außerhalb der Verteilung führt, noch wurde das oben erwähnte Problem der verringerten Robustheit nach der Feinabstimmung großer Modelle klar gelöst.

Diese Arbeit basiert auf dem modalübergreifenden großen Modell und analysiert die wesentlichen Gründe für den Robustheitsverlust des vorab trainierten großen Modells aus der Perspektive der Kausalität und schlägt dementsprechend eine Methode vor, mit der die Robustheit erheblich verbessert werden kann Optimieren Sie Ihre Trainingsmethoden. Diese Methode ermöglicht es dem Modell, eine hohe Robustheit beizubehalten, während es sich an nachgelagerte Aufgaben anpasst, und erfüllt die Anforderungen praktischer Anwendungen besser.

Nehmen Sie als Beispiel das große modalübergreifende Vortrainingsmodell CLIP (Contrastive Language–Image Pre-Training), das 2021 von OpenAI veröffentlicht wurde: CLIP ist ein großes modalübergreifendes Vortrainingsmodell, das auf kontrastivem Bildtext basiert Das gemeinsame Lernen ist die Grundlage generativer Modelle wie Stable Diffusion. Das Modell wird auf umfangreichen Multi-Source-Daten mit etwa 400 Millionen Bild-Text-Paaren trainiert und lernt einige kausale Zusammenhänge, die bis zu einem gewissen Grad robust gegenüber Verteilungsänderungen sind.

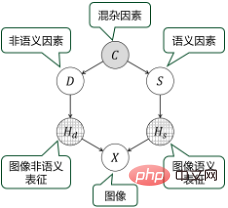

Bei der Feinabstimmung von CLIP mit Single-Feature-Downstream-Daten ist es jedoch leicht, dieses vom Modell erlernte kausale Wissen zu zerstören, da die nicht-semantische Darstellung und die semantische Darstellung des Trainingsbildes stark miteinander verflochten sind. Wenn man beispielsweise die CLIP-Modellübertragung auf das Downstream-Szenario „Bauernhof“ anwendet, zeigen viele der Trainingsbilder „Kühe“ im Gras. An diesem Punkt kann das Feinabstimmungstraining es dem Modell ermöglichen, zu lernen, sich auf die semantische Nicht-„Kuh“-Darstellung von Gras zu verlassen, um die Semantik des Bildes vorherzusagen. Dieser Zusammenhang stimmt jedoch nicht unbedingt, es können beispielsweise auch „Kühe“ auf der Straße auftauchen. Nachdem das Modell fein abgestimmt und trainiert wurde, verringert sich daher seine Robustheit, und die Ausgabeergebnisse während der Anwendung können extrem instabil werden und es fehlt ihnen an Kontrollierbarkeit.

Basierend auf der jahrelangen Erfahrung des Teams beim Aufbau und Training großer Modelle untersucht diese Arbeit das Problem der verringerten Robustheit, die durch die Feinabstimmung vorab trainierter Modelle verursacht wird, aus der Perspektive der Kausalität erneut. Basierend auf der kausalen Modellierung und Analyse schlägt diese Arbeit eine Trainingsmethode zur Feinabstimmung vor, die kontrafaktische Stichproben auf der Grundlage von Bildmasken erstellt und die Robustheit des Modells durch Lernen von Maskenbildern verbessert.

Um die falsche Korrelation in den nachgelagerten Trainingsbildern aufzubrechen, schlägt diese Arbeit insbesondere eine auf einer Klassenaktivierungskarte (CAM) basierende Methode vor, um den Inhalt bestimmter Bereiche des Bildes zu maskieren und zu ersetzen, um das Nichtsemantische zu manipulieren Die Bedeutung des Bildes erzeugt kontrafaktische Beispiele. Das fein abgestimmte Modell kann lernen, die Darstellung dieser kontrafaktischen Stichproben durch das vorab trainierte Modell durch Destillation zu imitieren, wodurch der Einfluss semantischer Faktoren und nicht-semantischer Faktoren besser entkoppelt und die Anpassungsfähigkeit an Verteilungsverschiebungen in nachgelagerten Feldern verbessert wird.

Experimente zeigen, dass diese Methode die Leistung vorab trainierter Modelle in nachgelagerten Aufgaben erheblich verbessern kann und gleichzeitig erhebliche Vorteile bei der Verbesserung der Robustheit im Vergleich zu bestehenden Trainingsmethoden zur Feinabstimmung großer Modelle bietet.

Die wichtige Bedeutung dieser Arbeit besteht darin, dass sie bis zu einem gewissen Grad die „Black Box“ öffnet, die vorab trainierte große Modelle vom Deep-Learning-Paradigma erben, und die Probleme der „Interpretierbarkeit“ und „Steuerbarkeit“ löst Große Modelle bringen uns den spürbaren Produktivitätssteigerungen näher, die durch vorab trainierte große Modelle erzielt werden.

Das HCP-Team der Sun Yat-sen-Universität beschäftigt sich seit der Einführung des Transformer-Mechanismus seit vielen Jahren mit der Erforschung großer Modelltechnologieparadigmen. Es hat sich zum Ziel gesetzt, die Trainingseffizienz großer Modelle zu verbessern und kausale Modelle einzuführen Lösen Sie das „Steuerbarkeitsproblem“ großer Modelle. Im Laufe der Jahre hat das Team unabhängig voneinander mehrere große Pre-Training-Modelle für Vision, Sprache, Sprache und Cross-Modalität erforscht und entwickelt. Das modalübergreifende große Modell „Wukong“ wurde gemeinsam mit dem Noah's Ark Laboratory von Huawei entwickelt (Link: https:/ /arxiv.org/abs/2202.06767) ist ein typischer Fall.

Teamvorstellung

Das Human-Computer Intelligence Convergence Laboratory (HCP Lab) der Sun Yat-sen University beschäftigt sich mit multimodalem kognitivem Computing, Robotik und eingebetteten Systemen, Metaversum und digitalen Menschen, kontrollierbarer Inhaltsgenerierung, usw. Führen Sie systematische Forschung auf diesem Gebiet durch, erstellen Sie Produktprototypen, detaillierte Anwendungsszenarien, exportieren Sie eine große Anzahl Originaltechnologien und bilden Sie unternehmerische Teams. Das Labor wurde 2010 von Professor Lin Liang, IAPR Fellow, gegründet. Es hat den ersten Preis des Science and Technology Award der China Image and Graphics Society, den Wu Wenjun Natural Science Award, den ersten Preis der Provinz-Naturwissenschaften und andere Auszeichnungen gewonnen. Es hat junge Talente auf nationaler Ebene wie Liang Xiaodan und Wang Keze ausgebildet.

Das obige ist der detaillierte Inhalt vonNeuer Durchbruch im HCP-Labor der Sun Yat-sen-Universität: Verwendung eines Kausalparadigmas zur Verbesserung multimodaler großer Modelle. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Detaillierte Erklärung des Nohup-Befehls

Detaillierte Erklärung des Nohup-Befehls

So kaufen und verkaufen Sie Bitcoin auf Okex

So kaufen und verkaufen Sie Bitcoin auf Okex

Gründe, warum phpstudy nicht geöffnet werden kann

Gründe, warum phpstudy nicht geöffnet werden kann

Verwendung der URL-Code-Funktion

Verwendung der URL-Code-Funktion

Wie viel entspricht Dimensity 9000 Snapdragon?

Wie viel entspricht Dimensity 9000 Snapdragon?

So richten Sie Douyin ein, um zu verhindern, dass jeder das Werk sieht

So richten Sie Douyin ein, um zu verhindern, dass jeder das Werk sieht

SQL in der Operator-Nutzung

SQL in der Operator-Nutzung

Welche Größe hat A5-Papier?

Welche Größe hat A5-Papier?