Das Erstellen von 3D-Inhalten basierend auf gegebenen Eingaben (z. B. basierend auf Textaufforderungen, Bildern oder 3D-Formen) hat wichtige Anwendungen in den Bereichen Computer Vision und Grafik. Dieses Problem stellt jedoch eine Herausforderung dar, da professionelle Künstler (technische Künstler) in der Regel viel Zeit und Kosten für die Erstellung von 3D-Inhalten aufwenden müssen. Gleichzeitig handelt es sich bei den Ressourcen in vielen Online-3D-Modellbibliotheken in der Regel um reine 3D-Modelle ohne Materialien. Wenn Sie sie auf die aktuelle Rendering-Engine anwenden möchten, benötigen Sie einen technischen Künstler, der hochwertige Materialien, Lichter und Normalkarten erstellt für sie. Daher wäre es vielversprechend, wenn es eine Möglichkeit gäbe, eine automatisierte, vielfältige und realistische 3D-Modell-Asset-Generierung zu erreichen.

Daher haben Forschungsteams der South China University of Technology, der Hong Kong Polytechnic University, des Interdimensional Intelligence, des Pengcheng Laboratory und anderer Institutionen eine textgesteuerte 3D-Modellstilisierungsmethode vorgeschlagen – TANGO, die für bestimmte Zwecke nützlich ist Mit 3D-Modellen und Text kann es automatisch realistischere SVBRDF-Materialien, Normalkarten und Lichter generieren und weist eine bessere Robustheit gegenüber 3D-Modellen geringer Qualität auf. Diese Studie wurde in NeurIPS 2022 aufgenommen.

Projekthomepage: https://cyw-3d.github.io/tango/

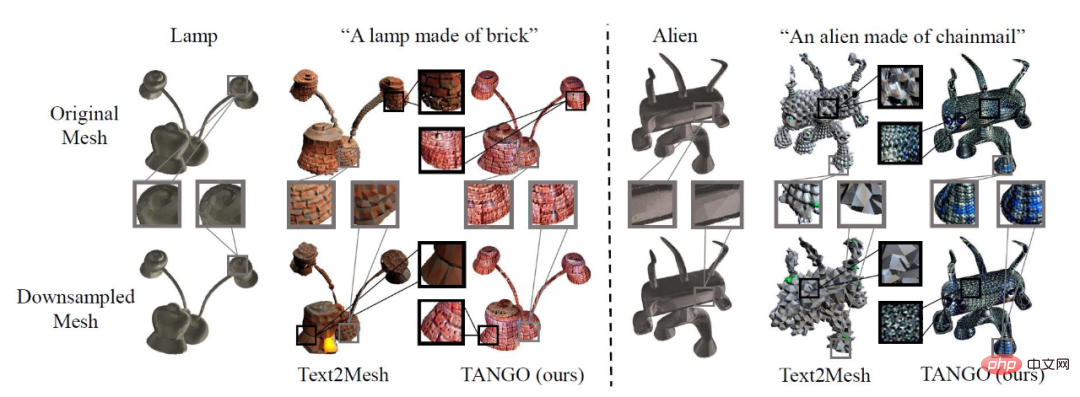

Für eine gegebene Texteingabe und ein dreidimensionales Modell kann TANGO mehr erzeugen verfeinert Es verfügt über hohe fotorealistische Details und erzeugt keine Selbstüberschneidungsprobleme auf der Oberfläche des 3D-Modells. Wie in Abbildung 1 unten dargestellt, stellt TANGO nicht nur realistische Reflexionseffekte auf glatten Materialien (wie Gold, Silber usw.) dar, sondern kann auch Punkt-für-Punkt-Normalen für unebene Materialien (wie Ziegel usw.) schätzen ein holpriger Effekt. Abbildung 1: Stilisierte Ergebnisse von TANGO Zerlegen Sie sie und lernen Sie sie separat. Schließlich werden diese aufgeteilten Teile über den sphärischen Gaußschen differenzierbaren Renderer ausgegeben und an CLIP gesendet, um den Verlust mit dem Eingabetext zu berechnen. Um die Gründe für die Entkopplung von Komponenten zu demonstrieren, wurde in der Studie jede Komponente visualisiert. Abbildung 2 (a) zeigt das stilisierte Ergebnis von „einem Paar Schuhe aus Ziegeln“, (b) zeigt die ursprüngliche Normalenrichtung des 3D-Modells, (c) ist die von TANGO für jeden Punkt im 3D-Modell vorhergesagte Normalenrichtung , (d) (e) (f) stellen die diffusen Reflexions-, Rauheits- und Spiegelreflexionsparameter in SVBRDF dar, (g) ist das Umgebungslicht, ausgedrückt durch die von TANGO vorhergesagte sphärische Gaußsche Funktion.

Abbildung 2 Visualisierung entkoppelter Rendering-Komponenten

Gleichzeitig kann diese Forschung auch die von TAGO ausgegebenen Ergebnisse bearbeiten. In Abbildung 3 kann die Forschung beispielsweise andere Lichtkarten verwenden, um die TANGO-Ergebnisse erneut zu beleuchten. In Abbildung 4 können die Parameter für Rauheit und Spiegelreflexion bearbeitet werden, um den Reflexionsgrad auf der Objektoberfläche zu ändern.

...Da TANGO außerdem vorhergesagte Normalkarten verwendet, um Objektoberflächendetails hinzuzufügen, ist es auch sehr robust gegenüber dreidimensionalen Modellen mit einer kleinen Anzahl von Eckpunkten. Wie in Abbildung 5 dargestellt, hatten die ursprünglichen Lampen- und Alien-Modelle 41160 bzw. 68430 Gesichter. Die Forscher führten ein Downsampling der ursprünglichen Modelle durch und erhielten ein Modell mit nur 5000 Gesichtern. Es ist ersichtlich, dass die Leistung von TANGO beim Originalmodell und beim Downsampling-Modell grundsätzlich ähnlich ist, während Text2Mesh beim Modell mit geringer Qualität ein schwerwiegendes Selbstüberschneidungsphänomen aufweist.

Abbildung 5 Robustheitstest

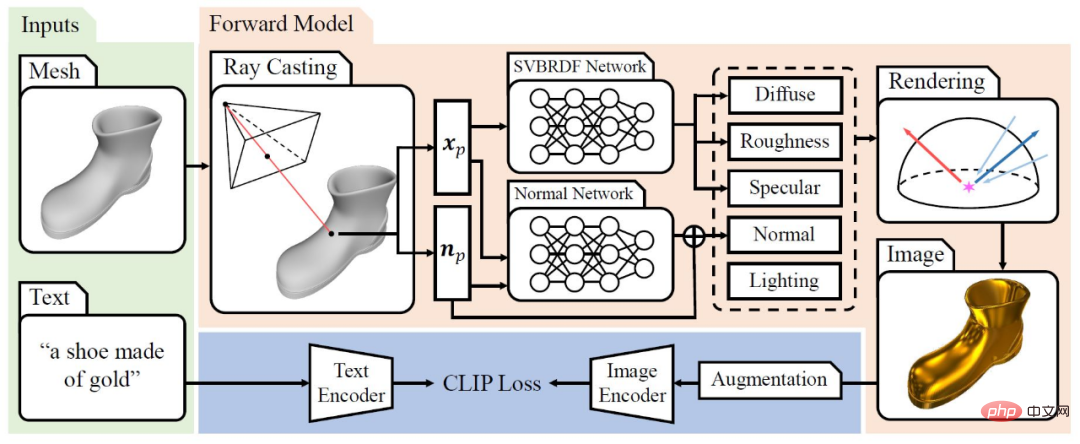

TANGO konzentriert sich hauptsächlich auf die Methode der textgesteuerten Stilisierung dreidimensionaler Objekte. Die relevanteste aktuelle Arbeit in diesem Bereich ist Text2Mesh, das das vorab trainierte Modell CLIP als Leitfaden verwendet, um den Farb- und Positionsversatz von Oberflächenscheitelpunkten eines 3D-Modells vorherzusagen und so eine Stilisierung zu erreichen. Allerdings führt die bloße Vorhersage von Oberflächenscheitelpunktfarben häufig zu unrealistischen Rendering-Effekten, und unregelmäßige Scheitelpunktversätze können zu schwerwiegenden Selbstüberschneidungen führen. Daher stützt sich diese Forschung auf die traditionelle physikalisch basierte Rendering-Pipeline, um den gesamten Rendering-Prozess in den Vorhersageprozess von SVBRDF-Materialien, Normalkarten und Lichtern zu entkoppeln und die entkoppelten Elemente jeweils mit sphärischen Gaußschen Funktionen auszudrücken. Diese physikbasierte Entkopplungsmethode ermöglicht es TANGO, realistische Rendering-Effekte korrekt zu erzeugen und weist eine gute Robustheit auf.

Abbildung 6 TANGO-Flussdiagramm

Abbildung 6 zeigt den Arbeitsablauf von TANGO. Bei einem gegebenen 3D-Modell und Text (z. B. „ein Schuh aus Gold“ im Bild) skaliert die Studie zunächst das 3D-Modell auf eine Einheitskugel und tastet dann die Kameraposition in der Nähe des 3D-Modells ab Ray findet den Schnittpunkt xp mit dem dreidimensionalen Modell und die Normalenrichtung des Schnittpunkts np. Als nächstes werden xp und np an das SVBRDF-Netzwerk und das Normalnetzwerk gesendet, um die Materialparameter und die Normalrichtung des Punktes vorherzusagen. Gleichzeitig werden mehrere sphärische Gaußsche Funktionen zum Ausdruck verwendet die Szene des Lichts. Für jede Trainingsiteration rendert die Studie das Bild mit einem differenzierbaren sphärischen Gaußschen Renderer, kodiert dann das erweiterte Bild mit dem Bildkodierer des CLIP-Modells und schließlich propagiert das CLIP-Modell Gradienten zurück, um alle lernbaren Parameter zu aktualisieren.

In diesem Artikel wird TANGO vorgeschlagen, eine neue Methode, die realistische Darstellungsstile für 3D-Modelle basierend auf Eingabetext generiert und robust gegenüber Modellen geringer Qualität ist. Indem wir den Erscheinungsstil von SVBRDF, lokalen geometrischen Änderungen (Punktnormalen) und Lichtbedingungen entkoppeln und diese als sphärische Gaußsche Funktionen darstellen und rendern, können wir CLIP zur Verlustüberwachung und zum Lernen verwenden.

Im Vergleich zu bestehenden Methoden kann TANGO selbst für 3D-Modelle geringer Qualität sehr robust sein. Die Methode, geometrische Details in Punkt-für-Punkt-Normalrichtung bereitzustellen und gleichzeitig Selbstüberschneidungen zu vermeiden, verringert jedoch auch geringfügig den Grad der Konkavität und Konvexität der Materialoberfläche, die in dieser Studie ausgedrückt werden kann, da TANGO und Text2Mesh auf Scheitelpunkten basieren Der Offset wird in die jeweilige Richtung durchgeführt. Dies ist ein guter erster Versuch und wird weitere Folgeforschung anregen.

Das obige ist der detaillierte Inhalt vonIn einem Satz kann das 3D-Modell ein realistisches Erscheinungsbild bis hin zu Details auf Fotoebene erzeugen.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Eine Sammlung häufig verwendeter Computerbefehle

Eine Sammlung häufig verwendeter Computerbefehle

Win10 stellt eine Verbindung zum freigegebenen Drucker her

Win10 stellt eine Verbindung zum freigegebenen Drucker her

So werden Sie auf TikTok ein enger Freund

So werden Sie auf TikTok ein enger Freund

Kostenlose Datenwiederherstellungssoftware

Kostenlose Datenwiederherstellungssoftware

Welche Funktionen gibt es zum Erstellen von Websites?

Welche Funktionen gibt es zum Erstellen von Websites?

Wie man negative Zahlen binär darstellt

Wie man negative Zahlen binär darstellt

Python konfiguriert Umgebungsvariablen

Python konfiguriert Umgebungsvariablen

So öffnen Sie die WeChat-HTML-Datei

So öffnen Sie die WeChat-HTML-Datei