Bilderzeugung ist eine der heißesten Richtungen im aktuellen AIGC-Bereich. Kürzlich veröffentlichte Bilderzeugungsmodelle wie DALL・E 2, Imagen, Stable Diffusion usw. haben eine neue Ära der Bilderzeugung eingeläutet und ein beispielloses Maß an Bildqualität und Modellflexibilität erreicht. Das Diffusionsmodell ist derzeit auch das vorherrschende Paradigma. Diffusionsmodelle basieren jedoch auf iterativer Inferenz, was ein zweischneidiges Schwert ist, da iterative Methoden ein stabiles Training mit einfachen Zielen erreichen können, der Inferenzprozess jedoch hohe Rechenkosten erfordert.

Vor Diffusionsmodellen waren generative kontradiktorische Netzwerke (GANs) eine häufig verwendete Infrastruktur in Bilderzeugungsmodellen. Im Vergleich zu Diffusionsmodellen erzeugen GANs Bilder durch einen einzigen Vorwärtsdurchlauf und sind daher von Natur aus effizienter. Die Skalierung von GANs erfordert jedoch aufgrund der Instabilität des Trainingsprozesses eine sorgfältige Abstimmung der Netzwerkarchitektur und der Trainingsfaktoren. Daher eignen sich GANs gut für die Modellierung einzelner oder mehrerer Objektklassen, ihre Skalierung auf komplexe Datensätze (geschweige denn auf die reale Welt) ist jedoch äußerst schwierig. Infolgedessen sind jetzt sehr große Modell-, Daten- und Rechenressourcen für Diffusions- und autoregressive Modelle vorgesehen.

Aber als effiziente Generierungsmethode haben viele Forscher die GAN-Methode nicht vollständig aufgegeben. Beispielsweise hat NVIDIA kürzlich das StyleGAN-T-Modell vorgeschlagen; Hong Kong Chinese und andere verwendeten GAN-basierte Methoden, um reibungslose Videos zu generieren. Dies sind weitere Versuche von CV-Forschern zu GAN.

In einem CVPR 2023-Artikel untersuchten Forscher von POSTECH, der Carnegie Mellon University und dem Adobe Research Institute gemeinsam mehrere wichtige Fragen zu GAN, darunter:

Es ist erwähnenswert, dass Zhu Junyan, der Hauptautor von CycleGAN und Gewinner des ACM SIGGRAPH Best Doctoral Thesis Award 2018, der zweite Autor dieses CVPR-Artikels ist.

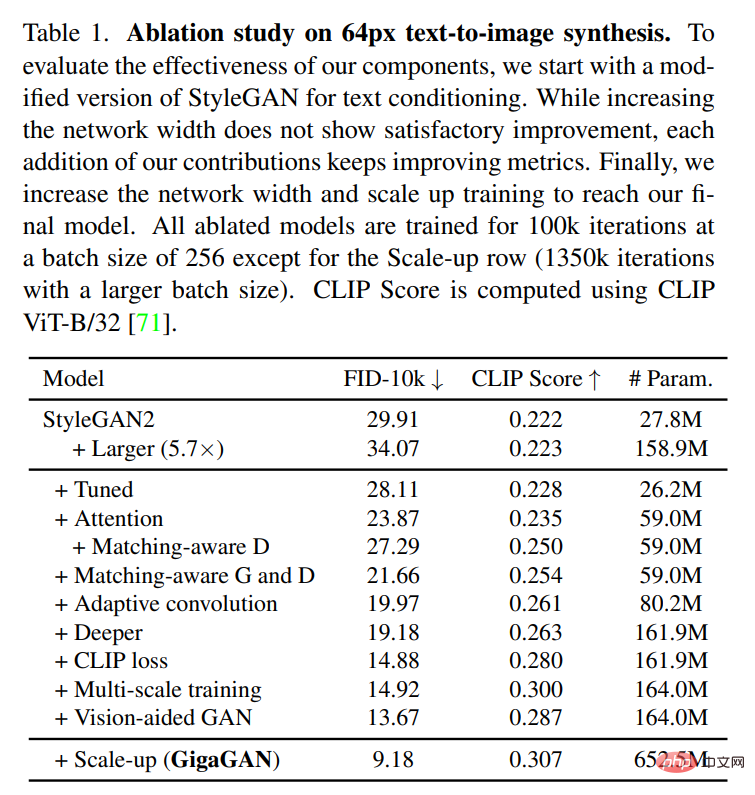

Die Studie führte zunächst Experimente mit StyleGAN2 durch und stellte fest, dass die einfache Erweiterung des Backbone-Netzwerks zu einem instabilen Training führte. Auf dieser Grundlage identifizierten die Forscher mehrere Schlüsselprobleme und schlugen eine Technik zur Stabilisierung des Trainings bei gleichzeitiger Erhöhung der Modellkapazität vor.

Erstens erweitert diese Studie effektiv die Kapazität des Generators, indem eine Reihe von Filtern beibehalten und probenspezifische Linearkombinationen verwendet werden. Die Studie übernahm auch mehrere Techniken, die üblicherweise im Diffusionskontext verwendet werden, und bestätigte, dass sie ähnliche Vorteile für GANs bringen. Beispielsweise kann die Verknüpfung von Selbstaufmerksamkeit (nur Bild) und Queraufmerksamkeit (Bild-Text) mit Faltungsschichten die Modellleistung verbessern.

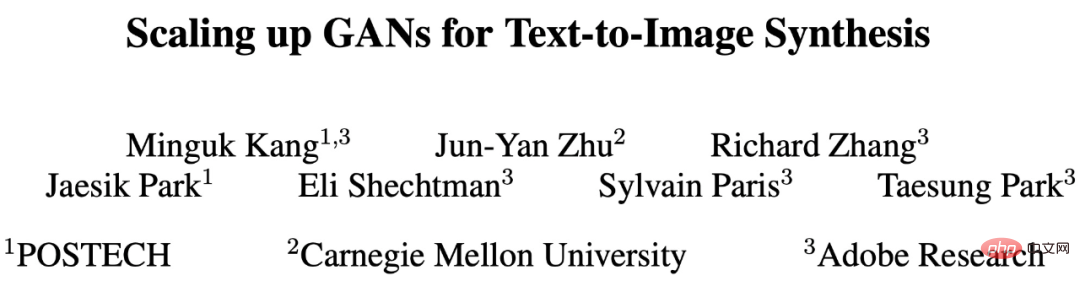

Die Forschung führt auch das Multiskalen-Training wieder ein und schlägt ein neues Schema vor, um die Bild-Text-Ausrichtung zu verbessern und niederfrequente Details der Ausgabe zu generieren. Multiskalentraining ermöglicht es GAN-basierten Generatoren, Parameter in Blöcken mit niedriger Auflösung effizienter zu nutzen, was zu einer besseren Bild-Text-Ausrichtung und Bildqualität führt. Nach sorgfältiger Anpassung schlägt diese Studie ein neues GigaGAN-Modell mit einer Milliarde Parametern vor und erreicht ein stabiles und skalierbares Training für große Datensätze (wie LAION2B-en). Die experimentellen Ergebnisse sind in Abbildung 1 unten dargestellt.

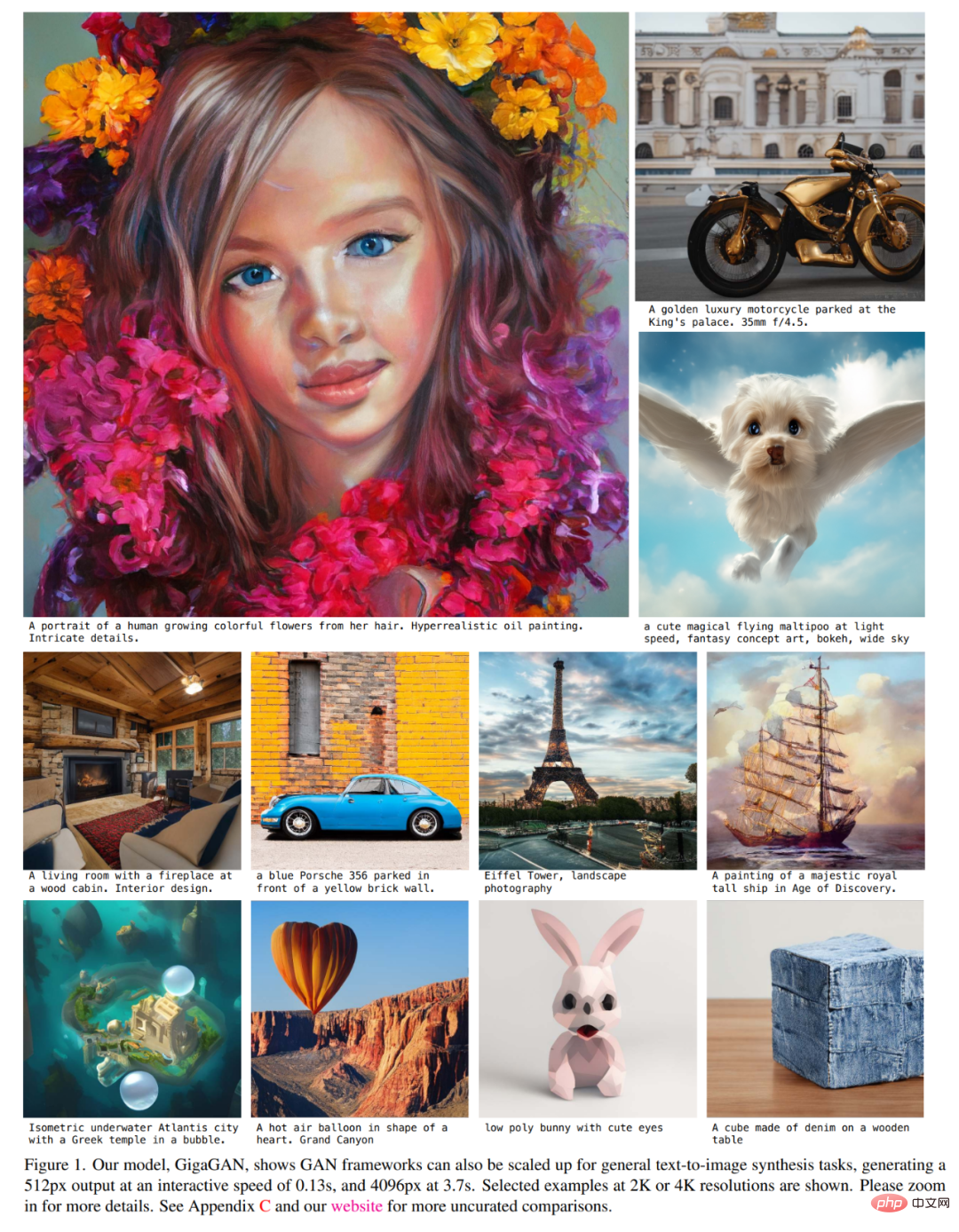

Darüber hinaus wurde in dieser Studie ein mehrstufiger Ansatz gewählt [14, 104], bei dem zunächst Bilder mit einer niedrigen Auflösung von 64 × 64 generiert und dann auf eine Auflösung von 512 × 512 hochgesampelt wurden. Beide Netzwerke sind modular und leistungsstark genug, um Plug-and-Play-fähig zu sein.

Diese Studie zeigt, dass das textkonditionierte GAN-Upsampling-Netzwerk als effizienter und qualitativ hochwertigerer Upsampler für das zugrunde liegende Diffusionsmodell verwendet werden kann, wie in Abbildung 2 und Abbildung 3 unten dargestellt.

Die oben genannten Verbesserungen machen GigaGAN weit über frühere GANs hinaus: 36-mal größer als StyleGAN2 und 6-mal größer als StyleGAN-XL und XMC-GAN. Während die Parameteranzahl von GigaGAN mit einer Milliarde (1B) immer noch niedriger ist als die neuerer großer synthetischer Modelle wie Imagen (3,0B), DALL・E 2 (5,5B) und Parti (20B), sagen die Forscher, dass dies noch nicht der Fall sei Beobachtete Änderungen in der Modellgröße. Die Qualität der Größe ist gesättigt.

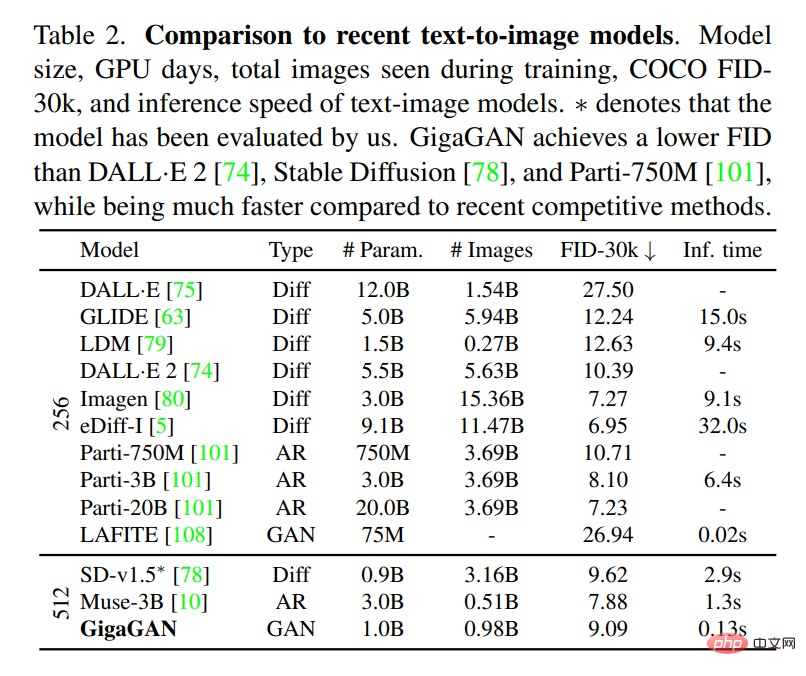

GigaGAN erreicht im COCO2014-Datensatz einen Nullstichproben-FID von 9,09, was niedriger ist als DALL・E 2, Parti-750M und Stable Diffusion.

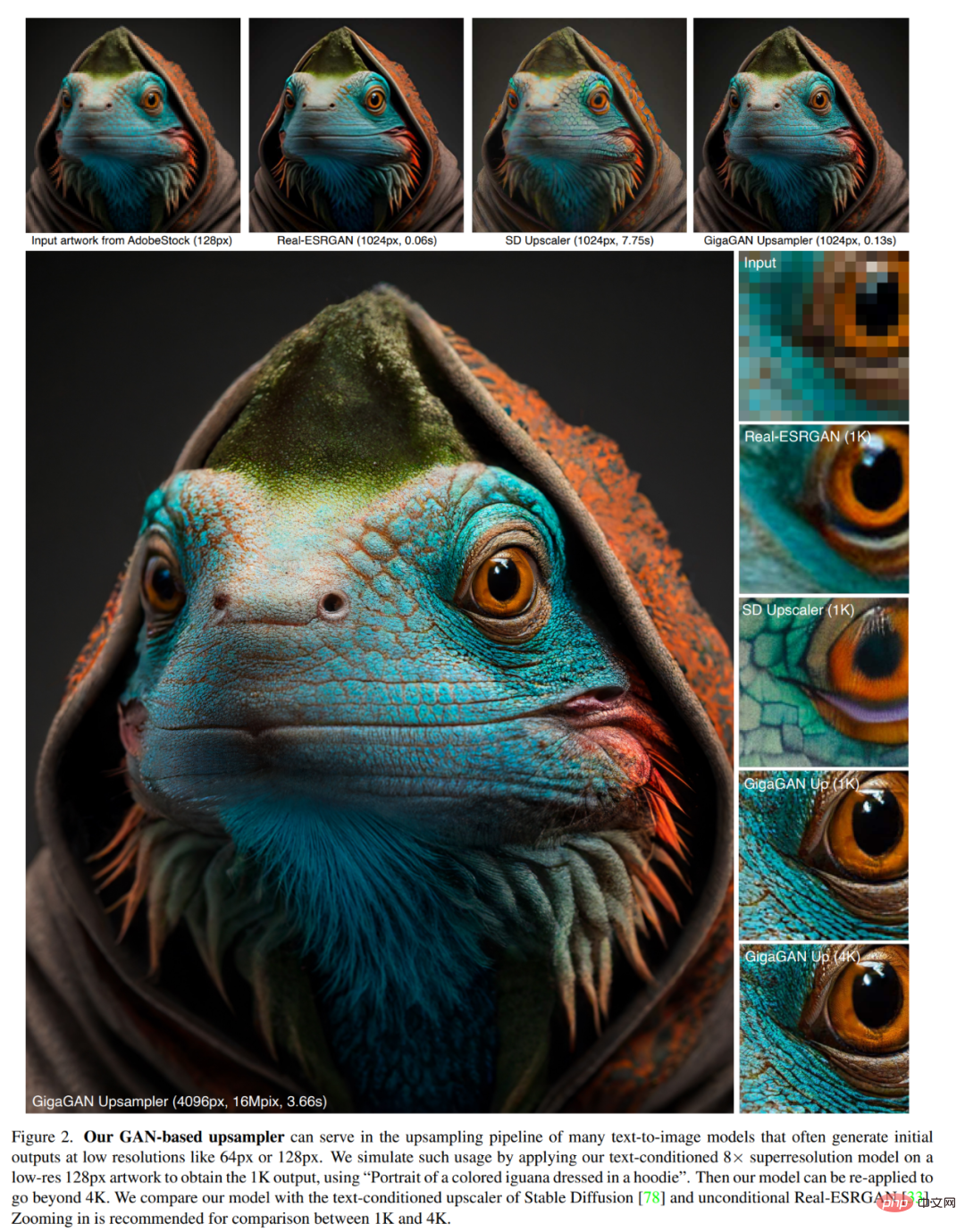

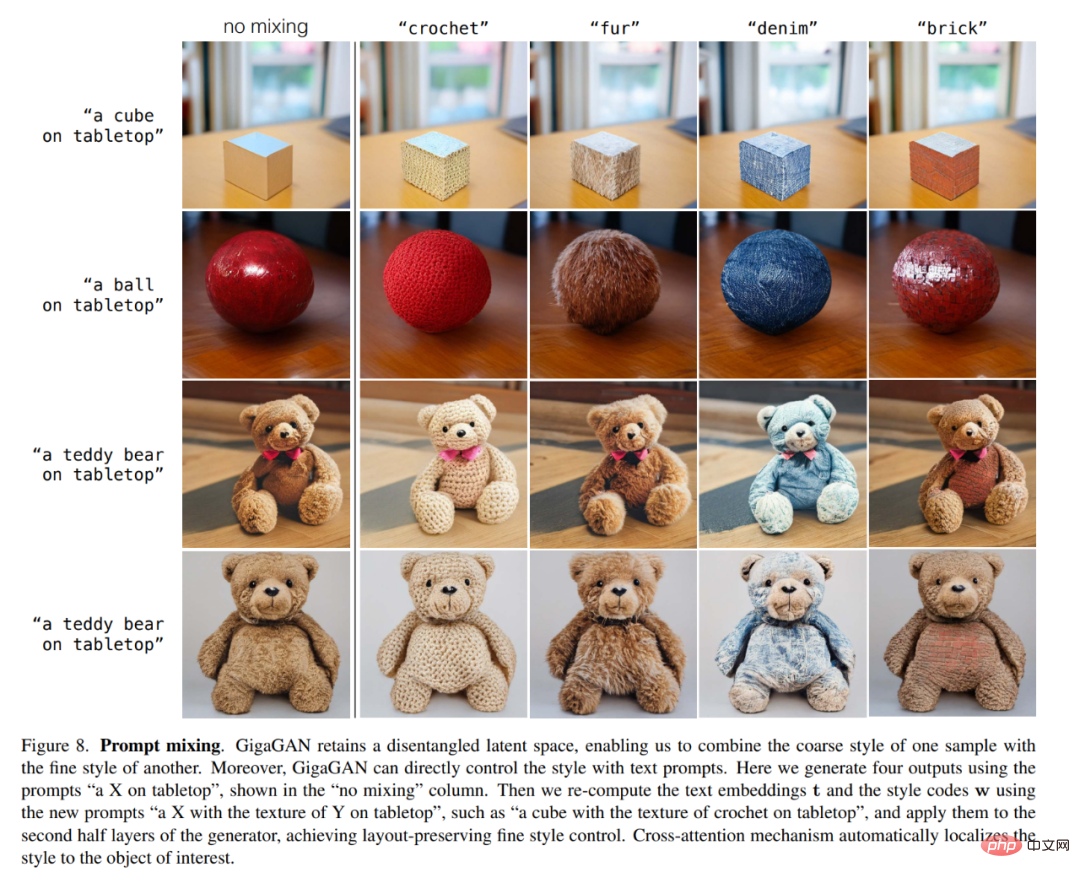

Darüber hinaus bietet GigaGAN im Vergleich zu Diffusionsmodellen und autoregressiven Modellen drei große praktische Vorteile. Erstens ist es Dutzende Male schneller und erzeugt ein 512-Pixel-Bild in 0,13 Sekunden (Abbildung 1). Zweitens kann es in nur 3,66 Sekunden ultrahochauflösende Bilder mit 4K-Auflösung synthetisieren. Drittens verfügt es über einen steuerbaren latenten Vektorraum, der für gut untersuchte steuerbare Bildsyntheseanwendungen geeignet ist, wie z. B. Style Blending (Abbildung 6), Prompt Interpolation (Abbildung 7) und Prompt Blending (Abbildung 8).

Die Forschung trainierte erfolgreich ein GAN-basiertes Milliarden-Parameter-Skalenmodell GigaGAN auf Milliarden von Bildern aus der realen Welt. Dies legt nahe, dass GANs eine praktikable Option für die Text-zu-Bild-Synthese bleiben und dass Forscher sie für eine aggressive zukünftige Erweiterung in Betracht ziehen sollten.

Die Forscher trainierten einen Generator G (z, c), um bei gegebener latenter Kodierung z∼N (0, 1)∈R^128 und einem Textkonditionierungssignal c ein Bild x∈ vorherzusagen R^(H×B×3). Sie verwenden einen Diskriminator D (x, c), um die Authentizität der generierten Bilder im Vergleich zu Proben in einer Trainingsdatenbank D zu beurteilen, die Bild-Text-Paare enthält.

Obwohl GANs erfolgreich realistische Bilder für Einzel- und Mehrklassen-Datensätze generieren können, steht die bedingte Open-Text-Synthese für Internetbilder immer noch vor Herausforderungen. Die Forscher gehen davon aus, dass die aktuellen Einschränkungen auf die Abhängigkeit von Faltungsschichten zurückzuführen sind. Das heißt, dass derselbe Faltungsfilter verwendet wird, um eine universelle Bildsynthesefunktion für alle Textbedingungen an allen Stellen im Bild zu modellieren, was eine Herausforderung darstellt. Vor diesem Hintergrund versuchen Forscher, der Parametrisierung mehr Ausdruckskraft zu verleihen, indem sie Faltungsfilter basierend auf Eingabebedingungen dynamisch auswählen und Abhängigkeiten über große Entfernungen durch Aufmerksamkeitsmechanismen erfassen.

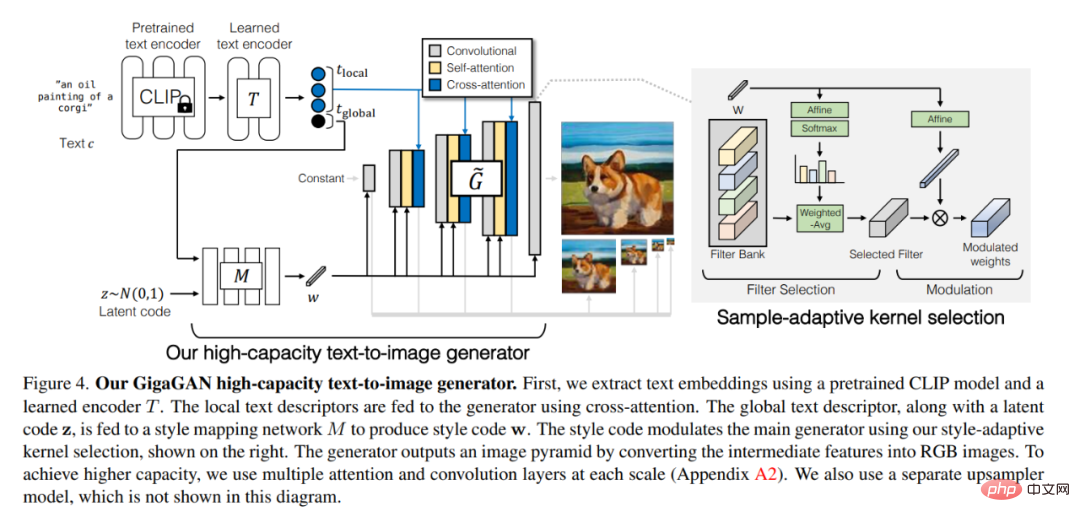

Der GigaGAN-Text-Bild-Generator mit hoher Kapazität ist in Abbildung 4 unten dargestellt. Zunächst verwenden wir ein vorab trainiertes CLIP-Modell und einen erlernten Encoder T, um Texteinbettungen zu extrahieren. Geben Sie mithilfe von Queraufmerksamkeit lokale Textdeskriptoren an den Generator weiter. Der globale Textdeskriptor wird zusammen mit dem latenten Code z in das Stilzuordnungsnetzwerk M eingespeist, um den Stilcode w zu erzeugen. Der Stilcode passt den Hauptgenerator mithilfe des Stils aus dem Papier an – adaptive Kernelauswahl, siehe rechts.

Der Generator gibt eine Bildpyramide aus, indem er Zwischenmerkmale in RGB-Bilder umwandelt. Um eine höhere Kapazität zu erreichen, verwenden wir auf jeder Skala mehrere Aufmerksamkeits- und Faltungsschichten (Anhang A2). Sie verwendeten auch ein separates Upsampler-Modell, das in dieser Abbildung nicht dargestellt ist.

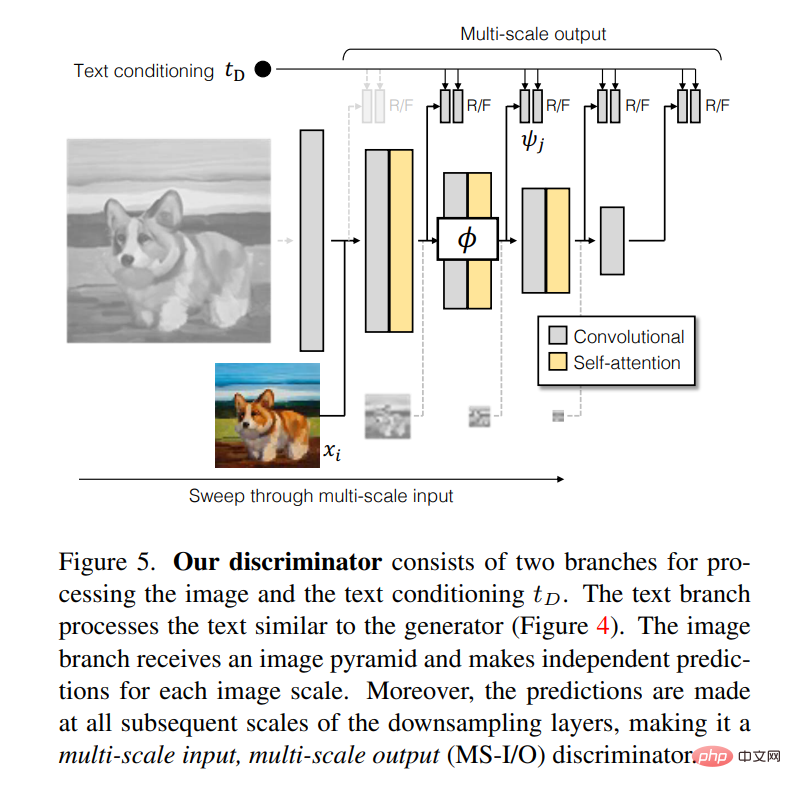

Der Diskriminator besteht aus zwei Zweigen zur Verarbeitung von Bild- und Textkonditionierung t_D. Der Textzweig verarbeitet Text ähnlich wie der Generator (Abbildung 4). Der Bildzweig erhält eine Bildpyramide und trifft für jeden Bildmaßstab unabhängige Vorhersagen. Darüber hinaus werden Vorhersagen auf allen nachfolgenden Skalen der Downsampling-Schicht getroffen, was sie zu einem Multi-Scale-Input-Multi-Scale-Output-Diskriminator (MS-I/O) macht.

In der Arbeit hat der Autor fünf verschiedene Experimente aufgezeichnet.

Im ersten Experiment demonstrierten sie die Wirksamkeit der vorgeschlagenen Methode, indem sie jede technische Komponente einzeln einbauten.

Im zweiten Experiment testeten sie die Fähigkeit des Modells, Diagramme zu erstellen, und die Ergebnisse zeigten, dass GigaGAN eine mit Stable Diffusion (SD-v1.5) vergleichbare FID durchführte und dabei bessere Ergebnisse lieferte Diffusions- oder autoregressive Modelle sind viel schneller.

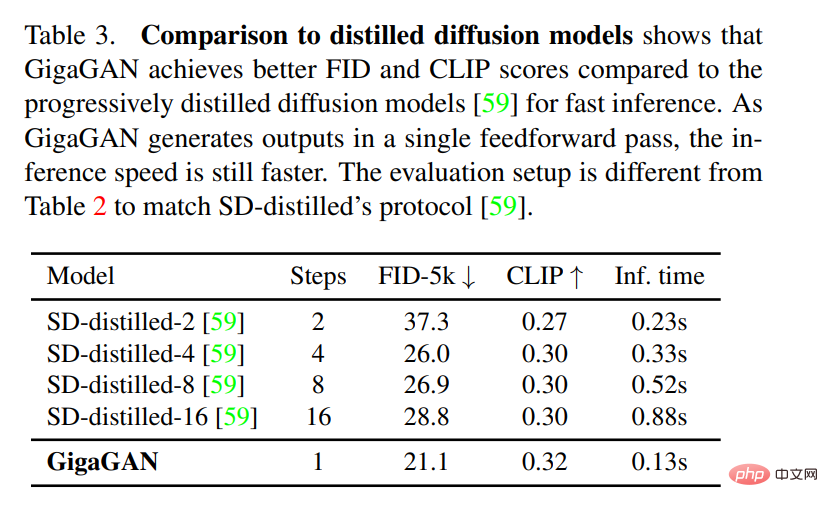

Im dritten Experiment verglichen sie GigaGAN mit einem destillationsbasierten Diffusionsmodell und die Ergebnisse zeigten, dass GigaGAN Bilder mit höherer Qualität schneller synthetisieren kann als ein destillationsbasiertes Diffusionsmodell.

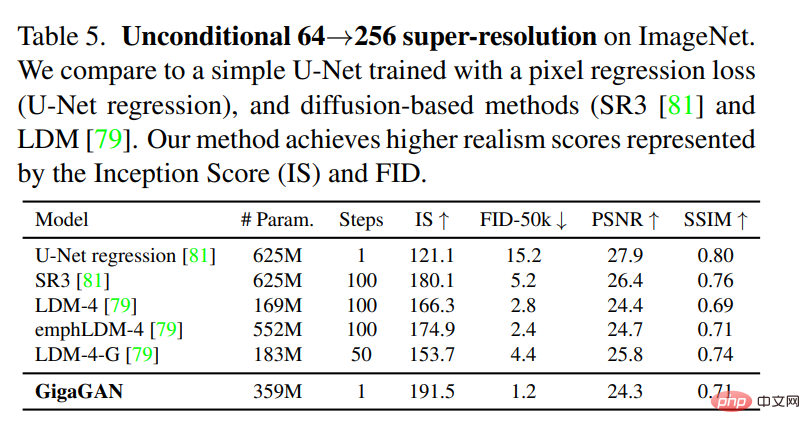

Im vierten Experiment überprüften sie die Vorteile des GigaGAN-Upsamplers im Vergleich zu anderen Upsamplern bei bedingten und bedingungslosen Superauflösungsaufgaben.

Schließlich zeigten sie, dass ihr vorgeschlagenes groß angelegtes GAN-Modell immer noch über die kontinuierlichen und entwirrten latenten Raumoperationen von GAN verfügt und so einen neuen Bildbearbeitungsmodus ermöglicht. Diagramme finden Sie in den Abbildungen 6 und 8 oben.

Das obige ist der detaillierte Inhalt vonGANs Gegenangriff: Zhu Junyans neues CVPR-Werk GigaGAN, die Kartenausgabegeschwindigkeit übertrifft Stable Diffusion. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Konvertieren Sie Text in einen numerischen Wert

Konvertieren Sie Text in einen numerischen Wert

Merkmale von Managementinformationssystemen

Merkmale von Managementinformationssystemen

Gängige hexadezimale Farbcodes

Gängige hexadezimale Farbcodes

So kaufen und verkaufen Sie Bitcoin legal

So kaufen und verkaufen Sie Bitcoin legal

So ändern Sie die IP-Adresse

So ändern Sie die IP-Adresse

Der Unterschied zwischen einem offiziellen Ersatztelefon und einem brandneuen Telefon

Der Unterschied zwischen einem offiziellen Ersatztelefon und einem brandneuen Telefon

So implementieren Sie Farbschriftarten in CSS

So implementieren Sie Farbschriftarten in CSS

So lösen Sie eine Cad-Vergiftung

So lösen Sie eine Cad-Vergiftung