Seit der ersten Veranstaltung im Jahr 2017 hat sich CoRL zu einer der weltweit führenden akademischen Konferenzen an der Schnittstelle von Robotik und maschinellem Lernen entwickelt. CoRL ist eine eingleisige Konferenz für Roboterlernforschung, die mehrere Themen wie Robotik, maschinelles Lernen und Steuerung, einschließlich Theorie und Anwendungen, abdeckt.

Die CoRL-Konferenz 2022 findet vom 14. bis 18. Dezember in Auckland, Neuseeland, statt.

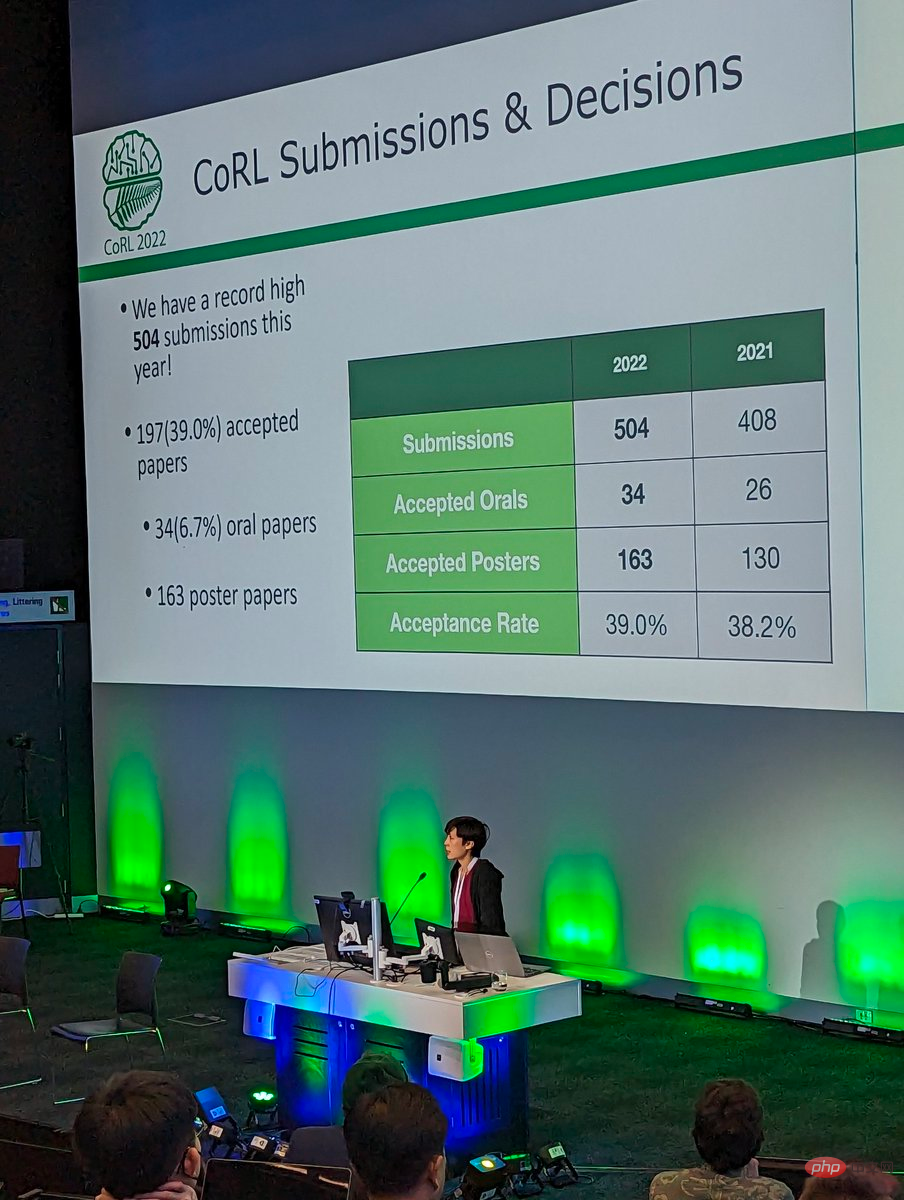

Diese Konferenz erhielt insgesamt 504 Einreichungen und nahm schließlich 34 mündliche Beiträge und 163 Posterbeiträge an, mit einer Annahmequote von 39 %.

Derzeit hat CoRL 2022 alle Auszeichnungen bekannt gegeben, darunter den Best Paper Award, den Best System Paper Award und den Special Innovation Award. Kun Huang, ein Master-Absolvent des GRASP Laboratory der University of Pennsylvania und Absolvent der Shanghai Jiao Tong University, gewann den Preis für den besten Beitrag der Konferenz.

Gewinner des Best Paper Award dieser Konferenz ist eine Studie der University of Pennsylvania.

Bewertungsergebnisse zeigen, dass IRF durch Zugriff auf Demos oder sorgfältig gestaltete Belohnungen erhebliche Leistungsverbesserungen erzielen und sogar die Ausgangswerte übertreffen kann. Im Bild unten muss der Roboter beispielsweise zuerst die Tür schließen und dann den symmetrischen Türgriff drehen, um die Tür vollständig zu verriegeln.

Beispieldemonstration für Türverriegelung

Der Zweck des folgenden Experiments besteht darin, drei optisch identische Blöcke zu einem stabilen Turm zu stapeln, wobei ein kleiner Block deutlich größer als die anderen beiden Blöcke ist Die beste Strategie besteht darin, es unten zu platzieren.

Stacked Evaluation Beispieldemonstration

Um die Robustheit und Allgemeingültigkeit des Algorithmus zu überprüfen, wurde er in dieser Studie in einem echten Roboter-Anziehexperiment mit einer D'Claw mit 9 Gelenken getestet. Der Zweck dieser Aufgabe besteht darin, das 4-Stift-Ventil um ca. 180° im Uhrzeigersinn in den festgezogenen Zustand zu drehen (weiße Linie auf der Ventilbasis).

Vorstellung an den Autor

Es gibt dieses Mal drei Autoren, die den CoRL 2022 Best Paper Award gewonnen haben, nämlich Kun Huang, Edward Hu und Dinesh Jayaraman.

Dinesh Jayaraman ist Assistenzprofessor am GRASP Laboratory der University of Pennsylvania. Er leitet die Forschungsgruppe Perception, Action, and Learning (PAL) und widmet sich der Forschung zu Schnittpunkten von Computer Vision, maschinellem Lernen und Robotik.

Kun Huang ist Meister des GRASP-Labors an der University of Pennsylvania und studiert Reinforcement Learning unter der Leitung von Professor Dinesh Jayaraman. Er erhielt seinen BS in Informatik von der University of Michigan, wo er zusammen mit Professor Dmitry Berenson an der Wahrnehmung von Robotern arbeitete. Kun Huang schloss sein Bachelor-Studium an der Shanghai Jiao Tong University ab. Seine Forschungsinteressen umfassen Robotik und reale Anwendungen. Kun Huang absolvierte während seines Masterstudiums ein Praktikum bei Waymo und wird nach seinem Abschluss als Ingenieur für maschinelles Lernen bei Cruise einsteigen.

Linkedin-Homepage: https://www.linkedin.com/in/kun-huang-620034171/

Edward S. Hu ist Doktorand im GRASP Laboratory der University of Pennsylvania unter der Aufsicht von Professor Dinesh Jayaraman. Zu seinen Forschungsschwerpunkten gehört modellbasiertes Reinforcement Learning. Edward erhielt seinen Master- und Bachelor-Abschluss in Informatik von der University of Southern California, wo er zusammen mit Professor Joseph J. Lim an Verstärkungs- und Nachahmungslernen bei Robotern arbeitete.

Insgesamt 3 Beiträge wurden auf dieser Konferenz für den Best Paper Award nominiert. Mit Ausnahme des endgültigen Gewinnerbeitrags sind die anderen 2 Beiträge:

Best System Paper Award

Best System Paper Award

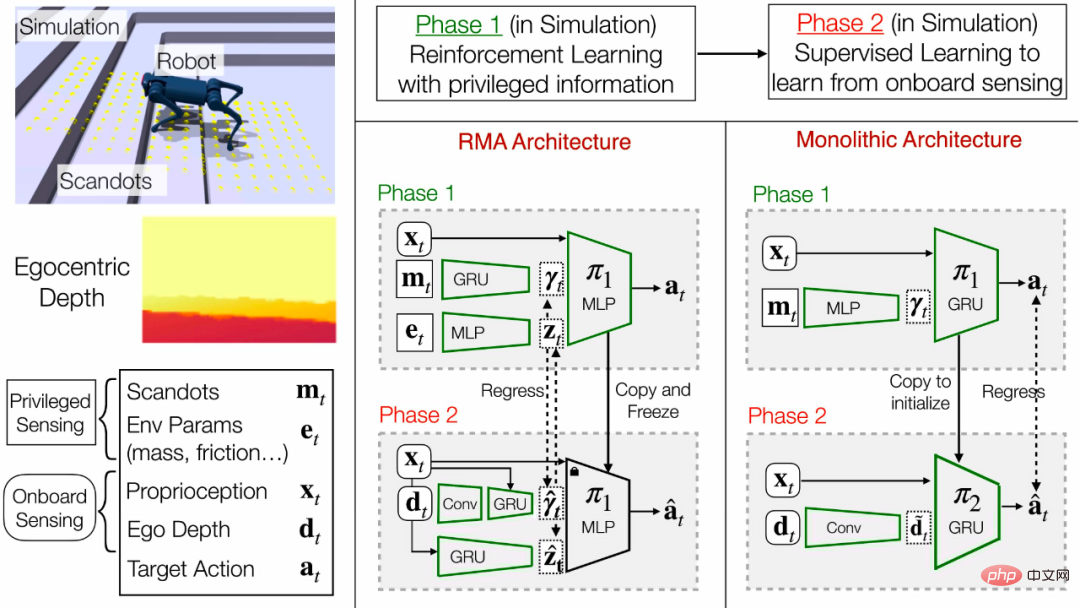

In diesem Artikel schlagen die Forscher das erste End-to-End-Fortbewegungssystem vor, das Treppen, Bordsteine, Trittsteine und Lücken überqueren kann, und demonstrieren es an einem mittelgroßen Vierbeinerroboter mit einer einzigen nach vorne gerichteten Tiefenkamera dieses Ergebnis erzielt. Aufgrund der geringen Größe des Roboters besteht die Notwendigkeit, spezielle Gangmuster zu entdecken, die anderswo nicht zu finden sind. Die Kamera muss die Strategie beherrschen, sich vergangene Informationen zu merken, um das Gelände dahinter und darunter abzuschätzen.

Die Forscher trainierten die Strategie des Roboters in einer simulierten Umgebung. Das Training ist in zwei Phasen unterteilt: Zuerst wird mithilfe von Reinforcement Learning eine Richtlinie für Deep-Image-Varianten mit geringem Rechenaufwand trainiert, und dann wird sie mithilfe von Deep Supervised Learning zu einer endgültigen Richtlinie verfeinert.

Die finale Strategie ist auf die reale Welt übertragbar und kann auf der begrenzten Rechenleistung des Roboters in Echtzeit ausgeführt werden. Es kann ein breites Spektrum von Geländen durchqueren und ist gleichzeitig robust gegenüber Störungen wie rutschigem Untergrund und felsigem Gelände.

Trittsteine und Lücken

Der Roboter kann in verschiedenen Konfigurationen über Barhocker steigen und die Schrittlänge anpassen, um große Lücken zu überbrücken. Da sich in der Nähe der Hinterfüße keine Kameras befinden, muss sich der Roboter die Position des Barhockers merken und seine Hinterfüße entsprechend platzieren.

Treppen und Bordsteine

Der Roboter kann Treppen bis zu einer Höhe von 24 cm und einer Breite von 30 cm erklimmen. Strategien gelten für verschiedene Treppen und Bordsteine unter verschiedenen Lichtverhältnissen. Auf ungleichmäßigen Treppenabständen bleibt der Roboter zunächst stecken, kann diese Hindernisse aber mit der Zeit durch sein Kletterverhalten überwinden.

Unstrukturiertes Gelände

Der Roboter kann unstrukturiertes Gelände durchqueren, das nicht in eine seiner Trainingskategorien fällt, was die Generalisierungsfähigkeiten des Systems demonstriert.

Bewegung im Dunkeln

Die Tiefenkamera projiziert mithilfe von Infrarotlicht Muster, um die Tiefe auch bei praktisch keinem Umgebungslicht genau abzuschätzen.

Robustheit

Die Strategie ist robust gegenüber hohen Kräften (Werfen eines 5-kg-Gewichts aus großer Höhe) und rutschigen Oberflächen (auf eine Plastikfolie gegossenes Wasser). In dieser Studie gibt es vier Autoren.

Jitendra Malik ist derzeit Arthur J. Chick-Professor am Fachbereich Elektrotechnik und Informatik an der UC Berkeley. Zu seinen Forschungsgebieten gehören Computer Vision, Computermodellierung des menschlichen Sehens, Computergrafik und biologische Bildanalyse.

Jitendra Malik ist derzeit Arthur J. Chick-Professor am Fachbereich Elektrotechnik und Informatik an der UC Berkeley. Zu seinen Forschungsgebieten gehören Computer Vision, Computermodellierung des menschlichen Sehens, Computergrafik und biologische Bildanalyse.

Einer der Autoren dieser preisgekrönten Studie, Ashish Kumar, ist sein Doktorand. Deepak Pathak ist derzeit Assistenzprofessor an der Carnegie Mellon University. Er erhielt seinen Doktortitel von der University of California, Berkeley und seine Forschungsthemen umfassen maschinelles Lernen, Robotik und Computer Vision.

Ananye Agarwal, eine der Autoren dieser preisgekrönten Studie, ist seine Doktorandin.

Darüber hinaus hat Deepak Pathak eine weitere Forschung auf der Shortlist für den Best System Paper Award dieser Konferenz.

Diese Konferenz hat auch einen besonderen Innovationspreis verliehen. Diese Forschung wurde gemeinsam von vielen Forschern von Google durchgeführt.

Zusammenfassung des Papiers:Große Sprachmodelle können eine große Menge an semantischem Wissen über die Welt kodieren, und dieses Wissen ist für Roboter sehr nützlich. Allerdings haben Sprachmodelle den Nachteil, dass sie keine Erfahrung mit der realen Welt haben, was es schwierig macht, Semantik zu nutzen, um Entscheidungen für eine bestimmte Aufgabe zu treffen.

Forscher von Google schlagen vor, eine reale Grundlage für große Sprachmodelle zu schaffen, indem vorab trainierte Fähigkeiten verwendet werden, um das Modell darauf zu beschränken, natürliche Sprachoperationen zu entwickeln, die sowohl machbar als auch kontextuell angemessen sind. Roboter können als „Hände und Augen“ von Sprachmodellen dienen, die hochgradiges semantisches Wissen über die Aufgabe liefern. Diese Studie zeigt, wie Fertigkeiten auf niedrigem Niveau mit großen Sprachmodellen kombiniert werden können, sodass das Sprachmodell hochstufiges Wissen über die Prozesse liefert, die komplexe und zeitintensive Anweisungen ausführen, während die mit diesen Fertigkeiten verbundenen Wertfunktionen die Möglichkeit bieten, eine Verbindung herzustellen dieses Wissen auf spezifische physikalische Umgebungen zu übertragen.

Die Forscher nutzten dieses Prinzip, als sie ein großes Sprachmodell (LLM) mit den physischen Aufgaben des Roboters kombinierten: Neben der einfachen Interpretation einer Anweisung durch das LLM kann es auch zur Bewertung einer einzelnen Aktion zur Vervollständigung der gesamten Chancen verwendet werden Sind fortgeschrittene Anweisungen hilfreich? Einfach ausgedrückt kann jede Aktion eine Sprachbeschreibung haben, und wir können das Prompt-Sprachmodell verwenden, um diese Aktionen bewerten zu lassen. Wenn jede Aktion über eine entsprechende Affordance-Funktion verfügt, ist es darüber hinaus möglich, ihre Erfolgswahrscheinlichkeit anhand des aktuellen Zustands (z. B. einer Lernwertfunktion) zu quantifizieren. Das Produkt zweier Wahrscheinlichkeitswerte ist die Wahrscheinlichkeit, dass der Roboter eine für die Anweisung hilfreiche Aktion erfolgreich abschließen kann. Sortieren Sie eine Reihe von Aktionen nach dieser Wahrscheinlichkeit und wählen Sie die Aktion mit der höchsten Wahrscheinlichkeit aus.

Das folgende Beispiel zeigt einen Roboter, der beim Aufheben eines Apfels hilft:

Das obige ist der detaillierte Inhalt vonAlumni der Shanghai Jiao Tong University gewannen den besten Beitrag und die Auszeichnungen für CoRL 2022, die wichtigste Robotikkonferenz, wurden bekannt gegeben. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So aktualisieren Sie Douyin

So aktualisieren Sie Douyin

Detaillierte Erklärung des Linux-Befehls dd

Detaillierte Erklärung des Linux-Befehls dd

So lösen Sie das Problem, dass localhost nicht geöffnet werden kann

So lösen Sie das Problem, dass localhost nicht geöffnet werden kann

Was soll ich tun, wenn eDonkey Search keine Verbindung zum Server herstellen kann?

Was soll ich tun, wenn eDonkey Search keine Verbindung zum Server herstellen kann?

Verwendung der Snoopy-Klasse in PHP

Verwendung der Snoopy-Klasse in PHP

Gängige Methoden zur Erkennung von Website-Schwachstellen

Gängige Methoden zur Erkennung von Website-Schwachstellen

Der Unterschied zwischen Git und SVN

Der Unterschied zwischen Git und SVN

Tutorial zum Kauf und Verkauf von Bitcoin auf Huobi.com

Tutorial zum Kauf und Verkauf von Bitcoin auf Huobi.com