Die jüngste Veröffentlichung vonChatGPT von OpenAI hat dem Bereich der künstlichen Intelligenz einen Schub gegeben. Seine leistungsstarken Fähigkeiten übertreffen die Erwartungen von Sprachverarbeitungsforschern bei weitem.

Benutzer, die ChatGPT kennengelernt haben, werden natürlich Fragen stellen:Wie hat sich das ursprüngliche GPT 3 zu ChatGPT entwickelt? Woher kommen die erstaunlichen Sprachfunktionen von GPT 3.5?

Kürzlich haben Forscher vomAllen Institute for Artificial Intelligenceeinen Artikel geschrieben, in dem sie versuchten, die Emergent Ability von ChatGPT zu analysieren, die Quelle dieser Fähigkeiten zu verfolgen und eine umfassende Technologie bereitzustellen. Die Roadmap veranschaulicht, wie das GPT-3.5-Modell funktioniert Serien und verwandte groß angelegte Sprachmodelle haben sich Schritt für Schritt zu ihrer aktuellen leistungsstarken Form entwickelt.

Originallink: https://yaofu.notion.site/GPT-3-5-360081d91ec245f29029d37b54573756

AutorFU尧Ist ein Doktorand an der University of Edinburgh zugelassen? im Jahr 2020? Er schloss sein Studium mit einem Master-Abschluss an der Columbia University und einem Bachelor-Abschluss an der Peking-Universität ab. Derzeit ist er Forschungspraktikant am Allen Institute for Artificial Intelligence. Sein Forschungsschwerpunkt sind groß angelegte probabilistische generative Modelle der menschlichen Sprache.

Der AutorPeng Haohat einen Bachelor-Abschluss und einen Ph.D. von der University of Washington. Er ist derzeit Young Investigator am Allen Institute for Artificial Intelligence und wird der Abteilung für Computer beitreten Wissenschaft an der University of Illinois at Urbana-Champaign im August 2023 im Department of Science als Assistenzprofessor. Zu seinen Hauptforschungsinteressen gehört es, Sprach-KI effizienter und verständlicher zu machen und groß angelegte Sprachmodelle zu erstellen.

Der AutorTushar KhotPh.D. hat seinen Abschluss an der University of Wisconsin-Madison gemacht und ist derzeit wissenschaftlicher Mitarbeiter am Allen Institute for Artificial Intelligence. Sein Forschungsschwerpunkt ist strukturiertes maschinelles Denken.

1. 2020-Version des GPT-3 der ersten Generation und umfangreiches Vortraining

Der GPT-3 der ersten Generation zeigte drei wichtige Fähigkeiten:

- Sprachgenerierung:Folgen Sie dem Eingabeaufforderungswort ( Eingabeaufforderung) und generieren Sie dann die Komplementsätze mit allen Eingabeaufforderungswörtern. Dies ist heute auch die häufigste Art und Weise, wie Menschen mit Sprachmodellen interagieren.

- In-Kontext-Lernen:Befolgen Sie einige Beispiele einer vorgegebenen Aufgabe und generieren Sie dann Lösungen für neue Testfälle. Ein sehr wichtiger Punkt ist, dass GPT-3 zwar ein Sprachmodell ist, in seinem Artikel jedoch kaum von „Sprachmodellierung“ die Rede ist – die Autoren haben ihre gesamte Schreibenergie der Vision des kontextuellen Lernens gewidmet. Dies ist der eigentliche Schwerpunkt von GPT-3.

- Weltwissen:Einschließlich Faktenwissen (Factual Knowledge) und gesundem Menschenverstand (Commonsense).

Woher kommen diese Fähigkeiten?

Grundsätzlich stammen die oben genannten drei Fähigkeiten aus einem umfangreichen Vortraining: Vorabtraining eines Modells mit 175 Milliarden Parametern auf einem Korpus von 300 Milliarden Wörtern (60 % des Trainingskorpus stammen aus C4+22 aus dem Jahr 2016- 2019 % aus WebText2 + 16 % aus Büchern + 3 % aus Wikipedia). Darunter:

- Die Fähigkeit zur Sprachgenerierung ergibt sich aus dem Trainingsziel der Sprachmodellierung (Sprachmodellierung).

- Weltwissen stammt aus einem Trainingskorpus von 300 Milliarden Wörtern (wo sonst könnte es sein).

- Die 175 Milliarden Parameter des Modells dienen der Speicherung von Wissen, was durch den Artikel von Liang et al. (2022) weiter bewiesen wird. Sie kamen zu dem Schluss, dass die Leistung bei wissensintensiven Aufgaben eng mit der Modellgröße zusammenhängt.

- Die Quelle kontextueller Lernfähigkeiten und warum Kontextlernen verallgemeinert werden kann, sind immer noch schwer zu ermitteln. Intuitiv kann diese Fähigkeit dadurch entstehen, dass Datenpunkte aus derselben Aufgabe während des Trainings nacheinander im selben Stapel angeordnet werden. Es wurde jedoch wenig darüber geforscht, warum das Vortraining eines Sprachmodells kontextbezogenes Lernen anregt und warum sich kontextbezogenes Lernen so anders verhält als die Feinabstimmung.

Merkwürdig ist, wie leistungsstark der GPT-3 der ersten Generation ist.

Tatsächlich ist es schwierig festzustellen, ob das ursprüngliche GPT-3 (in der OpenAI-API Davinci genannt) „stark“ oder „schwach“ ist.

Einerseits reagierte es angemessen auf einige spezifische Abfragen und erzielte bei vielen Datensätzen eine anständige Leistung.

Andererseits schnitt es bei vielen Aufgaben nicht so gut ab wie das T5-Modell (siehe sein Originalpapier).

Unter den heutigen (Dezember 2022) ChatGPT-Standards ist es schwierig zu sagen, dass das ursprüngliche GPT-3 „intelligent“ ist. Das Open-Source-OPT-Modell von Meta versucht, das ursprüngliche GPT-3 zu replizieren, seine Fähigkeiten stehen jedoch in scharfem Gegensatz zu den heutigen Standards. Viele Leute, die OPT getestet haben, glauben auch, dass das Modell im Vergleich zum aktuellen text-davinci-002 tatsächlich „nicht so gut“ ist.

Trotzdem könnte OPT eine ausreichend gute Open-Source-Annäherung an das ursprüngliche GPT-3 sein (gemäß dem OPT-Papier und der HELM-Bewertung der Stanford University).

Obwohl der GPT-3 der ersten Generation oberflächlich betrachtet schwach erscheinen mag, haben nachfolgende Experimente gezeigt, dass der GPT-3 der ersten Generation ein sehr starkes Potenzial hat. Diese Potenziale wurden später durch Code-Training, Befehlsoptimierung und Verstärkungslernen mit menschlichem Feedback (RLHF) freigesetzt, und der endgültige Körper zeigte äußerst leistungsstarke Emergenzfähigkeiten.

2. Von der 2020-Version von GPT-3 zur 2022-Version von ChatGPT

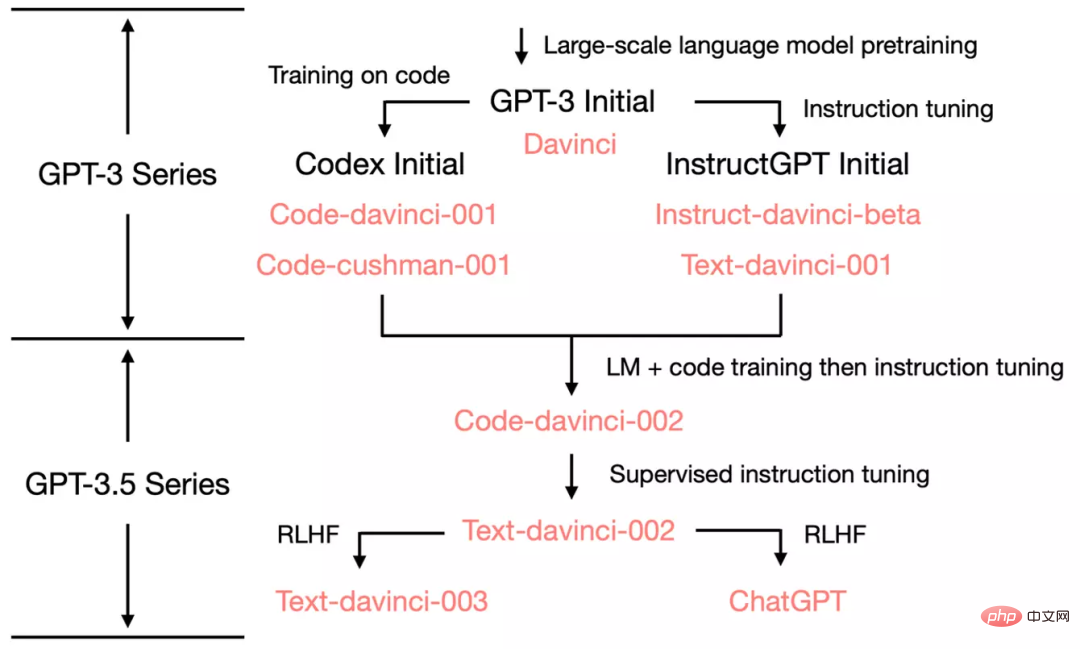

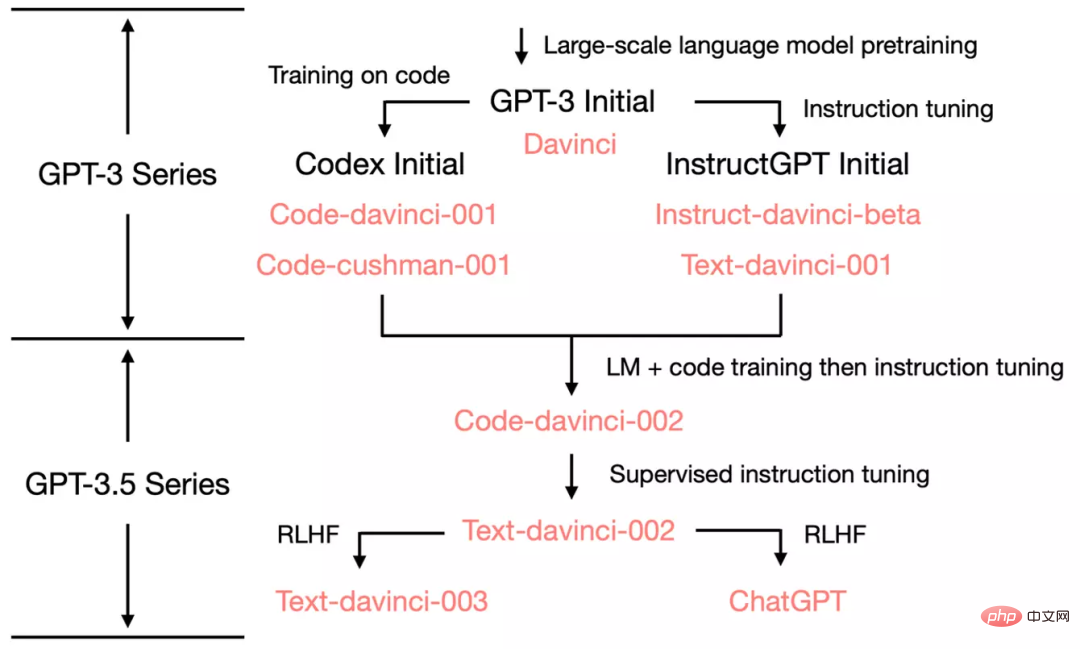

Um zu zeigen, wie sich OpenAI zu ChatGPT entwickelt, werfen wir einen Blick auf den Evolutionsbaum von GPT -3.5:

Im Juli 2020 veröffentlichte OpenAI davincis ursprüngliches GPT-3-Papier mit Modellindex und es hat sich seitdem kontinuierlich weiterentwickelt.

Im Juli 2021 wurde das Codex-Papier veröffentlicht, in dem der ursprüngliche Codex auf der Grundlage einer (möglicherweise internen) GPT-3-Variante mit 12 Milliarden Parametern verfeinert wurde. Dieses 12-Milliarden-Parameter-Modell entwickelte sich später in der OpenAI-API zu code-cushman-001.

Im März 2022 veröffentlichte OpenAI ein Papier zur Befehlsoptimierung, und sein überwachter Befehlsoptimierungsteil entspricht davinci-instruct-beta und text-davinci-001.

Von April bis Juli 2022 begann OpenAI mit dem Betatest des Code-Davinci-002-Modells, auch Codex genannt. Dann werden Code-Davinci-002, Text-Davinci-003 und ChatGPT alle durch Feinabstimmung der Anweisungen von Code-Davinci-002 erhalten. Weitere Informationen finden Sie in der Dokumentation zum Modellindex von OpenAI.

Obwohl Codex wie ein Nur-Code-Modell klingt, ist code-davinci-002 wahrscheinlich die leistungsstärkste GPT-3.5-Variante für natürliche Sprache (besser als text-davinci-002 und -003). Es ist wahrscheinlich, dass code-davinci-002 sowohl am Text als auch am Code trainiert und dann basierend auf den Anweisungen angepasst wurde (siehe unten).

Dann wird text-davinci-002 im Mai-Juni 2022 veröffentlicht und ist ein überwachtes, anweisungsoptimiertes Modell, das auf code-davinci-002 basiert. Eine Feinabstimmung der Anweisungen auf text-davinci-002 wird wahrscheinlich die kontextbezogene Lernfähigkeit des Modells verringern, aber die Nullschussfähigkeit des Modells verbessern (wird weiter unten erläutert).

Dann gibt es noch text-davinci-003 und ChatGPT, die beide im November 2022 veröffentlicht wurden. Dabei handelt es sich um Versionen der Instruktionsoptimierung mit Verstärkungslernen aus menschlichem Feedback.

text-davinci-003 stellt einige der in text-davinci-002 verlorenen teilweisen Kontextlernfähigkeiten wieder her (ist aber immer noch schlechter als code-davinci-002) (wahrscheinlich). Dies liegt daran, dass es die Sprachmodellierung während der Feinabstimmung einbezieht und die Zero-Sample-Fähigkeiten weiter verbessert (dank RLHF). ChatGPT hingegen scheint fast alle kontextbezogenen Lernfähigkeiten zugunsten der Fähigkeit zu opfern, den Gesprächsverlauf zu modellieren.

Im Allgemeinen hat OpenAI im Zeitraum 2020-2021, vor Code-Davinci-002, viel Aufwand in die Code-Schulung und die Feinabstimmung von Anweisungen investiert. 3. Als sie code-davinci-002 fertigstellten, waren alle Funktionen bereits vorhanden. Es ist wahrscheinlich, dass eine spätere Feinabstimmung der Anweisungen, sei es über eine überwachte Version oder eine Version des verstärkenden Lernens, Folgendes bewirken wird (dazu später mehr):

- # #Durch die Feinabstimmung der Anweisungen werden dem Modell keine neuen Funktionen hinzugefügt – alle Funktionen sind bereits vorhanden. Die Rolle von Befehlsstößen besteht darin, diese Fähigkeiten freizuschalten/zu aktivieren. Dies liegt hauptsächlich daran, dass die Datenmenge für die Feinabstimmung der Anweisungen um mehrere Größenordnungen kleiner ist als die Menge der Daten vor dem Training (die Grundfunktionen werden durch das Vortraining eingefügt).

- Durch die Feinabstimmung der Befehle wird GPT-3.5 in verschiedene Fähigkeitsbäume differenziert. Einige sind besser im kontextuellen Lernen, wie text-davinci-003, und andere sind besser in Gesprächen, wie ChatGPT.

- Die Feinabstimmung der Anleitung opfert die Leistung für die Ausrichtung auf den Menschen. Die Autoren von OpenAI nennen dies in ihrem Papier zur Feinabstimmung von Anweisungen eine „Ausrichtungssteuer“.

Viele Artikel haben berichtet, dass Code-Davinci-002 in Benchmarks die beste Leistung erzielt (aber das Modell entspricht nicht unbedingt den menschlichen Erwartungen). Nach der Feinabstimmung der Anweisungen zu Code-Davinci-002 kann das Modell Feedback generieren, das eher den menschlichen Erwartungen entspricht (oder das Modell auf Menschen ausgerichtet ist), wie zum Beispiel: Fragen und Antworten ohne Stichproben, wodurch ein sicherer und fairer Dialog entsteht Antworten und Ablehnung, die über den Rahmen des Wissensproblems des Modells hinausgehen.

3. Code-Davinci-002 und Text-Davinci-002, Schulung zum Code und Feinabstimmung der Anweisungen

# #Vor code-davinci-002 und text-davinci-002 gibt es zwei Zwischenmodelle, nämlich davinci-instruct-beta und text-davinci-001. Beide sind in vielerlei Hinsicht schlechter als die oben genannten Zwei-002-Modelle (z. B. ist die Fähigkeit zum Kettendenken von text-davinci-001 nicht stark).

Deshalb konzentrieren wir uns in diesem Abschnitt auf das -002-Modell.

3.1 Die Quelle komplexer Denkfähigkeiten und der Fähigkeit, auf neue Aufgaben zu verallgemeinern

Wir konzentrieren uns auf Code-Davinci-002 und Text- davinci-002, diese beiden Brüder sind die erste Version des GPT3.5-Modells, einer für Code und der andere für Text. Sie weisen drei wichtige Fähigkeiten auf, die sich vom ursprünglichen GPT-3 unterscheiden: Die Ausgabe von GPT-3 konzentriert sich hauptsächlich auf allgemeine Sätze im Trainingssatz. Das Modell generiert nun sinnvollere Antworten (anstelle relevanter, aber nutzloser Sätze) auf Anweisungen/Stichworte.

Auf ungesehene Aufgaben verallgemeinern:

- Wenn die Anzahl der zum Optimieren des Modells verwendeten Anweisungen einen bestimmten Maßstab überschreitet, kann das Modell automatisch effektiv generiert werden Antworten auf neue Befehle, die Sie noch nie zuvor gesehen haben. Diese Fähigkeit ist für die Online-Bereitstellung von entscheidender Bedeutung, da Benutzer immer neue Fragen stellen und das Modell in der Lage sein muss, diese zu beantworten.

Codegenerierung und Codeverständnis:

- Diese Fähigkeit ist offensichtlich, da das Modell mit Code trainiert wird.

Gedankenkette für komplexe Überlegungen verwenden:

- Das Modell des GPT3 der ersten Generation weist eine sehr schwache Gedankenkette auf Fähigkeiten. code-davinci-002 und text-davinci-002 sind zwei Modelle mit ausreichend starken Denkketten-Argumentationsfähigkeiten.

- Denkkettendenken ist wichtig, da Gedankenketten der Schlüssel zur Erschließung neuer Fähigkeiten und zur Überwindung von Skalierungsgesetzen sein können.

Woher kommen diese Fähigkeiten?

- Im Vergleich zum Vorgängermodell bestehen die beiden Hauptunterschiede in der Feinabstimmung der Anweisungen und dem Code-Training. Konkret:

- Die Fähigkeit, auf menschliche Befehle zu reagieren, ist ein direktes Produkt der Befehlsfeinabstimmung.

- Die Verallgemeinerungsfähigkeit, auf unsichtbare Anweisungen zu reagieren, erscheint automatisch, sobald die Anzahl der Anweisungen ein bestimmtes Niveau überschreitet, und die T0-, Flan- und FlanPaLM-Papiere beweisen dies weiter.

- Die Fähigkeit, Gedankenketten für komplexe Überlegungen zu nutzen, kann durchaus ein magisches Nebenprodukt des Programmiertrainings sein.Hierfür haben wir die folgenden Fakten als Unterstützung:

- Der ursprüngliche GPT-3 war nicht zum Programmieren trainiert, er konnte keine Gedankenverkettung durchführen.

- text-davinci-001-Modell: Obwohl es durch Anweisungen verfeinert wurde, berichtet die erste Version des Denkkettenpapiers, dass seine Fähigkeit, über andere Denkketten nachzudenken, sehr schwach ist – eine Feinabstimmung der Anweisungen ist daher möglicherweise nicht möglich Der Grund für die Existenz von Denkketten ist das Code-Training, das den wahrscheinlichsten Grund dafür darstellt, dass das Modell Denkketten-Argumentation durchführen kann.

- PaLM verfügt über 5 % Code-Trainingsdaten und kann Gedankenverkettungen durchführen.

- Das Codedatenvolumen im Codex-Papier beträgt 159G, was etwa 28 % der 570 Milliarden Trainingsdaten des ursprünglichen GPT-3 entspricht. code-davinci-002 und seine nachfolgenden Varianten können Gedankenketten-Schlussfolgerungen durchführen.

- Im HELM-Test führten Liang et al. (2022) eine groß angelegte Evaluierung verschiedener Modelle durch. Sie fanden heraus, dass auf Code trainierte Modelle über starke Sprachinferenzfähigkeiten verfügen, einschließlich des 12 Milliarden Parameters code-cushman-001.

- Unsere Arbeit an AI2 zeigt auch, dass code-davinci-002, wenn es mit komplexen Gedankenketten ausgestattet ist, derzeit das leistungsstärkste Modell bei wichtigen mathematischen Benchmarks wie GSM8K ist.

- Intuitiv ist die verfahrensorientierte Programmierung dem Prozess, durch den Menschen Aufgaben Schritt für Schritt lösen, sehr ähnlich, und die objektorientierte Programmierung ähnelt dem Prozess, durch den Menschen komplexe Aufgaben in mehrere einfache Aufgaben zerlegen.

- Alle oben genannten Beobachtungen sind Korrelationen zwischen Code und Argumentationsfähigkeit/Denkkette, aber nicht unbedingt Kausalität. Dieser Zusammenhang ist interessant, stellt jedoch derzeit noch eine offene Frage dar, die untersucht werden muss. Derzeit haben wir keine sehr schlüssigen Beweise dafür, dass Code die Ursache für Gedankenketten und komplexes Denken ist.

- Darüber hinaus sind Abhängigkeiten über große Entfernungen ein weiteres mögliches Nebenprodukt des Code-Trainings, wie Peter Liu betonte: „Die Vorhersage des nächsten Wortes in einer Sprache ist normalerweise sehr lokal, und Code erfordert normalerweise längere Abhängigkeiten, um einige Dinge wie zu tun.“ Passende vordere und hintere Klammern oder Referenzierung von Remote-Funktionsdefinitionen.Was ich hier noch hinzufügen möchte, ist: Aufgrund der Klassenvererbung in der objektorientierten Programmierung kann Code auch zur Fähigkeit des Modells beitragen, Codierungshierarchien einzurichten. Wir überlassen die Prüfung dieser Hypothese zukünftigen Arbeiten.

Achten Sie außerdem bitte auf einige Unterschiede im Detail:

- text-davinci-002 und code-davinci-002

# #

- Code-davinci-002 ist das Basismodell, text-davinci-002 ist das Produkt der Befehlsfeinabstimmung von code-davinci-002 (siehe OpenAI-Dokumentation). Die Feinabstimmung erfolgt anhand der folgenden Daten: (1) von Menschen kommentierte Anweisungen und erwartete Ausgaben (2) von menschlichen Annotatoren ausgewählte Modellausgaben;

- Wenn es kontextbezogene Beispiele (In-Kontext-Beispiel) gibt, ist Code-davinci-002 besser im Kontextlernen; wenn es keine kontextbezogenen Beispiele/Nullbeispiele oder Text gibt -davinci-002 schneidet bei Zero-Shot-Aufgabenabschluss besser ab. In diesem Sinne entspricht text-davinci-002 eher den menschlichen Erwartungen (da das Schreiben kontextbezogener Beispiele für eine Aufgabe umständlich sein kann).

- Es ist unwahrscheinlich, dass OpenAI absichtlich die Fähigkeit zum Kontextlernen im Austausch für die Fähigkeit zum Null-Beispiel-Lernen opfert – die Verringerung der Fähigkeit zum Kontextlernen ist eher ein Nebeneffekt des Instruktionslernens OpenAI kümmert sich nicht darum. Es heißt Ausrichtungssteuer.

- 001-Modell (code-cushman-001 und text-davinci-001) vs. 002-Modell (code-davinci -002 und text-davinci-002)

- 001-Modell ist hauptsächlich für reine Code-/Nur-Text-Aufgaben gedacht Das 002-Modell integriert Code-Training und Anweisungen-Feinabstimmung tiefgreifend, sodass sowohl Code als auch Text verwendet werden können.

- Code-davinci-002 ist möglicherweise das erste Modell, das Code-Training und Anweisungen-Feinabstimmung tiefgreifend integriert. Der Beweis ist: code-cushman-001 kann Rückschlüsse ziehen, ist aber bei Klartext nicht gut, text-davinci-001 ist bei Klartext gut, aber nicht gut bei Rückschlüssen. code-davinci-002 kann beides gleichzeitig tun.

3.2 Sind diese Fähigkeiten bereits nach dem Vortraining vorhanden oder werden sie später durch Feinabstimmung eingeführt?

In diesem Stadium haben wir die Schlüsselrolle der Feinabstimmung von Anweisungen und des Code-Trainings identifiziert. Eine wichtige Frage ist, wie die Auswirkungen des Code-Trainings und der Feinabstimmung von Anweisungen weiter analysiert werden können.

Im Einzelnen:Existieren die oben genannten drei Fähigkeiten bereits im ursprünglichen GPT-3 und werden nur durch Anweisungen und Code-Training ausgelöst/freigeschaltet? Oder sind diese Fähigkeiten im ursprünglichen GPT-3 nicht vorhanden, sondern wurden durch Anweisungen und Code-Training eingeführt?

Wenn die Antworten bereits im ursprünglichen GPT-3 enthalten sind, sollten diese Funktionen auch im OPT enthalten sein. Um diese Funktionen zu reproduzieren, ist es daher möglicherweise möglich, OPT direkt über Anweisungen und Code anzupassen.

Es ist jedoch möglich, dass code-davinci-002 nicht auf dem ursprünglichen GPT-3-davinci basiert, sondern auf einem größeren Modell als dem ursprünglichen GPT- 3. Wenn dies der Fall ist, gibt es möglicherweise keine Möglichkeit, es durch Anpassen des OPT zu reproduzieren.

Die Forschungsgemeinschaft muss weiter klären, welche Art von Modell OpenAI als Basismodell für code-davinci-002 trainiert hat.

Wir haben die folgenden Hypothesen und Beweise:

- Das Basismodell von code-davinci-002 ist möglicherweise nicht das GPT-3-Davinci-Modell der ersten Generation.

- Die erste Generation von GPT-3 wurde auf dem Datensatz C4 2016 – 2019 trainiert, während der Trainingssatz code-davinci-002 bis 2021 erweitert wurde. Daher ist es möglich, dass code-davinci-002 auf der Version 2019–2021 von C4 trainiert wird.

- Das ursprüngliche GPT-3 hatte ein Kontextfenster von 2048 Wörtern. Das Kontextfenster für code-davinci-002 ist 8192. Die GPT-Serie verwendet absolute Positionseinbettung, ohne Training direkt zu extrapolieren, was schwierig ist und die Leistung des Modells ernsthaft beeinträchtigen wird (siehe Press et al., 2022). Wenn code-davinci-002 auf dem ursprünglichen GPT-3 basiert, wie erweitert OpenAI das Kontextfenster?

- Ob es sich bei dem Basismodell hingegen um das ursprüngliche GPT-3 oder ein später trainiertes Modell handelt, kann die Fähigkeit, Anweisungen zu befolgen und Zero-Shot-Generalisierung durchzuführen, bereits im Basismodell vorhanden sein und fein abgestimmt werden später durch Anweisungen entsperren (nicht injizieren).

- Dies liegt hauptsächlich daran, dass die Größe der im OpenAI-Papier gemeldeten Befehlsdaten nur 77 KB beträgt, was mehrere Größenordnungen weniger ist als die Daten vor dem Training.

- Andere Arbeiten zur Feinabstimmung von Anweisungen belegen den Kontrast der Datensatzgröße zur Modellleistung. Beispielsweise beträgt die Feinabstimmung von Anweisungen bei Flan-PaLM nur 0,4 % die Berechnung vor dem Training. Im Allgemeinen sind die Unterrichtsdaten deutlich geringer als die Daten vor dem Training.

- Die komplexen Argumentationsfähigkeiten des Modells können jedoch durch Codedateninjektion während der Vortrainingsphase erfolgen.

- Der Maßstab des Codedatensatzes unterscheidet sich vom oben genannten Anleitungs-Feinabstimmungsfall. Die Menge an Codedaten ist hier groß genug, um einen erheblichen Teil der Trainingsdaten zu belegen (z. B. hat PaLM 8 % der Code-Trainingsdaten)

- Wie oben erwähnt, ist das Modell text-davinci-001 vor Code- Davinci-002 wurde nicht auf die Codedaten abgestimmt, daher ist seine Fähigkeit zur Argumentation/Denkkette sehr schlecht. Wie in der ersten Version des Dokuments zur Denkkette berichtet, ist es manchmal sogar schlechter als Code-Cushman. 001 mit einer geringeren Anzahl von Parametern.

- Der wahrscheinlich beste Weg, zwischen den Auswirkungen des Code-Trainings und der Feinabstimmung von Anweisungen zu unterscheiden, ist der Vergleich von code-cushman-001, T5 und FlanT5.

- Da sie ähnliche Modellgrößen (11 Milliarden und 12 Milliarden) und ähnliche Trainingsdatensätze (C4) haben, besteht der größte Unterschied zwischen ihnen darin, ob sie mit dem Code trainiert wurden/ob sie die Anweisungen gut ausgeführt haben -Tuning.

- Einen solchen Vergleich gibt es noch nicht. Wir überlassen dies der zukünftigen Forschung.

4. text-davinci-003 und ChatGPT, die Kraft des Reinforcement Learning from Human Feedback (RLHF)

Zum aktuellen Stand (Dezember 2022), text-davinci-002, gibt es nur wenige strenge statistische Vergleiche zwischen text-davinci-003 und ChatGPT, hauptsächlich weil:

- text-davinci-003 und ChatGPT zum Zeitpunkt des Schreibens seit weniger als einem Monat veröffentlicht sind.

- ChatGPT kann nicht über die OpenAI-API aufgerufen werden, daher ist das Testen anhand von Standard-Benchmarks umständlich.

Der Vergleich zwischen diesen Modellen basiert also eher auf der kollektiven Erfahrung der Forschungsgemeinschaft (statistisch gesehen nicht sehr streng). Wir glauben jedoch, dass vorläufige deskriptive Vergleiche immer noch Aufschluss über die Mechanismen des Modells geben können.

Uns fällt zunächst folgender Vergleich zwischen text-davinci-002, text-davinci-003 und ChatGPT auf:

- Alle drei Modelle sind mit Anleitungen fein abgestimmt.

- text-davinci-002 ist ein Modell, das mit überwachter Anweisungsoptimierung verfeinert wurde.

- text-davinci-003 und ChatGPT sind Instruction Tuning mit Reinforcement Learning from Human Feedback RLHF. Dies ist der bedeutendste Unterschied zwischen ihnen.

Das bedeutet, dass das Verhalten der meisten neuen Modelle ein Artefakt von RLHF ist.

Schauen wir uns also die Fähigkeiten des RLHF-Triggers an:

- Informative Antwort:text-davinci-003 dauert im Allgemeinen länger zum Generieren als text-davinci-002. Die Antwort von ChatGPT ist länger, sodass Benutzer explizit „Antworten Sie mir in einem Satz“ fragen müssen, um eine prägnantere Antwort zu erhalten. Dies ist ein direktes Ergebnis von RLHF.

- Gerechte Reaktion:ChatGPT gibt normalerweise sehr ausgewogene Antworten auf Ereignisse, die die Interessen mehrerer Einheiten betreffen, wie z. B. politische Ereignisse. Dies ist ebenfalls ein Produkt von RLHF.

- Ablehnung unangemessener Themen:Dies ist eine Kombination aus Inhaltsfiltern und den eigenen Fähigkeiten des Modells, die durch RLHF ausgelöst werden, wobei der Filter einen Teil herausfiltert und das Modell dann einen Teil ablehnt.

- Fragen ablehnen, die außerhalb seines Wissens liegen:Zum Beispiel neue Ereignisse ablehnen, die nach Juni 2021 aufgetreten sind (da es danach nicht auf Daten trainiert wurde). Dies ist der erstaunlichste Teil von RLHF, da er es dem Modell ermöglicht, implizit zu unterscheiden, welche Probleme in seinem Kenntnisbereich liegen und welche nicht.

Es gibt zwei Dinge, die es zu beachten gilt:

- Alle Fähigkeiten sind dem Modell inhärent und werden nicht durch RLHF injiziert. Was RLHF tut, ist das Auslösen/Freischalten auftauchender Fähigkeiten. Dieses Argument ergibt sich hauptsächlich aus dem Vergleich der Datengröße: Verglichen mit der Menge vorab trainierter Daten beansprucht RLHF viel weniger Rechenleistung/Daten.

- Das Modell weiß, was es nicht weiß, nicht indem es Regeln schreibt, sondern indem es es durch RLHF freischaltet. Dies ist ein sehr überraschender Befund, da das ursprüngliche Ziel von RLHF darin bestand, das Modell Antworten generieren zu lassen, die die menschlichen Erwartungen verstärken. Dabei ging es mehr darum, dass das Modell sichere Sätze generiert, als das Modell wissen zu lassen, was es nicht wusste.

Was hinter den Kulissen vor sich geht, könnte sein:

- ChatGPT: Opfern Sie die Fähigkeit, den Kontext zu lernen, im Austausch für die Fähigkeit, den Gesprächsverlauf zu modellieren. Dies ist eine empirische Beobachtung, da ChatGPT offenbar nicht so stark von der kontextuellen Präsentation beeinflusst wird wie text-davinci-003.

- text-davinci-003: Stellt die durch text-davinci-002 geopferte Kontextlernfähigkeit wieder her und verbessert die Fähigkeit von Nullproben. Laut dem instructGPT-Papier ist dies auf die Optimierungsphase des verstärkenden Lernens zurückzuführen, die mit dem Ziel der Sprachmodellierung verknüpft ist (und nicht auf RLHF selbst).

5. Zusammenfassung des Evolutionsprozesses von GPT-3.5 im aktuellen Stadium

Bisher haben wir alle Fähigkeiten, die entlang des Evolutionsbaums aufgetaucht sind, sorgfältig untersucht. Die folgende Tabelle fasst den Evolutionspfad zusammen:

Wir können schlussfolgern:

- Fähigkeit zur Spracherzeugung + grundlegendes Weltwissen + Kontextlernen stammen alle aus der Vorschulung (davinci).

- Die Fähigkeit, große Wissensmengen zu speichern, ergibt sich aus der Menge von 175 Milliarden Parametern.

- Die Fähigkeit, Anweisungen zu befolgen und auf neue Aufgaben zu verallgemeinern, ergibt sich aus der Erweiterung der Anzahl von Anweisungen beim Instruktionslernen (Davinci-instruct-beta).

- Die Fähigkeit, komplexe Überlegungen anzustellen, kommt wahrscheinlich vom Code-Training (code-davinci-002).

- Die Fähigkeit, neutrale, objektive, sichere und informative Antworten zu generieren, entsteht durch die Abstimmung mit Menschen. Konkret:

- Wenn es sich um die überwachte Lernversion handelt, ist das resultierende Modell text-davinci-002.

- Wenn es sich um die Reinforcement-Learning-Version (RLHF) handelt, ist das resultierende Modell text-davinci-003.

- Ob überwacht oder RLHF, die Leistung des Modells kann bei vielen Aufgaben Code-Davinci-002 nicht überschreiten. Dieses Phänomen der Leistungsverschlechterung aufgrund der Ausrichtung wird als Ausrichtung bezeichnet Steuer.

- Die Dialogfähigkeit kommt auch von RLHF (ChatGPT). Insbesondere opfert es die Fähigkeit des Kontextlernens Austausch gegen:

- Konversationsverlauf modellieren.

- Erhöhen Sie die Menge an Gesprächsinformationen.

- Fragen ablehnen, die außerhalb des Bereichs des Modellwissens liegen.

6. Was GPT-3.5 derzeit nicht kann

Obwohl GPT-3.5 ein wichtiger Schritt in der Forschung zur Verarbeitung natürlicher Sprache ist , aber es enthält nicht ganz alle wünschenswerten Eigenschaften, die sich viele Forscher, einschließlich AI2, vorgestellt haben. Im Folgenden sind einige wichtige Eigenschaften aufgeführt, die GPT-3.5 nicht hat:

- Umschreiben Sie die Überzeugungen des Modells in Echtzeit:Wenn ein Modell eine Überzeugung über etwas zum Ausdruck bringt und diese Überzeugung falsch ist, kann es für uns schwierig sein, sie zu korrigieren:

- Ein Beispiel, auf das ich kürzlich gestoßen bin, war : ChatGPT besteht darauf, dass 3599 eine Primzahl ist, obwohl es zugibt, dass 3599 = 59 * 61. Sehen Sie sich auch dieses Reddit-Beispiel des am schnellsten schwimmenden Meeressäugetiers an.

- Allerdings scheint es unterschiedliche Stärkegrade des Modellglaubens zu geben. Ein Beispiel ist: Selbst wenn ich sage, dass Darth Vader (die Figur aus den Star Wars-Filmen) die Wahl 2020 gewonnen hat, wird das Modell immer noch denken, dass der derzeitige Präsident der Vereinigten Staaten Biden ist. Aber wenn ich das Wahljahr auf 2024 ändere, denkt es, dass der Präsident Darth Vader ist, und ist der Präsident im Jahr 2026.

- Formales Denken:Die GPT-3.5-Reihe kann nicht in formal strengen Systemen wie Mathematik oder Logik erster Ordnung argumentieren:

- In der Literatur zur Verarbeitung natürlicher Sprache wird das Wort „Inferenz“ verwendet Die Definition von ist oft unklar. Aber wenn wir es zum Beispiel aus der Perspektive der Mehrdeutigkeit betrachten, sind einige Fragen (a) sehr zweideutig und ohne Begründung; (b) sie enthalten ein wenig Logik, können aber an manchen Stellen auch vage sein; c) sehr streng und darf keine Mehrdeutigkeit aufweisen.

- Dann kann das Modell Typ (b)-Argumentation mit Mehrdeutigkeit sehr gut durchführen. Beispiele sind:

- Generieren Sie, wie man Tofu Nao macht. Bei der Zubereitung von Tofu-Puffs ist es akzeptabel, in vielen Schritten etwas unklar zu sein, beispielsweise ob der Geschmack salzig oder süß sein soll. Solange die Gesamtschritte ungefähr stimmen, ist der Tofu-Quark essbar.

- Ideen zum Beweis mathematischer Theoreme. Die Beweisidee ist eine informelle Schritt-für-Schritt-Lösung, die in der Sprache ausgedrückt wird, und die strikte Ableitung jedes Schritts muss nicht zu spezifisch sein. Der Beweisgedanke wird im Mathematikunterricht häufig verwendet: Solange der Lehrer einen ungefähr korrekten Gesamtschritt angibt, können die Schüler ihn ungefähr verstehen. Dann weist der Lehrer den Schülern die spezifischen Beweisdetails als Hausaufgabe zu und die Antworten werden weggelassen.

- GPT-3.5 kann keine Inferenz vom Typ (c) durchführen (Inferenz kann keine Mehrdeutigkeit tolerieren).

- Ein Beispiel ist ein strenger mathematischer Beweis, der erfordert, dass Zwischenschritte nicht übersprungen, unscharf oder falsch sein dürfen.

- Aber ob diese Art der strengen Argumentation durch Sprachmodelle oder symbolische Systeme erfolgen sollte, muss noch diskutiert werden. Ein Beispiel ist, dass Sie, anstatt zu versuchen, GPT dazu zu bringen, dreistellige Additionen durchzuführen, einfach Python aufrufen.

- Abruf aus dem Internet:GPT-3.5-Serie (vorübergehend) kann nicht direkt im Internet suchen.

- Aber es gibt ein im Dezember 2021 veröffentlichtes WebGPT-Papier, das es GPT ermöglicht, die Suchmaschine aufzurufen. Daher wurden die Abruffunktionen innerhalb von OpenAI getestet.

- Der Punkt, der hier unterschieden werden muss, ist, dass die beiden wichtigen, aber unterschiedlichen Fähigkeiten von GPT-3.5 Wissen und Argumentation sind. Im Allgemeinen wäre es schön, wenn wir den Wissensteil auf ein externes Abrufsystem auslagern könnten und das Sprachmodell sich nur auf das Denken konzentrieren könnte. Denn:

- Das interne Wissen des Modells wird immer irgendwann abgeschnitten. Models benötigen immer das neueste Wissen, um die neuesten Fragen zu beantworten.

- Erinnern Sie sich daran, dass wir besprochen haben, dass 175 Milliarden Parameter in großem Umfang zum Speichern von Wissen verwendet werden. Wenn wir das Wissen außerhalb des Modells auslagern könnten, könnten die Modellparameter so weit reduziert werden, dass es schließlich sogar auf Mobiltelefonen laufen könnte (verrückte Idee, aber ChatGPT ist Science-Fiction genug, wer weiß, was die Zukunft bringt).

7. Fazit

In diesem Blogbeitrag haben wir den Funktionsumfang der GPT-3.5-Serie sorgfältig untersucht und die Quellen aller ihrer neuen Funktionen ermittelt.

Das GPT-3-Modell der ersten Generation erhält generative Fähigkeiten, Weltwissen und kontextbezogenes Lernen durch Vortraining. Durch den Modellzweig der Anweisungsoptimierung erlangten wir dann die Fähigkeit, Anweisungen zu befolgen und auf unsichtbare Aufgaben zu verallgemeinern. Das durch den Code trainierte Verzweigungsmodell erhält die Fähigkeit, den Code zu verstehen. Als Nebenprodukt des Codetrainings erhält das Modell möglicherweise auch die Fähigkeit, komplexe Überlegungen anzustellen.

Durch die Kombination dieser beiden Zweige scheint code-davinci-002 das stärkste GPT-3.5-Modell mit allen großartigen Funktionen zu sein. Als nächstes wird durch überwachte Befehlsoptimierung und RLHF die Modellfähigkeit im Austausch für die menschliche Ausrichtung, also die Ausrichtungssteuer, geopfert. RLHF ermöglicht es dem Modell, informativere und unvoreingenommenere Antworten zu generieren und gleichzeitig Fragen außerhalb seines Wissensbereichs abzulehnen.

Wir hoffen, dass dieser Artikel dazu beitragen kann, ein klares Bild der GPT-Bewertung zu vermitteln und einige Diskussionen über Sprachmodelle, Befehlsoptimierung und Codeoptimierung anzustoßen. Vor allem hoffen wir, dass dieser Artikel als Roadmap für die Replikation von GPT-3.5 innerhalb der Open-Source-Community dienen kann.

FAQ

- Sind die Aussagen in diesem Artikel eher eine Hypothese oder eine Schlussfolgerung?

- Die Fähigkeit, komplexe Schlussfolgerungen zu ziehen, kommt vom Code-Training, ist eine Annahme, die wir eher glauben.

- Die Fähigkeit, auf ungesehene Aufgaben zu verallgemeinern, ergibt sich aus umfangreichem Unterrichtslernen, ist das Fazit von mindestens 4 Arbeiten.

- Es ist eine fundierte Vermutung, dass GPT-3.5 von anderen großen Basismodellen stammt, nicht vom GPT-3 mit 175 Milliarden Parametern.

- All diese Fähigkeiten sind bereits vorhanden, egal ob es sich um überwachtes Lernen oder bestärkendes Lernen handelt, anstatt sie einzubauen, ist eine starke Annahme, so stark, dass man es nicht zu glauben wagt. Hauptsächlich, weil die Menge an Befehlsoptimierungsdaten um mehrere Größenordnungen geringer ist als die Menge an Vortrainingsdaten.

- Schlussfolgerung = Viele Beweise, die die Gültigkeit dieser Behauptungen stützen; Hypothese = Positive Beweise, aber nicht stark genug; Fundierte Vermutung = Keine eindeutigen Beweise, aber bestimmte Faktoren würden in diese Richtung weisen

- Warum sonst Modelle? (wie OPT und BLOOM) nicht so mächtig?

- OPT liegt wahrscheinlich daran, dass der Trainingsprozess zu instabil ist.

- BLOOMs Situation ist unbekannt.

Das obige ist der detaillierte Inhalt vonWarum wurde ChatGPT plötzlich so mächtig? Der lange Artikel eines chinesischen Arztes mit 10.000 Wörtern untersucht eingehend den Ursprung der GPT-3.5-Funktionen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

ChatGPT-Registrierung

ChatGPT-Registrierung Inländische kostenlose ChatGPT-Enzyklopädie

Inländische kostenlose ChatGPT-Enzyklopädie So installieren Sie ChatGPT auf einem Mobiltelefon

So installieren Sie ChatGPT auf einem Mobiltelefon Kann Chatgpt in China verwendet werden?

Kann Chatgpt in China verwendet werden? RGB in hexadezimales RGB umwandeln

RGB in hexadezimales RGB umwandeln Wie richte ich WeChat so ein, dass meine Zustimmung erforderlich ist, wenn mich jemand zu einer Gruppe hinzufügt?

Wie richte ich WeChat so ein, dass meine Zustimmung erforderlich ist, wenn mich jemand zu einer Gruppe hinzufügt? Einführung in die Lightning-Schnittstelle

Einführung in die Lightning-Schnittstelle Was tun, wenn Chrome keine Plugins laden kann?

Was tun, wenn Chrome keine Plugins laden kann?