Autonomes Fahren ist ein schrittweiser Übergang von der Vorhersagephase zur Industrialisierungsphase. Die spezifische Leistung kann in vier Punkte unterteilt werden. Erstens nimmt der Umfang der Datensätze im Zusammenhang mit Big Data rapide zu. Dadurch werden Details von Prototypen, die zuvor an kleinen Datensätzen entwickelt wurden, weitgehend herausgefiltert und nur Arbeiten durchgeführt, die bei großen Datensätzen effektiv sein können -Maßstabsdaten bleiben übrig. Der zweite Grund ist der Wechsel des Fokus von monokularen zu Multiview-Szenen, was zu einer Erhöhung der Komplexität führt. Hinzu kommt die Tendenz zu anwendungsfreundlichen Designs, etwa der Verlagerung des Ausgaberaums vom Bildraum in den BEV-Raum.

Schließlich sind wir vom reinen Streben nach Genauigkeit zu einer schrittweisen Berücksichtigung der Inferenzgeschwindigkeit übergegangen. Gleichzeitig ist in autonomen Fahrszenarien eine schnelle Reaktion erforderlich, sodass die Leistungsanforderungen die Geschwindigkeit berücksichtigen. Darüber hinaus wird stärker berücksichtigt, wie die Bereitstellung auf Edge-Geräten erfolgt.

Ein weiterer Hintergrund ist, dass sich die visuelle Wahrnehmung in den letzten 10 Jahren durch Deep Learning rasant weiterentwickelt hat. Es gab viel Arbeit und einige recht ausgereifte Paradigmen in Mainstream-Richtungen wie Klassifizierung, Erkennung und Segmentierung . Im Entwicklungsprozess der visuellen Wahrnehmung in autonomen Fahrszenarien wurden Aspekte wie die Zieldefinition der Merkmalskodierung, das Wahrnehmungsparadigma und die Überwachung stark von diesen Hauptrichtungen übernommen. Daher sollten diese Hauptrichtungen untersucht werden, bevor man sich auf die Wahrnehmung des autonomen Fahrens einlässt. Probieren Sie ein bisschen.

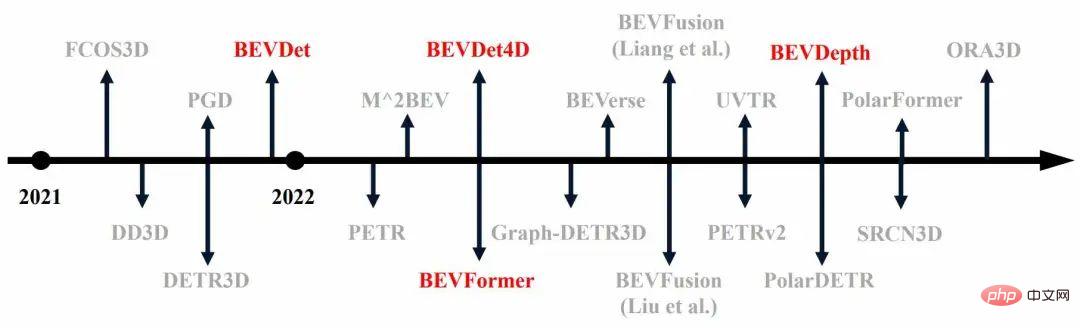

Vor diesem Hintergrund sind im vergangenen Jahr zahlreiche 3D-Zielerkennungsarbeiten an großen Datensätzen entstanden, wie in Abbildung 1 dargestellt (die rot markierten sind die ersten Algorithmen).检 Abbildung 1 Dreidimensionale Zielerkennung im vergangenen Jahr

Heben

Heben

🎜🎜🎜🎜🎜🎜🎜 Der Unterschied zwischen visueller Wahrnehmung und visueller Mainstream-Wahrnehmung des Mainstreams Der Unterschied liegt im gegebenen Zieldefinitionsraum. Das Ziel der visuellen Mainstream-Wahrnehmung wird im Bildraum definiert, und das Ziel von Die autonome Fahrszene wird im dreidimensionalen Raum definiert. Wenn es sich bei den Eingaben ausschließlich um Bilder handelt, ist zum Erhalten der Ergebnisse im dreidimensionalen Raum ein Lift-Prozess erforderlich. Dies ist das Kernproblem der visuellen Wahrnehmung beim autonomen Fahren. 🎜🎜🎜🎜Wir können die Methode zur Lösung des Lift-Objektproblems in Eingabe, Zwischenmerkmale und Ausgabe unterteilen. Ein Beispiel für die Eingabeebene ist die Verwendung des Bildes, um über die Tiefeninformationen nachzudenken und diese dann zu verwenden Konvertieren Sie die Tiefeninformationen in den RGB-Wert des Bildes in einen dreidimensionalen Raum, um eine farbige Punktwolke zu erhalten, und folgen Sie dann der zugehörigen Arbeit der Punktwolkenerkennung. 🎜🎜🎜🎜Derzeit sind die vielversprechenderen Transformationen auf Feature-Ebene oder der Lift auf Feature-Ebene, wie z. B. DETR3D, die alle räumliche Änderungen auf Feature-Ebene durchführen. Der Vorteil der Transformation auf Feature-Ebene besteht darin, dass eine wiederholte Extraktion vermieden werden kann Die geringe Menge an Funktionen und Berechnungen auf Bildebene kann auch das Problem der Fusion von Lookaround-Ergebnissen auf Ausgabeebene vermeiden. Natürlich weist die Konvertierung auf Funktionsebene auch einige typische Probleme auf, z. B. werden normalerweise einige seltsame OPs verwendet, was die Bereitstellung unfreundlich macht. 🎜🎜🎜🎜Derzeit basiert der relativ robuste Lift-Prozess auf Feature-Ebene hauptsächlich auf Strategien für Tiefen- und Aufmerksamkeitsmechanismen. Die repräsentativen Strategien sind BEVDet bzw. DETR3D. Die tiefenbasierte Strategie besteht darin, einen Lift-Prozess abzuschließen, indem die Tiefe jedes Bildpunkts berechnet und die Merkmale dann gemäß dem Bildmodell der Kamera in einen dreidimensionalen Raum projiziert werden. Die auf dem Aufmerksamkeitsmechanismus basierende Strategie besteht darin, ein Objekt im dreidimensionalen Raum als Abfrage vorzudefinieren, die dem Mittelpunkt des dreidimensionalen Raums entsprechenden Bildmerkmale als Schlüssel und Wert über interne und externe Parameter zu finden und dann zu berechnen ein dreidimensionales Objekt durch Aufmerksamkeit. Eine Eigenschaft eines Objekts im Raum. 🎜🎜🎜🎜Alle aktuellen Algorithmen sind grundsätzlich stark abhängig von Kameramodellen, egal ob tiefenbasiert oder aufmerksamkeitsbasiert, was zu Kalibrierungsempfindlichkeit und allgemein komplexen Berechnungsprozessen führt. Algorithmen, die auf Kameramodelle verzichten, sind oft nicht robust genug, sodass dieser Aspekt noch nicht vollständig ausgereift ist. 🎜🎜

Zeitliche (zeitliche) Informationen können gültig sein Verbessern Sie den Effekt der Zielerkennung. Für autonome Fahrszenarien hat das Timing eine tiefere Bedeutung, da die Geschwindigkeit des Ziels eines der Hauptwahrnehmungsziele im aktuellen Szenario ist. Der Schwerpunkt der Geschwindigkeit liegt auf der Änderung. Da einzelne Frame-Daten nicht über ausreichende Änderungsinformationen verfügen, ist eine Modellierung erforderlich, um Änderungsinformationen in der Zeitdimension bereitzustellen. Die bestehende Methode zur Modellierung von Punktwolken-Zeitreihen besteht darin, die Punktwolken mehrerer Frames als Eingabe zu mischen, sodass eine relativ dichte Punktwolke erhalten werden kann, wodurch die Erkennung genauer wird. Darüber hinaus enthalten Multi-Frame-Punktwolken kontinuierliche Informationen. Später, während des Netzwerktrainingsprozesses, wird BP verwendet, um zu lernen, wie diese kontinuierlichen Informationen extrahiert werden, um Aufgaben wie Geschwindigkeitsschätzungen zu lösen, die kontinuierliche Informationen erfordern.

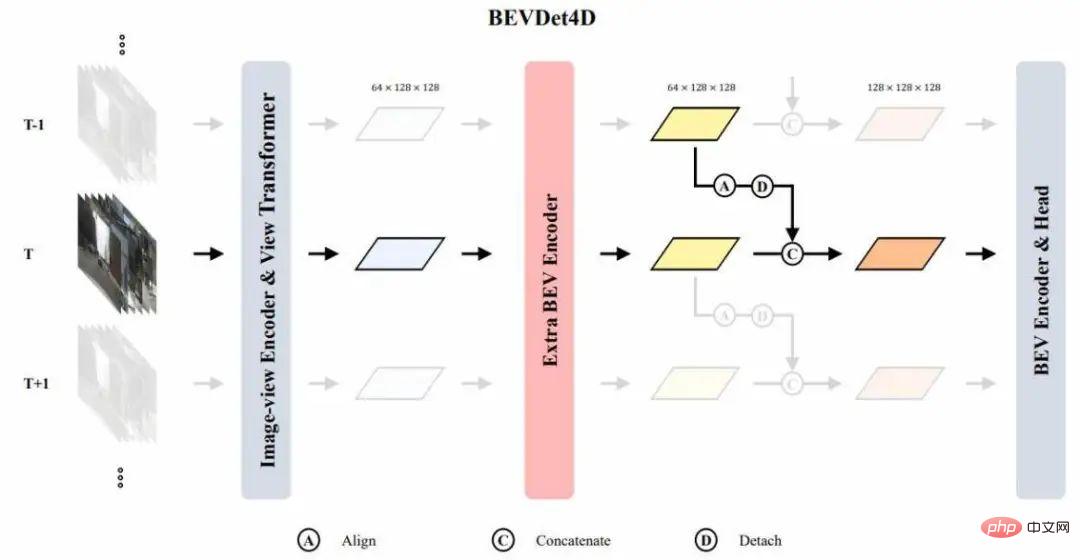

Die Timing-Modellierungsmethode der visuellen Wahrnehmung stammt hauptsächlich von BEVDet4D und BEVFormer. BEVDet4D stellt kontinuierliche Informationen für nachfolgende Netzwerke bereit, indem einfach ein Feature aus zwei Frames zusammengeführt wird. Der andere Weg basiert auf Aufmerksamkeit, indem er sowohl Einzelzeitrahmen- als auch Gegenuhrzeigersinnsmerkmale als Abfrageobjekt bereitstellt und diese beiden Merkmale dann gleichzeitig durch Aufmerksamkeit abfragt, um Zeitinformationen zu extrahieren.

Visuelle Wahrnehmung beim autonomen Fahren im Vergleich zur Radarwahrnehmung Eins Einer der größten Nachteile ist die Genauigkeit der Tiefenschätzung. Der Artikel „Probabilistische und geometrische Tiefe: Objekte in der Perspektive erkennen“ untersucht den Einfluss verschiedener Faktoren auf die Leistungsbewertung durch Ersetzen der GT-Methode. Die wichtigste Schlussfolgerung aus der Analyse ist, dass eine genaue Tiefenschätzung erhebliche Leistungsverbesserungen bringen kann.

Aber die Tiefenschätzung ist ein großer Engpass in der aktuellen visuellen Wahrnehmung. Derzeit gibt es zwei Möglichkeiten, sie zu verbessern. Eine besteht darin, geometrische Einschränkungen zur Vorhersage von PGD zu verwenden. Die Tiefenkarte wurde verfeinert. Die andere besteht darin, Lidar als Überwachung zu verwenden, um eine robustere Tiefenschätzung zu erhalten.

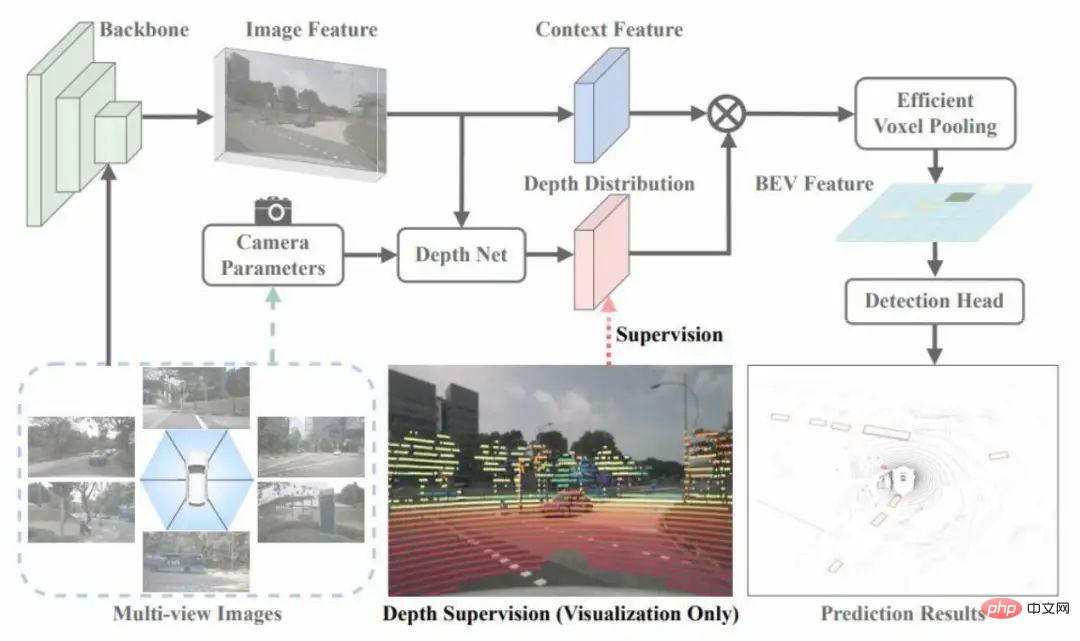

Die derzeit überlegene Lösung im Prozess, BEVDepth, verwendet die von Lidar während des Trainingsprozesses bereitgestellten Tiefeninformationen, um die Tiefenschätzung während des Änderungsprozesses zu überwachen Wahrnehmungsaufgaben werden gleichzeitig ausgeführt.

Multitasking bedeutet, eine Vielzahl von Wahrnehmungsaufgaben in einem einheitlichen Rahmen zu erledigen. Durch diese Berechnung kann der Zweck erreicht werden, Ressourcen zu sparen oder das rechnerische Denken zu beschleunigen. Die aktuellen Methoden erreichen jedoch grundsätzlich Multitasking, indem sie die Funktionen einfach auf verschiedenen Ebenen verarbeiten, nachdem sie eine einheitliche Funktion erhalten haben. Nach dem Zusammenführen von Aufgaben tritt häufig das Problem der Leistungseinbuße auf. Multimodalität ist nahezu universell, wenn es darum geht, eine Form zu finden, die direkt im gesamten Urteil verschmolzen werden kann, und dann eine einfache Verschmelzung zu erreichen 🎜🎜#BEVDet-Netzwerk ist in Abbildung 2 dargestellt. Der Merkmalsextraktionsprozess besteht hauptsächlich darin, ein Merkmal des extrahierten Bildraums in ein BEV-Raummerkmal umzuwandeln und dieses Merkmal dann weiter zu kodieren, um ein Merkmal zu erhalten, das zur Vorhersage verwendet werden kann Verwenden Sie schließlich eine dichte Vorhersage, um das Ziel vorherzusagen.

Der Prozess des Perspektivenänderungsmoduls ist in zwei Schritte unterteilt. Zunächst wird angenommen, dass die Größe des zu transformierenden Merkmals VxCxHxW ist, und dann wird eine Tiefe im Bildraum auf Klassifizierungsmethode vorhergesagt. und für jede Pixelverteilung wird eine D-dimensionale Tiefe erhalten, dann können Sie diese beiden verwenden, um Merkmale unterschiedlicher Tiefe zu rendern, um ein visuelles Merkmal zu erhalten, und es dann mit dem Kameramodell in einen dreidimensionalen Raum zu projizieren und die 3 zu voxelisieren -dimensionalen Raum und führen Sie dann den Splat-Prozess durch, um die BEV-Funktion zu erhalten.

Ein sehr wichtiges Merkmal des Perspektivwechselmoduls ist, dass es bei der Datenverlangsamung eine gegenseitige Isolationsrolle spielt. Insbesondere kann durch die internen Parameter der Kamera ein Punkt im Kamerakoordinatensystem erhalten werden, indem er in einen dreidimensionalen Raum projiziert wird, wenn die Datenerweiterung auf einen Punkt im Bildraum angewendet wird, um die Koordinaten beizubehalten Der Punkt im Kamerakoordinatensystem ist invariant. Sie müssen eine umgekehrte Transformation durchführen, dh eine Koordinate im Kamerakoordinatensystem bleibt vor und nach der Erweiterung unverändert, was einen gegenseitigen Isolationseffekt hat. Der Nachteil der gegenseitigen Isolation besteht darin, dass die Erweiterung des Bildraums das Lernen des BEV-Raums nicht reguliert. Der Vorteil kann die Robustheit des BEV-Raumlernens verbessern

Zusammenfassend können wir aus Experimenten mehrere wichtige Punkte gewinnen. Erstens ist es nach der Verwendung des BEV-Raumencoders wahrscheinlicher, dass der Algorithmus in eine Überanpassung gerät. Eine weitere Schlussfolgerung ist, dass die Erweiterung des BEV-Speicherplatzes einen größeren Einfluss auf die Leistung haben wird als die Erweiterung des Bildspeicherplatzes.

Es besteht auch ein Zusammenhang zwischen der Zielgröße des BEV-Raums und der Kategoriehöhe. Gleichzeitig wird beobachtet, dass die geringe Überlappungslänge zwischen den Zielen einige Probleme verursacht Der Bildraum ist nicht optimal. Der Kern der simultanen Beschleunigungsstrategie besteht darin, mithilfe paralleler Rechenmethoden unabhängige Threads verschiedenen kleinen Rechenaufgaben zuzuweisen, um den Zweck der parallelen Rechenbeschleunigung zu erreichen. Der Vorteil besteht darin, dass kein zusätzlicher Videospeicheraufwand entsteht. Die Netzwerkstruktur von BEVDet4D ist in Abbildung 3 dargestellt. Der Schwerpunkt dieses Netzwerks liegt auf der Anwendung der Features des Reverse-Time-Frames auf den aktuellen Frame. Wir wählen das Eingabe-Feature als beibehaltenes Objekt, wählen dieses Bild-Feature jedoch nicht, da die Zielvariablen im BEV-Raum definiert sind , und die Bildeigenschaften sind nicht für die direkte Timing-Modellierung geeignet. Gleichzeitig werden die Features hinter dem BEV-Encoder nicht als kontinuierliche Fusionsfeatures ausgewählt, da wir im BEV-Encoder ein kontinuierliches Feature extrahieren müssen.

Abbildung 3 BEVDet4D-Netzwerkstruktur

Wie entwerfe ich Zielvariablen, die zur Netzwerkstruktur passen? Zuvor müssen wir zunächst einige Schlüsselmerkmale des Netzwerks verstehen. Das erste ist das Empfangsfeld des Features. Da das Netzwerk durch BP lernt, wird das Empfangsfeld des Features durch den Ausgaberaum bestimmt.

Wenn die beiden Features direkt miteinander verbunden sind, sind die Positionen des statischen Ziels in den beiden Feature-Maps unterschiedlich und der Versatz des dynamischen Ziels in den beiden Feature-Maps ist gleich dem Versatz des selbst- test plus Der Versatz des oberen dynamischen Ziels im Weltkoordinatensystem. Gemäß dem Prinzip der Musterkonsistenz sollte es sich bei der Festlegung des Lernziels des Netzwerks um die Änderung der Position des Ziels in diesen handeln, da der Versatz des Ziels in den gespleißten Merkmalen mit dem eigenen Fahrzeug zusammenhängt zwei Feature-Maps.

Nach der folgenden Formel lässt sich ableiten, dass ein Lernziel nicht mit der Selbsttestbewegung zusammenhängt, sondern nur mit der Bewegung des Ziels im Weltkoordinatensystem.

Der Unterschied zwischen den Lernzielen, die wir oben abgeleitet haben, und den Lernzielen aktueller Mainstream-Methoden besteht darin, dass die Zeitkomponente entfernt wird und die Geschwindigkeit gleich der Verschiebung/Zeit ist, diese beiden Merkmale jedoch schon Es werden keine zeitbezogenen Hinweise bereitgestellt. Wenn Sie also das Ziel dieser Geschwindigkeit lernen möchten, muss das Netzwerk die Zeitkomponente genau schätzen, was die Lernschwierigkeit erhöht. In der Praxis können wir die Zeit zwischen zwei Frames während des Trainingsprozesses als konstanten Wert festlegen. Ein Netzwerk mit konstanten Zeitintervallen kann durch Lernen von BP erlernt werden.

Bei der Erweiterung des Zeitbereichs verwenden wir während des Trainingsprozesses zufällig unterschiedliche Zeitintervalle. In unterschiedlichen Zeitintervallen liegt das Ziel in den beiden Bildern Das Modell ist unterschiedlich und der Zielversatz des Lernens ist ebenfalls unterschiedlich, um den Lupineneffekt des Modells bei unterschiedlichen Versätzen zu erzielen. Gleichzeitig weist das Modell eine gewisse Empfindlichkeit gegenüber dem Versatz des Ziels auf. Das heißt, wenn das Intervall zu klein ist, ist die Änderung zwischen zwei Bildern schwer zu erkennen, wenn es zu klein ist. Daher kann die Wahl eines geeigneten Zeitintervalls während des Tests die Generalisierungsleistung des Modells effektiv verbessern.

#🎜. 🎜# In diesem Artikel wird Radar verwendet, um eine robuste Tiefenschätzung zu erhalten, wie in Abbildung 4 dargestellt. Es verwendet Punktwolken zur Überwachung der Tiefenverteilung im Änderungsmodul. Diese Überwachung ist im Vergleich zur vom Ziel bereitgestellten Tiefenüberwachung dicht, aber sie erreicht auch nicht jedes Pixel. Es können jedoch mehr Stichproben bereitgestellt werden, um die Generalisierungsleistung dieser Tiefenschätzung zu verbessern.

Abbildung 4 BEVTiefennetzwerkstruktur # 🎜🎜#

Ein weiterer Aspekt dieser Arbeit besteht darin, das Merkmal und die Tiefe zur Schätzung in zwei Zweige zu unterteilen und dem Tiefenschätzungszweig ein zusätzliches Restnetzwerk hinzuzufügen, um das Empfangsfeld des Tiefenschätzungszweigs zu vergrößern. Forscher gehen davon aus, dass die Genauigkeit der internen und externen Parameter der Kamera zu einer Fehlausrichtung von Kontext und Tiefe führt. Wenn das Tiefenschätzungsnetzwerk nicht leistungsfähig genug ist, kommt es zu einem gewissen Genauigkeitsverlust.Schließlich werden die internen Parameter dieser Kamera als Zweigeingabe der Tiefenschätzung verwendet, wobei eine NSE-ähnliche Methode verwendet wird, um eine Analyse der Kanäle auf Kanalebene durchzuführen Anpassung der Eingabefunktionen, die die Robustheit des Netzwerks gegenüber verschiedenen kamerainternen Parametern effektiv verbessern kann.

Einschränkungen und damit verbundene Diskussionen

Zuallererst dient die visuelle Wahrnehmung des autonomen Fahrens letztendlich der Bereitstellung, die während der Bereitstellung mit Datenproblemen verbunden sein wird und Modellfragen. Das Datenproblem beinhaltet ein Diversitätsproblem und Datenannotationen, da manuelle Annotationen sehr teuer sind. Daher werden wir sehen, ob in Zukunft automatisierte Annotationen erreicht werden können.Die Beschriftung dynamischer Ziele ist derzeit beispiellos. Bei statischen Zielen kann die 3D-Rekonstruktion verwendet werden, um eine teilweise oder halbautomatische Beschriftung zu erhalten. Was die Modelle betrifft, ist das aktuelle Modelldesign nicht robust gegenüber der Kalibrierung oder reagiert empfindlich auf die Kalibrierung. Daher ist es auch eine Frage, darüber nachzudenken, wie das Modell robust gegenüber der Kalibrierung oder unabhängig von der Kalibrierung gemacht werden kann.

Das andere ist das Problem der Netzwerkstrukturbeschleunigung. Kann ein allgemeiner OP verwendet werden, um Perspektivenänderungen zu erreichen, und dieses Problem wirkt sich auf den Netzwerkbeschleunigungsprozess aus.

Das obige ist der detaillierte Inhalt vonEine kurze Analyse der neuesten technischen Wege für visuelles autonomes Fahren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!