Autor |. Migüel Jetté

Zusammengestellt |. bluemin

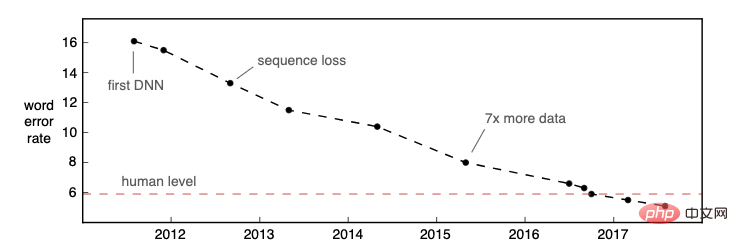

Herausgeber |. Die automatische Spracherkennung (Automatic Speech Recognition, ASR) hat in den letzten zwei Jahren wichtige Fortschritte gemacht: Mehrere ASR-Modelle auf Unternehmensebene, die vollständig auf neuronalen Netzen basieren, wurden erfolgreich eingeführt, z. B. Alexa, Rev, AssemblyAI, ASAPP usw. Im Jahr 2016 veröffentlichte Microsoft Research einen Artikel, in dem bekannt gegeben wurde, dass ihr Modell auf dem 25 Jahre alten Datensatz „Switchboard“ die Leistung eines Menschen erreicht hat (gemessen an der Wortfehlerrate). Die ASR-Genauigkeit verbessert sich weiter und erreicht bei immer mehr Datensätzen und Anwendungsfällen eine Leistung auf menschlichem Niveau.

Bildquelle: Awni Hannuns Blogbeitrag „Spracherkennung ist nicht gelöst“

Bildquelle: Awni Hannuns Blogbeitrag „Spracherkennung ist nicht gelöst“

Da sich die Erkennungsgenauigkeit der ASR-Technologie erheblich verbessert hat und die Anwendungsszenarien immer zahlreicher geworden sind, glauben wir: Jetzt ist es nicht so Der Höhepunkt der kommerziellen Nutzung von ASR ist noch nicht erreicht. Forschung und Marktanwendungen in diesem Bereich müssen noch erforscht werden. Wir gehen davon aus, dass sich KI-Sprachforschung und kommerzielle Systeme in den nächsten zehn Jahren auf die folgenden fünf Bereiche konzentrieren werden:

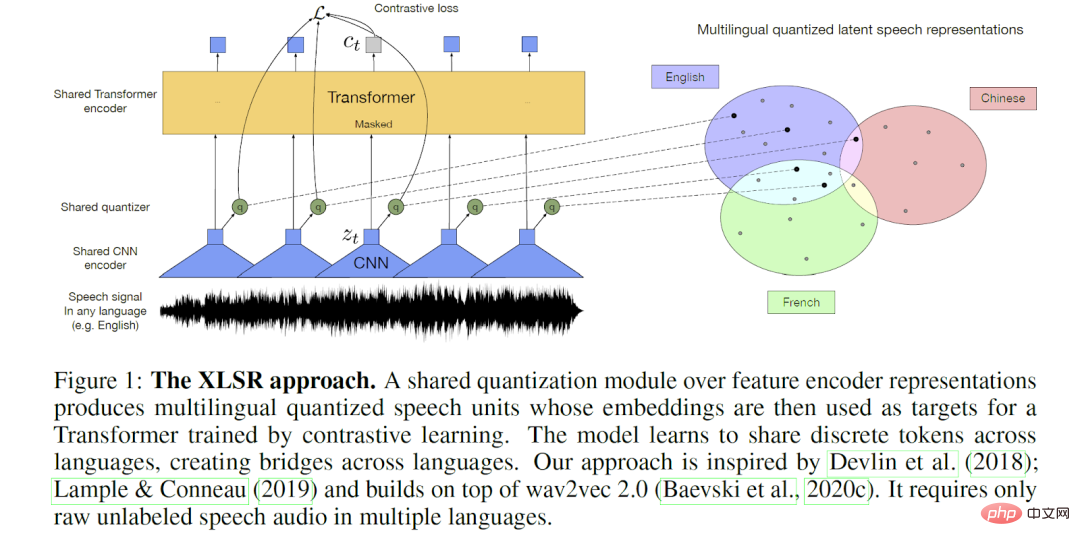

1. Mehrsprachiges ASR-Modell

Quelle: Alexis Conneau et al Repräsentationslernen für die Spracherkennung“-Papier

Quelle: Alexis Conneau et al Repräsentationslernen für die Spracherkennung“-Papier

Heutige kommerzielle ASR-Modelle verwenden hauptsächlich englische Datensätze für das Training, sodass sie eine höhere Genauigkeit für die englische Eingabe aufweisen. Aufgrund der Datenverfügbarkeit und der Marktnachfrage besteht in Wissenschaft und Industrie langfristig ein größeres Interesse an Englisch. Obwohl die Erkennungsgenauigkeit beliebter kommerzieller Sprachen wie Französisch, Spanisch, Portugiesisch und Deutsch ebenfalls angemessen ist, gibt es eindeutig eine lange Reihe von Sprachen mit begrenzten Trainingsdaten und relativ geringer ASR-Ausgabequalität.

Darüber hinaus basieren die meisten Geschäftssysteme auf einer einzigen Sprache, was nicht auf die mehrsprachigen Szenarien angewendet werden kann, die in vielen Gesellschaften einzigartig sind. Mehrsprachigkeit kann die Form von aufeinanderfolgenden Sprachen annehmen, beispielsweise bei der Medienprogrammierung in zweisprachigen Ländern. Amazon hat bei der Bewältigung dieses Problems große Fortschritte gemacht, indem es kürzlich ein Produkt auf den Markt gebracht hat, das Spracherkennung (LID) und ASR integriert. Im Gegensatz dazu ist Translanguaging (auch Code-Switching genannt) ein Sprachsystem, das von einer Person verwendet wird, um Wörter und Grammatik aus zwei Sprachen in demselben Satz zu kombinieren. Dies ist ein Bereich, in dem die Wissenschaft weiterhin interessante Fortschritte macht.

So wie der Bereich der Verarbeitung natürlicher Sprache einen mehrsprachigen Ansatz verfolgt, werden wir im nächsten Jahrzehnt erleben, wie ASR diesem Beispiel folgt. Während wir lernen, neue End-to-End-Technologien zu nutzen, werden wir groß angelegte mehrsprachige Modelle trainieren, die das Lernen zwischen mehreren Sprachen übertragen können. Metas XLS-R ist ein gutes Beispiel: In einer Demo könnten Benutzer jede von 21 Sprachen sprechen, ohne eine Sprache anzugeben, und das Modell würde schließlich ins Englische übersetzen. Durch das Verständnis und die Anwendung von Ähnlichkeiten zwischen Sprachen werden diese intelligenteren ASR-Systeme eine qualitativ hochwertige ASR-Verfügbarkeit für ressourcenarme Sprach- und gemischtsprachige Anwendungsfälle bieten und kommerzielle Anwendungen ermöglichen.

2. Umfangreiche standardisierte Ausgabeobjekte

Herkömmliche ASR-Systeme sind in der Lage, bei der Erkennung gesprochener Wörter ein Raster aus mehreren Hypothesen zu generieren, was sich bei der vom Menschen unterstützten Transkription, gesprochenen Dialogsystemen und dem Informationsabruf als sehr nützlich erwiesen hat. Durch die Einbeziehung der n-besten Informationen in ein umfangreiches Ausgabeformat werden mehr Benutzer dazu ermutigt, das ASR-System zu verwenden, wodurch die Benutzererfahrung verbessert wird. Während es derzeit keinen Standard für die Strukturierung und Speicherung der zusätzlichen Informationen gibt, die derzeit oder möglicherweise bei der Sprachdekodierung generiert werden, ist der Open Speech Transcription Standard (OVTS) von CallMiner ein solider Schritt in diese Richtung, der es Unternehmen erleichtert, mehrere ASR-Anbieter zu erkunden und auszuwählen.

Wir gehen davon aus, dass ASR-Systeme in Zukunft eine umfangreichere Ausgabe in Standardformaten erzeugen werden, was leistungsfähigere nachgelagerte Anwendungen ermöglicht. Beispielsweise könnte ein ASR-System den gesamten Satz möglicher Netze ausgeben und eine Anwendung könnte diese zusätzlichen Daten verwenden, um beim Bearbeiten des Transkripts eine intelligente automatisierte Transkription durchzuführen. Ebenso können ASR-Transkriptionen, die zusätzliche Metadaten wie erkannte regionale Dialekte, Akzente, Umgebungsgeräusche oder Stimmung enthalten, leistungsfähigere Suchanwendungen ermöglichen.

„In diesem Jahrzehnt wird groß angelegte ASR (d. h. privatisiert, erschwinglich, zuverlässig und schnell) Teil des täglichen Lebens aller sein in der Lage zu sein, nach Videos zu suchen, alle Medieninhalte zu indizieren, an denen wir teilnehmen, und jedes Video für hörgeschädigte Verbraucher auf der ganzen Welt zugänglich zu machen. ASR wird der Schlüssel dazu sein, jedes Audio und Video zugänglich und umsetzbar zu machen

Möglicherweise nutzen wir alle häufig Audio- und Videosoftware: Podcasts, Social-Media-Streaming, Online-Videos, Echtzeit-Gruppenchats, Zoom-Meetings usw. Dennoch werden nur sehr wenige relevante Inhalte tatsächlich transkribiert. Heutzutage ist die Inhaltstranskription zu einem der größten Märkte für ASR-APIs geworden und wird im nächsten Jahrzehnt exponentiell wachsen, insbesondere angesichts ihrer Genauigkeit und Erschwinglichkeit. Allerdings wird die ASR-Transkription derzeit nur für bestimmte Anwendungen (Videoübertragungen, bestimmte Konferenzen und Podcasts usw.) verwendet. Dies hat zur Folge, dass viele Menschen nicht auf diese Medieninhalte zugreifen können und nach einer Übertragung oder Veranstaltung Schwierigkeiten haben, relevante Informationen zu finden.

Möglicherweise nutzen wir alle häufig Audio- und Videosoftware: Podcasts, Social-Media-Streaming, Online-Videos, Echtzeit-Gruppenchats, Zoom-Meetings usw. Dennoch werden nur sehr wenige relevante Inhalte tatsächlich transkribiert. Heutzutage ist die Inhaltstranskription zu einem der größten Märkte für ASR-APIs geworden und wird im nächsten Jahrzehnt exponentiell wachsen, insbesondere angesichts ihrer Genauigkeit und Erschwinglichkeit. Allerdings wird die ASR-Transkription derzeit nur für bestimmte Anwendungen (Videoübertragungen, bestimmte Konferenzen und Podcasts usw.) verwendet. Dies hat zur Folge, dass viele Menschen nicht auf diese Medieninhalte zugreifen können und nach einer Übertragung oder Veranstaltung Schwierigkeiten haben, relevante Informationen zu finden.

In Zukunft wird sich diese Situation ändern. Wie Matt Thompson 2010 vorhersagte, wird ASR irgendwann billig und so weit verbreitet sein, dass wir das erleben werden, was er „Sprechbarkeit“ nannte. Wir gehen davon aus, dass in Zukunft fast alle Audio- und Videoinhalte transkribiert und in großem Umfang sofort zugänglich, speicherbar und durchsuchbar gemacht werden. Aber die Entwicklung von ASR wird hier nicht aufhören, wir hoffen auch, dass diese Inhalte umsetzbar sind. Wir hoffen, dass jedes konsumierte oder genutzte Audio- und Videomaterial zusätzlichen Kontext bietet, beispielsweise automatisch generierte Erkenntnisse aus einem Podcast oder einer Konferenz oder eine automatische Zusammenfassung wichtiger Momente im Video usw. Wir hoffen, dass NLP-Systeme die oben genannte Verarbeitung routinemäßig durchführen können.

In Zukunft wird der Mensch das ASR-Training mit intelligenten Mitteln effizient überwachen und eine immer wichtigere Rolle bei der Beschleunigung des maschinellen Lernens spielen. Human-in-the-Loop-Ansätze versetzen menschliche Prüfer in die maschinelle Lern-/Feedback-Schleife und ermöglichen so eine kontinuierliche Überprüfung und Anpassung der Modellergebnisse. Dadurch wird maschinelles Lernen schneller und effizienter, was zu einer qualitativ hochwertigeren Ausgabe führt. Anfang dieses Jahres haben wir darüber gesprochen, wie Verbesserungen an ASR es den menschlichen Transkriptoren von Rev (genannt „Revvers“) ermöglichen würden, ASR-Entwürfe nachzubearbeiten und sie dadurch produktiver zu machen. Die Transkription von Revver kann direkt in das verbesserte ASR-Modell eingegeben werden und bildet so einen positiven Kreislauf.

Ein Bereich, in dem menschliche Sprachexperten nach wie vor ein integraler Bestandteil von ASR sind, ist die inverse Textnormalisierung (ITN), bei der sie erkannte Zeichenfolgen (wie „fünf Dollar“) in ihre erwartete geschriebene Form (wie „$5“) umwandeln. Pusateri et al. schlugen einen hybriden Ansatz unter Verwendung „handgefertigter Grammatik und statistischer Modelle“ vor, und Zhang et al. fuhren in dieser Richtung fort, indem sie RNNs mit handgefertigten FSTs einschränkten.

„Wie alle Systeme der künstlichen Intelligenz werden sich zukünftige ASR-Systeme an strengere ethische Grundsätze der künstlichen Intelligenz halten, sodass das System alle gleich behandelt und ein höheres Maß an Erklärbarkeit für ihre Entscheidungen bietet.“ und respektieren Sie die Privatsphäre der Benutzer und ihrer Daten.“

Fairness: Ein faires ASR-System kann Sprache unabhängig vom Hintergrund, dem sozioökonomischen Status oder anderen Merkmalen des Sprechers erkennen. Es ist erwähnenswert, dass der Aufbau eines solchen Systems die Identifizierung und Reduzierung von Verzerrungen in unseren Modellen und Trainingsdaten erfordert. Glücklicherweise arbeiten Regierungen, NGOs und Unternehmen bereits daran, die Infrastruktur zu schaffen, um Voreingenommenheit zu erkennen und abzumildern.

Das obige ist der detaillierte Inhalt vonIn den nächsten zehn Jahren wird sich die KI-Spracherkennung in diese fünf Richtungen entwickeln. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Welche Fähigkeiten sind erforderlich, um in der PHP-Branche zu arbeiten?

Welche Fähigkeiten sind erforderlich, um in der PHP-Branche zu arbeiten?

So ändern Sie C-Sprachsoftware auf Chinesisch

So ändern Sie C-Sprachsoftware auf Chinesisch

Können Weibo-Mitglieder Besucherdatensätze einsehen?

Können Weibo-Mitglieder Besucherdatensätze einsehen?

Lösung dafür, dass die Ordnereigenschaften von Win7 keine Registerkartenseite freigeben

Lösung dafür, dass die Ordnereigenschaften von Win7 keine Registerkartenseite freigeben

Mein Computer kann es nicht durch Doppelklick öffnen.

Mein Computer kann es nicht durch Doppelklick öffnen.

Was ist die Anweisung zum Löschen einer Tabelle in SQL?

Was ist die Anweisung zum Löschen einer Tabelle in SQL?

Welches Format ist PDF?

Welches Format ist PDF?

Für die Frontend-Entwicklung erforderliche Fähigkeiten

Für die Frontend-Entwicklung erforderliche Fähigkeiten