Die Panoramasegmentierung ist eine grundlegende Visionsaufgabe, die darauf abzielt, jedem Pixel eines Bildes semantische Bezeichnungen und Instanzbezeichnungen zuzuweisen. Semantische Beschriftungen beschreiben die Kategorie jedes Pixels (z. B. Himmel, vertikales Objekt usw.) und Instanzbeschriftungen stellen eine eindeutige ID für jede Instanz im Bild bereit (um verschiedene Instanzen derselben Kategorie zu unterscheiden). Diese Aufgabe kombiniert semantische Segmentierung und Instanzsegmentierung, um umfassende semantische Informationen über die Szene bereitzustellen.

Obwohl die Kategorien semantischer Beschriftungen a priori festgelegt sind, können die den Objekten im Bild zugewiesenen Instanz-IDs ausgetauscht werden, ohne dass die Erkennung beeinträchtigt wird. Beispielsweise hat der Austausch der Instanz-IDs zweier Fahrzeuge keinen Einfluss auf die Ergebnisse. Daher sollte ein neuronales Netzwerk, das darauf trainiert ist, Instanz-IDs vorherzusagen, in der Lage sein, eine Eins-zu-viele-Zuordnung von einem einzelnen Bild zu mehreren Instanz-ID-Zuweisungen zu erlernen. Das Erlernen von Eins-zu-vielen-Zuordnungen ist eine Herausforderung, und herkömmliche Methoden nutzen oft mehrstufige Pipelines, einschließlich Objekterkennung, Segmentierung und Zusammenführung mehrerer Vorhersagen. Kürzlich haben einige Wissenschaftler auf der Grundlage des differenzierbaren bipartiten Graphenvergleichs End-to-End-Methoden vorgeschlagen, mit denen eine Eins-zu-Viele-Zuordnung effektiv in eine Eins-zu-Eins-Zuordnung basierend auf dem Erkennungsvergleich umgewandelt werden kann. Diese Methoden erfordern jedoch immer noch angepasste Architekturen und spezielle Verlustfunktionen sowie integrierte induktive Vorspannungen für Panorama-Segmentierungsaufgaben.

Neueste Allzweck-Vision-Modelle wie Pix2Seq, OFA, UViM und Unified I/O befürworten allgemeine, aufgabenfreie Frameworks zur Erfüllung von Generalisierungsaufgaben und sind gleichzeitig viel einfacher als frühere Modelle. Beispielsweise generiert Pix2Seq eine Reihe semantisch bedeutsamer Sequenzen basierend auf Bildern, um einige zentrale visuelle Aufgaben zu erfüllen, und diese Modelle basieren auf Transformern, um autoregressive Modelle zu trainieren.

In einem neuen Artikel folgen Forscher wie Ting Chen und Geoffrey Hinton von Google Brain demselben Konzept und verstehen das Problem der Panorama-Segmentierungsaufgabe aus der Perspektive der bedingten diskreten Datengenerierung.

Papierlink https://arxiv.org/pdf/2210.06366.pdf

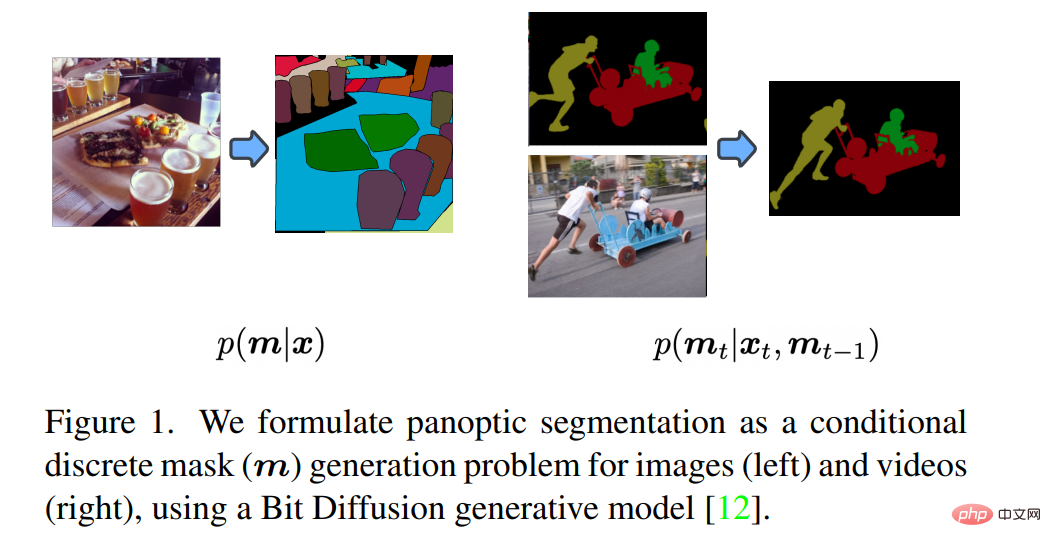

Wie in Abbildung 1 gezeigt, entwarf der Forscher ein generatives Modell für Panoramamasken und Eingaben für jedes Bild des Das Modell generiert einen Satz diskreter Token. Benutzer können dieses Modell auf Videodaten (Online-Daten/Streaming-Medien) anwenden, indem sie einfach Vorhersagen aus vergangenen Frames als zusätzliche bedingte Signale verwenden. Auf diese Weise lernt das Modell automatisch, Objekte zu verfolgen und zu segmentieren.

Die generative Modellierung der Panoramasegmentierung ist eine große Herausforderung, da Panoramamasken diskret oder kategorisch sind und das Modell sehr groß sein kann. Um beispielsweise eine 512×1024-Panoramamaske zu generieren, muss das Modell über 1 Million diskrete Tags (Semantik- und Instanzbezeichnungen) generieren. Dies ist bei autoregressiven Modellen immer noch relativ teuer, da Token sequenzieller Natur sind und schwer zu ändern sind, wenn sich der Umfang der Eingabedaten ändert. Diffusionsmodelle eignen sich besser für den Umgang mit hochdimensionalen Daten, werden jedoch meist in kontinuierlichen statt in diskreten Bereichen angewendet. Durch die Darstellung diskreter Daten mit analogen Bits zeigen die Autoren, dass Diffusionsmodelle direkt auf großen Panoramamasken trainiert werden können, ohne dass ein latenter Raum erlernt werden muss.

Durch umfangreiche Experimente haben die Forscher gezeigt, dass ihre allgemeine Methode in ähnlichen Umgebungen mit modernsten Expertenmethoden konkurrieren kann.

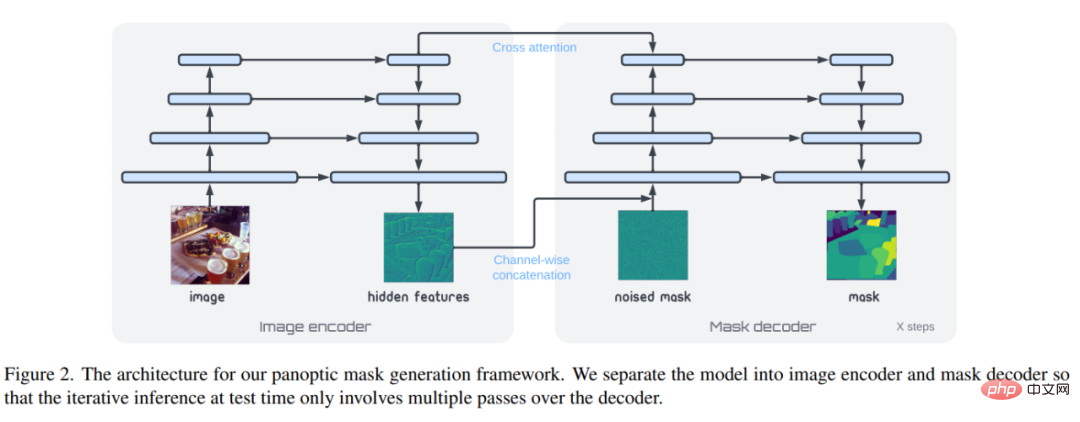

Diffusionsmodell-Sampling erfolgt iterativ, daher muss der Vorwärtsdurchlauf des Netzwerks während der Inferenz mehrmals ausgeführt werden. Daher haben die Forscher, wie in Abbildung 2 dargestellt, das Netzwerk absichtlich in zwei Komponenten aufgeteilt: 1) Bildcodierer, 2) Maskendecoder. Ersteres ordnet rohe Pixeldaten Darstellungsvektoren auf hoher Ebene zu, und dann liest der Maskendecoder iterativ die Panoramamaske aus.

Pixel-/Bildkodierer

DerEncoder ist ein Netzwerk, das das Originalbild  der Feature-Map in

der Feature-Map in  zuordnet, wobei H’ und w’ die Höhe und Breite der Panoramamaske sind. Die Panoramamaske kann die gleiche Größe wie das Originalbild oder kleiner haben. In dieser Arbeit verwendeten die Forscher ResNet als Backbone-Netzwerk und dann die Encoderschicht von Transformer als Merkmalsextraktor. Um sicherzustellen, dass die Ausgabe-Feature-Map eine ausreichende Auflösung hat und Features unterschiedlicher Maßstäbe enthält, verwendeten die Forscher eine Faltung mit bilateralen Verbindungen und Upsampling-Operationen, um Features unterschiedlicher Auflösung zusammenzuführen. Obwohl komplexere Encoder verwendet werden können, die einige der neuesten Fortschritte im Architekturdesign nutzen können, steht dies nicht im Mittelpunkt des Netzwerkmodells. Daher verwenden die Forscher lediglich einfachere Merkmalsextraktoren, um seine Rolle im Modell zu veranschaulichen.

zuordnet, wobei H’ und w’ die Höhe und Breite der Panoramamaske sind. Die Panoramamaske kann die gleiche Größe wie das Originalbild oder kleiner haben. In dieser Arbeit verwendeten die Forscher ResNet als Backbone-Netzwerk und dann die Encoderschicht von Transformer als Merkmalsextraktor. Um sicherzustellen, dass die Ausgabe-Feature-Map eine ausreichende Auflösung hat und Features unterschiedlicher Maßstäbe enthält, verwendeten die Forscher eine Faltung mit bilateralen Verbindungen und Upsampling-Operationen, um Features unterschiedlicher Auflösung zusammenzuführen. Obwohl komplexere Encoder verwendet werden können, die einige der neuesten Fortschritte im Architekturdesign nutzen können, steht dies nicht im Mittelpunkt des Netzwerkmodells. Daher verwenden die Forscher lediglich einfachere Merkmalsextraktoren, um seine Rolle im Modell zu veranschaulichen.

Mask Decoder

Der Decoder verfeinert die Panoramamaske iterativ basierend auf Bildmerkmalen während der Modellinferenz. Konkret handelt es sich bei dem von den Forschern verwendeten Maskendecoder um TransUNet. Das Netzwerk verwendet als Eingabe die Verkettung einer Bildmerkmalskarte vom Encoder und einer Rauschmaske (entweder zufällig initialisiert oder iterativ aus dem Codierungsprozess) und gibt eine genaue Vorhersage der Maske aus. Ein Unterschied zwischen dem Decoder und der Standard-U-Net-Architektur für die Bilderzeugung und Bild-zu-Bild-Konvertierung besteht darin, dass das in diesem Dokument verwendete U-Net eine Transformator-Decoderschicht mit einer darüber liegenden Cross-Attention-Schicht zum Zusammenführen verwendet codierte Bildmerkmale.

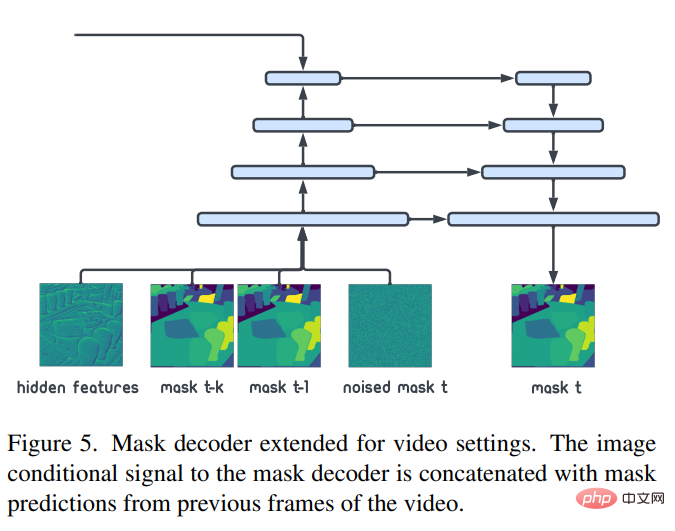

Anwendung im Videomodus

Der Forscher modelliert die Panoramamaske unter Bildbedingungen als: p(m|x). Basierend auf der dreidimensionalen Maske eines bestimmten Videos (mit einer zusätzlichen zeitlichen Dimension) kann unser Modell direkt auf die Video-Panoramasegmentierung angewendet werden. Zur Anpassung an Online-/Streaming-Videoeinstellungen kann stattdessen die Modellierung p(m_t|x_t,m_(t-1),m_(t-k)) verwendet werden, um ein neues Panorama basierend auf dem aktuellen Bild und der Maske des vorherigen zu generieren Moment. Maske. Wie in Abbildung 5 dargestellt, kann diese Änderung durch Verketten der vergangenen Panoramamaske (m_(t-1),m_(t-k)) mit der vorhandenen Rauschmaske erreicht werden. Abgesehen von dieser kleinen Änderung ist alles andere dasselbe wie beim Video-Basismodell (p(m|x)). Dieses Modell ist sehr einfach und kann durch Feinabstimmung des Bildpanoramamodells auf Videoszenen angewendet werden.

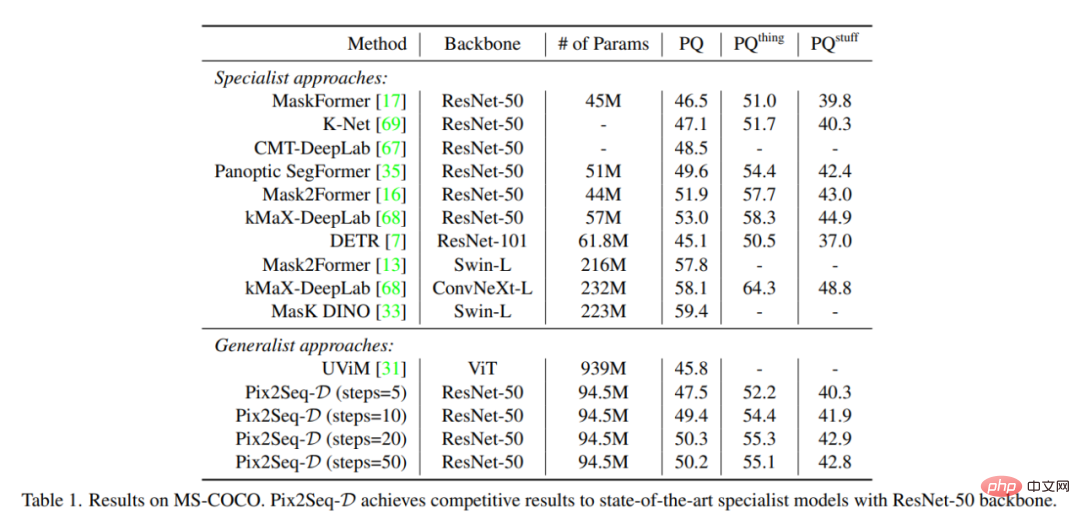

Dieser Artikel vergleicht mit zwei Serien hochmoderner Methoden, nämlich Expertenmethoden und allgemeinen Methoden. Tabelle 1 fasst die Ergebnisse des MS-COCO-Datensatzes zusammen. Die Generalisierungsqualität (PQ) von Pix2Seq-D auf dem ResNet-50-basierten Backbone ist mit modernsten Methoden konkurrenzfähig. Im Vergleich zu anderen neueren Allzweckmodellen wie UViM ist unser Modell deutlich leistungsfähiger und gleichzeitig effizienter.

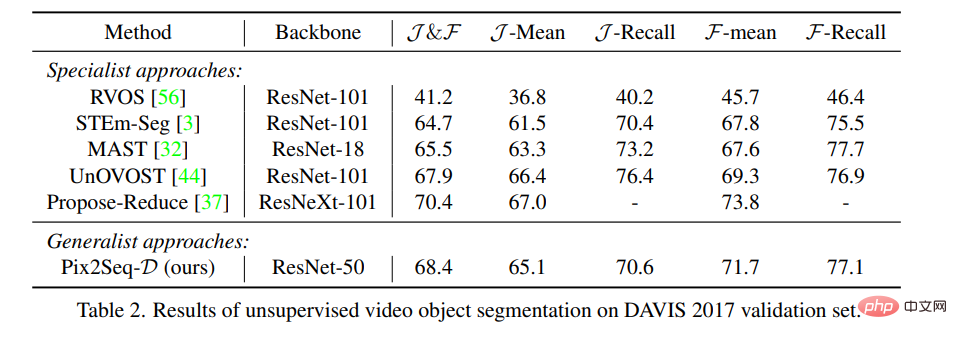

Tabelle 2 vergleicht Pix2Seq-D mit modernsten Methoden zur unbeaufsichtigten Videoobjektsegmentierung im DAVIS-Datensatz unter Verwendung von Standard-J&F-Metriken. Es ist zu beachten, dass die Basislinie keine anderen allgemeinen Modelle enthält, da diese nicht direkt auf die Aufgabe anwendbar sind. Unsere Methode erzielt ohne spezielles Design die gleichen Ergebnisse wie modernste Methoden.

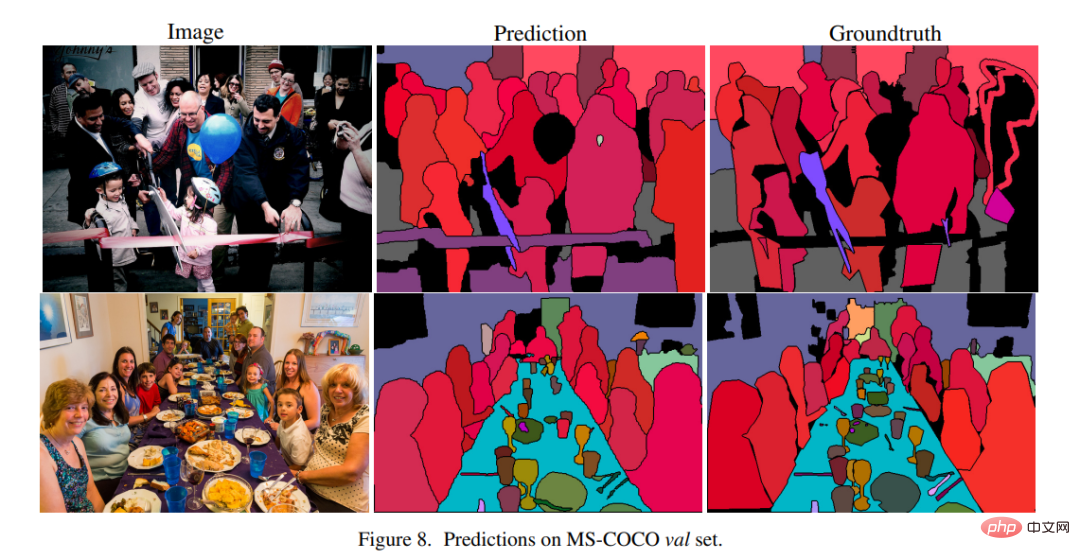

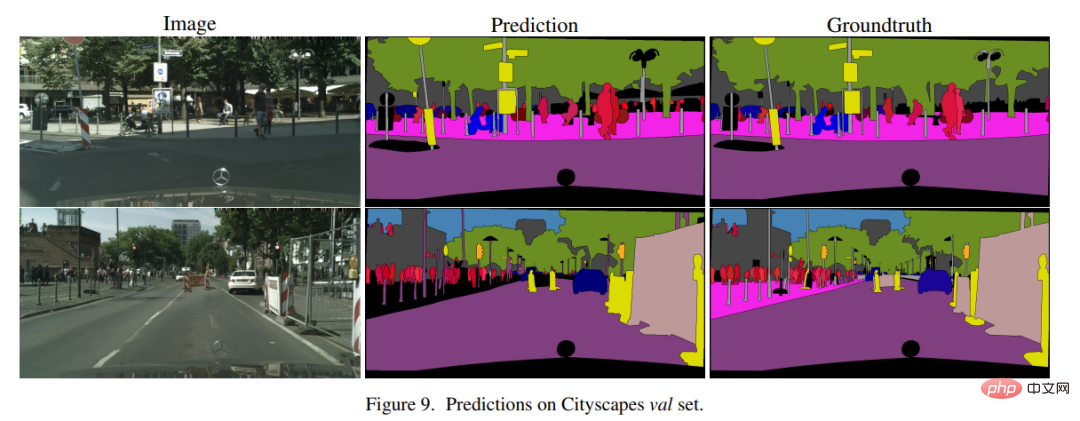

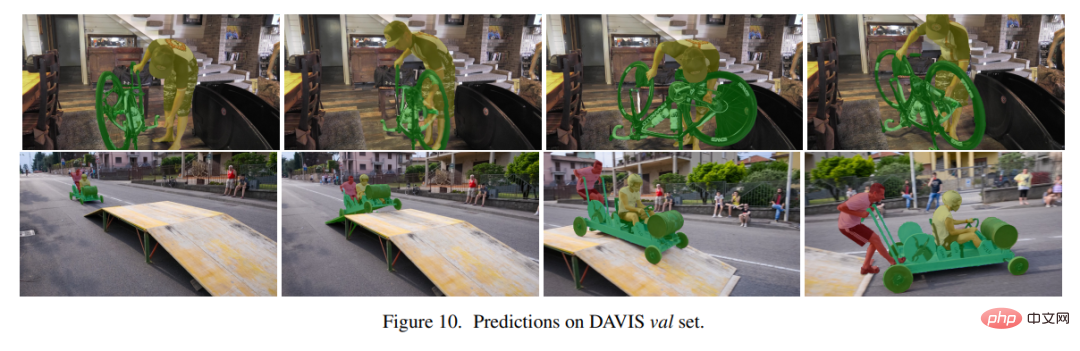

Die Abbildungen 8, 9 und 10 zeigen Beispielergebnisse von Pix2Seq-D auf MS-COCO, Cityscape und DAVIS.

Das obige ist der detaillierte Inhalt vonIst es wirklich so seidig glatt? Hintons Gruppe schlug ein Framework zur Instanzsegmentierung vor, das auf großen Panoramamasken basiert und einen reibungslosen Wechsel von Bild- und Videoszenen ermöglicht.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Einführung in die Bedeutung von Cloud-Download-Fenstern

Einführung in die Bedeutung von Cloud-Download-Fenstern

Lösung für die vscode-Einstellung der chinesischen Schnittstelle wird nicht wirksam

Lösung für die vscode-Einstellung der chinesischen Schnittstelle wird nicht wirksam

So schließen Sie Port 135 445

So schließen Sie Port 135 445

Warum öffnet sich die mobile Festplatte so langsam?

Warum öffnet sich die mobile Festplatte so langsam?

So verwenden Sie Split in Python

So verwenden Sie Split in Python

Handy-Bildschirm tft

Handy-Bildschirm tft

So ändern Sie die Größe von Bildern in PS

So ändern Sie die Größe von Bildern in PS

0x80070057 Parameterfehlerlösung

0x80070057 Parameterfehlerlösung