Bei der Beantwortung komplexer Fragen können Menschen Informationen in verschiedenen Modalitäten verstehen und eine vollständige Gedankenkette (CoT) bilden. Kann das Deep-Learning-Modell die „Black Box“ öffnen und eine Denkkette für seinen Argumentationsprozess bereitstellen? Kürzlich haben die UCLA und das Allen Institute for Artificial Intelligence (AI2) ScienceQA vorgeschlagen, den ersten multimodalen wissenschaftlichen Frage-Antwort-Datensatz mit detaillierten Erklärungen, um die multimodalen Argumentationsfähigkeiten des Modells zu testen. In der ScienceQA-Aufgabe schlug der Autor das GPT-3 (CoT)-Modell vor, das schnelles Lernen basierend auf Gedankenketten in das GPT-3-Modell einführte, sodass das Modell bei der Generierung von Antworten entsprechende Begründungserklärungen generieren kann. GPT-3 (CoT) erreicht bei ScienceQA eine Genauigkeit von 75,17 % und die menschliche Auswertung zeigt, dass es qualitativ hochwertigere Erklärungen generieren kann.

Komplexe Aufgaben genauso effektiv zu lernen und zu erledigen wie Menschen, ist eines der langfristigen Ziele, die künstliche Intelligenz verfolgt. Menschen können während des Entscheidungsprozesses einem vollständigen Denkprozess (CoT) folgen, um vernünftige Erklärungen für die gegebenen Antworten zu geben.

Die meisten vorhandenen Modelle für maschinelles Lernen basieren jedoch auf einer großen Anzahl von Eingabe-Ausgabe-Beispieltrainings, um bestimmte Aufgaben auszuführen. Diese Black-Box-Modelle generieren oft direkt die endgültige Antwort, ohne den spezifischen Argumentationsprozess preiszugeben.

Durch die Beantwortung wissenschaftlicher Fragen kann gut diagnostiziert werden, ob das Modell der künstlichen Intelligenz über mehrstufige Argumentationsfähigkeiten und Interpretierbarkeit verfügt. Um wissenschaftliche Fragen zu beantworten, muss ein Modell nicht nur multimodale Inhalte verstehen, sondern auch externes Wissen extrahieren, um zur richtigen Antwort zu gelangen. Gleichzeitig sollte ein zuverlässiges Modell auch Erklärungen liefern, die seinen Denkprozess offenbaren. Den meisten aktuellen wissenschaftlichen Frage- und Antwortdatensätzen fehlen jedoch detaillierte Erläuterungen zu den Antworten oder sie sind auf Textmodalitäten beschränkt.

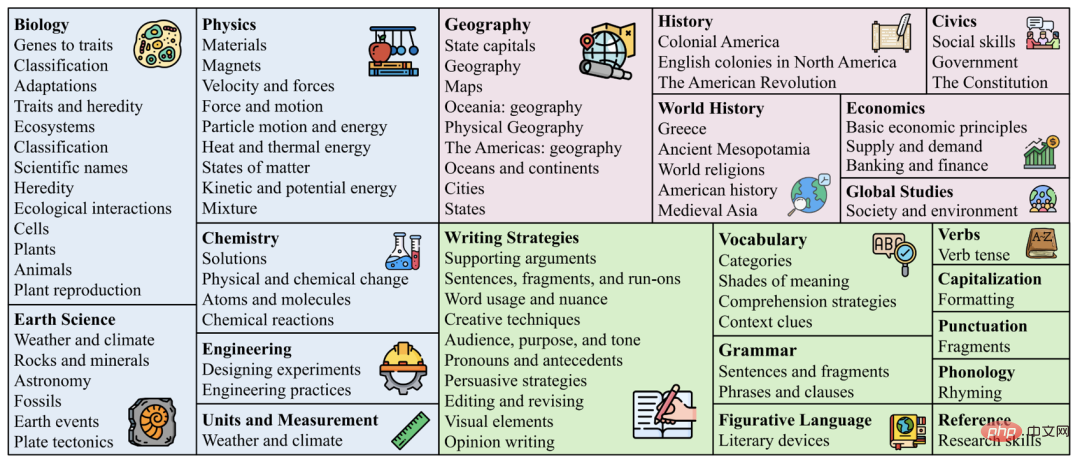

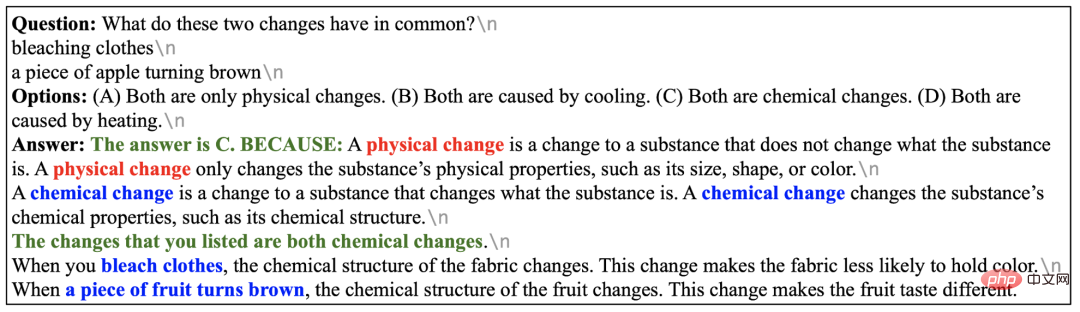

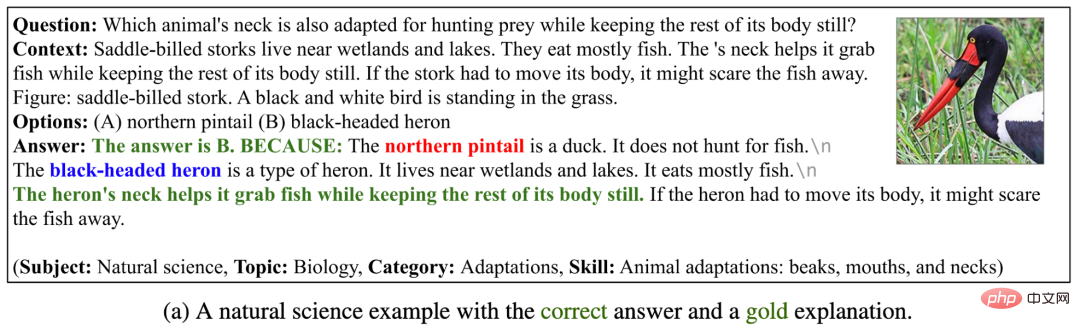

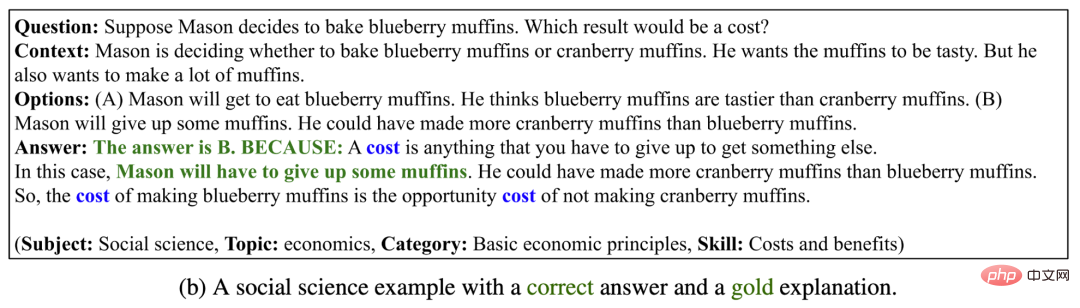

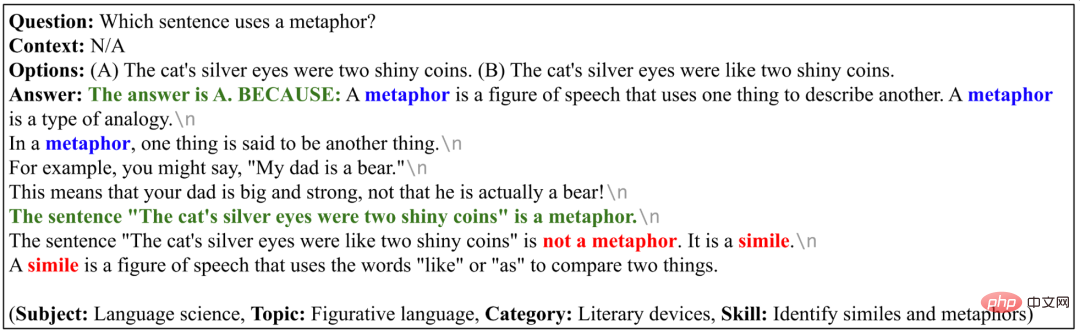

Daher Der Autor hat einen neuen wissenschaftlichen Frage- und Antwortdatensatz ScienceQA zusammengestellt, der 21.208 Multiple-Choice-Fragen aus naturwissenschaftlichen Kursen der Grund- und Sekundarstufe enthält. Eine typische Frage enthält multimodalen Kontext, richtige Optionen, allgemeines Hintergrundwissen (Vortrag) und spezifische Erklärung (Erklärung).

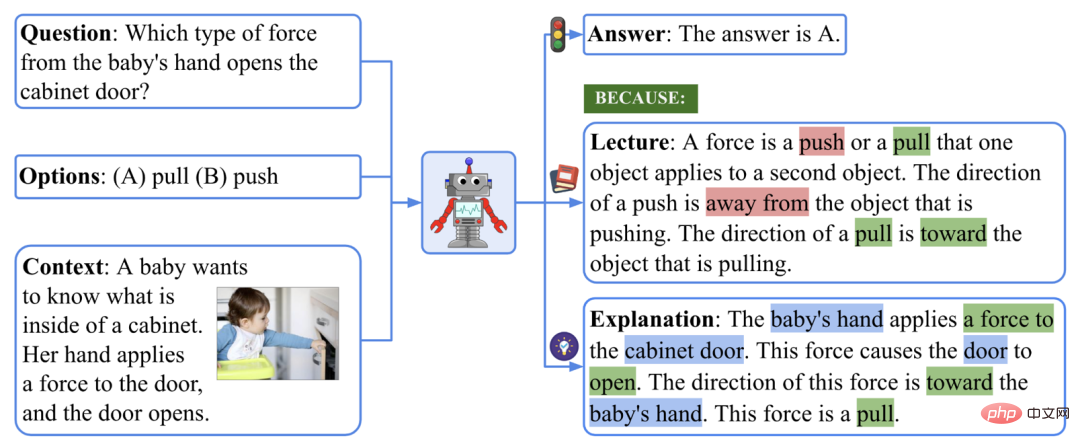

Ein Beispiel für einen ScienceQA-Datensatz.

Um das oben gezeigte Beispiel zu beantworten, müssen wir uns zunächst an die Definition von Kraft erinnern: „Eine Kraft ist ein Stoß oder Zug, der ... Die Richtung eines Stoßes ist ... Die Richtung eines Zuges ist.“ ...“ und bilden dann einen mehrstufigen Denkprozess: „Die Hand des Babys übt eine Kraft auf die Schranktür aus → Die Richtung dieser Kraft ist auf die Hand des Babys gerichtet.“ und bekam schließlich die richtige Antwort: „Diese Kraft ist ein Sog.“

In der ScienceQA-Aufgabe muss das Modell die Antwort vorhersagen und gleichzeitig eine detaillierte Erklärung ausgeben. In diesem Artikel der Autor verwendet ein groß angelegtes Sprachmodell, um Hintergrundwissen und Erklärungen als Gedankenkette (CoT) zu generieren, um die Fähigkeit des Menschen zum mehrstufigen Denken nachzuahmen.

Experimente zeigen, dass aktuelle multimodale Fragebeantwortungsmethoden bei der ScienceQA-Aufgabe keine gute Leistung erzielen können. Im Gegensatz dazu Durch gedankenkettenbasiertes schnelles Lernen kann das GPT-3-Modell eine Genauigkeit von 75,17 % im ScienceQA-Datensatz erreichen und Erklärungen höherer Qualität generieren: 65,2 % der Erklärungen sind nach menschlicher Bewertung relevant, richtig und vollständig. Thoughtchain kann auch dazu beitragen, dass das UnifiedQA-Modell eine Verbesserung um 3,99 % gegenüber dem ScienceQA-Datensatz erzielt.

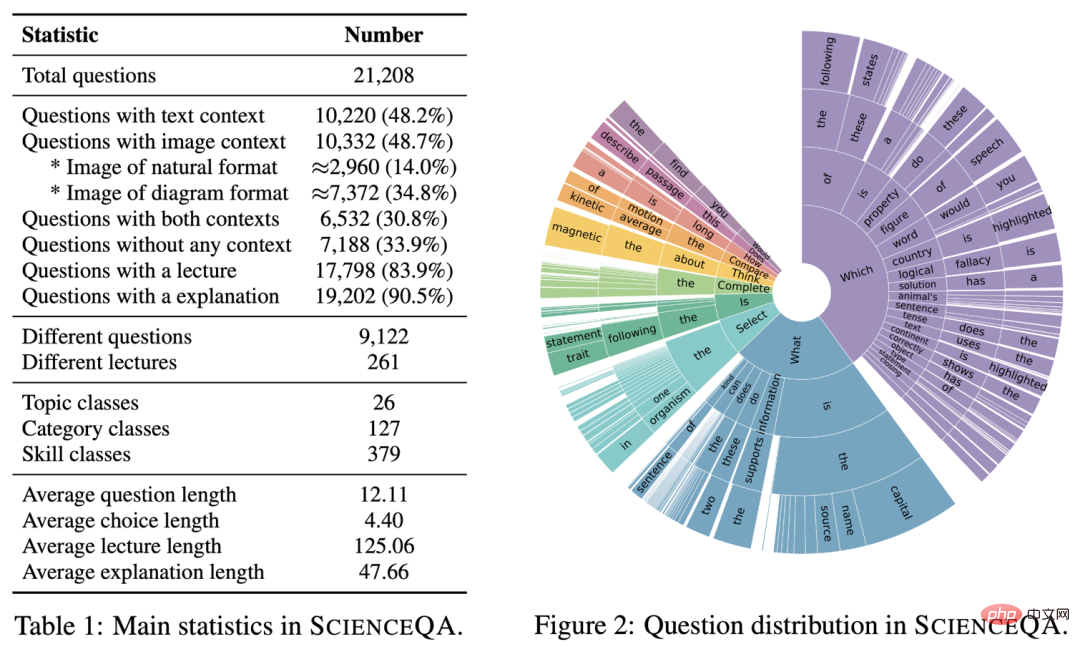

Datensatzstatistik

Die wichtigsten statistischen Informationen von ScienceQA sind wie folgt.

Hauptinformationen des ScienceQA-Datensatzes

ScienceQA enthält 21208 Beispiele, davon gibt es 9122 verschiedene Fragen. 10.332 Traktate (48,7 %) hatten visuelle Hintergrundinformationen, 10.220 Traktate (48,2 %) hatten textliche Hintergrundinformationen und 6.532 Traktate (30,8 %) hatten visuelle und textliche Hintergrundinformationen. Die überwiegende Mehrheit der Fragen ist mit ausführlichen Erläuterungen versehen: 83,9 % der Fragen verfügen über Anmerkungen zum Hintergrundwissen (Vorlesung) und 90,5 % der Fragen enthalten ausführliche Antworten (Erläuterung).

ScienceQA-Datensatzfrage und Hintergrundverteilung. „Themenverteilung der Datensätze“ . Themenverteilung von

ScienceQA.

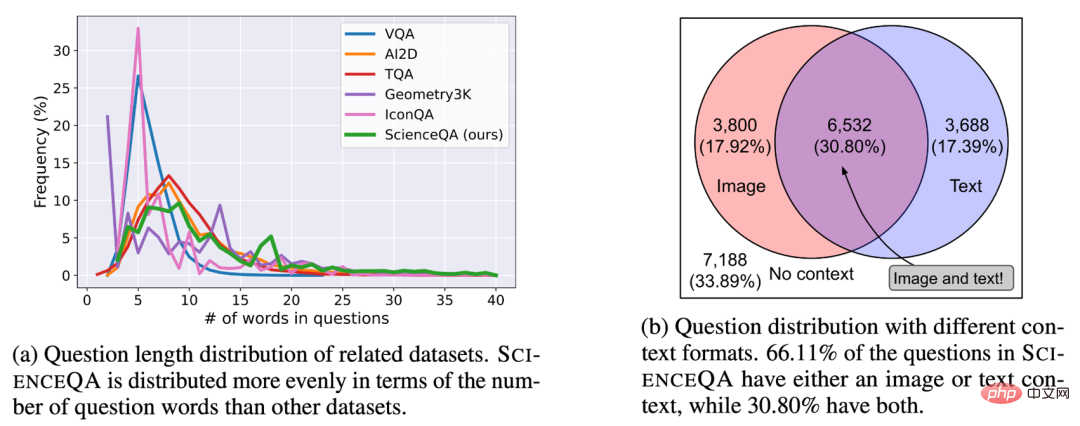

Wortwolkenverteilung im Datensatz

Wie in der Wortwolkenverteilung in der folgenden Abbildung dargestellt, weisen die Fragen in ScienceQA eine große semantische Vielfalt auf. Modelle müssen unterschiedliche Problemformulierungen, Szenarien und Hintergrundwissen verstehen. Wortwolkenverteilung von ScienceQA.

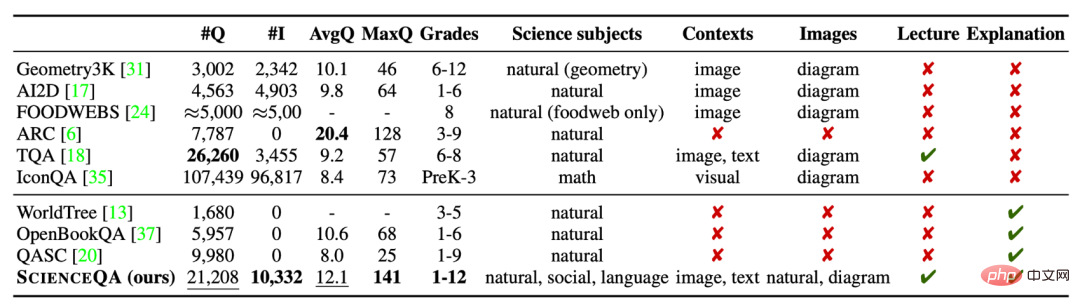

Datensatzvergleich

ScienceQA ist der erste multimodale wissenschaftliche Frage- und Antwortdatensatz , der mit detaillierten Erläuterungen kommentiert ist. Im Vergleich zu vorhandenen Datensätzen spiegeln die Datengröße, die Fragetypvielfalt, die Themenvielfalt und andere Dimensionen von ScienceQA seine Vorteile wider.

Vergleich des ScienceQA-Datensatzes mit anderen wissenschaftlichen Frage- und Antwortdatensätzen.

2. Modelle und Methoden Grundlinien

Grundlinien

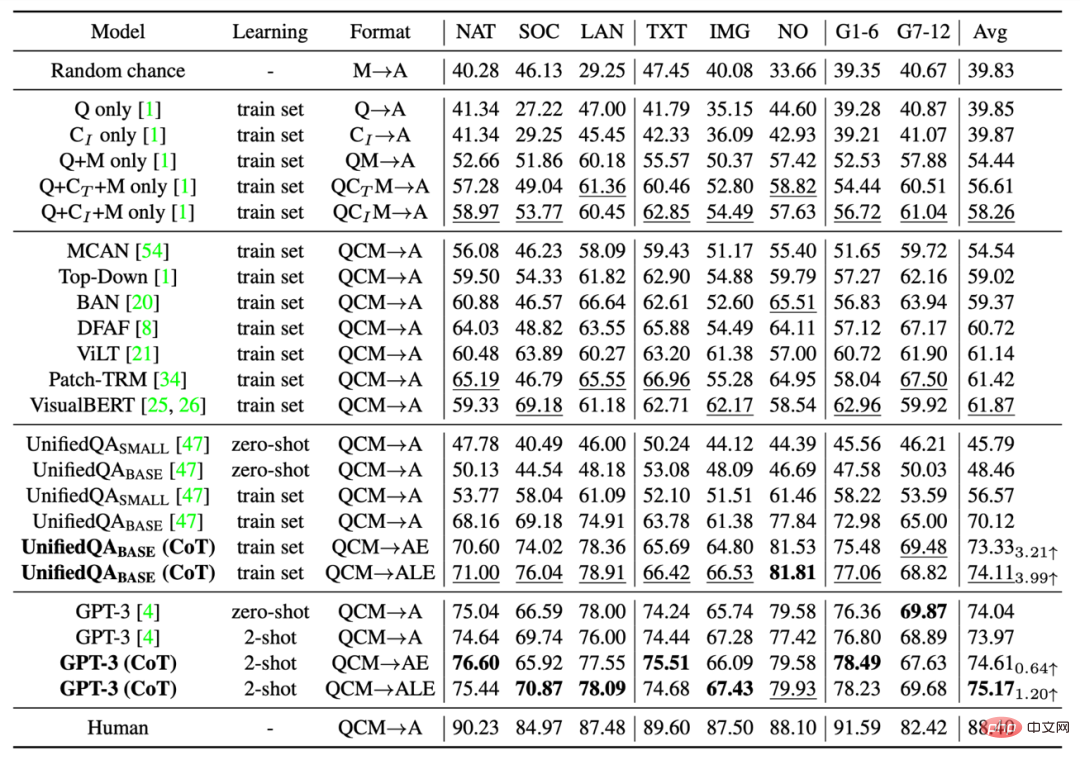

Der Autor bewertete verschiedene Benchmark-Methoden für den ScienceQA-Datensatz, darunter VQA-Modelle wie Top-Down Attention, MCAN, BAN, DFAF, ViLT, Patch-TRM und VisualBERT, groß angelegte Sprachmodelle wie UnifiedQA und GPT-3, und zufälliger Zufall und menschliche Leistung. Bei den Sprachmodellen UnifiedQA und GPT-3 werden Hintergrundbilder in Textbeschriftungen umgewandelt.

GPT-3 (CoT)

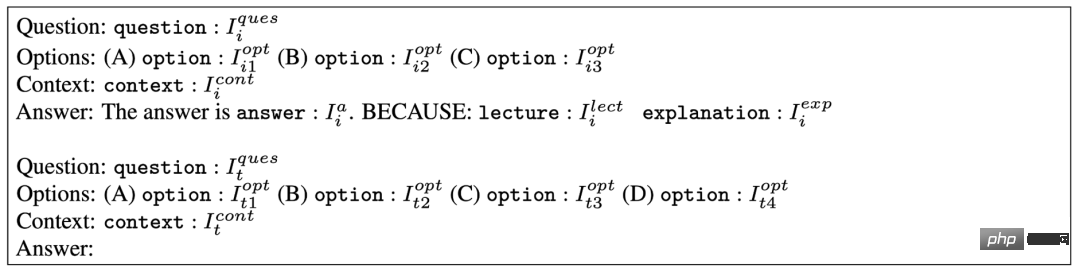

Neueste Forschungsarbeiten zeigen, dass GPT-3-Modelle bei geeigneten Hinweisen eine überlegene Leistung bei verschiedenen nachgelagerten Aufgaben zeigen können. Zu diesem Zweck schlägt der Autor das GPT-3 (CoT)-Modell vor, das den Eingabeaufforderungen eine Gedankenkette (CoT) hinzufügt, sodass das Modell bei der Generierung von Antworten entsprechendes Hintergrundwissen und Erklärungen generieren kann.

Die spezifische Eingabeaufforderungsvorlage ist im Bild unten dargestellt. wobei Ii das Trainingsbeispiel und It das Testbeispiel darstellt. Das Trainingsbeispiel enthält Frage-, Optionen-, Kontext- und Antwortelemente, wobei die Antwort aus der richtigen Antwort, Hintergrundwissen (Vortrag) und Erklärung (Erklärung) besteht. GPT-3 (CoT) vervollständigt die vorhergesagten Antworten, Hintergrundwissen und Erläuterungen zu den Testbeispielen basierend auf den Eingabeaufforderungsinformationen.

Tipps-Vorlage übernommen von GPT-3 (CoT). 3. Experimente und Analysen VisualBERT, eines der derzeit besten VQA-Modelle, kann nur eine Genauigkeit von 61,87 % erreichen. Durch die Einführung von CoT-Daten während des Trainingsprozesses kann das UnifiedQA_BASE-Modell eine Genauigkeit von 74,11 % erreichen. Und GPT-3 (CoT) erreichte mit der Eingabeaufforderung von 2 Trainingsbeispielen eine Genauigkeit von 75,17 %, was höher ist als bei anderen Benchmark-Modellen

. Menschen schneiden beim ScienceQA-Datensatz gut ab, erreichen eine Gesamtgenauigkeit von 88,40 % und schneiden in verschiedenen Fragenkategorien stabil ab.

Die Ergebnisse verschiedener Methoden im ScienceQA-Testset.

Bewertung generierter Erklärungen

Bewertung generierter Erklärungen

Die Autoren bewerteten die durch verschiedene Methoden generierten Erklärungen mithilfe automatischer Bewertungsmetriken wie BLEU-1, BLEU-2, ROUGE-L und Satzähnlichkeit. Da automatische Bewertungsmetriken nur die Ähnlichkeit zwischen Vorhersageergebnissen und kommentierten Inhalten messen können, haben die Autoren außerdem manuelle Bewertungsmethoden übernommen, um die Relevanz, Richtigkeit und Vollständigkeit der generierten Erklärungen zu bewerten. Wie zu sehen ist, erfüllen 65,2 % der von GPT-3 (CoT) generierten Erklärungen den Goldstandard .

Die Ergebnisse verschiedener Bewertungsmethoden zur Generierung von Erklärungen.

Verschiedene Hinweisvorlagen

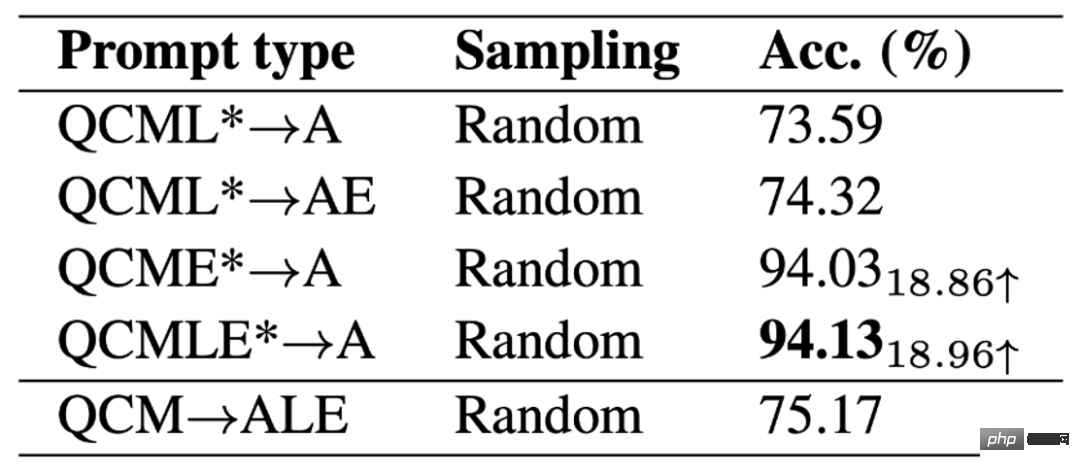

Der Autor verglich die Auswirkungen verschiedener Hinweisvorlagen auf die GPT-3 (CoT)-Genauigkeit

. Es ist ersichtlich, dass GPT-3 (CoT) unter der QAM-ALE-Vorlage die größte durchschnittliche Genauigkeit und die kleinste Varianz erzielen kann. Darüber hinaus schneidet GPT-3 (CoT) am besten ab, wenn es mit zwei Trainingsbeispielen dazu aufgefordert wird.Vergleich der Ergebnisse verschiedener Eingabeaufforderungsvorlagen.

Modellobergrenze

Um die Leistungsobergrenze des GPT-3 (CoT)-Modells zu erkunden, ergänzt der Autor die Eingabe des Modells (QCMLE*-A) mit annotiertem Hintergrundwissen und Erläuterungen . Wir können sehen, dass GPT-3 (CoT) eine Genauigkeit von bis zu 94,13 % erreichen kann. Dies legt auch eine mögliche Richtung für die Modellverbesserung nahe: Das Modell kann Schritt-für-Schritt-Schlussfolgerungen durchführen, das heißt, zunächst genaues Hintergrundwissen abrufen und genaue Erklärungen generieren und diese Ergebnisse dann als Eingabe verwenden. Dieser Prozess ist der Art und Weise, wie Menschen komplexe Probleme lösen, sehr ähnlich.

Leistungsobergrenze für GPT-3 (CoT)-Modelle.

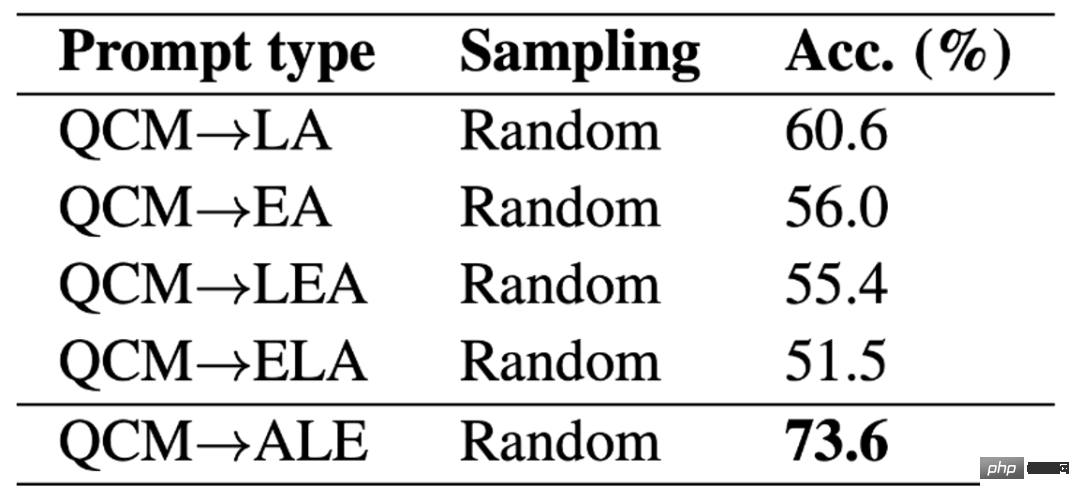

Unterschiedliche ALE-Positionen

Der Autor diskutiert außerdem die Auswirkungen verschiedener ALE-Positionen auf die Ergebnisse von GPT-3 (CoT) bei der Erstellung von Vorhersagen. Experimentelle Ergebnisse zu ScienceQA zeigen, dass die Vorhersagegenauigkeit von GPT-3 (CoT) erheblich sinkt, wenn GPT-3 (CoT) zunächst Hintergrundwissen L oder Erklärung E und dann Antwort A generiert. Der Hauptgrund ist, dass Hintergrundwissen L und Erklärung E eine große Anzahl von Wörtern enthalten. Wenn LE zuerst generiert wird, geht dem GPT-3-Modell möglicherweise die maximale Anzahl an Wörtern aus oder es wird vorzeitig aufgehört, Text zu generieren, sodass die endgültige Antwort vorliegt A kann nicht erhalten werden.

Verschiedene LE-Positionen.

Verschiedene LE-Positionen.

Erfolgsgeschichten

In den folgenden 4 Beispielen kann GPT-3 (CoT) nicht nur richtige Antworten generieren, sondern auch relevante, richtige und vollständige Erklärungen geben . Dies zeigt, dass GPT-3 (CoT) starke mehrstufige Argumentations- und Erklärungsfähigkeiten im ScienceQA-Datensatz aufweist.

GPT-3 (CoT) Beispiele für die Generierung korrekter Antworten und Erklärungen.

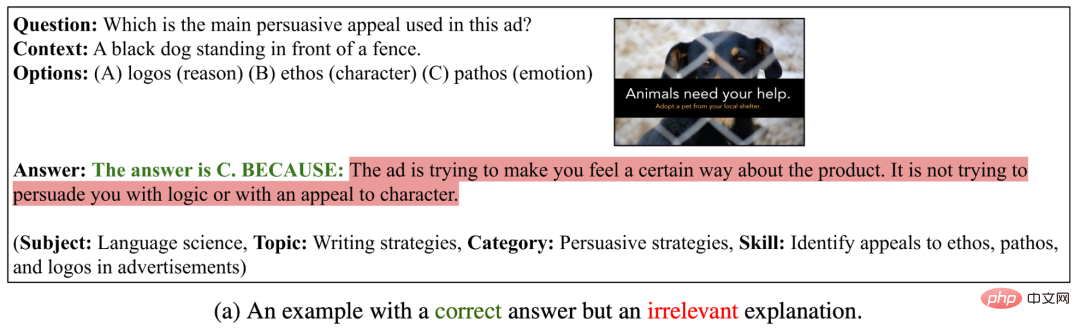

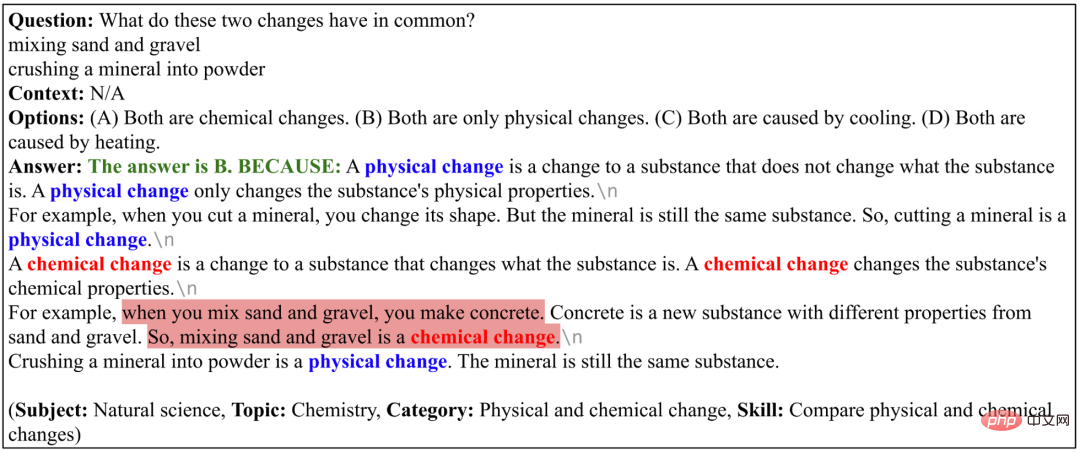

Fehlerfall I

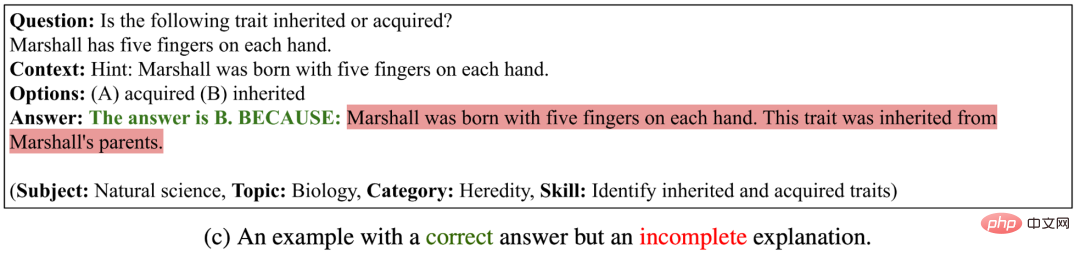

In den folgenden drei Beispielen generierte GPT-3 (CoT) korrekte Antworten, die generierten Erklärungen waren jedoch irrelevant, falsch oder unvollständig . Dies zeigt, dass GPT-3 (CoT) immer noch größere Schwierigkeiten hat, logisch konsistente lange Sequenzen zu erzeugen.

GPT-3 (CoT) kann Beispiele für richtige Antworten generieren, aber die generierten Erklärungen sind falsch.

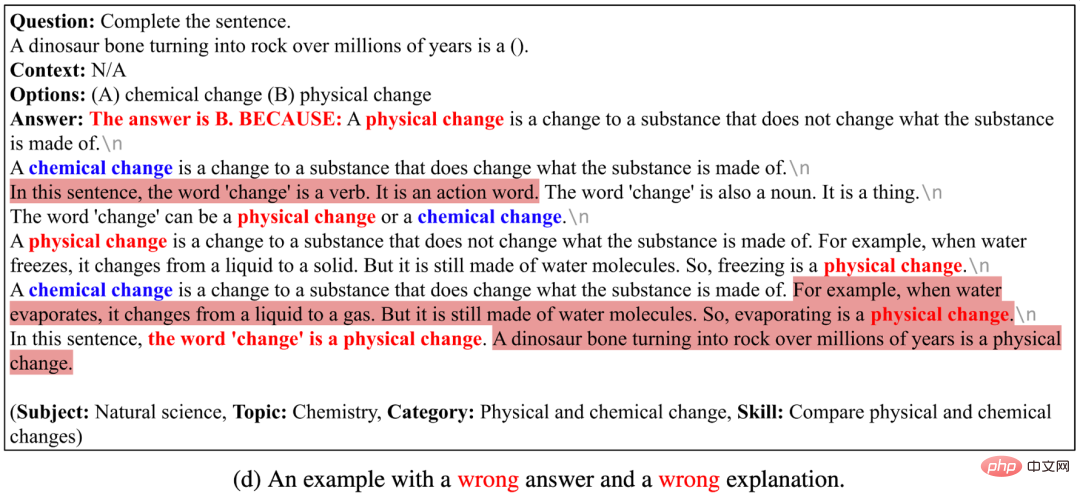

Fehlerfall II

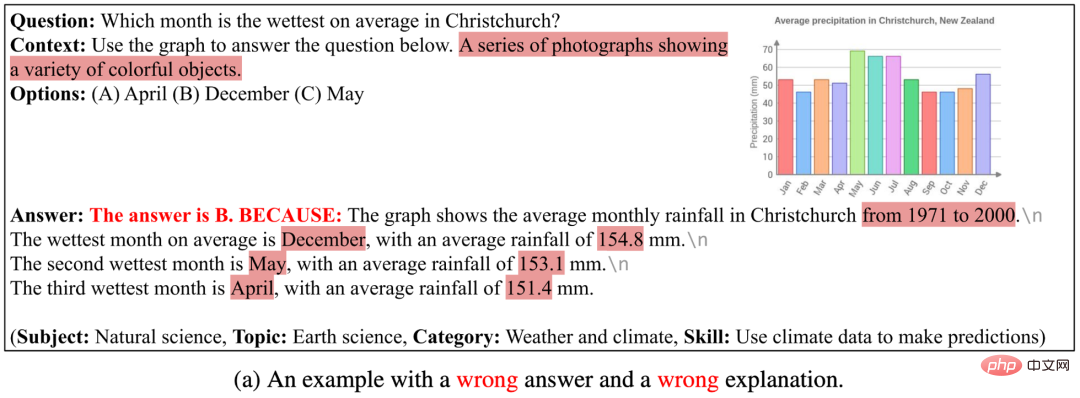

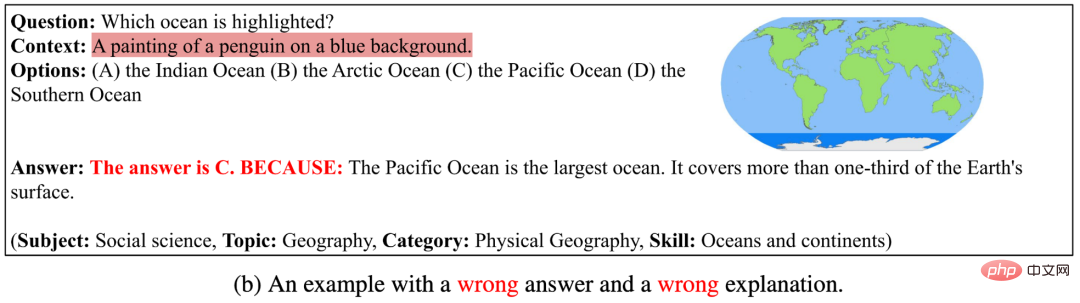

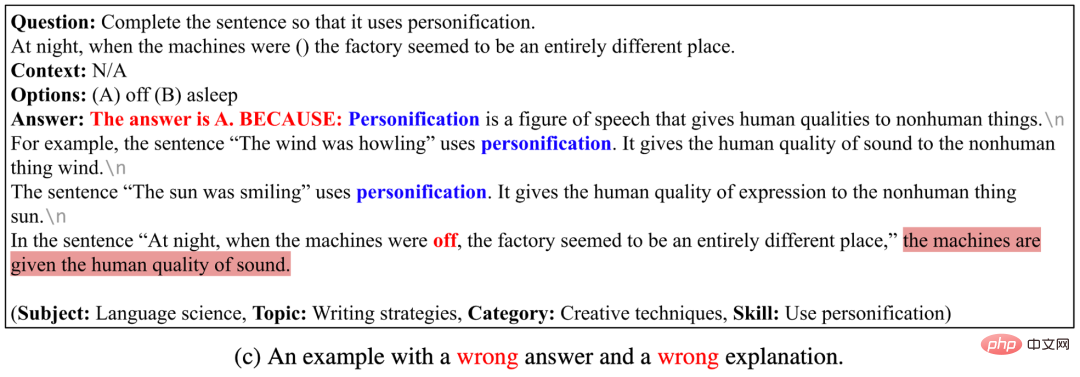

In den vier folgenden Beispielen kann GPT-3 (CoT) weder die richtige Antwort noch die richtige Erklärung generieren. Die Gründe dafür sind: (1) Das aktuelle Bildunterschriftenmodell kann die semantischen Informationen von Bildern wie schematischen Diagrammen und Tabellen nicht genau beschreiben. Wenn das Bild durch Bildanmerkungstext dargestellt wird, kann GPT-3 (CoT) die darin enthaltene Frage noch nicht beantworten der Diagrammhintergrund. (2) Wenn GPT-3 (CoT) lange Sequenzen generiert, ist es anfällig für inkonsistente oder inkohärente Probleme. (3) GPT-3 (CoT) ist noch nicht in der Lage, spezifische Fragen zu beantworten .

GPT-3 (CoT) kann Beispiele für falsche Antworten und Erklärungen generieren.

Der Autor schlug ScienceQA vor, den ersten multimodalen wissenschaftlichen Frage- und Antwortdatensatz mit detaillierten Erläuterungen. ScienceQA enthält 21.208 Multiple-Choice-Fragen aus naturwissenschaftlichen Fächern der Grund- und Sekundarstufe, die drei große naturwissenschaftliche Bereiche und eine Vielzahl von Themen abdecken. Die meisten Fragen sind mit detailliertem Hintergrundwissen und Erklärungen versehen. ScienceQA bewertet die Fähigkeiten eines Modells in Bezug auf multimodales Verständnis, mehrstufiges Denken und Interpretierbarkeit. Die Autoren bewerten verschiedene Basismodelle auf dem ScienceQA-Datensatz und schlagen vor, dass das GPT-3 (CoT)-Modell bei der Generierung von Antworten entsprechendes Hintergrundwissen und Erklärungen generieren kann. Eine Vielzahl experimenteller Analysen und Fallstudien lieferten wertvolle Anregungen für die Verbesserung des Modells.

Das obige ist der detaillierte Inhalt vonDer erste multimodale wissenschaftliche Frage- und Antwortdatensatz mit detaillierten Erklärungen, Deep-Learning-Modell-Argumentation verfügt über eine Denkkette. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!