Seit seiner Einführung im Jahr 2017 hat das Transformer-Modell in anderen Bereichen wie der Verarbeitung natürlicher Sprache und Computer Vision eine beispiellose Stärke gezeigt und technologische Durchbrüche wie ChatGPT ausgelöst. Darüber hinaus haben Menschen verschiedene Variationen vorgeschlagen das Originalmodell.

Da Wissenschaft und Industrie weiterhin neue Modelle auf Basis des Transformer-Aufmerksamkeitsmechanismus vorschlagen, fällt es uns manchmal schwer, diese Richtung zusammenzufassen. Kürzlich könnte uns ein Übersichtsartikel von Xavier Amatriain, Leiter der KI-Produktstrategie bei LinkedIn, bei der Lösung dieses Problems helfen.

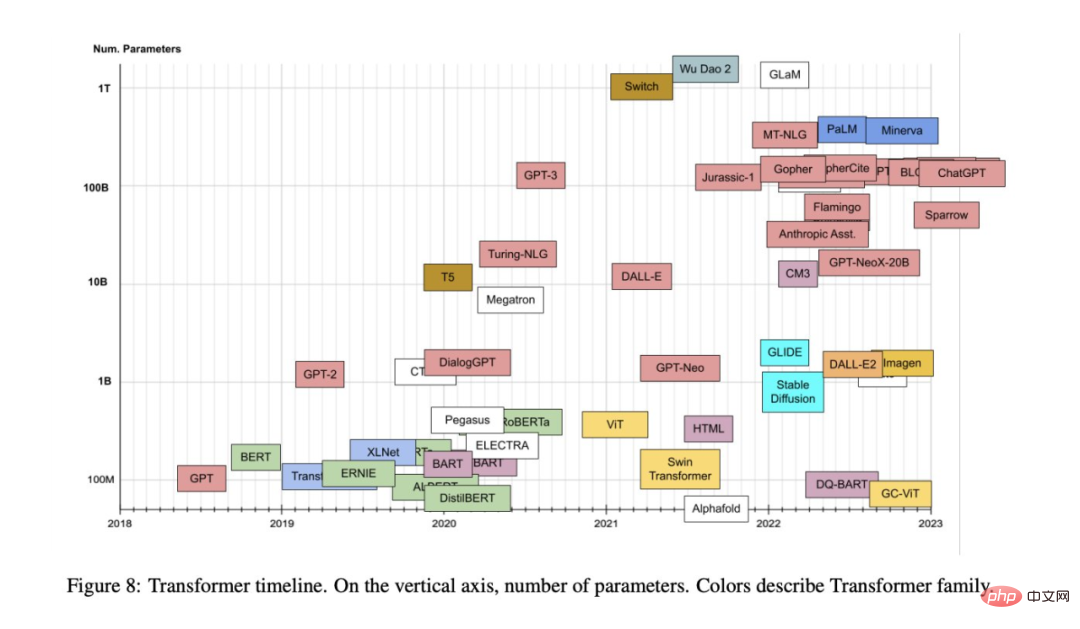

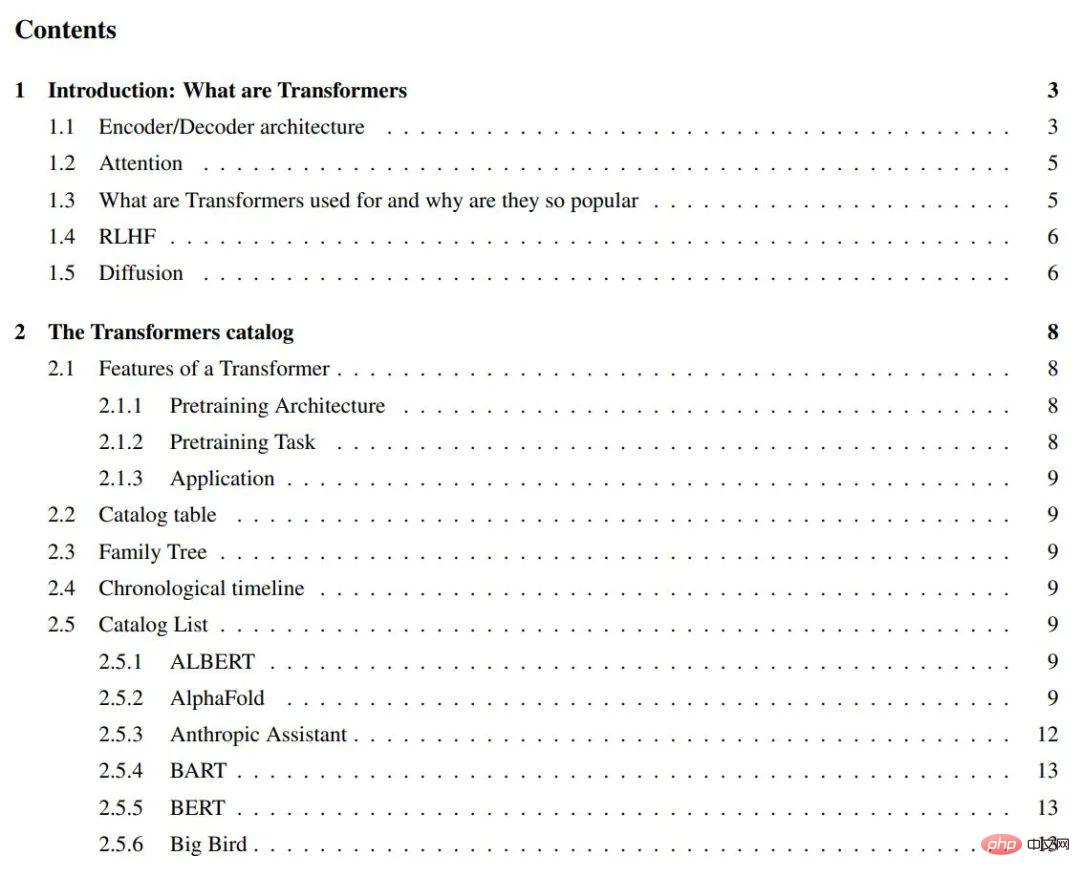

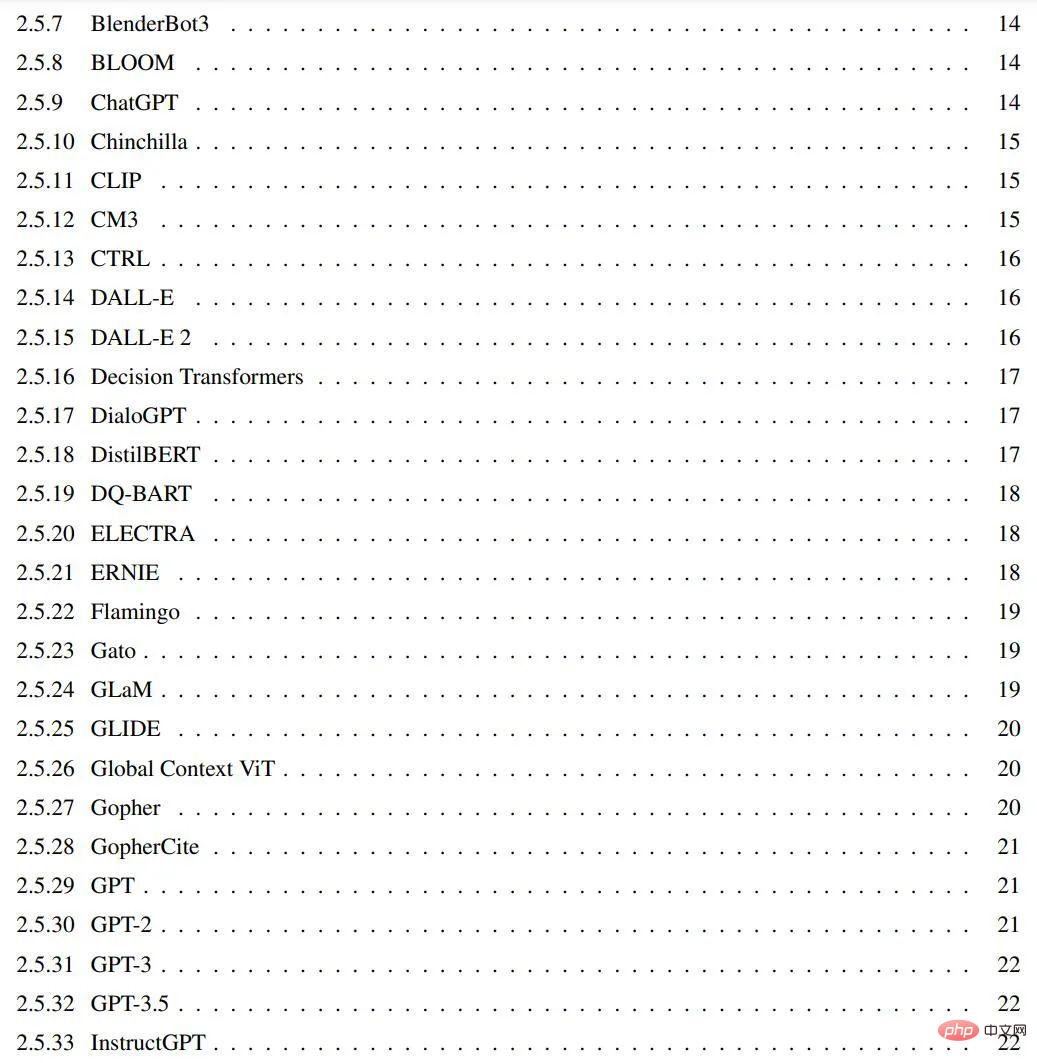

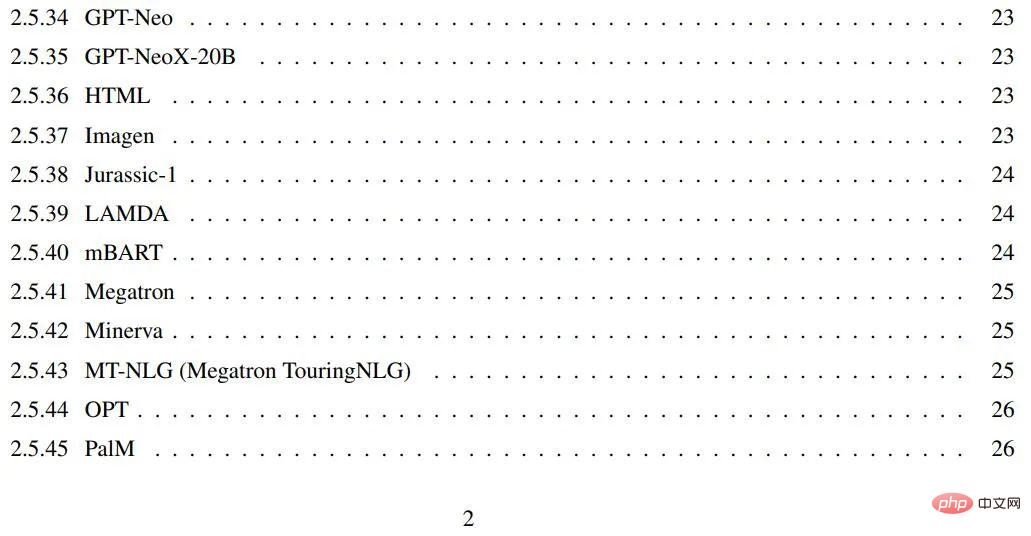

In den letzten Jahren sind Dutzende Modelle aus der Transformer-Familie erschienen, alle mit lustigen und leicht verständlichen Namen. Ziel dieses Artikels ist es, einen relativ umfassenden, aber einfachen Katalog und eine Klassifizierung der beliebtesten Transformer-Modelle bereitzustellen. Darüber hinaus stellt dieser Artikel auch die wichtigsten Aspekte und Neuerungen bei Transformer-Modellen vor.

Das Papier „Transformer-Modelle: eine Einführung und ein Katalog“:

#🎜 🎜 #

Papierlink:

https:// arxiv .org/abs/2302.07730

GitHub: https://github.com/xamat/TransformerCatalog# 🎜 🎜#Einführung: Was ist Transformer? Erschien zum ersten Mal in dem berühmten Artikel „Attention is All you Need“, der 2017 von Google-Forschern veröffentlicht wurde (dieser Artikel wurde in nur 5 Jahren mehr als 38.000 Mal zitiert) und verwandten Blogbeiträgen. Die Transformer-Architektur ist eine spezifische Instanz des Encoder-Decoder-Modells [2], das vor zwei bis drei Jahren populär wurde. Allerdings war Aufmerksamkeit bis dahin nur einer der Mechanismen dieser Modelle, die hauptsächlich auf LSTM (Long Short-Term Memory) [3] und anderen RNN-Varianten (Recurrent Neural Network) [4] basierten. Die wichtigste Erkenntnis des Transformers-Papiers besteht darin, dass, wie der Titel schon sagt, Aufmerksamkeit als einziger Mechanismus zur Ableitung von Abhängigkeiten zwischen Eingaben und Ausgaben verwendet werden kann. Die Diskussion aller Details der Transformer-Architektur würde den Rahmen dieses Blogs sprengen. Zu diesem Zweck empfiehlt dieser Artikel, sich auf das obige Originalpapier oder den Beitrag von Transformers zu beziehen, die beide sehr spannend sind. Allerdings werden in diesem Artikel die wichtigsten Aspekte kurz beschrieben und auch im folgenden Inhaltsverzeichnis erwähnt. Dieser Artikel beginnt mit dem grundlegenden Architekturdiagramm im Originalpapier und erweitert dann den zugehörigen Inhalt.

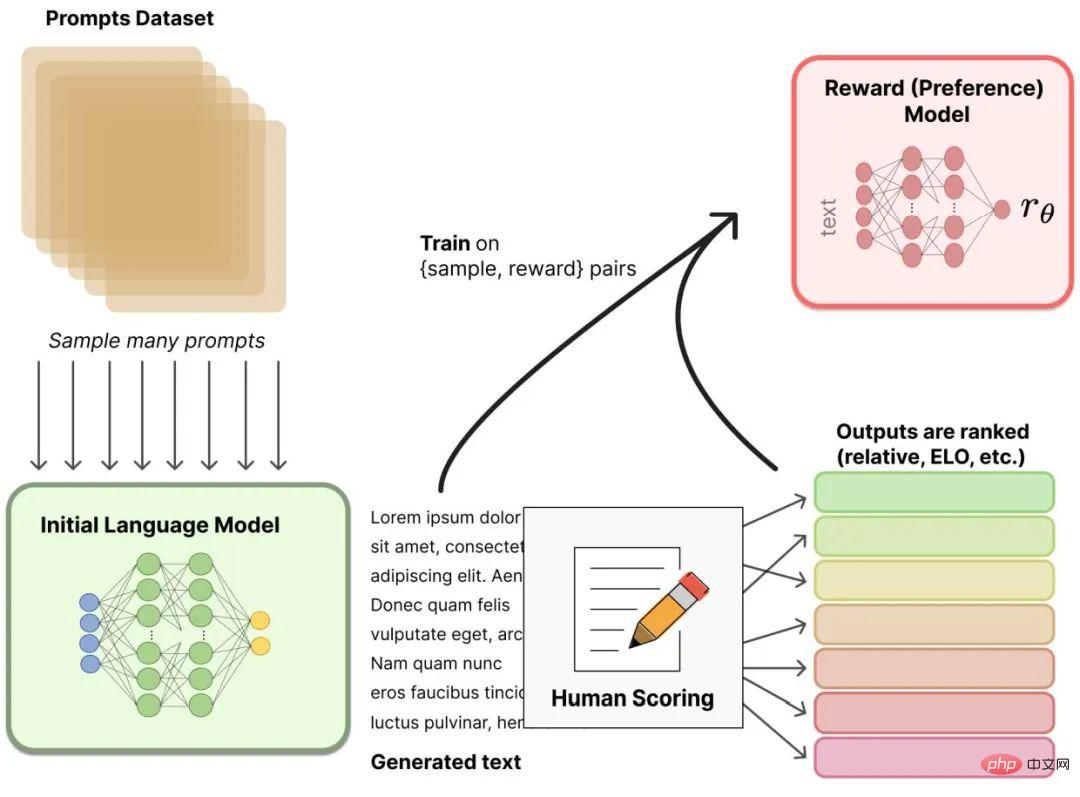

Encoder/Decoder-Architektur

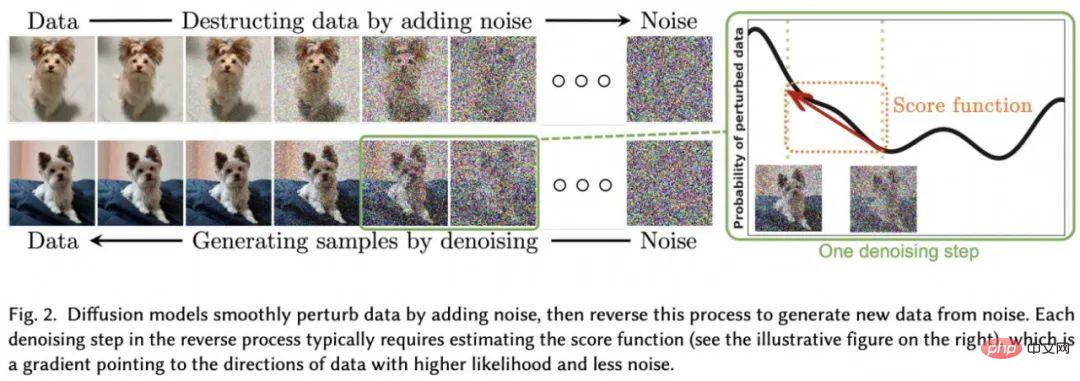

Universal Encoder/ Die Decoder-Architektur (siehe Abbildung 1) besteht aus zwei Modellen. Der Encoder nimmt Eingaben entgegen und codiert sie in einen Vektor fester Länge. Der Decoder nimmt diesen Vektor und dekodiert ihn in eine Ausgabesequenz. Der Encoder und der Decoder werden gemeinsam trainiert, um die bedingte Log-Likelihood zu minimieren. Nach dem Training kann der Encoder/Decoder anhand einer Folge von Eingaben eine Ausgabe generieren oder die Eingabe-/Ausgabesequenzen bewerten. In der ursprünglichen Transformer-Architektur verfügten sowohl der Encoder als auch der Decoder über sechs identische Schichten. Jeder Encoder in diesen 6 Schichten hat zwei Unterschichten: eine Multi-Head-Aufmerksamkeitsschicht und ein einfaches Feedforward-Netzwerk. Jede Unterschicht verfügt über eine Restverbindung und eine Schichtnormalisierung. Die Ausgabegröße des Encoders beträgt 512. Der Decoder fügt eine dritte Unterschicht hinzu, die eine weitere Multi-Head-Aufmerksamkeitsschicht am Encoder-Ausgang darstellt. Zusätzlich wird eine weitere Multi-Head-Schicht im Decoder maskiert. Abbildung 1: Transformator-ArchitekturAbbildung 2: Aufmerksamkeitsmechanismus , hier liegt die volle Kraft des Modells. Was genau ist also Aufmerksamkeit? Eine Aufmerksamkeitsfunktion ist eine Zuordnung zwischen einer Abfrage und einer Reihe von Schlüssel-Wert-Paaren zu einer Ausgabe. Die Ausgabe wird als gewichtete Summe von Werten berechnet, wobei die jedem Wert zugewiesene Gewichtung durch die Kompatibilitätsfunktion der Abfrage mit dem entsprechenden Schlüssel berechnet wird. Transformatoren verwenden Mehrkopfaufmerksamkeit, bei der es sich um die parallele Berechnung einer spezifischen Aufmerksamkeitsfunktion handelt, die als skalierte Skalarproduktaufmerksamkeit bezeichnet wird. Für weitere Einzelheiten zur Funktionsweise des Aufmerksamkeitsmechanismus wird in diesem Artikel erneut auf den Beitrag „The Illustrated Transformer“ verwiesen. Das Diagramm aus dem Originalpapier wird in Abbildung 2 wiedergegeben, um die Hauptidee zu verstehen. Aufmerksamkeitsschichten haben gegenüber wiederkehrenden und Faltungsnetzwerken mehrere Vorteile. Die wichtigsten beiden sind ihre geringere Rechenkomplexität und höhere Konnektivität, die besonders nützlich für das Erlernen langfristiger Abhängigkeiten in Sequenzen sind. Wofür werden Transformer verwendet und warum sind sie so beliebt? Der ursprüngliche Transformer wurde für die Sprachübersetzung entwickelt, insbesondere vom Englischen ins Deutsche. Wie jedoch aus der ursprünglichen Forschungsarbeit hervorgeht, lässt sich die Architektur gut auf andere Sprachaufgaben verallgemeinern. Dieser besondere Trend erregte schnell die Aufmerksamkeit der Forschungsgemeinschaft. In den folgenden Monaten wurden die meisten sprachbezogenen ML-Aufgabenrankings vollständig von einer Version der Transformer-Architektur dominiert (z. B. dem berühmten SQUAD-Ranking, bei dem alle Topmodelle eine Sammlung von Transformers sind). Einer der Hauptgründe dafür, dass Transformer die meisten NLP-Ranglisten so schnell dominieren können, ist ihre Fähigkeit, sich schnell an andere Aufgaben anzupassen, auch bekannt als Transferlernen. Vortrainierte Transformer-Modelle können sehr einfach und schnell an Aufgaben angepasst werden, für die sie nicht trainiert wurden, was einen großen Vorteil hat. Als ML-Praktiker müssen Sie keine großen Modelle mehr anhand riesiger Datensätze trainieren. Alles, was Sie tun müssen, ist, das vorab trainierte Modell in Ihrer Aufgabe wiederzuverwenden und es möglicherweise mit einem viel kleineren Datensatz leicht zu optimieren. Eine spezielle Technik zur Anpassung eines vorab trainierten Modells an verschiedene Aufgaben wird als Feinabstimmung bezeichnet. Natürlich wäre keine dieser Anwendungen möglich, wenn es nicht die unzähligen Tools gäbe, mit denen jeder problemlos ein paar Zeilen Code schreiben kann. Transformer kann nicht nur schnell in große Frameworks für künstliche Intelligenz (z. B. Pytorch8 und TF9) integriert werden, sondern es können sogar ganze Unternehmen darauf aufbauen. Huggingface, ein Startup, das bisher über 60 Millionen US-Dollar eingesammelt hat, basiert fast ausschließlich auf der Idee, die Open-Source-Transformer-Bibliothek zu kommerzialisieren. Abschließend ist es notwendig, über die Auswirkungen von GPT-3 auf Transformer in den frühen Stadien seiner Popularität zu sprechen. GPT-3 ist ein Transformer-Modell, das im Mai 2020 von OpenAI eingeführt wurde und eine Weiterentwicklung der früheren GPT und GPT-2 darstellt. Das Unternehmen sorgte für großes Aufsehen, als es das Modell in einem Vorabdruck vorstellte, von dem es behauptete, es sei so leistungsstark, dass es nicht der Welt zugänglich gemacht werden konnte. Seitdem wurde das Modell nicht nur veröffentlicht, sondern durch eine massive Zusammenarbeit zwischen OpenAI und Microsoft auch kommerzialisiert. GPT-3 unterstützt über 300 verschiedene Anwendungen und ist von grundlegender Bedeutung für die Geschäftsstrategie von OpenAI (was für ein Unternehmen, das über 1 Milliarde US-Dollar an Finanzmitteln eingesammelt hat, sinnvoll ist). RLHF In letzter Zeit ist das verstärkende Lernen aus menschlichem Feedback (oder Präferenzen) (RLHF (auch bekannt als RLHP)) zu einer großen Ergänzung des Toolkits für künstliche Intelligenz geworden Es wurde in „Deep Reinforcement Learning from Human Preferences“ vorgeschlagen und kürzlich auf ChatGPT und ähnliche Konversationsagenten wie BlenderBot oder Sparrow angewendet. Die Idee ist einfach: Sobald das Sprachmodell vorab trainiert ist, kann der Benutzer unterschiedliche Antworten darauf generieren Sie können die Antworten bewerten und die Ergebnisse bewerten (d. h. Präferenzen oder Feedback), um Belohnungen in einer bestärkenden Lernumgebung zu trainieren. Diffusionsmodelle sind zum neuen SOTA in der Bilderzeugung geworden und verdrängen offenbar frühere Methoden wie GANs (Generative Adversarial Networks). Was ist ein Diffusionsmodell? Sie sind eine Klasse latenter Variablenmodelle, die mit Variationsinferenz trainiert werden. Ein auf diese Weise trainiertes Netzwerk lernt tatsächlich den latenten Raum, der durch diese Bilder dargestellt wird (siehe Abbildung 4). Diffusionsmodelle sind mit anderen generativen Modellen verwandt, wie etwa den berühmten [Generative Adversarial Networks (GAN)] 16, die in vielen Anwendungen, insbesondere durch (entrauschende) Autoencoder, ersetzt wurden. Einige Autoren sagen sogar, dass Diffusionsmodelle nur ein spezifisches Beispiel für Autoencoder seien. Sie erkennen jedoch auch an, dass kleine Unterschiede ihre Anwendung von der zugrunde liegenden Darstellung des Autoconders auf die rein generative Natur des Diffusionsmodells ändern.

Abbildung 3: Reinforcement Learning mit menschlichem Feedback.

Abbildung 4: Probabilistische Diffusionsmodellarchitektur ist ein Auszug aus „Diffusion Models: A Comprehensive Survey of Methods and Applications“

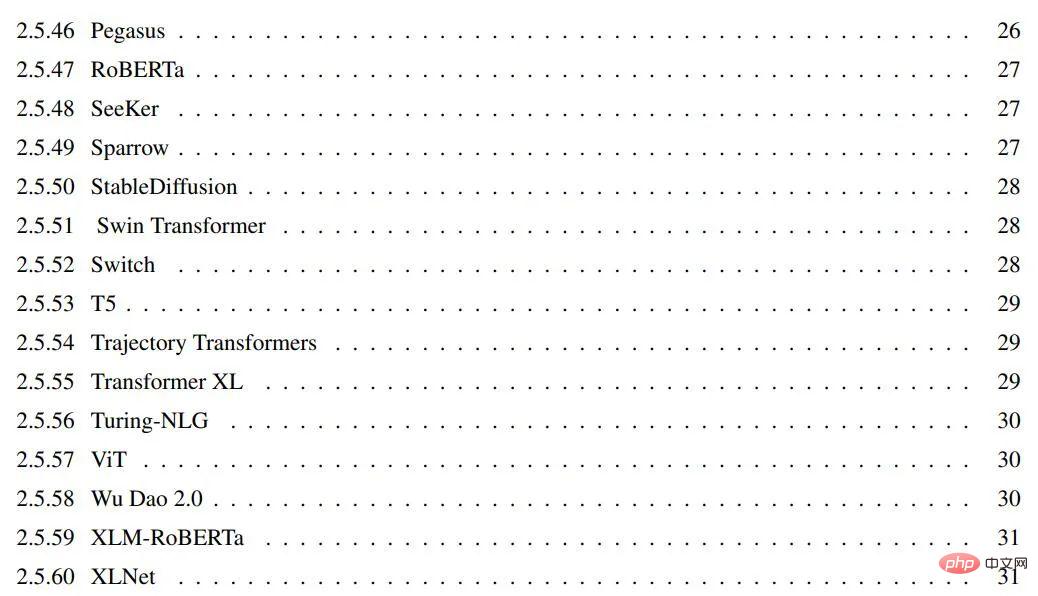

Die in vorgestellten Modelle Dieser Artikel enthält:

Das obige ist der detaillierte Inhalt vonDas Transformer-Universum wurde in fünf Jahren 38.000 Mal zitiert und hat sich auf diese Weise entwickelt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

vim-Befehl zum Speichern und Beenden

vim-Befehl zum Speichern und Beenden

So wechseln Sie auf dem Laptop in den abgesicherten Modus

So wechseln Sie auf dem Laptop in den abgesicherten Modus

Wie wurde der Name von tt voice geändert?

Wie wurde der Name von tt voice geändert?

Was ist der Baidu-Index?

Was ist der Baidu-Index?

Was sind die Befehle zur Datenträgerbereinigung?

Was sind die Befehle zur Datenträgerbereinigung?

Was bedeutet Harmonios?

Was bedeutet Harmonios?

Drei häufig verwendete Kodierungsmethoden

Drei häufig verwendete Kodierungsmethoden

Befehl zum Neustart der Netzwerkkarte unter Linux

Befehl zum Neustart der Netzwerkkarte unter Linux