Vor zehn Jahren wurde der Aufstieg des Deep Learning teilweise durch die Integration neuer Algorithmen und Architekturen, eine erhebliche Datenzunahme und Verbesserungen der Rechenleistung vorangetrieben. In den letzten 10 Jahren sind KI- und ML-Modelle tiefer und komplexer geworden, mit mehr Parametern und Trainingsdaten, wodurch sie größer und schwerfälliger geworden sind, was zu einigen der transformativsten Ergebnisse in der Geschichte des maschinellen Lernens geführt hat.

Diese Modelle werden zunehmend in Produktions- und Geschäftsanwendungen eingesetzt, und gleichzeitig haben sich ihre Effizienz und Kosten von zweitrangigen Überlegungen zu primären Einschränkungen entwickelt. Um große Herausforderungen auf vier Ebenen anzugehen: effiziente Architektur, Trainingseffizienz, Dateneffizienz und Inferenzeffizienz, investiert Google weiterhin stark in die ML-Effizienz. Neben der Effizienz stehen diese Modelle vor vielen Herausforderungen hinsichtlich Authentizität, Sicherheit, Datenschutz und Aktualität. Als Nächstes konzentriert sich dieser Artikel auf die Bemühungen von Google Research bei der Entwicklung neuer Algorithmen zur Bewältigung der oben genannten Herausforderungen.

Die Grundfrage der Forschung lautet: „Gibt es eine bessere Möglichkeit, das Modell zu parametrisieren, um die Effizienz zu verbessern?“ Im Jahr 2022 konzentrieren sich die Forscher auf das Abrufen von Kontexten und das Mischen von Expertensystemen und die Effizienz des Transformers (dem Herzstück großer ML-Modelle) verbessern, um neue Technologien zu entwickeln, die durch Verbesserung des Modells externes Wissen einbringen.

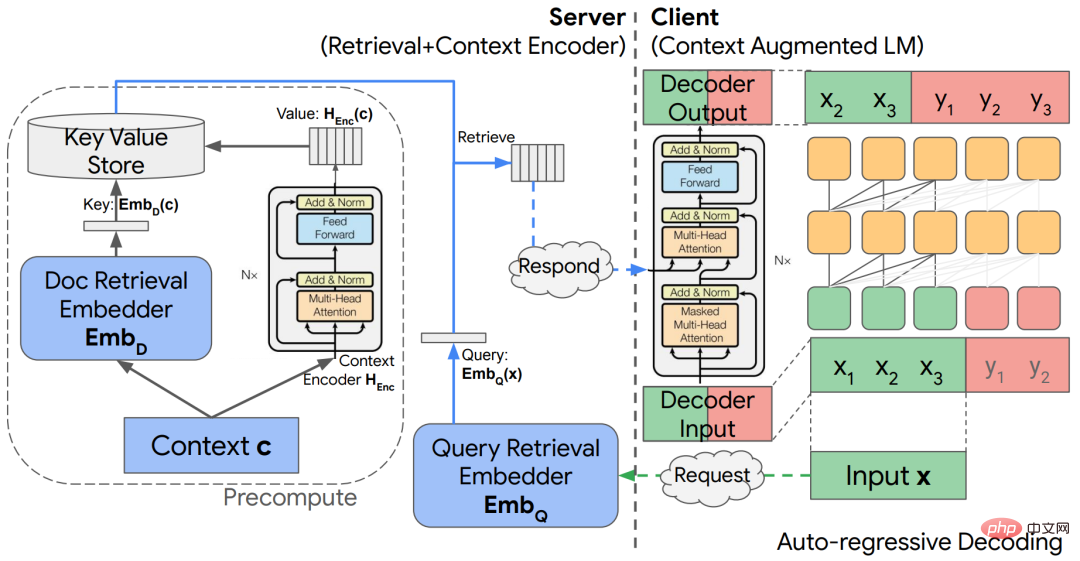

Im Streben nach höherer Qualität und Effizienz kann es mit externem Kontext aus einer großen Datenbank oder einem trainierbaren Speicher erweitert werden neuronales Modell. Durch die Nutzung des abgerufenen Kontexts können neuronale Netze eine bessere Parametereffizienz, Interpretierbarkeit und Realismus erreichen, ohne dass Wissen umfassend in ihren internen Parametern gespeichert werden muss.

In einem Artikel mit dem Titel „Entkoppelte Kontextverarbeitung für kontexterweiterte Sprachmodellierung“ wurde eine einfache Architektur untersucht, die auf einer entkoppelten Encoder-Decoder-Architektur basiert, um externen Kontext in Sprachmodelle zu integrieren. Dies führt zu erheblichen Recheneinsparungen bei der autoregressiven Sprachmodellierung und bei der Beantwortung von Fragen im offenen Bereich. Allerdings verbrauchen vorab trainierte große Sprachmodelle (LLMs) eine große Menge an Informationen durch Selbstüberwachung an großen Trainingssätzen. Es ist jedoch unklar, wie das Wissen dieser Modelle über die Welt mit dem dargestellten Kontext interagiert. Durch wissensbewusste Feinabstimmung (Knowledge-Aware Fine-Tuning, KAFT) integrieren Forscher kontrafaktischen und irrelevanten Kontext in überwachte Standarddatensätze, was die Kontrollierbarkeit und Robustheit von LLM verbessert.

Papieradresse: https://arxiv.org/abs/2210.05758

Encoder-Decoder für Kontextzusammenführung Die Queraufmerksamkeit Der Mechanismus ermöglicht die Entkopplung von Kontextkodierung und Sprachmodellinferenz, wodurch die Effizienz kontexterweiterter Modelle verbessert wird.

Bei der Suche nach modularen tiefen Netzwerken besteht eines der Probleme darin, wie eine konzeptionelle Datenbank mit entsprechenden Rechenmodulen entworfen werden kann. Die Forscher schlugen eine theoretische Architektur vor, die „Erinnerungsereignisse“ in Form von Skizzen in einer externen LSH-Tabelle speichert, die ein Zeigermodul zur Verarbeitung von Skizzen enthält.

Die Nutzung von Beschleunigern zum schnellen Abrufen von Informationen aus großen Datenbanken ist eine weitere große Herausforderung für kontexterweiterte Modelle. Die Forscher entwickelten einen TPU-basierten Ähnlichkeitssuchalgorithmus, der mit dem Leistungsmodell der TPU konsistent ist und analytische Garantien für den erwarteten Rückruf bietet, wodurch Spitzenleistungen erzielt werden. Suchalgorithmen beinhalten oft eine große Anzahl von Hyperparametern und Designoptionen, was es schwierig macht, sie bei der Ausführung neuer Aufgaben zu optimieren. Forscher schlagen einen neuen eingeschränkten Optimierungsalgorithmus für die automatisierte Optimierung von Hyperparametern vor. Durch die Festlegung der gewünschten Kosten oder Rückrufe als Eingabe erzeugt der vorgeschlagene Algorithmus Abstimmungen, die empirisch sehr nahe an der Geschwindigkeits-Rückruf-Pareto-Grenze liegen und eine führende Leistung bei Standard-Benchmarks bieten.

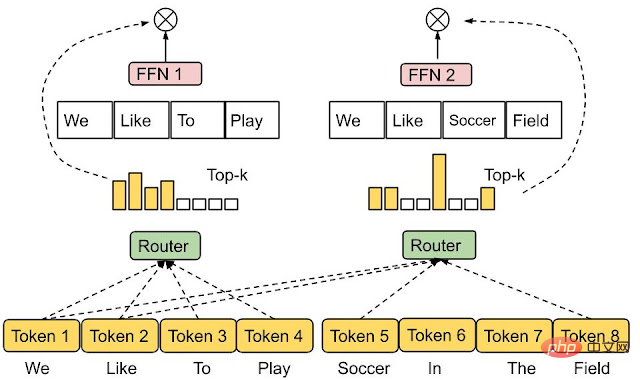

Mixed-Expert-Modelle (MoE) haben sich als wirksames Mittel zur Erhöhung der Kapazität neuronaler Netzwerkmodelle erwiesen, ohne die Rechenkosten übermäßig zu erhöhen. Die Grundidee von MoE besteht darin, aus vielen Experten-Subnetzwerken ein einheitliches Netzwerk aufzubauen, in dem jede Eingabe von einer entsprechenden Experten-Submenge verarbeitet wird. Infolgedessen ruft MoE im Vergleich zu standardmäßigen neuronalen Netzen nur einen Bruchteil des gesamten Modells auf, was zu hohen Effizienzen führt, wie in Sprachmodellanwendungen wie GLaM gezeigt.

Jeder Eingabetoken in der GLaM-Architektur wird zur Vorhersage dynamisch an zwei der 64 Expertennetzwerke weitergeleitet.

Für eine bestimmte Eingabe ist die Routing-Funktion dafür verantwortlich, zu entscheiden, welche Experten aktiviert werden sollen. Das Design dieser Funktion ist eine Herausforderung, da die Forscher eine Unter- und Überauslastung jedes Experten vermeiden möchten. Eine aktuelle Arbeit schlägt Expert Selection Routing vor, einen neuen Routing-Mechanismus, der, anstatt jedes Eingabe-Token Top-k-Experten zuzuweisen, jeden Experten Top-k-Token zuweist. Dadurch wird automatisch eine Lastenverteilung durch Experten gewährleistet, während natürlich auch mehrere Experten mit einem Eingabetoken umgehen können.

Experten wählen die Route. Experten mit vorgegebener Pufferkapazität werden Top-K-Token zugewiesen und sorgen so für einen Lastausgleich. Jeder Token kann von einer variablen Anzahl von Experten bearbeitet werden.

Transformer ist ein beliebtes Sequenz-zu-Sequenz-Modell, das bei einer Reihe anspruchsvoller Probleme vom Sehen bis zum Verständnis natürlicher Sprache bemerkenswerte Erfolge erzielt hat. Die Kernkomponente dieses Modells ist die Aufmerksamkeitsschicht, die Ähnlichkeiten zwischen Abfragen und Schlüsseln identifiziert und diese Ähnlichkeiten nutzt, um eine entsprechend gewichtete Kombination von Werten zu konstruieren. Obwohl die Leistung hoch ist, ist die Recheneffizienz des Aufmerksamkeitsmechanismus nicht hoch und die Komplexität beträgt normalerweise die zweite Potenz der Länge der Eingabesequenz.

Da der Umfang von Transformer weiter wächst, ist eine der für die Forschung sehr wertvollen Fragen, ob es natürlich vorkommende Strukturen oder Muster von Lernmodellen gibt, die das Prinzip der effektiven Aufmerksamkeit lösen können. Zu diesem Zweck untersuchten die Forscher erlernte Einbettungen in MLP-Zwischenschichten und stellten fest, dass diese sehr spärlich sind – beispielsweise weist das T5-Large-Modell 1 % Nicht-Null-Einträge auf. Die Sparsity zeigt weiter, dass man FLOPs potenziell reduzieren kann, ohne die Modellleistung zu beeinträchtigen.

Papieradresse: https://arxiv.org/pdf/2210.06313.pdf

Kürzlich hat die Forschung Treeformer eingeführt – eine Alternative zu Standard-Aufmerksamkeitsberechnungen, die auf Entscheidungsbäumen basiert. Einfach ausgedrückt: Dadurch wird schnell eine kleine Teilmenge von Schlüsseln identifiziert, die für eine Abfrage relevant sind, und Aufmerksamkeitsoperationen werden nur für diese Menge ausgeführt. Als Faustregel gilt, dass Treeformer die FLOPs der Aufmerksamkeitsschicht um das 30-fache reduzieren kann. Darüber hinaus gibt es Sequential Attention – eine Methode zur Auswahl differenzierbarer Merkmale, die Aufmerksamkeits- und Greedy-Algorithmen kombiniert. Die Technik verfügt über starke nachweisbare Garantien für lineare Modelle und lässt sich nahtlos auf große Einbettungsmodelle übertragen.

Eine weitere Möglichkeit, die Transformer-Effizienz zu verbessern, besteht darin, die Softmax-Berechnung in der Aufmerksamkeitsschicht zu beschleunigen. Basierend auf der Forschung zur „Low-Rank-Approximation des Softmax-Kernels“ schlugen die Forscher einen neuen Typ von Zufallsmerkmalen vor, der die erste „positive und begrenzte“ Zufallsmerkmalsnäherung des Softmax-Kernels bereitstellt und die Sequenzlänge berechnet Linear.

Effiziente Optimierungsmethoden sind der Grundstein moderner ML-Anwendungen, und dies ist besonders wichtig in großen Umgebungen. In diesem Umfeld sind selbst adaptive Methoden erster Ordnung wie Adam oft teuer und stehen vor Herausforderungen hinsichtlich der Trainingsstabilität. Darüber hinaus sind diese Methoden normalerweise unabhängig von der Architektur des neuronalen Netzwerks, wodurch der Reichtum der Architektur ignoriert wird, was zu einer geringen Trainingseffizienz führt. Dies führt auch dazu, dass kontinuierlich neue Technologien vorgeschlagen werden, um moderne neuronale Netzwerkmodelle effektiver zu optimieren. Forscher entwickeln neue architekturbewusste Trainingstechniken. Einige Studien zum Training von Transformer-Netzwerken umfassen beispielsweise neue skaleninvariante Transformer-Netzwerke und neue Pruning-Methoden in Kombination mit stochastischem Gradientenabstieg (SGD), um den Trainingsprozess zu beschleunigen. Mit Hilfe dieser Methode konnten Forscher BERT erstmals effektiv mit einfachem SGD trainieren, ohne dass eine Anpassung erforderlich war.

Papieradresse: https://arxiv.org/pdf/2210.05758.pdf

Darüber hinaus schlugen die Forscher mit Hilfe von LocoProp eine neue Methode vor – Ähnliches erreichen Leistung einem Optimierer zweiter Ordnung und nutzt dabei die gleichen Rechen- und Speicherressourcen wie ein Optimierer erster Ordnung. LocoProp betrachtet neuronale Netze modular und zerlegt sie in Schichtenzusammensetzungen. Jede Schicht darf dann über eine eigene Verlustfunktion sowie Ausgabeziele und Gewichtsregulatoren verfügen. Bei diesem Setup aktualisiert LocoProp nach entsprechenden Vorwärts- und Rückwärtsdurchläufen weiterhin parallel den lokalen Verlust jeder Schicht. Tatsächlich kann gezeigt werden, dass diese Aktualisierungen sowohl theoretisch als auch empirisch denen von Optimierern höherer Ordnung ähneln. Beim Deep-Autoencoder-Benchmark erreicht LocoProp eine mit höherwertigen Optimierern vergleichbare Leistung und verfügt gleichzeitig über einen Geschwindigkeitsvorteil.

Link zum Papier: https://proceedings.mlr.press/v151/amid22a.html

Ähnlich wie bei der Backpropagation wendet LocoProp einen Vorwärtsdurchlauf an, um Aktivierungen zu berechnen. In einem Rückwärtsdurchlauf legt LocoProp pro Neuron Ziele für jede Schicht fest. Schließlich teilt LocoProp das Modelltraining in unabhängige Probleme über Schichten hinweg auf, wobei mehrere lokale Aktualisierungen parallel auf die Gewichte jeder Schicht angewendet werden können. Die Kernidee von Optimierern wie

SGD besteht darin, dass jeder Datenpunkt unabhängig und identisch aus der Verteilung abgetastet wird. Leider lässt sich dies in realen Umgebungen nur schwer erfüllen, beispielsweise beim Reinforcement Learning, bei dem das Modell (oder der Agent) aus Daten lernen muss, die auf der Grundlage seiner eigenen Vorhersagen generiert wurden. Die Forscher schlugen einen neuen SGD-Algorithmus vor, der auf der umgekehrten Erfahrungswiedergabe basiert und optimale Lösungen in linearen dynamischen Systemen, nichtlinearen dynamischen Systemen und Q-Learning finden kann. Darüber hinaus haben Studien gezeigt, dass eine erweiterte Version dieser Methode, IER, derzeit die modernste und stabilste Erfahrungswiedergabetechnik in verschiedenen beliebten RL-Benchmarks ist.

Papieradresse: https://arxiv.org/pdf/2103.05896.pdf

Bei vielen Aufgaben sind tiefe neuronale Netze stark auf große Datensätze angewiesen. Zusätzlich zu den Speicherkosten und potenziellen Sicherheits-/Datenschutzproblemen, die mit großen Datensätzen einhergehen, verursacht das Training moderner tiefer neuronaler Netze auf der Grundlage solcher Datensätze auch hohe Rechenkosten. Eine Möglichkeit, dieses Problem zu lösen, besteht darin, eine Teilmenge der Daten auszuwählen.

Die Forscher analysierten ein Teilmengenauswahl-Framework, das für die Arbeit mit beliebigen Modellfamilien in praktischen Stapelverarbeitungseinstellungen entwickelt wurde. In diesem Fall kann der Lernende jeweils ein Beispiel ausprobieren und dabei sowohl auf den Kontext als auch auf die wahre Bezeichnung zugreifen. Um den Overhead zu begrenzen, kann der Status (d. h. Gewichtungen des weiteren Trainingsmodells) jedoch erst aktualisiert werden, nachdem eine ausreichende Anzahl von Beispielen erstellt wurde ausgewählt. Die Forscher entwickelten einen Algorithmus namens IWeS, der Beispiele durch Wichtigkeitsstichproben auswählt, wobei die jedem Beispiel zugewiesene Stichprobenwahrscheinlichkeit auf der Entropie eines Modells basiert, das auf zuvor ausgewählten Chargen trainiert wurde. Die in der Studie bereitgestellte theoretische Analyse zeigt Grenzen bei der Generalisierung und den Stichprobenraten auf.

Papieradresse: https://arxiv.org/pdf/2301.12052.pdf

Ein weiteres Problem beim Training großer Netzwerke besteht darin, dass sie möglicherweise sehr anfällig für Verteilungsänderungen zwischen den Trainingsdaten und den Daten sind, die bei der Bereitstellung von Sensitive angezeigt werden , insbesondere wenn mit einer begrenzten Menge an Trainingsdaten gearbeitet wird, die möglicherweise nicht alle Bereitstellungszeitszenarien abdecken. Eine aktuelle Studie, die die Hypothese aufstellte, dass „extreme Einfachheitsverzerrung“ das Schlüsselproblem hinter dieser Fragilität neuronaler Netze ist, machte diese Hypothese möglich und führte zur Kombination zweier neuer komplementärer Methoden – DAFT und FRR –, die deutlich robustere neuronale Netze liefern können. Insbesondere nutzen diese beiden Methoden kontradiktorische Feinabstimmung sowie umgekehrte Feature-Vorhersage, um das Lernnetzwerk zu stärken.

Papieradresse: https://arxiv.org/pdf/2006.07710.pdf

Es stellt sich heraus, dass eine Vergrößerung eines neuronalen Netzwerks dessen Leistung verbessern kann Vorhersagegenauigkeit. Allerdings ist die Realisierung dieser Vorteile in der realen Welt eine Herausforderung, da die Inferenzkosten großer Modelle für die Bereitstellung sehr hoch sind. Dies fördert Strategien zur Verbesserung der Serviceeffizienz ohne Einbußen bei der Genauigkeit. Im Jahr 2022 untersuchten Experten verschiedene Strategien, um dieses Ziel zu erreichen, insbesondere solche, die auf Wissensdestillation und adaptivem Computing basieren.

Destillation

Die Destillation ist eine einfache und effektive Modellkomprimierungsmethode, die die potenzielle Anwendbarkeit großer neuronaler Modelle erheblich erweitert. Studien haben gezeigt, dass die Destillation in einer Reihe praktischer Anwendungen wie Werbeempfehlungen eine Rolle spielen kann. In den meisten Anwendungsfällen der Destillation geht es um die direkte Anwendung eines Grundrezepts auf einen bestimmten Bereich, wobei nur begrenzt bekannt ist, wann und warum dies funktionieren sollte. Die diesjährige Studie von Google befasste sich mit der Anpassung der Destillation an bestimmte Umgebungen und untersuchte offiziell die Faktoren, die den Destillationserfolg steuern.

Auf der algorithmischen Seite entwickeln wir einen wichtigen Ansatz zur Neugewichtung von Trainingsbeispielen, indem wir das Rauschen in Lehrerbezeichnungen sorgfältig modellieren, und eine effiziente Maßnahme, um eine Teilmenge der Daten abzutasten, um Lehrerbezeichnungen zu erhalten. Google erklärte in „Teacher Guided Training: An Efficient Framework for Knowledge Transfer“, dass Lehrer nicht passiv zur Kommentierung fester Datensätze eingesetzt werden, sondern dass Lehrer aktiv dazu genutzt werden, die Auswahl der zu kommentierenden informativen Beispiele zu steuern. Dadurch zeichnet sich der Destillationsprozess bei begrenzten Daten oder Long-Tail-Einstellungen aus.

Papieradresse: https://arxiv.org/pdf/2208.06825.pdf

Darüber hinaus hat Google auch Untersuchungen vom Cross-Encoder (Dual-Encoder wie BERT) zur faktoriellen Dual-Codierung A durchgeführt Neue Methode für den Dual-Encoder, der auch eine wichtige Einstellung zur Bewertung der Relevanz von (Abfrage-, Dokument-)Paaren darstellt. Die Forscher untersuchten die Gründe für den Leistungsunterschied zwischen Cross-Encodern und Dual-Encodern und stellten fest, dass dies möglicherweise eher auf die Verallgemeinerung als auf Kapazitätsbeschränkungen von Dual-Encodern zurückzuführen ist. Eine sorgfältige Konstruktion der Destillationsverlustfunktion kann diese Situation entschärfen und die Lücke zwischen Cross-Encoder- und Dual-Encoder-Leistung verringern. Anschließend untersuchen wir in Embedtitil die weitere Verbesserung der Dual-Encoder-Destillation durch Anpassen der Einbettungen im Lehrermodell. Diese Strategie kann auch verwendet werden, um Informationen aus großen bis kleinen Dual-Encoder-Modellen zu extrahieren, wobei sich die Übernahme und das Einfrieren der Dokumenteinbettungen des Lehrers als sehr effektiv erweisen kann.

Papieradresse: https://arxiv.org/pdf/2301.12005.pdf

Theoretisch bietet die Forschung eine neue Perspektive auf die Destillation aus der Perspektive der Aufsichtskomplexität Dies ist ein Maß dafür, wie gut Schüler Lehrerbezeichnungen vorhersagen können. Die NTK-Theorie (Neural Tangent Kernel) liefert konzeptionelle Erkenntnisse. Die Forschung zeigt außerdem, dass Destillation dazu führen kann, dass Schüler nicht in Punkte passen, die das Lehrermodell als schwierig zu modellieren erachtet. Intuitiv kann dies den Schülern helfen, ihre begrenzten Fähigkeiten auf die Stichproben zu konzentrieren, die sinnvoll modelliert werden können.

Papieradresse: https://arxiv.org/pdf/2301.12245.pdf

Während die Destillation ein wirksames Mittel zur Reduzierung der Inferenzkosten ist, ist sie bei allen Proben konsistent. Allerdings erfordern einige einfache Proben intuitiv möglicherweise von Natur aus weniger Berechnungen als harte Proben. Das Ziel des adaptiven Rechnens besteht darin, Mechanismen zu entwerfen, die eine solche stichprobenabhängige Berechnung ermöglichen.

CALM (Confident Adaptive Language Modeling) führt kontrollierte Early-Exit-Funktionalität für Transformer-basierte Textgeneratoren wie T5 ein.

Papieradresse: https://arxiv.org/pdf/2207.07061.pdf

Bei dieser Form der adaptiven Berechnung modifiziert das Modell jeden Decodierungsschritt dynamisch mithilfe der Anzahl der Transformatoren Schichten. Das Early-Exit-Gate verwendet ein Konfidenzmaß mit einem Entscheidungsschwellenwert, der so kalibriert ist, dass er statistische Leistungsgarantien erfüllt. Auf diese Weise muss das Modell nur für die anspruchsvollsten Vorhersagen den gesamten Stapel von Decoderschichten berechnen. Einfachere Vorhersagen erfordern nur die Berechnung einiger Decoderschichten. In der Praxis verwendet das Modell durchschnittlich etwa ein Drittel so viele Schichten, um Vorhersagen zu treffen, was zu einer zwei- bis dreifachen Geschwindigkeitssteigerung bei gleichbleibender Generierungsqualität führt.

Generieren Sie Text mit dem regulären Sprachmodell (oben) und CALM (unten). CALM versucht, frühe Vorhersagen zu treffen. Sobald der generierte Inhalt sicher genug ist (dunkelblauer Farbton), wird er übersprungen, um Zeit zu sparen.

Ein beliebter adaptiver Rechenmechanismus ist die Kaskade von zwei oder mehr Grundmodellen. Eine wichtige Frage bei der Verwendung von Kaskaden ist, ob einfach die Vorhersagen des aktuellen Modells verwendet oder Vorhersagen auf nachgelagerte Modelle verschoben werden sollen. Um zu lernen, wann eine Verzögerung angebracht ist, muss eine geeignete Verlustfunktion entworfen werden, die geeignete Signale als Überwachung für die Verzögerung von Entscheidungen nutzen kann. Um dieses Ziel zu erreichen, haben die Forscher bestehende Verlustfunktionen formal untersucht und gezeigt, dass sie aufgrund impliziter Label-Glättungsanwendungen möglicherweise nicht für Trainingsproben geeignet sind. Untersuchungen haben gezeigt, dass dies durch ein nachträgliches Training verzögerter Regeln gemildert werden kann, das keinerlei Änderung der Modellinterna erfordert.

Papieradresse: https://openreview.net/pdf?id=_jg6Sf6tuF7

Für Abrufanwendungen verwenden standardmäßige semantische Suchtechniken einen festen Wert für jede von Large generierte Einbettung Modelle ausdrücken. Das heißt, die Größe und Fähigkeiten der Darstellung sind im Wesentlichen festgelegt, unabhängig von den nachgelagerten Aufgaben und den damit verbundenen Rechenumgebungen oder Einschränkungen. MRL (Matryoshka Representation Learning) bietet die Flexibilität, die Darstellung entsprechend der Bereitstellungsumgebung anzupassen. In Verbindung mit Standardtechniken für die Suche nach ungefähren nächsten Nachbarn wie ScaNN ist MRL in der Lage, bis zu 16-mal weniger Berechnungen durchzuführen und dabei dieselben Recall- und Präzisionsmetriken zu verwenden.

Papieradresse: https://openreview.net/pdf?id=9njZa1fm35

Das obige ist der detaillierte Inhalt vonWie Sie die Effizienz von Deep-Learning-Algorithmen verbessern können, hat Google mit diesen Tricks. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Algorithmus zum Ersetzen von Seiten

Algorithmus zum Ersetzen von Seiten

Welche Fähigkeiten sind erforderlich, um in der PHP-Branche zu arbeiten?

Welche Fähigkeiten sind erforderlich, um in der PHP-Branche zu arbeiten?

So erstellen Sie ein rundes Bild in ppt

So erstellen Sie ein rundes Bild in ppt

Verwendung von strncpy

Verwendung von strncpy

Gängige Codierungsmethoden

Gängige Codierungsmethoden

Ripple-Zukunftsprognose

Ripple-Zukunftsprognose

cmccedu

cmccedu

Was tun, wenn beim Klicken auf das Eingabefeld kein Cursor angezeigt wird?

Was tun, wenn beim Klicken auf das Eingabefeld kein Cursor angezeigt wird?