Forscher der KI-Forschungsabteilung von Meta haben kürzlich eine Ankündigung veröffentlicht, in der sie wichtige Fortschritte bei der Koordination adaptiver Fähigkeiten von Robotern und der Replikation des visuellen Kortex ankündigen. Sie sagen, dass diese Fortschritte es KI-betriebenen Robotern ermöglichen, in der realen Welt durch Vision zu agieren, ohne dass Daten aus der realen Welt erfasst werden müssen.

Sie behaupten, dies sei ein großer Fortschritt bei der Entwicklung universell einsetzbarer „Embodied AI“-Roboter, die ohne menschliches Eingreifen mit der realen Welt interagieren können. Die Forscher sagten auch, dass sie einen künstlichen visuellen Kortex namens „VC-1“ geschaffen hätten, der auf dem Ego4D-Datensatz trainiert wurde, der die täglichen Aktivitäten von Tausenden von Forschungsteilnehmern auf der ganzen Welt aufzeichnet.

Wie die Forscher in einem zuvor veröffentlichten Blogbeitrag erklärten, ist der visuelle Kortex der Bereich des Gehirns, der es Organismen ermöglicht, Sehen in Bewegung umzuwandeln. Daher ist ein künstlicher visueller Kortex eine wichtige Voraussetzung für jeden Roboter, der Aufgaben basierend auf der Szene vor ihm ausführen muss.

Da der künstliche visuelle Kortex von „VC-1“ benötigt wird, um eine Reihe unterschiedlicher sensomotorischer Aufgaben in unterschiedlichen Umgebungen gut auszuführen, spielt der Ego4D-Datensatz eine besonders wichtige Rolle, da er die Daten enthält, die die Studienteilnehmer durch die Kameras tragen Stundenlanges Video von täglichen Aktivitäten wie Kochen, Putzen, Sport treiben, Basteln und mehr.

Die Forscher sagten: „Biologische Organismen verfügen über einen universellen visuellen Kortex, der das Repräsentationsmittel ist, nach dem wir suchen. Deshalb haben wir uns zum Ziel gesetzt, einen Datensatz zu erstellen, der bei mehreren Aufgaben gut funktioniert, wobei wir Ego4D als Kerndatensatz verwenden und verbessern.“ VC-1 durch das Hinzufügen zusätzlicher Datensätze. Da sich Ego4D hauptsächlich auf alltägliche Aktivitäten wie Kochen, Gartenarbeit und Basteln konzentriert, haben wir auch einen Datensatz mit egozentrischen Videos zur Erkundung von Häusern und Wohnungen übernommen „verkörperte KI.“ Damit Roboter in der realen Welt völlig autonom arbeiten können, müssen sie auch in der Lage sein, reale Objekte zu manipulieren. Der Roboter benötigt Sehkraft, um zu navigieren, ein Objekt zu finden und zu tragen, es an einen anderen Ort zu bewegen und es dann richtig zu platzieren – alles Aktionen, die er autonom auf der Grundlage dessen ausführt, was er sieht und hört.

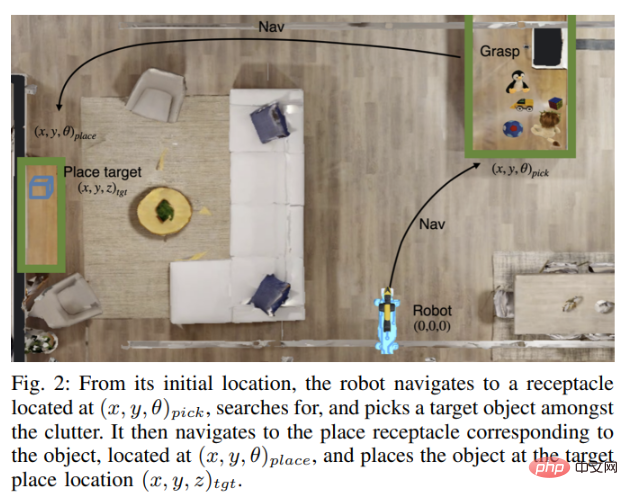

Um dieses Problem zu lösen, haben die KI-Experten von Meta mit Forschern des Georgia Institute of Technology zusammengearbeitet, um eine neue Technologie namens Adaptive Skill Coordination (ASC) zu entwickeln, mit der Roboter diese Fähigkeiten simulieren und dann trainieren. Diese Fähigkeiten werden in realen Robotern nachgebildet.

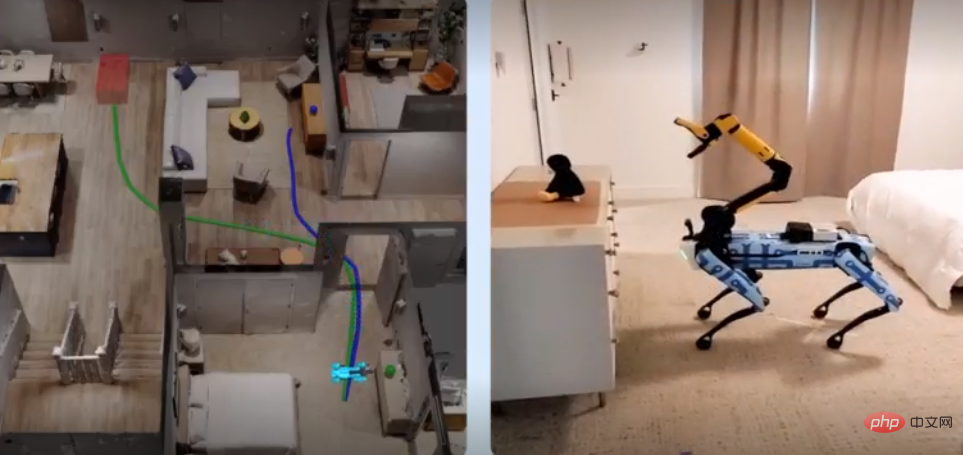

Meta arbeitete auch mit Boston Dynamics zusammen, um die Wirksamkeit seiner ASC-Technologie zu demonstrieren. Die beiden Unternehmen kombinierten die ASC-Technologie mit dem Spot-Roboter von Boston Dynamics, um dem Roboter leistungsstarke Erfassungs-, Navigations- und Manipulationsfähigkeiten zu verleihen, obwohl dafür auch ein erheblicher menschlicher Eingriff erforderlich ist. Um beispielsweise ein Objekt auszuwählen, muss jemand auf das Objekt klicken, das auf dem Tablet des Roboters angezeigt wird.

Die Forscher schrieben in dem Artikel: „Unser Ziel ist es, ein KI-Modell zu entwickeln, das die Welt anhand der integrierten Sensorik und motorischen Befehle über die Boston Dynamics API wahrnehmen kann.“

Der Spot-Roboter wurde mit dem Habitat-Simulator getestet, den The Die Simulationsumgebung wurde unter Verwendung von HM3D- und ReplicaCAD-Datensätzen erstellt, die 3D-Scandaten für den Innenbereich von mehr als 1.000 Häusern enthalten. Der Spot-Roboter wurde dann darauf trainiert, sich durch ein Haus zu bewegen, das er zuvor noch nicht gesehen hatte, Gegenstände zu tragen und sie an geeigneten Orten zu platzieren. Das von den trainierten Spot-Robotern gewonnene Wissen und die Informationen werden dann auf Spot-Roboter übertragen, die in der realen Welt arbeiten und die automatisch dieselben Aufgaben ausführen, basierend auf ihrem Wissen über den Grundriss des Hauses.

Die Forscher schrieben: „Wir haben den Spot-Roboter in zwei sehr unterschiedlichen realen Umgebungen getestet, einer 185 Quadratmeter großen, voll möblierten Wohnung und einem 65 Quadratmeter großen Universitätslabor. Insgesamt hat der Spot-Roboter mit ASC-Technologie nahezu fehlerfrei funktioniert und 59 Mal von 60 Tests bestanden, wobei er Hardware-Instabilität, Aufnahmefehler und gegnerische Störungen wie sich bewegende Hindernisse oder blockierende Wege überwand dass sie auch den Quellcode des VC-1-Modells geöffnet und in einem anderen Artikel Einzelheiten zur Skalierung der Modellgröße, der Datensatzgröße usw. mitgeteilt haben. In der Zwischenzeit wird der nächste Schwerpunkt des Teams auf der Integration von VC-1 mit ASC liegen, um ein menschlicheres repräsentatives KI-System zu schaffen.

Die Forscher schrieben: „Wir haben den Spot-Roboter in zwei sehr unterschiedlichen realen Umgebungen getestet, einer 185 Quadratmeter großen, voll möblierten Wohnung und einem 65 Quadratmeter großen Universitätslabor. Insgesamt hat der Spot-Roboter mit ASC-Technologie nahezu fehlerfrei funktioniert und 59 Mal von 60 Tests bestanden, wobei er Hardware-Instabilität, Aufnahmefehler und gegnerische Störungen wie sich bewegende Hindernisse oder blockierende Wege überwand dass sie auch den Quellcode des VC-1-Modells geöffnet und in einem anderen Artikel Einzelheiten zur Skalierung der Modellgröße, der Datensatzgröße usw. mitgeteilt haben. In der Zwischenzeit wird der nächste Schwerpunkt des Teams auf der Integration von VC-1 mit ASC liegen, um ein menschlicheres repräsentatives KI-System zu schaffen.

Das obige ist der detaillierte Inhalt vonMetaforscher erschaffen einen künstlichen visuellen Kortex, der es Robotern ermöglicht, visuell zu operieren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So beheben Sie einen DNS-Fehler

So beheben Sie einen DNS-Fehler

So verbinden Sie PHP mit der MSSQL-Datenbank

So verbinden Sie PHP mit der MSSQL-Datenbank

Der Unterschied zwischen großer Funktion und max

Der Unterschied zwischen großer Funktion und max

Lösung für Sitzungsfehler

Lösung für Sitzungsfehler

Was sind die ASP-Entwicklungstools?

Was sind die ASP-Entwicklungstools?

Der Computer ist infiziert und kann nicht eingeschaltet werden

Der Computer ist infiziert und kann nicht eingeschaltet werden

So kaufen Sie Bitcoin

So kaufen Sie Bitcoin

Lösung für fehlende xlive.dll

Lösung für fehlende xlive.dll