Dieser Artikel stammt von Lei Feng.com. Wenn Sie ihn erneut drucken möchten, besuchen Sie bitte die offizielle Website von Lei Feng.com, um eine Genehmigung zu beantragen.

Jeder hat die Geschichte vom elektrischen Ventilator und der leeren Seifenschale gehört, oder?

Es wird gemunkelt, dass ein bekannter internationaler Hersteller von schnelllebigen Konsumgütern einmal eine Produktionslinie für Seifenverpackungen eingeführt hat. Es wurde festgestellt, dass diese Produktionslinie einen Fehler im Prozess der Seifenverpackung aufwies, das heißt, es gab oft einen Fehler Kisten ohne Seife. Sie konnten keine leeren Kisten an Kunden verkaufen, also stellten sie einen Postdoktoranden im Bereich Automatisierung ein, um einen Plan für die Sortierung leerer Seifenkisten zu entwerfen.

Der Postdoktorand stellte sofort ein technisches Team von mehr als einem Dutzend Personen zusammen, nutzte umfassend Maschinen, Automatisierung, Mikroelektronik, Röntgenerkennung und andere Technologien, gab 900.000 aus und entwickelte schließlich erfolgreich einen Plan, der in zwei integriert ist Wenn auf beiden Seiten eine leere Seifenkiste erkannt wird, wird eine Roboterhand angetrieben, um die leere Seifenkiste wegzuschieben.

Man kann sagen, dass dies ein wichtiger Durchbruch bei der Implementierung von Technologie zur Lösung tatsächlicher industrieller Probleme ist.

Zufälligerweise kaufte zur gleichen Zeit auch ein Township-Unternehmen in Südchina dieselbe Produktionslinie. Als der Chef dieses Problem entdeckte, war er sehr wütend. Er rief einen Arbeiter in die Fabrik und sagte: „Kommen Sie und denken Sie über eine Möglichkeit nach, dieses Problem zu lösen.“ Unter dem Druck entwickelte der Arbeiter schnell einen cleveren Plan: Er gab aus Für 190 Yuan kaufte ich einen leistungsstarken elektrischen Ventilator und stellte ihn neben die Produktionslinie für Seifenverpackungen. Sobald die Produktionslinie umdrehte, fing es an, stark zu blasen. Sobald die leeren Seifenkisten auftauchten, wurden sie weggeblasen.

Ein kleiner Arbeiter hat mit seiner cleveren Kreativität dieses Problem schnell gelöst und ein großes Ziel erreicht, das in der Branche oft genannt wird: Kosten senken und Effizienz steigern.

führte zu zwei Stimmen im Kreis:

Eine Stimme sagte, dass große Modelle bei einer Vielzahl von Aufgabenbenchmarks starke Leistung und Potenzial gezeigt haben und dass sie in Zukunft die Entwicklungsrichtung der künstlichen Intelligenz sein müssen. Derzeit dient die Investition dazu, sich darauf vorzubereiten, die großen Chancen der Zeit auch in Zukunft nicht zu verpassen, und es lohnt sich, Millionen (oder mehr) in die Ausbildung zu investieren. Mit anderen Worten: Der Hauptwiderspruch besteht darin, den Vorsprung großer Modelle zu erobern, und hohe Investitionskosten sind der sekundäre Widerspruch.

Eine andere Stimme sagt, dass im tatsächlichen Prozess der Implementierung der KI-Technologie die derzeitige umfassende Werbung für große Modelle nicht nur Forschungsressourcen für kleine Modelle und andere KI-Richtungen beraubt, sondern auch aufgrund hoher Investitionskosten schwer zu lösen ist Die tatsächlichen Probleme sind bei industriellen Themen gering und können im Rahmen der digitalen Transformation nicht mehr von ihnen profitieren.

Mit anderen Worten: „Wirtschaftliche Verfügbarkeit“ und „ob die Fähigkeit stark ist oder nicht“ bilden die beiden Hauptschwerpunkte von KI-Algorithmen bei der Lösung praktischer Probleme. Heute ist sich die Branche einig: In Zukunft wird KI zur „Macht“ werden, die alle Lebensbereiche stärkt. Was ist also aus der Perspektive einer groß angelegten KI-Implementierung besser: große Modelle oder kleine Modelle? Hat die Branche wirklich darüber nachgedacht?

1Die Ankunft „großer“ Models

Wenn große in- und ausländische Technologieunternehmen in den letzten Jahren ihre KI-F&E-Fähigkeiten bekannt machen, taucht immer wieder ein Wort mit hoher Frequenz auf: Big Model.Dieser Wettbewerb beginnt mit ausländischen Technologiegiganten. Im Jahr 2018 brachte Google das groß angelegte vorab trainierte Sprachmodell BERT auf den Markt, nachdem OpenAI 2019 und 2020 GPT-2 und GPT-3 auf den Markt gebracht hatte eine überwältigende Anzahl von Parametern. Der Switch Transformer...

Die sogenannte Modellgröße, der Hauptmessindikator, ist die Größe der Modellparameter. Die „Größe“ des Modells bezieht sich auf die große Anzahl von Parametern.

Zum Beispiel erreichte die Anzahl der Parameter von BERT im Jahr 2018 erstmals 300 Millionen Parameter und übertraf damit den Menschen in zwei Messungen des maschinellen Leseverständnistests SQuAD1.1 auf höchstem Niveau und erreichte 11 verschiedene SOTA-Tests Leistung, einschließlich der Erhöhung des GLUE-Benchmarks auf 80,4 % (absolute Verbesserung 7,6 %), der MultiNLI-Genauigkeit, die 86,7 % erreicht (absolute Verbesserung 5,6 %), was die Leistungsfähigkeit einer Erhöhung der Anzahl von Parametern zur Verbesserung der Leistung von KI-Algorithmen demonstriert.

OpenAI hat nacheinander GPT-2 mit einem Parametervolumen von 1,5 Milliarden eingeführt, und das Parametervolumen von GPT-3 überschritt erstmals 100 Milliarden und erreichte 175 Milliarden. Der im Januar 2021 von Google veröffentlichte Switch Transformer erreichte erstmals Billionen, mit einem Parametervolumen von 1,6 Billionen.

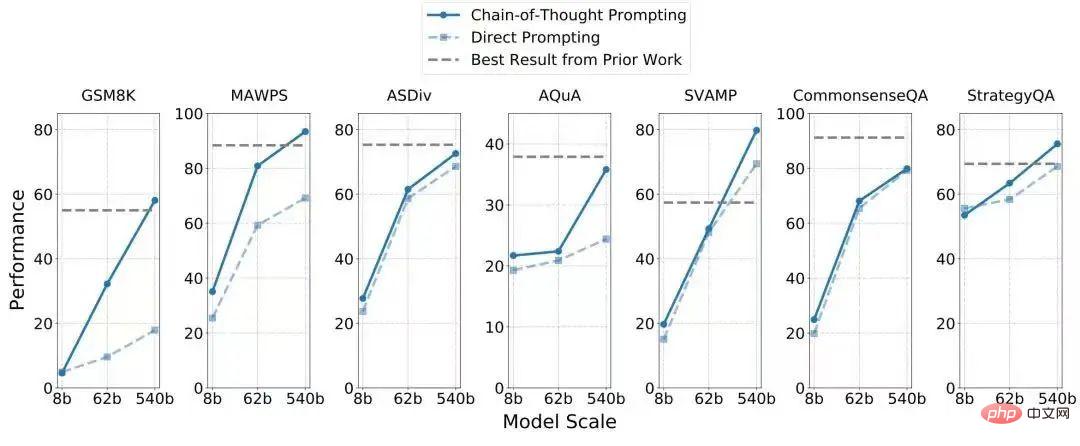

Angesichts dieser wütenden Situation sind große inländische Hersteller und sogar staatlich finanzierte Forschungseinrichtungen nicht weit zurückgeblieben und haben sukzessive ihre Ergebnisse bei der Herstellung großer Modelle veröffentlicht: Im April 2021 veröffentlichte die Alibaba DAMO Academy das chinesische Vorschulungssprachenmodell „PLUG“ mit 27 Milliarden Parametern; im April veröffentlichten Huawei und das Pengcheng Laboratory gemeinsam „Pangu α“ mit 200 Milliarden Parametern; im September veröffentlichte das Beijing Zhiyuan Artificial Intelligence Research Institute „Enlightenment 2.0“ mit 1,75 Billionen Parametern; , Baidu veröffentlichte das zweisprachige Chinesisch-Englisch-Modell PLATO-X mit zig Milliarden Parametern. Im Oktober letzten Jahres veröffentlichte die Alibaba Damo Academy „M6-10T“, das 10 Billionen Parameter erreicht hat und derzeit das größte KI-Modell in China ist. Obwohl es nicht so gut ist wie Alibaba, liegt Baidu bei der Verfolgung der Anzahl der Parameter des Modells nicht weit zurück. Gemeinsam mit dem Pengcheng Laboratory wurde „Baidu Wenxin“ mit einer Parameterzahl von 260 Milliarden veröffentlicht, was zehnmal größer als PLATO ist -X. Darüber hinaus sagte Tencent auch, dass sie ein großes Modell „Paida Star“ entwickelt hätten, die Größe der Parameter sei jedoch unbekannt. Zu den wichtigsten inländischen Großmodell-Forschungs- und Entwicklungsunternehmen gehört neben den großen KI-Forschungs- und Entwicklungsunternehmen auch der Rechenleistungsanbieter Inspur. Sie haben im Oktober letzten Jahres das Großmodell „Source 1.0“ mit einem Parametervolumen von 245,7 veröffentlicht Milliarde. Alles in allem kann 2021 als Chinas „erstes Jahr der großen Modelle“ bezeichnet werden. Auch in diesem Jahr erfreuen sich große Modelle weiterhin großer Beliebtheit. Anfangs konzentrierten sich große Modelle auf den Bereich der Computersprache, aber jetzt haben sie sich nach und nach auf Vision und Entscheidungsfindung ausgeweitet, und ihre Anwendungen decken sogar wichtige wissenschaftliche Themen wie Proteinvorhersage, Luft- und Raumfahrt usw. ab. Google, Meta, Baidu und Andere große Unternehmen haben entsprechende Ergebnisse. Eine Zeit lang hatten KI-Modelle mit Parametern unter 100 Millionen keine Stimme. Es besteht kein Zweifel daran, dass KI-Großmodelle ihr inhärentes Potenzial unter Beweis gestellt haben, egal ob es um Leistungsüberschreitungen oder Aufgabenerweiterungen geht, und der Wissenschaft und der Industrie grenzenlose Fantasie beschert haben. Forschungsexperimente haben gezeigt, dass eine Erhöhung der Daten- und Parametermenge die Genauigkeit des Modells bei der Lösung von Problemen effektiv verbessern kann. Am Beispiel des von Google im Jahr 2021 veröffentlichten visuellen Übertragungsmodells Big Transfer wurden zwei Datensätze mit 1,28 Millionen Bildern in 1.000 Kategorien und 300 Millionen Bildern in 18.291 Kategorien für das Training verwendet. Die Genauigkeit des Modells kann von 77 % auf erhöht werden 79 %. Nehmen Sie das von Google in diesem Jahr eingeführte Einweg-Sprachmodell mit 540 Milliarden Parametern. Es basiert auf dem von Google in diesem Jahr veröffentlichten KI-Framework Pathways und übertrifft nicht nur die 175 Milliarden Parameter von GPT-3 der Feinabstimmung, verfügt aber auch über deutlich verbesserte Argumentationsfunktionen, 4 der 7 Datensätze für arithmetische Wortprobleme/logisches Denken übertrafen das aktuelle SOTA (wie in der Tabelle unten gezeigt) und nur 8 Proben (d. h. gesammelte Daten). verwendet wurden. Vision ist Wahrnehmung und Sprache ist Intelligenz, aber die beiden haben beim Sieg des „kausalen Denkens“ keinen durchschlagenden Durchbruch erzielt, und die Fähigkeit des kausalen Denkens ist für die Entwicklung von KI-Systemen sehr wichtig. Man kann es so verstehen: Die einfache Fähigkeit eines Kindes, aus 1+1=2 100+100=200 abzuleiten, ist für ein Maschinensystem sehr kompliziert, weil dem System die Vorstellungskraft für kausales Denken fehlt. Wenn Maschinen nicht einmal über vernünftige Denkfähigkeiten/Vorstellungskraft verfügen, werden wir weit davon entfernt sein, die superintelligenten Roboter aus Science-Fiction-Filmen zu entwickeln. Das Aufkommen großer Modelle ermöglicht die Realisierung allgemeiner künstlicher Intelligenz (AGI). Wir können also sehen, dass große Unternehmen, wenn sie ein großes Modell bewerben, oft betonen, dass es mehrere Aufgaben gleichzeitig lösen und SOTA (das derzeit höchste Niveau) bei mehreren Aufgaben-Benchmarks erreichen kann. Beispielsweise kann das von Google in diesem Jahr eingeführte 540-Milliarden-Parameter-Sprachmodell PaLM Witze interpretieren und Filme durch Emoji-Ausdrücke erraten. Die von Zhiyuan eingeführte „Aufklärung 2.0“ kann Hua Zhibing hervorbringen, einen virtuellen Studenten, der sich mit Musik, Schach und Kalligraphie auskennt und Malerei. Kurz gesagt, große Models haben oft eine Eigenschaft: Sie sind vielseitig und können viele Hüte tragen. Dies ist entscheidend für die Lösung der Herausforderungen komplexer Szenarien. „Das kleine Modell hat eine kleine Anzahl von Parametern und ist auf eine einzelne Aufgabe beschränkt; während der (Vorteil) des großen Modells darin besteht, dass das Wissen, das eine Person lernt, wenn sie Tischtennis spielt, einen unterstützenden Effekt auf das Spielen hat.“ Badminton Big Es gibt eine Verallgemeinerung zwischen den Aufgaben des Modells. Wenn ein kleines Modell mit neuen Aufgaben konfrontiert wird, kann es sein, dass es Tausende oder Zehntausende von Trainingsdaten benötigt, während ein großes Modell möglicherweise nur eine Trainingsdaten oder gar keine Trainingsdaten benötigt „Erklärte Lan Zhenzhong, Leiter des Deep Learning Laboratory der West Lake University, gegenüber Leifeng.com-AI Technology Review. Nehmen Sie als Beispiel die Forschung zu Dialogsystemen. Dialogsysteme sind hauptsächlich in zwei Kategorien unterteilt: Die eine ist der aufgabenbasierte Dialog, bei dem Benutzer Aufgaben zuweisen und das KI-System diese automatisch ausführt, z. B. die schnelle Buchung von Flugtickets, den Kauf von Kinokarten usw.; die andere ist ein offener Typ Dialoge wie der Film „Her“ (Her ) ist ein fiktiver Roboter, der mit Menschen zu jedem Thema kommunizieren kann und den Benutzern sogar das Gefühl gibt, emotional begleitet zu werden. Unter ihnen ist das Fähigkeitsniveau des Letzteren offensichtlich höher und seine Forschung und Entwicklung schwieriger. Es liegt viel Nebel vor Ihnen und Sie wissen nicht, vor welchen Herausforderungen Sie stehen werden. Zu diesem Zeitpunkt verfügt das große Modell selbst über ein reichhaltiges „Fähigkeitspaket“ und eine außergewöhnliche Leistung bei neuen Aufgaben, und seine Kampfeffektivität ist offensichtlich besser als das des kleinen Modells. Lan Zhenzhong wies darauf hin, dass KI-Forscher in Wissenschaft und Industrie derzeit viele Merkmale großer Modelle noch nicht vollständig erfasst haben. Beispielsweise können wir von der vorherigen Generation von GPT-3 zu dieser Generation von Instruct GPT sehen, dass es sich um ein großes Modell handelt, aber die Wirkung von Instruct GPT ist bei der Annahme von Befehlen viel besser ist das, was sie getan haben, nur beim Studium großer Modelle zu erfahren. Was passiert mit der Leistung des KI-Modells, wenn die Anzahl der Parameter zunimmt? Dies ist ein wissenschaftliches Thema, das einer eingehenden Untersuchung bedarf, daher ist es notwendig, weiterhin in die Forschung an großen Modellen zu investieren. Damit Menschen Fortschritte machen können, muss es immer Menschen geben, die mutig dorthin gehen, wo niemand ist. Allerdings kann sich in der realen Welt nicht jeder das Ideal von Sternen und Meer leisten, und immer mehr Menschen möchten ihre Probleme einfach so schnell und kostengünstig wie möglich lösen. Letztendlich muss für die Implementierung von KI-Algorithmen das Input-Output-Verhältnis der Technologieforschung und -entwicklung berücksichtigt werden. Zu diesem Zeitpunkt werden die Nachteile großer Modelle sichtbar. Eine grausame Tatsache, die nicht ignoriert werden kann, ist, dass die Berechnung großer Modelle langsam ist und die Schulungskosten extrem hoch sind. Im Allgemeinen gilt: Je größer die Anzahl der Parameter des Modells, desto langsamer läuft die Maschine und desto höher sind die Rechenkosten. Nach Angaben ausländischer Medien gab OpenAI fast 5 Millionen US-Dollar (ca. 35 Millionen RMB) für das Training von GPT-3 aus, das 175 Milliarden Parameter enthält. Google hat beim Training von PaLM, das 540 Milliarden Parameter enthält, 6.144 TPUs verwendet. Laut Statistiken begeisterter Internetnutzer belaufen sich die Kosten für das Training eines PaLM für normale Menschen zwischen 9 und 17 Millionen US-Dollar. Dies sind nur die Kosten für die Rechenleistung. Große inländische Hersteller haben ihre wirtschaftlichen Kosten für das Training großer Modelle nicht offengelegt, aber basierend auf den vorhandenen weltweit gemeinsam genutzten Computermethoden und -ressourcen sollten die Computerausgaben nicht weit auseinander liegen. Sowohl GPT-3 als auch PaLM haben nur Stückzahlen im Hunderter-Milliarden-Bereich, aber für große Modelle mit Parametern im Billionen-Bereich oder mehr müssen die Kosteninvestitionen atemberaubend sein. Wenn ein großer Hersteller bei Forschung und Entwicklung großzügig genug ist, werden die Investitionskosten großer Modelle kein „Stolperstein“ sein. Allerdings wetten einige Start-ups und staatlich finanzierte Forschungseinrichtungen immer noch, wenn das Kapital gegenüber KI vorsichtiger wird stark auf großen Modellen, was bedeutet, dass es ein bisschen magisch wirkt. Die hohen Anforderungen an die Rechenleistung großer Modelle haben den Wettbewerb um die technische Stärke zwischen Unternehmen zu einem Wettbewerb um Geld gemacht. Sobald Algorithmen zu Gütern mit hohem Verbrauch werden, ist die modernste KI auf lange Sicht dazu bestimmt, nur wenigen Menschen zur Verfügung zu stehen, was zu einer Monopolsituation der Belagerung und Abschottung führt. Mit anderen Worten: Auch wenn die allgemeine künstliche Intelligenz eines Tages auftauchen sollte, wird sie nicht allen Nutzern zugute kommen. Gleichzeitig wird auf diesem Weg die Innovationskraft kleiner Unternehmen geschwächt. Um ein großes Modell aufzubauen, müssen kleine Unternehmen entweder mit großen Herstellern zusammenarbeiten und auf den Schultern von Riesen stehen (aber das kann nicht jede kleine Fabrik), oder sie müssen viel investieren und ihre Kassen vorbereiten (aber in Bezug auf Kapital, Im kalten Winter ist dies nicht praktikabel. Berechnen Sie nach der Berechnung der Eingabe die Ausgabe. Leider hat kein Unternehmen, das derzeit große Modelle weiterentwickelt, offengelegt, welche wirtschaftlichen Vorteile große Modelle mit sich gebracht haben. Aus öffentlichen Informationen geht jedoch hervor, dass mit der Implementierung dieser großen Modelle nacheinander begonnen wurde, um Probleme zu lösen. Nachdem die Alibaba Damo Academy beispielsweise das Billionen-Parameter-Modell M6 veröffentlicht hatte, hieß es, dass dessen Bilderzeugungsfunktionen bereits hilfreich sein könnten Autodesigner im Fahrzeugdesign, das durch Ausleihen der Copywriting-Generierungsfähigkeit von M6 erstellt wurde, wurde auch auf Mobilgeräten von Taobao, Alipay und Alibaba Xiaomi verwendet. Für große Modelle, die sich in der Anfangsphase der Erkundung befinden, ist die Betonung kurzfristiger Renditen zu streng. Wir müssen jedoch noch diese Frage beantworten: Ob es sich um die Geschäftswelt oder die Wissenschaft handelt, wenn man auf große Modelle setzt, geht es darum, nicht eine technische Richtung zu verpassen, die in Zukunft dominieren könnte, oder weil sie das Problem besser lösen kann Aktuelle Probleme? Bekannte Fragen? Ersteres hat einen starken Einfluss auf akademische Forschung, während Letzteres ein echtes Anliegen von Branchenpionieren ist, die KI-Technologie zur Lösung von Problemen einsetzen. Das große Modell wurde durch die Veröffentlichung von BERT durch Google ins Leben gerufen, was eine chaotische und aufgeschlossene Idee war: Vor dem BERT-Experiment hat das technische Team von Google Brain das Modell nicht um ein bekanntes reales Problem herum entwickelt und hat es auch nicht getan Sie denken, dass dieses KI-Modell mit der damals größten Anzahl an Parametern (300 Millionen) erhebliche Leistungsverbesserungen bewirken kann. Als OpenAI Google bei der Entwicklung von GPT-2 und GPT-3 nachahmte, hatte es keine spezifische Aufgabe. Stattdessen testeten alle nach der erfolgreichen Entwicklung den Aufgabeneffekt auf GPT-3 und stellten fest, dass sich verschiedene Indikatoren verbessert hatten . War einfach erstaunt. Das heutige GPT-3 ist wie eine Plattform und wurde von Tausenden von Benutzern verwendet. Aber mit der Zeit kehrt die Entwicklung großer Modelle unweigerlich zur ursprünglichen Absicht zurück, ein bestimmtes praktisches Problem zu lösen, wie zum Beispiel das in diesem Jahr von Meta veröffentlichte große Proteinvorhersagemodell ESMFold und das von Baidu veröffentlichte große Luft- und Raumfahrtmodell vor nicht allzu langer Zeit. Wenn die anfänglichen groß angelegten Modelle wie GPT-3 hauptsächlich dazu gedacht waren, die Auswirkungen zu untersuchen, die eine Erhöhung der Anzahl von Parametern auf die Leistung des Algorithmus haben würde, und es sich lediglich um „Unbekannte handelte, die das Unbekannte lenkten“, dann sind die aktuellen Großmodelle Die maßstabsgetreue Modellforschung hat begonnen, ein komplexeres, klares Ziel widerzuspiegeln: reale Probleme zu lösen und unternehmerischen Wert zu schaffen. Zu diesem Zeitpunkt ändert sich die Entwicklungsrichtung des großen Modells vom Willen des Forschers zu den Bedürfnissen des Benutzers. Bei einigen sehr kleinen Anforderungen (z. B. der Nummernschilderkennung) können auch große Modelle das Problem lösen, aber aufgrund der hohen Schulungskosten ist es ein bisschen so, als würde man „ein Schwein mit einem Vorschlaghammer töten“, und die Leistung ist nicht unbedingt hervorragend . Mit anderen Worten: Wenn die Genauigkeitsverbesserung einiger Punkte mit Kosten von mehreren zehn Millionen erreicht wird, ist das Preis-Leistungs-Verhältnis extrem niedrig. Ein Brancheninsider sagte gegenüber Leifeng.com-AI Technology Review, dass wir in den meisten Fällen eine Technologie zur Lösung eines bekannten praktischen Problems, wie z. B. einer Stimmungsanalyse und einer Nachrichtenzusammenfassung, zu diesem Zeitpunkt tatsächlich entwerfen können Aufgabe zu studieren, und die Wirkung des resultierenden „kleinen Modells“ ist deutlich besser als die großer Modelle wie GPT-3. Selbst für einige spezifische Aufgaben seien große Modelle „unmöglich zu verwenden“. Bei der Förderung der Entwicklung von KI ist die Kombination von großen Modellen und kleinen Modellen unvermeidlich. Da die Forschungs- und Entwicklungsschwelle für große Modelle extrem hoch ist, werden in absehbarer Zukunft kleine Modelle, die wirtschaftlich verfügbar und zu präzisen Angriffen fähig sind, die Hauptkraft bei der Bewältigung der wichtigen Aufgabe der groß angelegten Implementierung von KI sein. Sogar einige Wissenschaftler, die große Modelle untersuchen, sagten gegenüber Leifeng.com-AI Technology Review deutlich, dass große Modelle zwar viele Aufgaben gleichzeitig ausführen können, „es aber noch zu früh ist, um jetzt über allgemeine künstliche Intelligenz zu sprechen.“ Große Modelle mögen ein wichtiger Weg sein, um das Endziel zu erreichen, aber das Ideal liegt noch in weiter Ferne und die KI muss zunächst die aktuelle Situation befriedigen. Tatsächlich haben einige Forscher in Wissenschaft und Industrie als Reaktion auf das Phänomen immer größerer KI-Modelle dessen Vor- und Nachteile bei der Umsetzung erkannt und aktiv Gegenmaßnahmen entwickelt. Wenn wir darüber sprechen wollen, was die Aufklärungstechnologie den Menschen über die Veränderungen in der Gesellschaft gebracht hat, dann wird eines der wichtigen Dinge, die auf jeden Fall erwähnt werden, sein: Wie kann die Schwelle technologischer Produkte gesenkt werden (ob in Bezug auf Technologie oder Kosten), so dass mehr Menschen davon profitieren können. Nur wenn Menschen die Vorteile dieser Technologie nutzen können, kann ihr Einfluss erweitert werden. Beim Wechsel zu einem großen Modell besteht der Kernwiderspruch darin, wie man seine Trainingsgeschwindigkeit verbessert, die Trainingskosten senkt oder eine neue Architektur vorschlägt. Betrachtet man allein den Einsatz von Rechenressourcen, ist das Dilemma großer Modelle eigentlich nicht überragend. Die neuesten Trainingsergebnisse des MLPerf-Benchmarks, die Ende Juni dieses Jahres von der Open Engineering Alliance MLCommons veröffentlicht wurden, zeigen, dass die Trainingsgeschwindigkeit des diesjährigen maschinellen Lernsystems fast doppelt so hoch ist wie im letzten Jahr und damit gegen das Mooresche Gesetz verstößt (Verdoppelung alle 18–24). Monate). Tatsächlich hat sich die Datenverarbeitung durch die Aktualisierung und Iteration verschiedener Server und das Aufkommen neuer Methoden wie Cloud Computing beschleunigt und der Energieverbrauch gesenkt. Beispielsweise wurde GPT-3 erst vor zwei Jahren eingeführt, und jetzt wurden die Berechnungen von Meta auf der Grundlage des von ihm entwickelten OPT-Modells auf 1/7 des Wertes von 2020 reduziert. Darüber hinaus zeigte ein kürzlich veröffentlichter Artikel, dass das große BERT-Modell, für dessen Training im Jahr 2018 Tausende von GPUs erforderlich waren, nun innerhalb von 24 Stunden auf einer einzigen Karte trainiert werden kann und problemlos in einem normalen Labor trainiert werden kann. Der Engpass bei der Beschaffung von Rechenleistung besteht nicht mehr, das einzige Hindernis sind die Anschaffungskosten. In den letzten Jahren hofften einige Forscher nicht nur darauf, sich ausschließlich auf die Rechenleistung zu verlassen, sondern auch, einen anderen Weg zu finden, um die „wirtschaftliche Verfügbarkeit“ großer Modelle ausschließlich auf der Grundlage der Eigenschaften des Modells und des Algorithmus selbst zu erreichen. Ein Weg ist die datenzentrierte „Dimensionalitätsreduktion“. Kürzlich hat DeepMind eine Arbeit („Training Compute-Optimal Large Language Models“) veröffentlicht, in der erfolgreich untersucht und festgestellt wurde, dass bei gleichem Rechenaufwand die Trainingsdaten des Modells größer gemacht werden, anstatt die Parameter des Modells zu vergrößern können wir bessere Ergebnisse erzielen, als nur das Modell zu vergrößern. In dieser DeepMind-Studie übertrifft Chinchilla, ein 70-Milliarden-Parameter-Modell, das Daten vollständig nutzt, das 175-Milliarden-Parameter-GPT-3 und das 280-Milliarden-Parameter-Gopher bei der Bewertung einer Reihe nachgelagerter Aufgaben. Lan Zhenzhong erklärte, dass Chinchilla gewinnen konnte, weil es die Daten während des Trainings erweitert und verdoppelt und sie dann nur einmal berechnet hat. Eine andere Möglichkeit besteht darin, sich auf Innovationen bei Algorithmen und Architektur zu verlassen, um große Modelle „leichter“ zu machen. Zhou Ming, ehemaliger Vizepräsident von Microsoft Research Asia und aktueller Gründer von Lanzhou Technology, ist ein Anhänger dieses Tracks. Als Unternehmer ist die Idee von Zhou Ming sehr „Pflicht“, nämlich Geld zu sparen. Er wies darauf hin, dass viele große Unternehmen jetzt große Modelle anstreben. Zweitens wollen sie auch ihre Rechenkapazitäten, insbesondere die Fähigkeiten von Cloud-Diensten, zum Ausdruck bringen. Als kleines, gerade gegründetes Unternehmen träumt Lanzhou Technology davon, KI zur Wertschöpfung zu nutzen, verfügt jedoch nicht über starke Cloud-Fähigkeiten und nicht über genügend Geld. Daher dachte Zhou Ming zunächst darüber nach, wie die Modellarchitektur angepasst und destilliert werden kann Wissen und verwandelt große Modelle in „leichte Modelle“, die den Kunden zur Verfügung stehen. Das im Juli letzten Jahres auf den Markt gebrachte Leichtbaumodell „Mencius“ bewies die Machbarkeit dieser Idee. „Mencius“ hat nur 1 Milliarde Parameter, aber seine Leistung auf der CLUE-Bewertungsliste zum Verständnis der chinesischen Sprache übertrifft große Modelle wie BERTSG und Pangu mit Parameterniveaus von mehreren zehn oder sogar Hunderten von Milliarden (Tabelle unten). Auf diesem Gebiet besteht Konsens darüber, dass bei gleicher Architektur die Leistung umso besser ist, je größer die Anzahl der Parameter ist. Der Einfallsreichtum von „Mencius“ liegt jedoch in der Innovation der Architektur. Im akademischen Bereich veröffentlichten Professor Ma Yi von der University of California, Berkeley, Shen Xiangyang und Cao Ying vor nicht allzu langer Zeit gemeinsam eine Studie („On the Principles of Parsimony and Self-Consistency for the Emergence of Intelligenz“), das theoretisch die technischen Gründe analysiert, warum große Modelle immer größer werden. Das heißt, tiefe neuronale Netze sind im Wesentlichen ein „Open-Loop“-System, also ein Diskriminanzmodell zur Klassifizierung und ein Modell zur Abtastung oder Wiedergabe Das Training generativer Modelle erfolgt in den meisten Fällen getrennt, was zu einem ineffizienten Training der Parameter führt. Die Leistung des Modells kann nur durch die Verwendung von Heap-Parametern und Heap-Rechenleistung verbessert werden. Zu diesem Zweck ist die von ihnen vorgeschlagene „Reform“-Methode gründlicher und befürwortet die Kombination des diskriminierenden Modells und des generativen Modells, um ein vollständiges „komprimiertes“ geschlossenes Regelkreissystem zu bilden, damit das KI-Modell lernen kann unabhängiger und effizienter, stabiler und anpassungsfähiger und reaktionsfähiger, wenn es um neue Probleme geht, die in einer neuen Umgebung auftreten können. Mit anderen Worten: Wenn Forscher auf dem Gebiet der KI Modelle auf diesem Weg entwickeln können, wird die Parametergröße des Modells stark reduziert, und es kehrt zum „kleinen und schönen“ Weg zurück und die Fähigkeit großer Modelle, „Unbekanntes zu lösen“. Probleme" können ebenfalls erreicht werden. Im Hinblick auf die Erzielung wirtschaftlicher Verfügbarkeit gibt es sogar eine Stimme, die sich dafür ausspricht, AutoML oder AutoAI zu verwenden, um die Schwierigkeit des Modelltrainings zu lösen, die Forschungsschwelle von KI-Algorithmen zu senken und Algorithmeningenieuren oder Nicht-KI-Praktikern eine flexible Anpassung zu ermöglichen Ihre eigenen Um ein Einzelfunktionsmodell entsprechend den Anforderungen zu erstellen, werden unzählige kleine Modelle gebildet, und ein einzelner Funke kann ein Präriefeuer entfachen. Diese Art von Stimme kommt aus der Perspektive der „Nachfrage“ und ist dagegen, Dinge hinter verschlossenen Türen aufzubauen. Visuelle Algorithmen werden beispielsweise zur Identifizierung, Erkennung und Positionierung verwendet. Dabei stellen die Identifizierung von Rauch und Feuerwerkskörpern unterschiedliche Anforderungen an den Algorithmus, sodass sie eine Plattform oder ein Werkzeug bereitstellen, damit Nachfrager schnell eine Rauch- und Feuerwerksidentifizierung erstellen können Der visuelle Algorithmus zur Identifizierung von Feuerwerkskörpern weist eine höhere Genauigkeit auf und muss nicht auf „Universalität“ oder „Verallgemeinerung“ über Szenen hinweg abzielen. Zu diesem Zeitpunkt kann ein großes Modell, das Klavier, Schach, Kalligraphie und Malerei beherrscht, in unzählige kleine Modelle aufgeteilt werden, die Klavier, Schach, Kalligraphie und Malerei beherrschen, und das Problem kann ebenfalls gelöst werden. lasst uns zurück zur Geschichte des elektrischen Ventilators gehen, der die leere Seifenschale aufbläst. Wenn es darum geht, reale Probleme mit KI-Technologie zu lösen, sind große Modelle und kleine Modelle wie die Automatisierungslösung eines Postdocs und der elektrische Ventilator eines kleinen Arbeiters. Obwohl Ersteres bei der Lösung eines kleinen Problems überflüssig und umständlich erscheint, ist der Effekt nicht so schnell wie ein elektrischer Ventilator, aber fast niemand würde den Wert leugnen, den Postdocs und ihre Teams bieten, geschweige denn sie „eliminieren“. Im Gegenteil, wir können sogar Hunderte von Gründen nennen, die die Rationalität technologischer Forschung und Entwicklung hervorheben. Aber in vielen Fällen ignorieren technische Forscher oft die Weisheit kleiner Arbeiter bei der Lösung von Problemen: Sie gehen von tatsächlichen Problemen aus, anstatt sich auf die Vorteile der Technologie zu beschränken. Aus dieser Perspektive hat die Forschung an großen Modellen einen inhärenten Wert, um an vorderster Front zu stehen, aber auch das „wirtschaftlich nutzbare“ Ziel der Kostensenkung und Effizienzsteigerung muss berücksichtigt werden. Zurück zur Forschung selbst sagte Lan Zhenzhong, dass es zwar viele Ergebnisse zu großen Modellen gebe, es aber nur sehr wenige offene Quellen gebe und normale Forscher nur begrenzten Zugang hätten, was sehr bedauerlich sei. Da große Modelle nicht Open Source sind, können normale Benutzer die Praktikabilität großer Modelle nicht aus der Perspektive der Nachfrage beurteilen. Tatsächlich haben wir zuvor Experimente mit einigen großen Open-Source-Modellen durchgeführt und festgestellt, dass die Leistung großer Sprachmodelle beim Verständnis sozialer Ethik und Emotionen äußerst instabil ist. Weil sie nicht für die Öffentlichkeit zugänglich sind, basiert die Einführung eigener Großmodelle durch große Hersteller immer noch auf akademischen Indikatoren, was zu einem ähnlichen Dilemma wie Schrödinger führt: Man weiß nie, was in der Box ist, und man kann es nicht Ob es wahr oder falsch ist, mit einem Wort: Sie haben über alles das letzte Wort. Abschließend hoffe ich, dass große KI-Modelle wirklich mehr Menschen nutzen können.

2 Das Ideal ist weit weg, aber die Realität ist sehr nah

3 Müssen KI-Modelle immer größer werden?

4 Am Ende

Das obige ist der detaillierte Inhalt vonFans und Gedanken zu großen Unternehmen, die Geld ausgeben, um große KI-Modelle zu verfolgen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Lösung für Sitzungsfehler

Lösung für Sitzungsfehler

So stellen Sie den PPT-Breitbildmodus ein

So stellen Sie den PPT-Breitbildmodus ein

Können Douyin-Funken wieder entzündet werden, wenn sie länger als drei Tage ausgeschaltet waren?

Können Douyin-Funken wieder entzündet werden, wenn sie länger als drei Tage ausgeschaltet waren?

Warum meldet vue.js einen Fehler?

Warum meldet vue.js einen Fehler?

Was tun, wenn Ihre IP-Adresse angegriffen wird?

Was tun, wenn Ihre IP-Adresse angegriffen wird?

Der Unterschied zwischen WeChat-Dienstkonto und offiziellem Konto

Der Unterschied zwischen WeChat-Dienstkonto und offiziellem Konto

Eingang zur offiziellen msdn-Website

Eingang zur offiziellen msdn-Website

Der Unterschied zwischen fprintf und printf

Der Unterschied zwischen fprintf und printf