In letzter Zeit besteht großes Interesse an den leistungsstarken Fähigkeiten großer Sprachmodelle (z. B. Gedankenketten[2], Notizblöcke[3]), und es wurde viel daran gearbeitet. Wir bezeichnen diese zusammenfassend als die entstehenden Fähigkeiten großer Modelle [4]. Diese Fähigkeiten [5] existieren möglicherweise nur in großen Modellen, nicht jedoch in kleineren Modellen, daher werden sie „emergent“ genannt. Viele dieser Fähigkeiten sind sehr beeindruckend, wie z. B. komplexes Denken, wissensbasiertes Denken und Robustheit außerhalb der Verteilung, auf die wir später im Detail eingehen werden.

Bemerkenswerterweise kommen diese Fähigkeiten dem nahe, was die NLP-Community seit Jahrzehnten sucht, und stellen somit einen möglichen Paradigmenwechsel in der Forschung dar, weg von der Feinabstimmung kleiner Modelle hin zur Verwendung großer Modelle für kontextbezogenes Lernen. Für First Mover mag der Paradigmenwechsel offensichtlich sein. Aus Gründen der wissenschaftlichen Genauigkeit benötigen wir jedoch sehr klare Gründe, warum man auf große Sprachmodelle umsteigen sollte, auch wenn diese Modelle teuer [6], schwierig zu verwenden [7] und möglicherweise nur sind mäßig wirksam [8]. In diesem Artikel werfen wir einen genaueren Blick darauf, was diese Fähigkeiten sind, was große Sprachmodelle bieten können und welche potenziellen Vorteile sie in einem breiteren Spektrum von NLP/ML-Aufgaben haben.

Originallink: yaofu.notion.site/A-Closer-Look-at-Large-Language-Models-Emergent-Abilities-493876b55df5479d80686f68a1abd72f

Prämisse: Wir gehen davon aus, dass die Leser über die folgenden Kenntnisse verfügen:

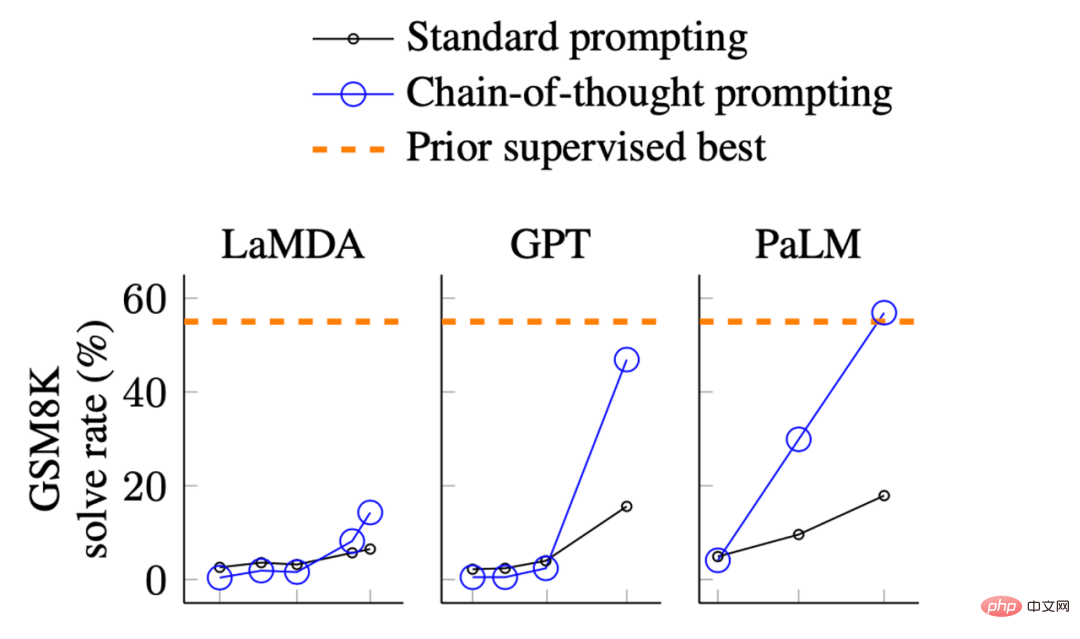

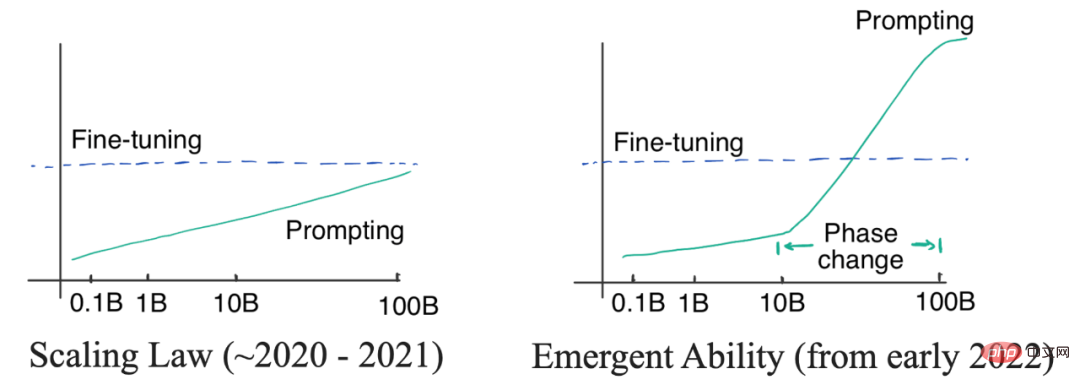

In den obigen Darstellungen können wir die Leistung des Modells beobachten: Wenn die Größe relativ klein ist, ist die Verbesserung nicht groß.

Es gibt eine signifikante Verbesserung, wenn das Modell wird größer

In diesem Artikel interessieren uns hauptsächlich die folgenden Fähigkeiten:

1 Fähigkeiten, auf die die NLP-Community in den letzten Jahren geachtet hat, die aber von früheren NLP-Modellen nur schwer zu erreichen waren

2. Vom Menschen abgeleitet Die tiefste wesentliche Fähigkeit der Sprache (Fähigkeitstiefe)

3 Die Fähigkeit, die das höchste Niveau der menschlichen Intelligenz erreichen kann (die Obergrenze der Fähigkeit)

2 FähigkeitViele interessante Fähigkeiten können alle in die oben genannten Kategorien eingeteilt werden. Darunter besprechen wir hauptsächlich die folgenden drei typischen Fähigkeiten:

Komplexes Denken

Wissensdenken

Komplexes Denken

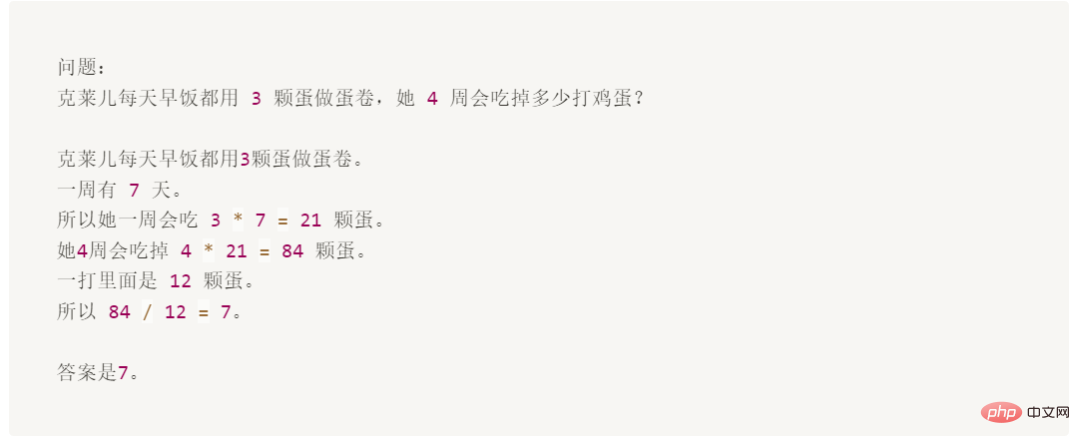

Das Folgende ist ein Beispiel im GSM8K-Datensatz, bei dem die Verwendung von Aufforderungswörtern die Feinabstimmung deutlich übersteigt:

Obwohl diese Frage für ein 10-jähriges Kind einfach ist, Für Sprachmodelle ist es schwierig, vor allem weil Mathematik und Sprache miteinander vermischt sind.

GSM8K wurde ursprünglich von OpenAI im Oktober 2021 vorgeschlagen [10]. Damals nutzten sie die erste Version [11]GPT3, um den gesamten Trainingssatz mit einer Genauigkeit von etwa 35 % zu verfeinern. Dieses Ergebnis stimmt die Autoren ziemlich pessimistisch, da ihre Ergebnisse das Skalierungsgesetz von Sprachmodellen zeigen: Wenn die Modellgröße exponentiell zunimmt, steigt die Leistung linear (darauf werde ich später noch eingehen). Daher überlegen sie in Abschnitt 4.1:

„Das 175B-Modell scheint mindestens zwei zusätzliche Größenordnungen Trainingsdaten zu erfordern, um eine 80 %ige Lösungsrate zu erreichen.“

Drei Monate später, im Jahr 2022 January, Wei et al. [12] Basierend auf dem 540BPaLM-Modell verbesserte sich die Genauigkeit auf 56,6 % unter Verwendung von nur 8 Gedankenketten-Eingabeaufforderungsbeispielen (ohne den Trainingssatz um zwei Größenordnungen zu erhöhen). Später im März 2022 basierten Wang et al.[13] auf dem gleichen 540B PaLM-Modell und verbesserten die Genauigkeit durch Mehrheitsentscheidung auf 74,4 %. Der aktuelle SOTA stammt aus meiner eigenen Arbeit an AI2 (Fu et. al. Nov 2022[14]), wo wir durch den Einsatz komplexer Gedankenketten eine Genauigkeit von 82,9 % auf 175B Codex erreichten. Wie aus den oben genannten Fortschritten hervorgeht, nimmt der technologische Fortschritt tatsächlich exponentiell zu.

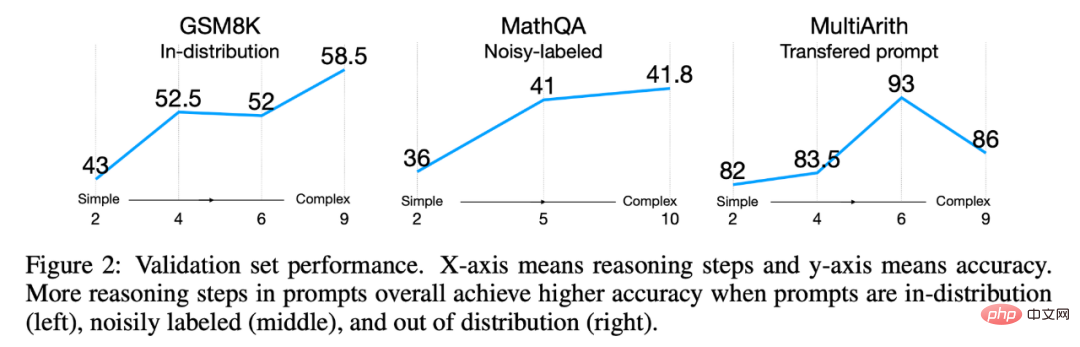

Die Eingabeaufforderung der Denkkette ist ein typisches Beispiel, das die Emergenzfähigkeit des Modells mit Maßstab zeigt:

[16], das College [17] und sogar in die Aufgaben der Internationalen Mathematikolympiade [18] gebracht. Ist es jetzt kühler?

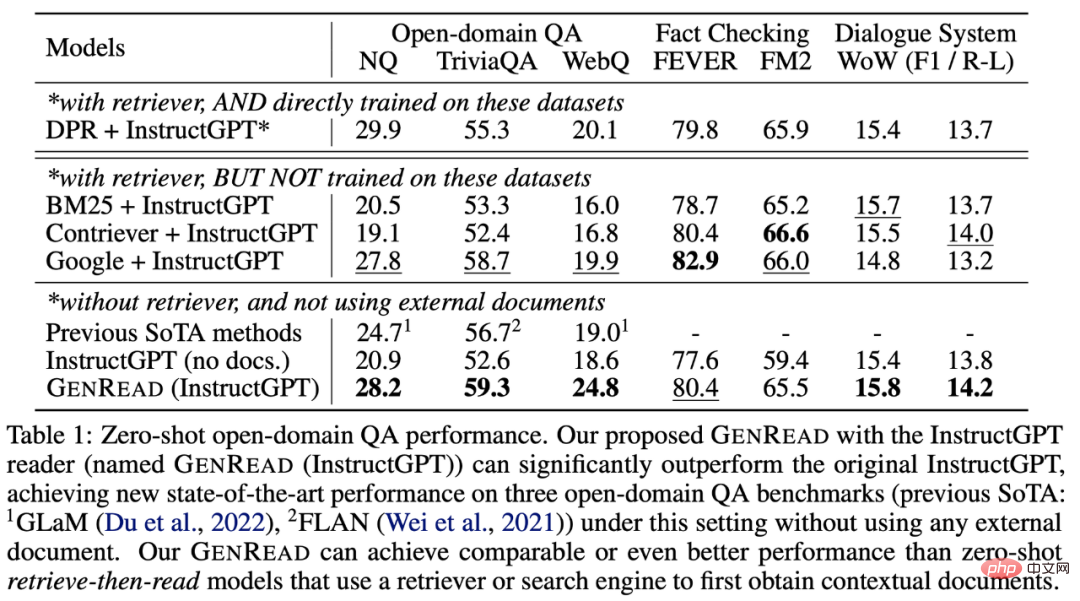

Wissensbasiertes Denken

Das nächste Beispiel sind Denkfähigkeiten, die Wissen erfordern (wie Frage und Antwort und gesundes Denken). In diesem Fall ist die Anregung eines großen Modells nicht unbedingt besser als die Feinabstimmung eines kleinen Modells (welches Modell besser ist, bleibt abzuwarten). Aber die Annotationseffizienz wird in diesem Fall erhöht, weil:

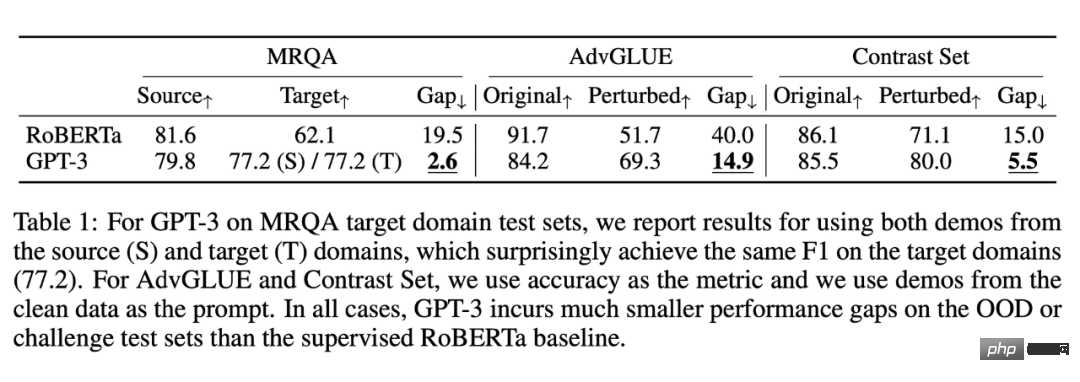

Das Bild stammt von Yu et al. 2022. Frühere SOTA-Modelle müssen aus externen Wissensquellen abgerufen werden. GPT-3 schneidet ohne Abruf genauso gut/besser ab als die Vorgängermodelle.

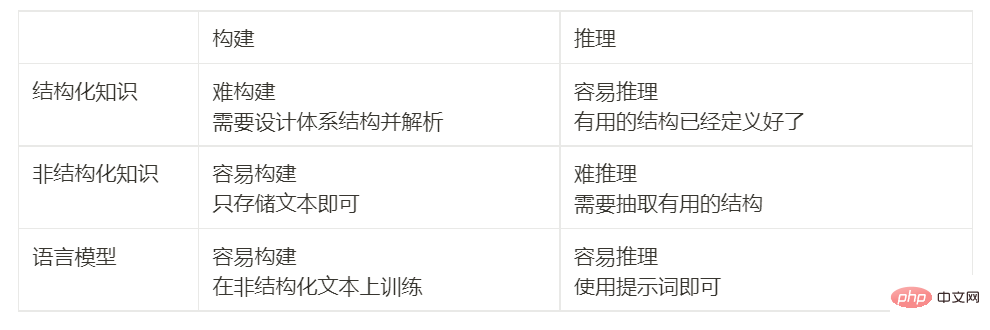

Wie in der Tabelle gezeigt, übertrifft GPT-3 im Gegensatz zum Beispiel für eine mathematische Aufgabe das vorherige, fein abgestimmte Modell nicht wesentlich. Es muss aber nicht aus externen Dokumenten abgerufen werden, es enthält selbst Wissen[23]. Um die Bedeutung dieser Ergebnisse zu verstehen, können wir auf die Geschichte zurückblicken: Die NLP-Community stand von Anfang an vor der Herausforderung, „Wissen effizient zu kodieren“. Menschen suchen ständig nach Möglichkeiten, Wissen außerhalb oder innerhalb des Modells zu speichern. Seit den 1990er Jahren versucht man, die Regeln der Sprache und der Welt in einer riesigen Bibliothek festzuhalten und Wissen außerhalb des Modells zu speichern. Das ist aber sehr schwierig, schließlich können wir nicht alle Regeln ausschöpfen. Daher begannen Forscher mit dem Aufbau domänenspezifischer Wissensdatenbanken, um Wissen in Form von unstrukturiertem Text, halbstrukturiertem (wie Wikipedia) oder vollständig strukturiertem (wie Wissensgraphen) zu speichern. Im Allgemeinen ist strukturiertes Wissen schwer zu konstruieren (weil das strukturelle System des Wissens entworfen werden muss), aber leicht zu begründen (aufgrund der Architektur), unstrukturiertes Wissen ist leicht zu konstruieren (speichern Sie es einfach direkt) , aber sehr schwer zum Nachdenken zu verwenden (keine Architektur). Sprachmodelle bieten jedoch eine neue Möglichkeit, einfach Wissen aus unstrukturiertem Text zu extrahieren und basierend auf dem Wissen effizient zu argumentieren, ohne dass vordefinierte Muster erforderlich sind. Die folgende Tabelle vergleicht die Vor- und Nachteile: Out-of-Distribution-Robustheit

Ähnlich ist in diesem Experiment die Wirkung von GPT-3 basierend auf prompten Wörtern unter derselben Verteilung nicht so gut wie die von fein abgestimmtem RoBERTa. Aber es übertrifft RoBERTa in drei anderen Distributionen (Domain Switching, Noise und Adversarial Perturbations), was bedeutet, dass GPT3 robuster ist. Darüber hinaus bleibt die Verallgemeinerungsleistung guter Aufforderungsworte auch bei einer Verteilungsverschiebung erhalten. Zum Beispiel:

Die Studie von Fu et al. aus dem Jahr 2022 [25] Bisherige Zusammenfassung Im obigen Artikel habe ich drei neue Funktionen besprochen, die nur in großen Modellen verfügbar sind. Sie sind: Angesichts der oben aufgeführten Vorteile denken Sie vielleicht, dass große Sprachmodelle tatsächlich sehr gut sind. Bevor wir weiter diskutieren, werfen wir einen Blick auf frühere Arbeiten und wir werden auf eine sehr seltsame Frage stoßen: GPT-3 wurde im Jahr 2020 veröffentlicht, aber warum haben wir den Paradigmenwechsel erst jetzt entdeckt und nicht darüber nachgedacht? Die Antwort auf diese Frage liegt in zwei Arten von Kurven: der logarithmischen linearen Kurve und der Phasenänderungskurve. Wie unten gezeigt: Linkes Bild: Gesetz der Proportionen. Wenn die Modellgröße exponentiell wächst, wächst die entsprechende Modellleistung linear. Rechts: Wenn die Modellgröße einen bestimmten Maßstab erreicht, werden neue Funktionen angezeigt, die eine dramatische Leistungssteigerung ermöglichen. Anfangs glaubten (OpenAI)-Forscher, dass die Beziehung zwischen der Leistung des Sprachmodells und der Modellgröße durch eine logarithmisch lineare Kurve vorhergesagt werden kann, d. h. wenn die Modellgröße exponentiell zunimmt, steigt die Leistung linear an. Dieses Phänomen ist als Skalierungsgesetz von Sprachmodellen bekannt, wie es von Kaplan et al. in ihrem ursprünglichen GPT3-Artikel aus dem Jahr 2020 diskutiert wurde. Wichtig ist, dass selbst der größte GPT-3 zu diesem Zeitpunkt die Feinabstimmung kleiner Modelle mit Hinweisen nicht übertreffen konnte. Daher bestand zu diesem Zeitpunkt keine Notwendigkeit, teure große Modelle zu verwenden (obwohl die Kennzeichnung von Aufforderungswörtern sehr effizient war). Bis 2021 stellten Cobbe et al. [28] fest, dass das Skalierungsgesetz auch für die Feinabstimmung gilt. Dies ist ein etwas pessimistischer Befund, da er bedeutet, dass wir möglicherweise an die Modellgröße gebunden sind. Obwohl die Optimierung der Modellarchitektur die Modellleistung bis zu einem gewissen Grad verbessern kann, bleibt der Effekt dennoch in einem Bereich (entsprechend dem Modell). Maßstab), ist es schwierig, einen bedeutenderen Durchbruch zu erzielen. Unter der Kontrolle des Skalierungsgesetzes (2020 bis 2021) schenkt die NLP-Community mehr Aufmerksamkeit, da GPT-3 die Feinabstimmung von T5-11B nicht übertreffen kann und die Feinabstimmung von T5-11B bereits sehr problematisch ist Untersuchen Sie kleinere Modelle oder eine effiziente Parameteranpassung. Präfix-Tuning[29] ist ein Beispiel für die Schnittstelle von Aufforderungen und Anpassungen, die später von He et al. im Jahr 2021 vereinheitlicht wurden. Die damalige Logik war einfach: Wenn der Feinabstimmungseffekt besser ist, sollten wir mehr an einer effizienten Parameteranpassung arbeiten; wenn die Prompt-Word-Methode besser ist, sollten wir mehr Energie in das Training großer Sprachmodelle investieren. Bei der Verwendung von Gedankenketten für Eingabeaufforderungen schneidet das große Modell deutlich besser ab als die Feinabstimmung bei komplexen Überlegungen, schneidet bei Wissensbegründungen sehr konkurrenzfähig ab und verfügt über ein gewisses Potenzial für Verteilungsrobustheit. Es sind nur etwa 8 Beispiele erforderlich, um einen solchen Effekt zu erzielen, weshalb sich das Paradigma ändern kann (Hinweis: Dieser Artikel wurde einen Monat vor der Online-Schaltung von ChatGPT fertiggestellt; nachdem ChatGPT online ging, war die gesamte Branche schockiert und erkannte, dass sich das Paradigma geändert hatte ). 4. Was bedeutet Paradigmenwechsel?

Die Vorteile von Prompt Words liegen auf der Hand: Wir brauchen keine mühsame Datenannotation und Feinabstimmung der gesamten Datenmenge mehr. Wir müssen nur noch Prompt Words schreiben und erhalten Ergebnisse, die den Anforderungen entsprechen, was viel schneller geht als Feinabstimmungen. Tuning. Zwei weitere zu beachtende Punkte sind: Ist kontextuelles Lernen überwachtes Lernen? Ist kontextuelles Lernen wirklich besser als überwachtes Lernen? Obwohl wir glauben, dass große Sprachmodelle ein enormes Potenzial haben, gibt es immer noch keine schlüssigen Beweise dafür, dass eine Feinabstimmung oder Stichworte besser sind, sodass wir nicht sicher sind, ob sich das Paradigma tatsächlich ändern sollte oder ändern sollte Inwieweit . Es ist sehr sinnvoll, diese beiden Paradigmen sorgfältig zu vergleichen, um uns ein klares Verständnis der Zukunft zu vermitteln. Wir überlassen die weitere Diskussion dem nächsten Artikel. 5. Wie groß sollte das Modell sein? Zwei Zahlen: 62B und 175B. Das Modell erfordert mindestens 62B, damit die Wirkung der Gedankenkette größer sein kann als die Standard-Promptwort-Methode.

Für alle Modelle kleiner als 62B ist die direkte Verwendung von Eingabeaufforderungswörtern besser als Denkkette. Allerdings gibt es andere große Modelle, die unter der Denkkette viel schlechter abschneiden und die Denkkette nicht einmal erlernen können, wie zum Beispiel die erste Version von OPT, BLOOM und GPT-3. Sie haben beide die Größe 175B. Dies bringt uns zu unserer nächsten Frage. Nein. Skalierung ist ein notwendiger, aber nicht ausreichender Faktor. Einige Modelle sind groß genug (z. B. OPT und BLOOM, beide 175B), können aber keine Gedankenketten ausführen. Es gibt zwei Modelle[33], die zur Gedankenverkettung verwendet werden können: Warum es Emergenzfähigkeit gibt, ist noch unklar, aber wir haben die Faktoren herausgefunden, die Emergenzfähigkeit erzeugen können: All diese Faktoren sind zum jetzigen Zeitpunkt jedoch Spekulation. Es ist sehr sinnvoll zu zeigen, wie das Modell trainiert werden kann, um neue Fähigkeiten zu erzeugen, und wir werden die weitere Diskussion dem nächsten Artikel überlassen. In diesem Artikel haben wir die Emergenzfähigkeit von Sprachmodellen sorgfältig untersucht. Wir betonen die Bedeutung und Möglichkeiten von komplexem Denken, Wissensdenken und Out-of-Distribution-Robustheit. Neue Fähigkeiten sind sehr spannend, weil sie Skalierungsgesetze überwinden und Phasenübergänge in Skalierungskurven aufweisen können. Wir haben ausführlich darüber diskutiert, ob sich das Forschungsparadigma tatsächlich von der Feinabstimmung zum kontextuellen Lernen verschieben wird, haben aber noch keine eindeutige Antwort darauf, da die Auswirkungen der Feinabstimmung und des kontextuellen Lernens in Szenarien innerhalb und außerhalb der Verteilung immer noch bestehen müssen verglichen werden. Abschließend diskutieren wir drei potenzielle Faktoren, die neue Fähigkeiten hervorbringen: Feinabstimmung der Anweisungen, Feinabstimmung des Codes und Feinabstimmung der Gedankenkette. Anregungen und Diskussionen sind herzlich willkommen. Außerdem haben wir zwei interessante Themen erwähnt, die noch nicht besprochen wurden: Für diese beiden Themen werden wir sie in den Artikeln danach besprechen .

Bild von Fu et al. 2022. Auch wenn die Testverteilung von der Trainingsverteilung abweicht, schneiden komplexe Hinweise immer besser ab als einfache Hinweise.

Bild von Fu et al. 2022. Auch wenn die Testverteilung von der Trainingsverteilung abweicht, schneiden komplexe Hinweise immer besser ab als einfache Hinweise.

3. Emergente Fähigkeiten heben das Gesetz der Proportionen auf

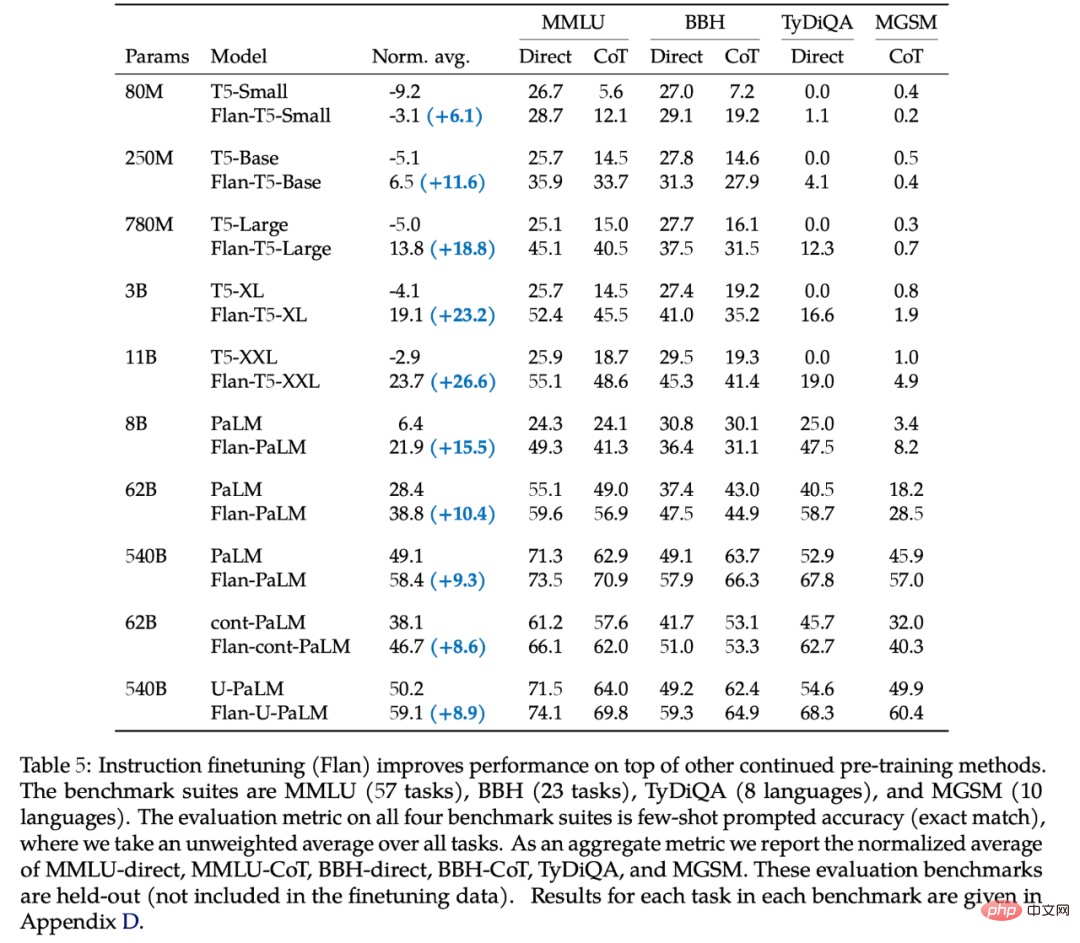

Das erste bessere Modell, das die Gedankenkette nutzt, ist das Ergebnis von Flan-cont-PaLM 62B auf BBH. Das 540B-Modell, das die Denkkette verwendet, wird bei mehr Aufgaben gute Ergebnisse erzielen, aber nicht alle Aufgaben sind besser als eine Feinabstimmung. Darüber hinaus kann die ideale Größe weniger als 540B betragen. In der Arbeit von Suzgun et al. [32] aus dem Jahr 2022 zeigte der Autor, dass 175B InstructGPT und 175B Codex besser sind als die direkte Verwendung von Prompt-Wörtern. Wenn wir die obigen Ergebnisse kombinieren, erhalten wir zwei Zahlen: 63B und 175B. Wenn Sie also an diesem Spiel teilnehmen möchten, müssen Sie zunächst über ein überdurchschnittlich großes Modell verfügen.

Das erste bessere Modell, das die Gedankenkette nutzt, ist das Ergebnis von Flan-cont-PaLM 62B auf BBH. Das 540B-Modell, das die Denkkette verwendet, wird bei mehr Aufgaben gute Ergebnisse erzielen, aber nicht alle Aufgaben sind besser als eine Feinabstimmung. Darüber hinaus kann die ideale Größe weniger als 540B betragen. In der Arbeit von Suzgun et al. [32] aus dem Jahr 2022 zeigte der Autor, dass 175B InstructGPT und 175B Codex besser sind als die direkte Verwendung von Prompt-Wörtern. Wenn wir die obigen Ergebnisse kombinieren, erhalten wir zwei Zahlen: 63B und 175B. Wenn Sie also an diesem Spiel teilnehmen möchten, müssen Sie zunächst über ein überdurchschnittlich großes Modell verfügen. 6. Ist die Größe der einzige Faktor?

7. Fazit Fazit

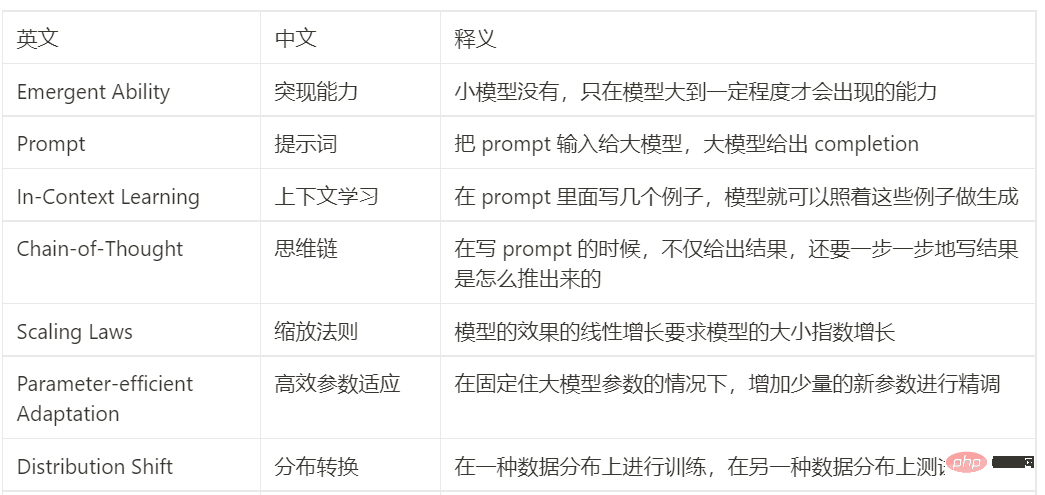

Chinesisch-Englisch-Vergleichstabelle

Das obige ist der detaillierte Inhalt vonInterpretation aktueller Themen: Die aufstrebende Fähigkeit großer Modelle und der durch ChatGPT ausgelöste Paradigmenwechsel. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

ChatGPT-Registrierung

ChatGPT-Registrierung

Inländische kostenlose ChatGPT-Enzyklopädie

Inländische kostenlose ChatGPT-Enzyklopädie

So installieren Sie ChatGPT auf einem Mobiltelefon

So installieren Sie ChatGPT auf einem Mobiltelefon

Kann Chatgpt in China verwendet werden?

Kann Chatgpt in China verwendet werden?

Welche Methoden gibt es, Crawler zu verhindern?

Welche Methoden gibt es, Crawler zu verhindern?

Die Vorteile des OTC-Handels

Die Vorteile des OTC-Handels

Methode zum Öffnen der Bereichsberechtigung

Methode zum Öffnen der Bereichsberechtigung

Mobile Festplattenpartitionssoftware

Mobile Festplattenpartitionssoftware