Seit Meta die LLaMA-Modellreihe veröffentlicht und als Open Source bereitgestellt hat, haben Forscher der Stanford University, der UC Berkeley und anderer Institutionen eine „zweite Schöpfung“ auf der Grundlage von LLaMA durchgeführt und nacheinander mehrere „Alpaka“-Modelle wie Alpaka und Vicuna auf den Markt gebracht . Modell.

Alpaca ist der neue Top-Player in der Open-Source-Community. Aufgrund der Fülle an „sekundären Schöpfungen“ sind die englischen Bezeichnungen für die biologische Gattung Alpaka nahezu außer Gebrauch geraten, es ist aber auch möglich, das große Vorbild nach anderen Tieren zu benennen.

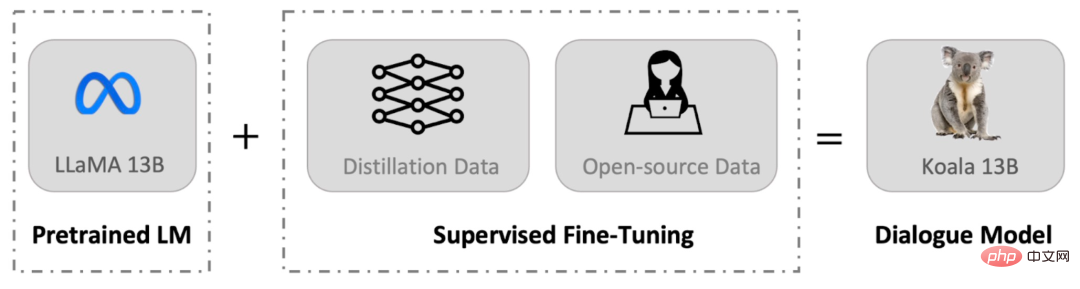

Kürzlich hat das Berkeley Artificial Intelligence Institute (BAIR) an der UC Berkeley ein Konversationsmodell Koala (wörtlich übersetzt als Koala) veröffentlicht, das auf GPUs der Verbraucherklasse ausgeführt werden kann. Koala optimiert das LLaMA-Modell mithilfe von im Internet gesammelten Gesprächsdaten.

Project Adresse: https: //bair.berkeley.edu/blog/2023/04/03/koala/

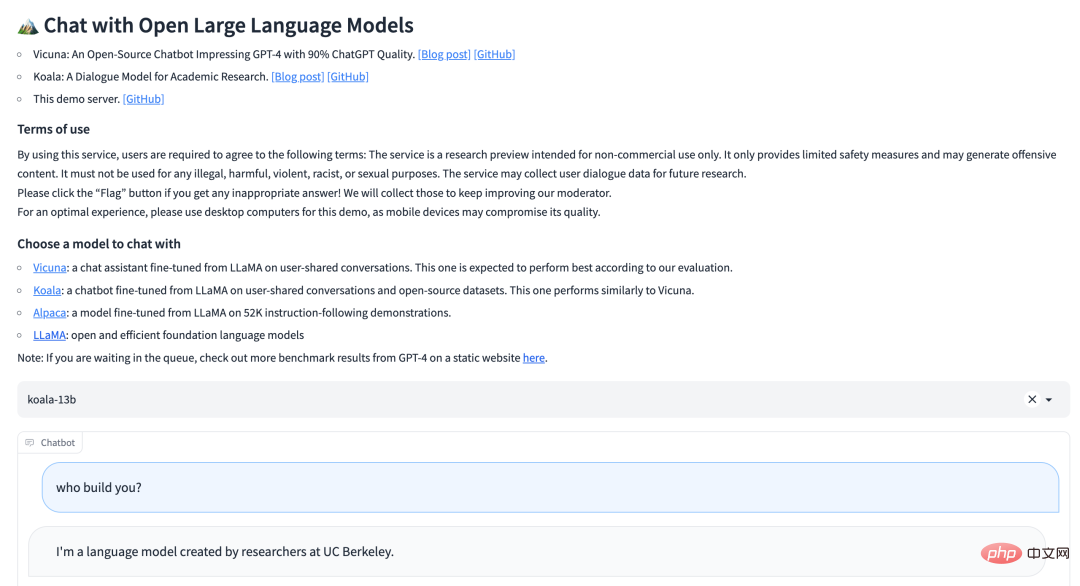

koala hat eine Online -Test -Demo gestartet:

Ähnlich wie Vicuna optimiert auch Koala das LLaMA-Modell mithilfe von im Internet gesammelten Konversationsdaten, wobei der Schwerpunkt auf öffentlichen Daten zu Konversationen mit großen Closed-Source-Modellen wie ChatGPT liegt.

Das Forschungsteam gab an, dass das Koala-Modell in EasyLM unter Verwendung von JAX/Flax implementiert ist und das Koala-Modell auf einem einzelnen Nvidia DGX-Server trainiert wird, der mit 8 A100-GPUs ausgestattet ist. Es dauert 6 Stunden, um 2 Trainingsepochen abzuschließen. Die Kosten für eine solche Schulung betragen auf öffentlichen Cloud-Computing-Plattformen in der Regel weniger als 100 US-Dollar.

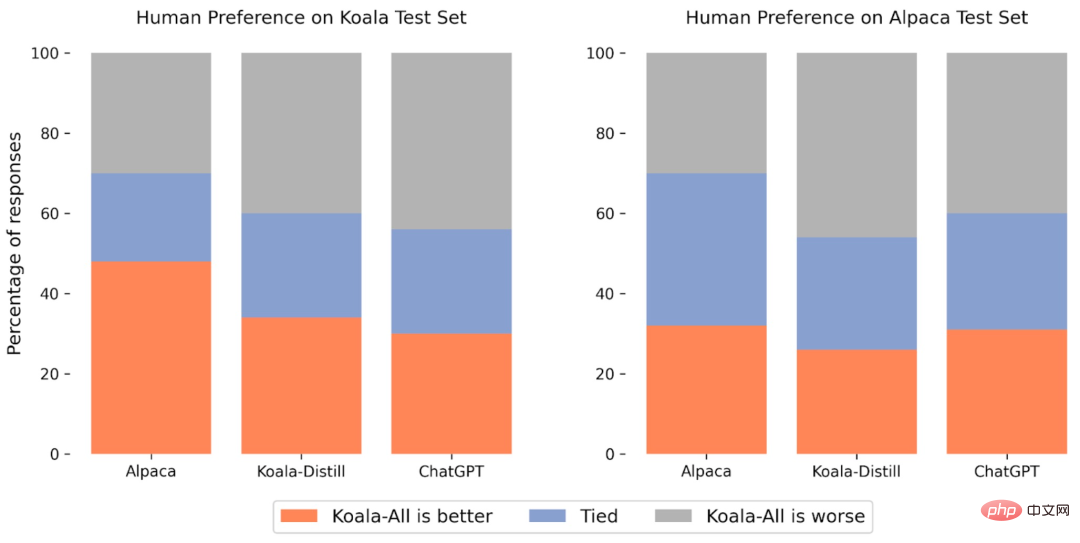

Das Forschungsteam verglich Koala experimentell mit ChatGPT und Alpaca der Stanford University. Die Ergebnisse zeigten: Koala-13B mit 13 Milliarden Parametern kann effektiv auf verschiedene Benutzeranfragen reagieren und die generierten Antworten sind im Allgemeinen besser als Alpaca und in der Leistung ist in mehr als der Hälfte der Fälle mit ChatGPT vergleichbar.

Die wichtigste Bedeutung von Koala besteht darin, dass es zeigt, dass ein Modell, das klein genug ist, um lokal ausgeführt zu werden, durch Training auf einem Datensatz höherer Qualität auch eine hervorragende Leistung ähnlich der eines großen Modells erzielen kann. Das bedeutet, dass die Open-Source-Community härter daran arbeiten sollte, qualitativ hochwertige Datensätze zu kuratieren, da dies zu sichereren, realistischeren und leistungsfähigeren Modellen führen kann, als nur die Größe bestehender Systeme zu vergrößern. Aus dieser Perspektive ist Koala eine kleine, aber feine Alternative zu ChatGPT.

Allerdings ist Koala immer noch nur ein Forschungsprototyp und weist immer noch große Mängel in Bezug auf Inhalt, Sicherheit und Zuverlässigkeit auf und sollte nicht für andere Zwecke als die Forschung verwendet werden.

Die größte Hürde beim Aufbau eines Konversationsmodells ist die Verwaltung der Trainingsdaten. Große Konversationsmodelle wie ChatGPT, Bard, Bing Chat und Claude verwenden alle proprietäre Datensätze mit umfangreichen menschlichen Anmerkungen. Um den Trainingsdatensatz von Koala zu erstellen, sammelte und kuratierte das Forschungsteam Konversationsdaten aus dem Internet und öffentlichen Datensätzen, die Daten enthalten, die öffentlich von Benutzern geteilt wurden, die mit großen Sprachmodellen wie ChatGPT sprechen.

Im Gegensatz zu anderen Modellen, die so viele Webdaten wie möglich crawlen, um den Datensatz zu maximieren, konzentriert sich Koala auf das Sammeln kleiner, qualitativ hochwertiger Datensätze, einschließlich Frage-und-Antwort-Abschnitten in öffentlichen Datensätzen, menschlichem Feedback (positiv und negativ) und Interaktionen mit Gesprächen mit bestehenden Sprachmodellen. Konkret umfasst der Trainingsdatensatz von Koala die folgenden Teile:

ChatGPT-destillierte Daten:

Open-Source-Daten:

Insgesamt reicht das Koala-Modell aus, um viele der Fähigkeiten von LLM zu demonstrieren, und ist gleichzeitig klein genug, um eine Feinabstimmung oder Verwendung mit begrenzten Rechenressourcen zu ermöglichen. Das Forschungsteam hofft, dass das Koala-Modell eine nützliche Plattform für zukünftige akademische Forschung zu groß angelegten Sprachmodellen wird:

Sicherheit und Ausrichtung: Koala ermöglicht weitere Forschung zur Sicherheit von Sprachmodellen und passt sich besser den menschlichen Absichten an. Seien Sie konsequent.

Das obige ist der detaillierte Inhalt von13 Milliarden Parameter, 8 A100-Schulungen, UC Berkeley veröffentlicht Dialogmodell Koala. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

vim-Befehl zum Speichern und Beenden

vim-Befehl zum Speichern und Beenden

So wechseln Sie auf dem Laptop in den abgesicherten Modus

So wechseln Sie auf dem Laptop in den abgesicherten Modus

Wie wurde der Name von tt voice geändert?

Wie wurde der Name von tt voice geändert?

Was ist der Baidu-Index?

Was ist der Baidu-Index?

Was sind die Befehle zur Datenträgerbereinigung?

Was sind die Befehle zur Datenträgerbereinigung?

Was bedeutet Harmonios?

Was bedeutet Harmonios?

Drei häufig verwendete Kodierungsmethoden

Drei häufig verwendete Kodierungsmethoden

Befehl zum Neustart der Netzwerkkarte unter Linux

Befehl zum Neustart der Netzwerkkarte unter Linux