Es ist keine manuelle Anmerkung erforderlich, es ist nur eine Schulung erforderlich, damit das 3D-Modell die Sprache verstehen und unbeschriftete Kategorien identifizieren kann.

3D-Modellsegmentierung ist jetzt freihändig!

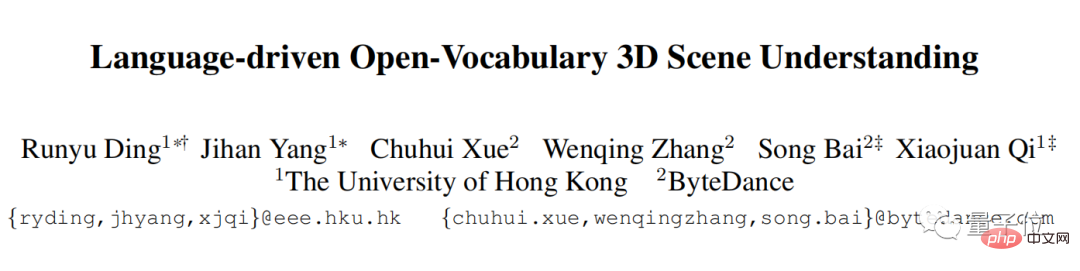

Die University of Hong Kong und ByteDream haben zusammengearbeitet und eine neue Methode entwickelt:

Es ist keine manuelle Annotation erforderlich und es ist nur eine Schulung erforderlich, damit das 3D-Modell die Sprache verstehen und unbeschriftete Kategorien identifizieren kann.

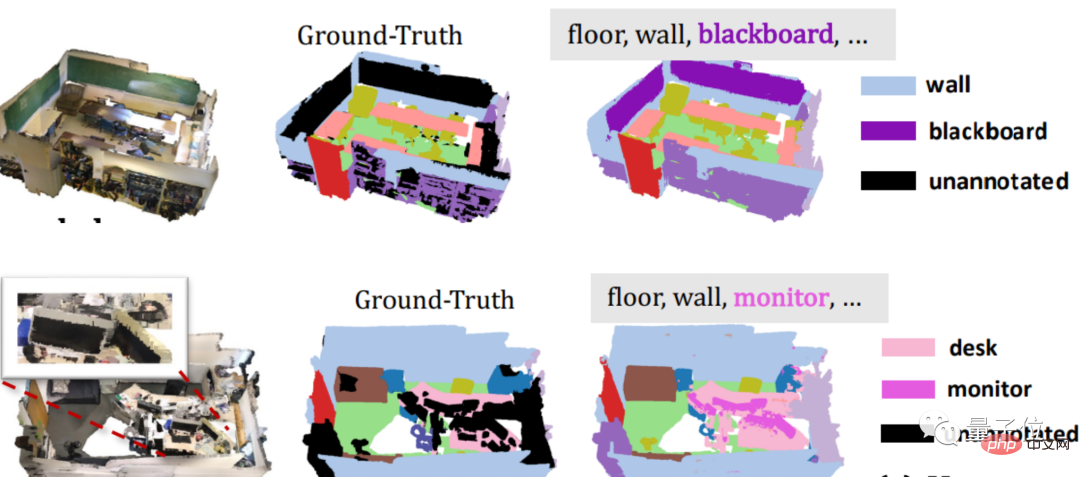

Sehen Sie sich zum Beispiel das folgende Beispiel an: Tafel und Monitor ohne Anmerkungen. Nachdem das 3D-Modell mit dieser Methode trainiert wurde, kann es das Ziel für die Segmentierung schnell „erfassen“.

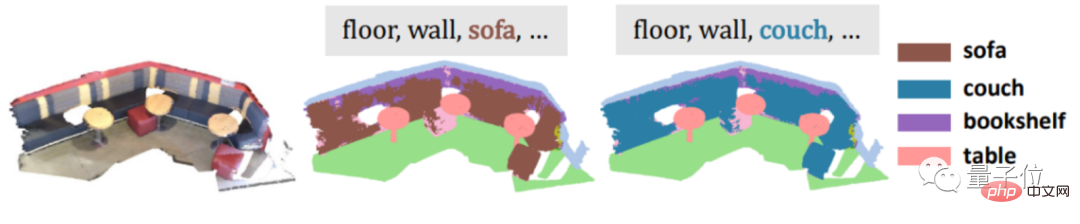

Ein weiteres Beispiel: Wenn Sie Synonyme wie Sofa und Husten eingeben, damit es schwierig wird, können Sie es leicht gewinnen.

Auch abstrakte Kategorien wie Badezimmer können gelöst werden.

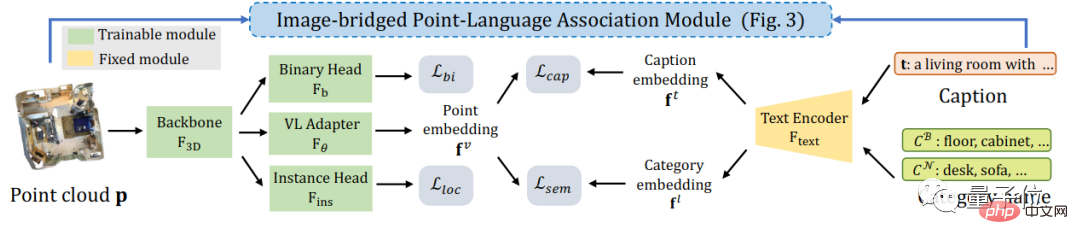

Diese neue Methode heißt PLA (Point-Language Assocation), eine Methode, die Punktwolke (eine riesige Punktsammlung von Zieloberflächeneigenschaften) und natürliche Sprache kombiniert.

Derzeit wurde dieses Papier von CVPR 2023 angenommen.

Aber es ist keine manuelle Kennzeichnung erforderlich, es wird nur ein Training durchgeführt und auch die abstrakte Klassifizierung von Synonymen kann erkannt werden ... Dies ist eine Überlagerung mehrerer Buffs.

Sie müssen wissen, dass die 3D-Daten und die natürliche Sprache, die von allgemeinen Methoden verwendet werden, nicht kostenlos direkt aus dem Internet bezogen werden können und oft eine teure manuelle Annotation erfordern, und dass allgemeine Methoden keine neuen Kategorien basierend auf der semantischen Verbindung zwischen Wörtern identifizieren können.

Wie macht PLA das? Werfen wir einen Blick auf ~

Um es ganz klar auszudrücken: Der wichtigste Schritt für eine erfolgreiche 3D-Modellaufteilung besteht darin, die 3D-Daten in natürlicher Sprache verständlich zu machen.

Professionell gesehen geht es darum, Beschreibungen in natürlicher Sprache in 3D-Punktwolken einzuführen.

Wie stellt man es vor?

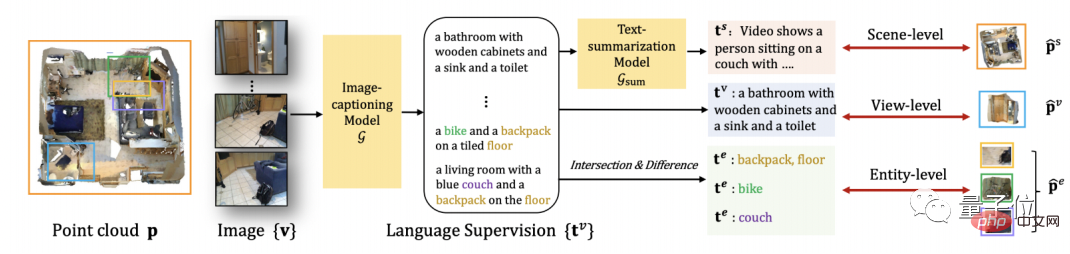

Angesichts der Tatsache, dass es derzeit relativ erfolgreiche Methoden zur Aufteilung von 2D-Bildern gibt, entschied sich das Forschungsteam, mit 2D-Bildern zu beginnen.

Konvertieren Sie zunächst die 3D-Punktwolke in das entsprechende 2D-Bild, verwenden Sie sie dann als Eingabe für das multimodale 2D-Großmodell und extrahieren Sie daraus die Sprachbeschreibung des Bildes.

Als nächstes kann mithilfe der Projektionsbeziehung zwischen dem Bild und der Punktwolke die Sprachbeschreibung des Bildes natürlich mit den 3D-Punktwolkendaten verknüpft werden.

Und um mit 3D-Objekten unterschiedlicher Granularität kompatibel zu sein, schlägt PLA auch eine Korrelationsmethode zwischen 3D-Punktwolke und natürlicher Sprache mit mehreren Granularitäten vor.

Für die gesamte 3D-Szene fasst PLA die aus allen der Szene entsprechenden Bildern extrahierten Sprachbeschreibungen zusammen und verwendet diese zusammengefasste Sprache, um die gesamte 3D-Szene zuzuordnen.

Für die partielle 3D-Szene, die jeder Bildansicht entspricht, verwendet PLA das Bild direkt als Brücke, um die entsprechende 3D-Punktwolke und Sprache zuzuordnen.

Für feinkörnigere 3D-Objekte bietet PLA eine feinkörnigere 3D-Sprachbezogene Methode.

Auf diese Weise kann das Forschungsteam Paare von 3D-Punktwolken erhalten – natürliche Sprache, die das Problem der manuellen Annotation direkt löst.

PLA verwendet das erhaltene Paar „3D-Punktwolke-natürliche Sprache“ und die Überwachung vorhandener Datensätze, damit das 3D-Modell die Definition des Erkennungs- und Segmentierungsproblems verstehen kann.

Kontrastives Lernen wird insbesondere verwendet, um den Abstand zwischen jedem Paar von 3D-Punktwolken und natürlicher Sprache im Merkmalsraum zu verkürzen und die nicht übereinstimmenden 3D-Punktwolken und Beschreibungen in natürlicher Sprache zu entfernen.

Nachdem wir über so viele Prinzipien gesprochen haben, wie funktioniert PLA bei bestimmten Segmentierungsaufgaben?

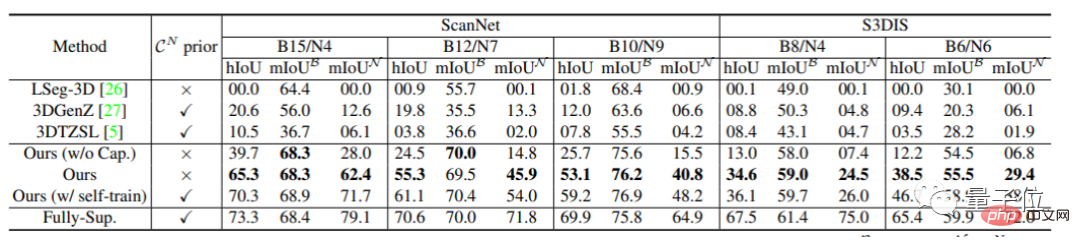

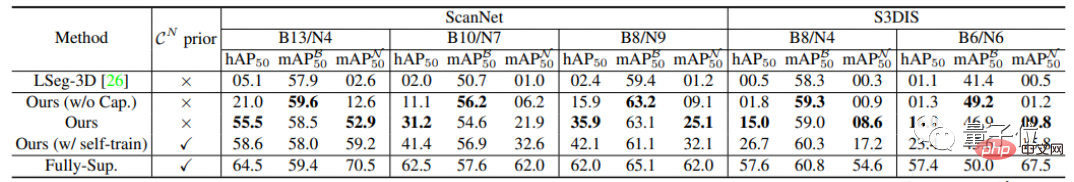

Die Forscher testeten die Leistung des 3D-Open-World-Modells in unbeschrifteten Kategorien als Hauptmesskriterium.

Erstens übertraf PLA bei den semantischen Segmentierungsaufgaben von ScanNet und S3DIS die vorherige Basismethode um 35 % bis 65 %.

Bei der Instanzsegmentierungsaufgabe wurde PLA ebenfalls verbessert. Im Vergleich zur vorherigen Methode liegt die PLA-Verbesserung zwischen 15 % und 50 %.

Das Forschungsteam für dieses Projekt kommt vom CVMI Lab der University of Hong Kong und ByteDance.

CVMI Lab ist ein Labor für künstliche Intelligenz der Universität Hongkong. Das Labor wurde am 1. Februar 2020 gegründet.

Der Forschungsumfang umfasst Computer Vision und Mustererkennung, maschinelles Lernen/Deep Learning, Bild-/Videoinhaltsanalyse und industrielle Big-Data-Analyse auf Basis maschineller Intelligenz.

Adresse der Abschlussarbeit:https://arxiv.org/pdf/2211.16312.pdf

Projektinhaber:https://github.com/CVMI-Lab/PLA

Das obige ist der detaillierte Inhalt vonNeue Methode der 3D-Modellsegmentierung macht Ihre Hände frei! Es ist keine manuelle Kennzeichnung erforderlich, es ist nur eine Schulung erforderlich, und auch nicht gekennzeichnete Kategorien können HKU und Byte erkennen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Rangliste der Kryptowährungsbörsen

Rangliste der Kryptowährungsbörsen

Der Unterschied zwischen Heap und Stack

Der Unterschied zwischen Heap und Stack

location.reload-Nutzung

location.reload-Nutzung

Was bedeutet BBS?

Was bedeutet BBS?

Kostenlose Software zum Erstellen von Websites

Kostenlose Software zum Erstellen von Websites

Was soll ich tun, wenn sich mein Computer nicht einschalten lässt?

Was soll ich tun, wenn sich mein Computer nicht einschalten lässt?

wenn was bedeutet es

wenn was bedeutet es

So prüfen Sie CNKI auf Plagiate. Detaillierte Schritte zur Plagiatsprüfung auf CNKI

So prüfen Sie CNKI auf Plagiate. Detaillierte Schritte zur Plagiatsprüfung auf CNKI