Was benötigt ein Python-Crawler zum Crawlen von Bildern? Im Folgenden finden Sie zwei Methoden zum Erstellen eines Batch-Crawlings von Netzwerkbildern:

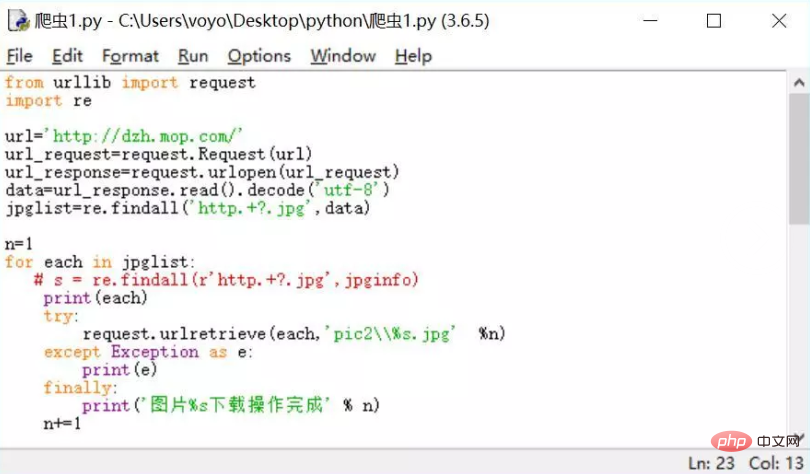

Die erste Methode: Basierend auf der URLlib-Implementierung

Die wichtigsten Punkte sind wie folgt :

1.url_request = request.Request(url)

2.url_response = request.urlopen(url) oder url_response = request.urlopen(url_request)

3. data= url_response .read().decode('utf-8')

4.jpglist=re.findall(regulärer Ausdruck, Daten)

5.request.urlretrieve(jpgUrl,' % s.jpg' %n) #Download, die erste Parameter-URL, der zweite Parametername

Verwandte Empfehlungen: „Python Video Tutorial“

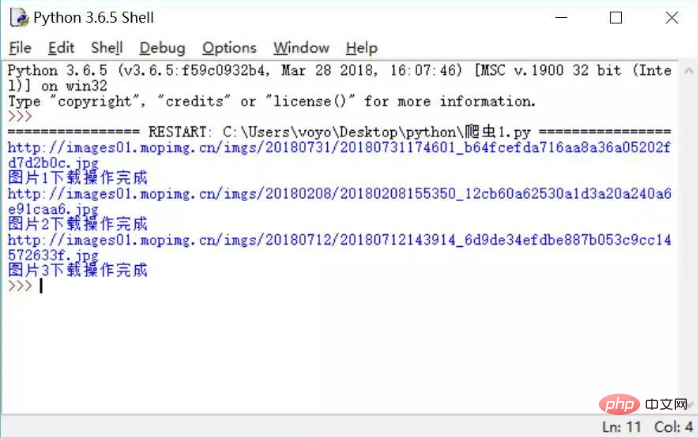

Der erste Fall , Wir haben Bilder auf einer Webseite auf Maopu gecrawlt. Der Fallcode lautet wie folgt.

Es ist zu beachten, dass „pic2\“ im Code request.urlretrieve(each,'pic2\%s.jpg' %n) bedeutet, dass das heruntergeladene Bild ist im vorgefertigten Good-Ordner pic2 abgelegt. Nach dem Ausführen des Codes werden IDLE und das Endergebnis in der folgenden Abbildung angezeigt.

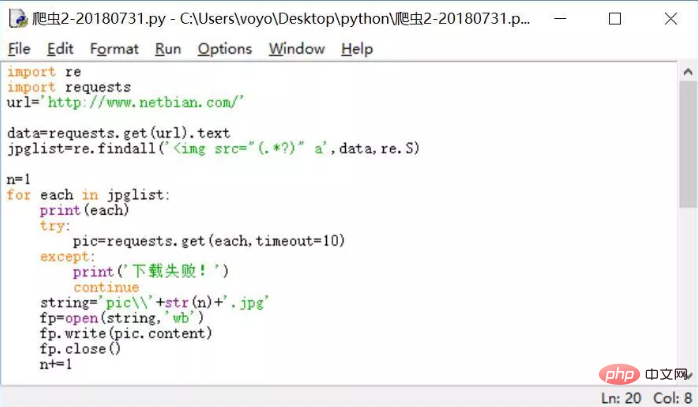

Die zweite Implementierungsmethode: basierend auf Anfragen

Die wichtigsten Punkte sind wie folgt:

1. data=requests .get(url).text

2.jpglist=re.findall(regular expression,data,re.S)

3.pic=requests.get(pic_url,timeout =10 )

4. fp=open(pic_name,'wb')

fp.write(pic.content)

fp.close()

In diesem Fall haben wir die Webseite einer Wallpaper-Website gecrawlt und gehen davon aus, dass die Bildqualität relativ hoch sein sollte. Der vollständige Code lautet wie folgt:

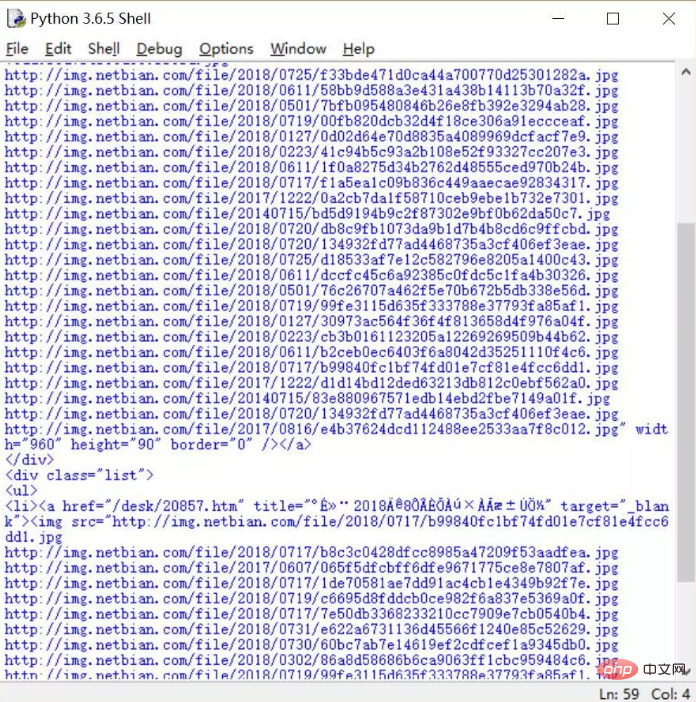

Schauen wir uns die Ergebnisse der Ausführung des Codes an, wie in der folgenden Abbildung dargestellt. Es ist wirklich schön, wir haben 42 Hintergrundbilder bekommen und es war in nur wenigen Sekunden fertig.

Das obige ist der detaillierte Inhalt vonWas wird benötigt, damit der Python-Crawler Bilder crawlen kann?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!