Python-Crawler ist ein Python-Webcrawler, der auch als Web-Spider oder Web-Roboter bezeichnet wird. Es handelt sich um ein Programm oder Skript, das nach bestimmten Regeln automatisch World Wide Web-Informationen erfasst bekannt als Ameisen, Autoindexer, Emulatoren oder Würmer.

Einfach ausgedrückt ist das Internet ein großes Netzwerk, das aus Websites und Netzwerkgeräten besteht. Wir greifen über einen Browser auf die Website zu und die Website enthält HTML, JS, und CSS-Codes Diese Codes werden an den Browser zurückgegeben und vom Browser analysiert und gerendert, um reichhaltige und farbenfrohe Webseiten vor unseren Augen zu präsentieren

Wenn wir das Internet vergleichen Bei einem großen Spinnennetz werden Daten in jedem Knoten des Spinnennetzes gespeichert, und der Python-Crawler ist eine kleine Spinne.

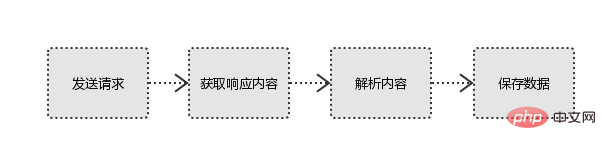

Ergreift seine eigene Beute (Daten) im Netzwerk. Der Crawler bezieht sich auf: Erstellen eines Anfrage an die Website, Abrufen eines Programms, das nützliche Daten nach Ressourcen analysiert und extrahiert.

Aus technischer Sicht simuliert es das Verhalten eines Browsers, der eine Website über ein Programm anfordert, und crawlt den HTML-Code/JSON-Daten /Binärdaten (Bilder, Videos), die von der Site an den lokalen Bereich zurückgegeben werden, und dann die benötigten Daten extrahieren, speichern und verwenden

Grundprinzipien des Python-Crawlers

1. Initiieren Sie eine Anfrage

Verwenden Sie die http-Bibliothek, um eine Anfrage an die Zielseite zu initiieren, d. h. eine Anfrage zu senden

Anfrage umfasst: Anforderungsheader, Anforderungstext usw.

Anforderungsmodulfehler: JS- und CSS-Code kann nicht ausgeführt werden

2. Holen Sie sich den Antwortinhalt

Wenn der Server antworten kann Normalerweise erhalten Sie eine Antwort

Antwort umfasst: HTML, JSON, Bilder, Videos usw.

3. Inhalt analysieren

HTML-Daten analysieren: regulärer Ausdruck (RE Modul), Analysebibliotheken von Drittanbietern wie Beautifulsoup, Pyquery usw.

JSON-Daten analysieren: JSON-Modul

Binärdaten analysieren: Dateien im WB-Format schreiben

4 . Daten speichern

Datenbank (MySQL, Mongdb, Redis)

Das obige ist der detaillierte Inhalt vonWas bedeutet Python-Crawler?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!