Zuerst müssen wir wissen, was ein Crawler ist! Als ich das Wort Crawler zum ersten Mal hörte, dachte ich, es sei ein kriechendes Insekt. Es war lächerlich, darüber nachzudenken ... Später fand ich heraus, dass es sich um ein Daten-Scraping-Tool im Internet handelte!

Webcrawler (auch bekannt als Web Spiders, Web Robots, in der FOAF-Community häufiger als Web Page Chaser bekannt) sind eine Art Webcrawler, der folgt Ein Programm oder Skript, das auf der Grundlage bestimmter Regeln automatisch World Wide Web-Informationen erfasst. Andere, weniger häufig verwendete Namen sind Ameisen, Autoindexer, Emulatoren oder Würmer.

Was kann ein Crawler?

1. Simulieren Sie den Browser, um die Webseite zu öffnen und den gewünschten Teil der Daten auf der Webseite zu erhalten.

2. Aus technischer Sicht simuliert das Programm das Verhalten des Browsers, der die Site anfordert, crawlt den von der Site zurückgegebenen HTML-Code/JSON-Daten/Binärdaten (Bilder, Videos) und dann extrahiert, was Sie brauchen. Die Daten werden gespeichert und verwendet.

3. Wenn man genau hinschaut, ist es nicht schwer festzustellen, dass immer mehr Menschen Crawler verstehen und lernen können. Andererseits können immer mehr Daten aus dem Internet bezogen werden. Wie Python bietet die Programmiersprache immer mehr hervorragende Tools, um das Crawlen einfach und benutzerfreundlich zu gestalten.

4. Mithilfe von Crawlern können wir eine große Menge wertvoller Daten erhalten und so Informationen erhalten, die nicht durch Wahrnehmungswissen erlangt werden können, wie zum Beispiel:

Zhihu: Crawling Hochwertige Antworten, Auswahl der qualitativ hochwertigsten Inhalte zu jedem Thema für Sie.

Taobao, JD.com: Erfassen Sie Produkte, Kommentare und Verkaufsdaten und analysieren Sie verschiedene Produkte und Benutzerverbrauchsszenarien.

Anjuke und Lianjia: Erfassen Informationen zu Immobilienverkäufen und -mieten, analysieren Immobilienpreistrends und führen Immobilienpreisanalysen in verschiedenen Regionen durch.

Lagou.com und Zhaopin: Durchsuchen Sie verschiedene Jobinformationen und analysieren Sie die Talentnachfrage und Gehaltsniveaus in verschiedenen Branchen.

Snowball Network: Erfassen Sie das Verhalten von Snowball-Benutzern mit hoher Rendite, analysieren und prognostizieren Sie den Aktienmarkt usw.

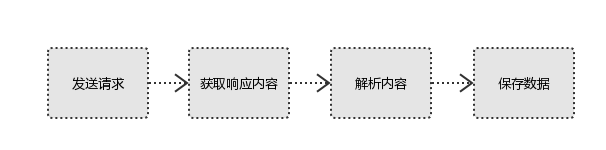

Was ist das Prinzip des Crawlers?

Anfrage senden Der Prozess ist sehr einfach, nicht wahr? Daher bestehen die Browserergebnisse, die Benutzer sehen, aus HTML-Code. Unser Crawler erhält diesen Inhalt durch Analyse und Filterung des HTML-Codes, um die gewünschten Ressourcen zu erhalten.

Verwandte Lernempfehlungen:

Verwandte Lernempfehlungen:

Das obige ist der detaillierte Inhalt vonWas kann ein Python-Crawler?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!