Kauf mir einen Kaffee☕

*Memos:

-

In meinem Beitrag werden das Problem des verschwindenden Gradienten, das Problem des explodierenden Gradienten und das Problem des sterbenden ReLU erläutert.

-

Mein Beitrag erklärt Ebenen in PyTorch.

-

Mein Beitrag erklärt Aktivierungsfunktionen in PyTorch.

-

Mein Beitrag erklärt Verlustfunktionen in PyTorch.

-

Mein Beitrag erklärt Optimierer in PyTorch.

*Sowohl Überanpassung als auch Unteranpassung können durch die Holdout-Methode oder die Kreuzvalidierung (K-Fold-Kreuzvalidierung) erkannt werden. *Kreuzvalidierung ist besser.

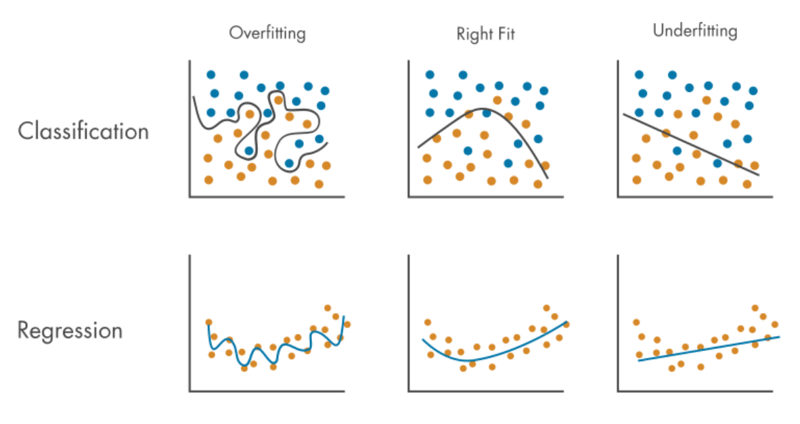

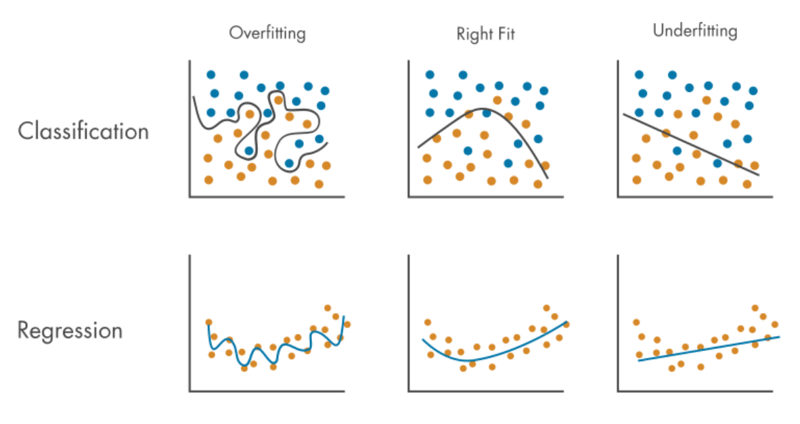

Überanpassung:

- ist das Problem, dass ein Modell sehr genaue Vorhersagen für Zugdaten treffen kann, für neue Daten (einschließlich Testdaten) jedoch nur wenige, sodass das Modell viel besser zu Zugdaten passt als zu neuen Daten.

- tritt auf, weil:

- Die Trainingsdaten sind klein (nicht ausreichend), sodass das Modell nur eine kleine Anzahl von Mustern lernen kann.

- Zugdaten sind unausgeglichen (voreingenommen) und enthalten viele spezifische (begrenzte), ähnliche oder gleiche Daten, aber nicht viele verschiedene Daten, sodass das Modell nur eine kleine Anzahl von Mustern lernen kann.

- Zugdaten enthalten viel Rauschen (verrauschte Daten), sodass das Modell die Muster des Rauschens viel lernt, jedoch nicht die Muster normaler Daten. *Rauschen (verrauschte Daten) bedeutet Ausreißer, Anomalien oder manchmal doppelte Daten.

- Die Trainingszeit ist zu lang mit einer zu großen Anzahl an Epochen.

- Das Modell ist zu komplex.

- kann gemildert werden durch:

- größere Zugdaten.

- mit vielen verschiedenen Daten.

- Lärm reduzieren.

- Mischender Datensatz.

- Training vorzeitig beenden.

- Ensemble-Lernen.

- Regularisierung zur Reduzierung der Modellkomplexität:

*Memos:

- Es gibt Dropout (Regularisierung). *Mein Beitrag erklärt die Dropout-Ebene.

- Es gibt eine L1-Regularisierung, auch L1-Norm oder Lasso-Regression genannt.

- Es gibt eine L2-Regularisierung, auch L2-Norm oder Ridge-Regression genannt.

-

Mein Beitrag erklärt linalg.norm().

-

Mein Beitrag erklärt linalg.vector_norm().

-

Mein Beitrag erklärt linalg.matrix_norm().

Unteranpassung:

- ist das Problem, dass ein Modell häufig keine genauen Vorhersagen sowohl für Zugdaten als auch für neue Daten (einschließlich Testdaten) treffen kann, sodass das Modell nicht sowohl für Zugdaten als auch für neue Daten geeignet ist.

- tritt auf, weil:

- Das Modell ist zu einfach (nicht komplex genug).

- Die Trainingszeit ist zu kurz mit einer zu geringen Anzahl an Epochen.

- Übermäßige Regularisierung (Dropout, L1- und L2-Regularisierung) wird angewendet.

- kann gemildert werden durch:

- Zunehmende Modellkomplexität.

- Erhöhung der Trainingszeit mit einer größeren Anzahl von Epochen.

- Abnehmende Regularisierung.

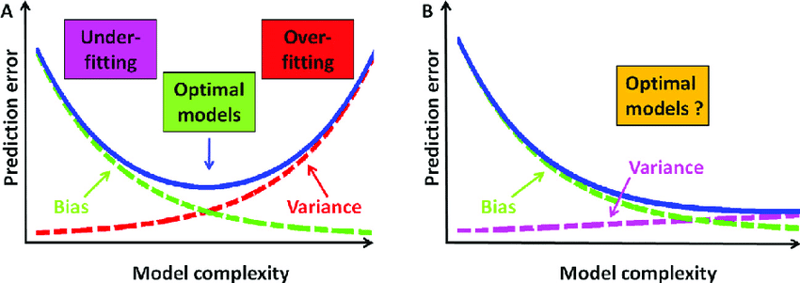

Überanpassung und Unteranpassung sind ein Kompromiss:

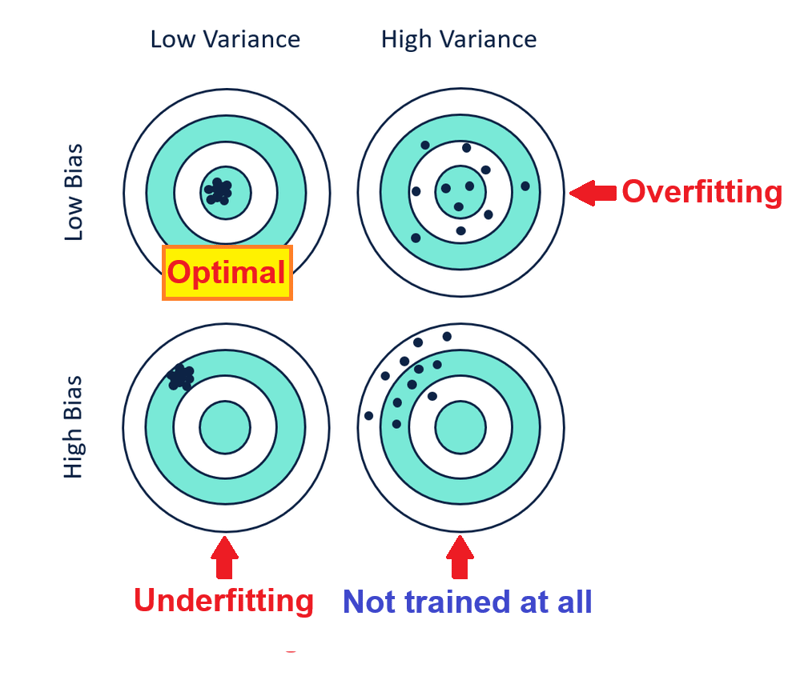

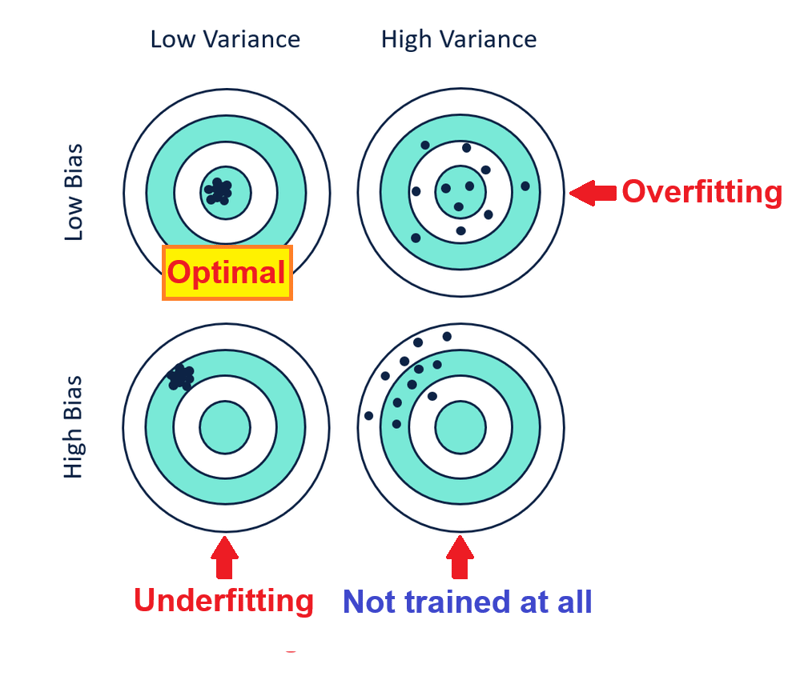

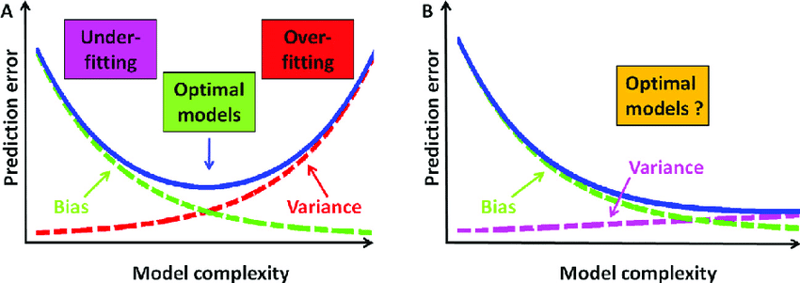

Zu viel Überanpassungsminderung (5., 6. und 7.) führt zu Unteranpassung mit hoher Verzerrung und geringer Varianz, während zu viel Unteranpassungsminderung( 1., 2. und 3.) führt zu einer Überanpassung mit geringer Verzerrung und hoher Varianz, daher sollte ihre Abschwächung wie unten gezeigt ausgewogen sein:

*Memos:

- Man kann auch sagen: Bias und Varianz sind ein Kompromiss, weil die Verringerung der Bias die Varianz erhöht, während die Reduzierung der Varianz die Bias erhöht, sodass sie ausgeglichen sein sollten. *Eine Erhöhung der Modellkomplexität verringert die Verzerrung, erhöht aber die Varianz, während eine Verringerung der Modellkomplexität die Varianz verringert, aber die Verzerrung erhöht.

- Geringe Vorspannung bedeutet hohe Genauigkeit, während hohe Vorspannung geringe Genauigkeit bedeutet.

- Geringe Varianz bedeutet hohe Präzision, während hohe Varianz geringe Präzision bedeutet.

Das obige ist der detaillierte Inhalt vonÜberanpassung vs. Unteranpassung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!