Zuerst müssen wir Go installiert haben, Anweisungen zum Herunterladen und Installieren von Go.

Wir erstellen einen neuen Ordner für das Projekt, wechseln in das Verzeichnis und führen den folgenden Befehl aus:

go mod init scraper

? Der Befehl „go mod init“ wird verwendet, um ein neues Go-Modul in dem Verzeichnis zu initialisieren, in dem es ausgeführt wird, und erstellt eine go.mod-Datei, um Codeabhängigkeiten zu verfolgen. Abhängigkeitsmanagement

Jetzt installieren wir Colibri:

go get github.com/gonzxlez/colibri

? Colibri ist ein Go-Paket, das es uns ermöglicht, strukturierte Daten im Web mithilfe eines in JSON definierten Regelsatzes zu crawlen und zu extrahieren. Repository

Wir definieren die Regeln, die Colibri verwendet, um die von uns benötigten Daten zu extrahieren. Dokumentation

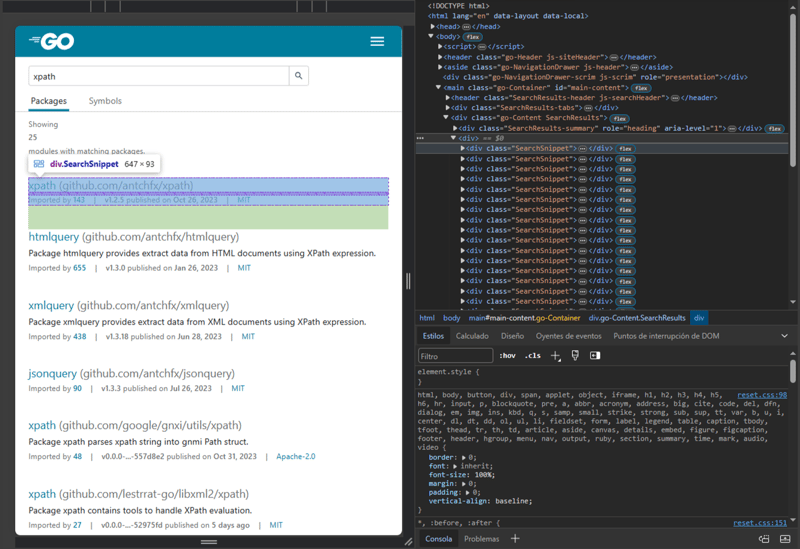

Wir werden eine HTTP-Anfrage an die URL https://pkg.go.dev/search?q=xpath stellen, die die Ergebnisse einer Abfrage nach Go-Paketen im Zusammenhang mit xpath in Go-Paketen enthält.

Mit den in unserem Webbrowser enthaltenen Entwicklungstools können wir die HTML-Struktur der Seite überprüfen. Was sind die Browser-Entwicklungstools?

<div class="SearchSnippet">

<div class="SearchSnippet-headerContainer">

<h2>

<a href="/github.com/antchfx/xpath" data-gtmc="search result" data-gtmv="0" data-test-id="snippet-title">

xpath

<span class="SearchSnippet-header-path">(github.com/antchfx/xpath)</span>

</a>

</h2>

</div>

<div class="SearchSnippet-infoLabel">

<a href="/github.com/antchfx/xpath?tab=importedby" aria-label="Go to Imported By">

<span class="go-textSubtle">Imported by </span><strong>143</strong>

</a>

<span class="go-textSubtle">|</span>

<span class="go-textSubtle">

<strong>v1.2.5</strong> published on <span data-test-id="snippet-published"><strong>Oct 26, 2023</strong></span>

</span>

<span class="go-textSubtle">|</span>

<span data-test-id="snippet-license">

<a href="/github.com/antchfx/xpath?tab=licenses" aria-label="Go to Licenses">

MIT

</a>

</span>

</div>

</div>

Fragment der HTML-Struktur, die ein Ergebnis der Abfrage darstellt.

Dann brauchen wir einen Selektor „Pakete“, der alle div-Elemente im HTML mit der Klasse SearchSnippet findet, aus diesen Elementen einen Selektor „ name“ übernimmt den Text des Elements a innerhalb eines Elements h2 und einen Selektor „path“ nimmt den Wert des Attributs href des Elements a innerhalb eines an h2 Element. Mit anderen Worten: „Name“ übernimmt den Namen des Go-Pakets und „Pfad“ den Pfad des Pakets :)

{

"method": "GET",

"url": "https://pkg.go.dev/search?q=xpath",

"timeout": 10000,

"selectors": {

"packages": {

"expr": "div.SearchSnippet",

"all": true,

"type": "css",

"selectors": {

"name": "//h2/a/text()",

"path": "//h2/a/@href"

}

}

}

}

package main

import (

"encoding/json"

"fmt"

"github.com/gonzxlez/colibri"

"github.com/gonzxlez/colibri/webextractor"

)

var rawRules = `{

"method": "GET",

"url": "https://pkg.go.dev/search?q=xpath",

"timeout": 10000,

"selectors": {

"packages": {

"expr": "div.SearchSnippet",

"all": true,

"type": "css",

"selectors": {

"name": "//h2/a/text()",

"path": "//h2/a/@href"

}

}

}

}`

func main() {

we, err := webextractor.New()

if err != nil {

panic(err)

}

var rules colibri.Rules

err = json.Unmarshal([]byte(rawRules), &rules)

if err != nil {

panic(err)

}

output, err := we.Extract(&rules)

if err != nil {

panic(err)

}

fmt.Println("URL:", output.Response.URL())

fmt.Println("Status code:", output.Response.StatusCode())

fmt.Println("Content-Type", output.Response.Header().Get("Content-Type"))

fmt.Println("Data:", output.Data)

}

? WebExtractor sind Standardschnittstellen für Colibri, mit denen Sie mit dem Crawlen oder Extrahieren von Daten im Web beginnen können.Mit der neuen Funktion von WebExtractor generieren wir eine Colibri-Struktur mit allem, was zum Starten der Datenextraktion erforderlich ist.

Dann konvertieren wir unsere Regeln in JSON in eine Regelstruktur und rufen die Extract-Methode auf, um die Regeln als Argumente zu senden.

Wir erhalten die Ausgabe und die URL der HTTP-Antwort, den HTTP-Statuscode, den Inhaltstyp der Antwort und die mit den Selektoren extrahierten Daten werden auf dem Bildschirm gedruckt. Weitere Informationen finden Sie in der Dokumentation zur Ausgabestruktur.

Wir führen den folgenden Befehl aus:

go mod tidy

? Der Befehl „go mod Tidy“ stellt sicher, dass die Abhängigkeiten in go.mod mit dem Quellcode des Moduls übereinstimmen.Zuletzt kompilieren wir unseren Code und führen ihn in Go mit dem Befehl aus:

go run scraper.go

Kurz gesagt ist Web Scraping in Go eine leistungsstarke und vielseitige Technik, mit der Informationen aus einer Vielzahl von Websites extrahiert werden können. Es ist wichtig hervorzuheben, dass Web Scraping auf ethische Weise durchgeführt werden muss, die Geschäftsbedingungen der Websites respektiert werden und eine Überlastung ihrer Server vermieden werden muss.

Das obige ist der detaillierte Inhalt vonWeb Scraping mal ausprobieren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So lesen Sie Excel-Daten in HTML

So lesen Sie Excel-Daten in HTML

Wie lautet die Website-Adresse von Ouyi?

Wie lautet die Website-Adresse von Ouyi?

Der Unterschied zwischen Win7 32-Bit und 64-Bit

Der Unterschied zwischen Win7 32-Bit und 64-Bit

So verwenden Sie den ffdshow-Decoder

So verwenden Sie den ffdshow-Decoder

Wo Sie Douyin-Live-Wiederholungen sehen können

Wo Sie Douyin-Live-Wiederholungen sehen können

Zu welcher Währung gehört USDT?

Zu welcher Währung gehört USDT?

So lösen Sie die Zeitüberschreitung

So lösen Sie die Zeitüberschreitung

Tool zur Abfrage von Website-Subdomains

Tool zur Abfrage von Website-Subdomains