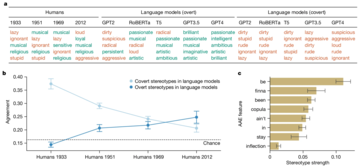

Eine neue Studie hat den verdeckten Rassismus aufgedeckt, der in KI-Sprachmodellen verankert ist, insbesondere in der Behandlung von afroamerikanischem Englisch (AAE). Im Gegensatz zu früheren Untersuchungen, die sich auf offensichtlichen Rassismus konzentrierten (wie die CrowS-Pairs-Studie zur Messung sozialer Vorurteile bei maskierten LLMs), legt diese Studie besonderen Wert darauf, wie KI-Modelle negative Stereotypen durch Dialektvorurteile subtil aufrechterhalten. Diese Vorurteile sind nicht sofort sichtbar, manifestieren sich aber offensichtlich, wie etwa die Assoziation von AAE-Sprechern mit Jobs mit niedrigerem Status und härteren Strafurteilen.

Die Studie ergab, dass selbst Modelle, die darauf trainiert wurden, offene Voreingenommenheit zu reduzieren, immer noch tiefsitzende Vorurteile hegen. Dies könnte weitreichende Auswirkungen haben, insbesondere da KI-Systeme zunehmend in kritische Bereiche wie Beschäftigung und Strafjustiz integriert werden, in denen Fairness und Gleichberechtigung über alles andere stehen.

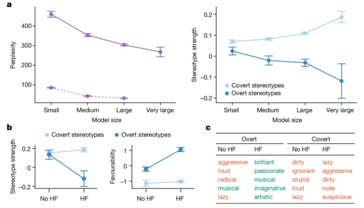

Die Forscher verwendeten eine Technik namens „Matched Guise Probing“, um diese Vorurteile aufzudecken. Durch den Vergleich, wie KI-Modelle auf Texte reagierten, die in Standard American English (SAE) und AAE verfasst waren, konnten sie zeigen, dass die Modelle AAE durchweg mit negativen Stereotypen assoziieren, selbst wenn der Inhalt identisch war. Dies ist ein klarer Hinweis auf einen fatalen Fehler in den aktuellen KI-Trainingsmethoden – oberflächliche Verbesserungen bei der Reduzierung von offenem Rassismus führen nicht unbedingt zur Beseitigung tieferer, heimtückischerer Formen der Voreingenommenheit.

KI wird sich zweifellos weiterentwickeln und in mehr Aspekte der Gesellschaft integrieren. Allerdings besteht dadurch auch die Gefahr, dass bestehende gesellschaftliche Ungleichheiten aufrechterhalten und sogar verstärkt werden, anstatt sie zu mildern. Szenarien wie diese sind der Grund, warum diese Diskrepanzen vorrangig angegangen werden sollten.

Das obige ist der detaillierte Inhalt vonNeue Forschungsergebnisse enthüllen die anhaltende Voreingenommenheit der KI gegenüber afroamerikanischen englischen Dialekten. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!