Il semble que tout le monde ait encore des opinions différentes sur la question de savoir si RLHF et RL peuvent être classées dans la même catégorie. Le gourou de l'IA Karpathy est de nouveau là pour populariser le concept d'intelligence artificielle. Hier, il a tweeté : "L'apprentissage par renforcement basé sur le feedback humain (RLHF) n'est qu'un apprentissage par renforcement (RL)."

Le texte intégral de Karpathy est expliqué comme suit :

RLHF est la troisième méthode de formation de grands modèles de langage (LLM). sont trois (et dernières) étapes principales, les deux premières étapes sont la pré-formation et le réglage fin supervisé (SFT). Je pense que le RLHF est à peine un RL, il n'est pas largement reconnu. RL est puissant, mais RLHF ne l’est pas.

Regardons l'exemple d'AlphaGo, qui a été formé à l'aide d'un vrai RL. L'ordinateur jouait au jeu de Go et était entraîné sur des tours qui maximisaient la fonction de récompense (gagner la partie), surpassant finalement les meilleurs joueurs humains. AlphaGo n’a pas été formé à l’aide du RLHF, et si c’était le cas, il ne serait pas aussi efficace.

À quoi cela ressemblerait-il d'entraîner AlphaGo avec RLHF ? Tout d'abord, vous donnez aux annotateurs humains deux états du tableau Go et leur demandez lequel ils préfèrent :

Vous collecterez ensuite 100 000 comparaisons similaires et entraînerez un réseau neuronal de « modèle de récompense » (RM) pour simuler une vérification par vibration humaine de l'état de la carte. Vous l’entraînez à être d’accord avec le jugement humain moyen. Une fois que nous avons vérifié l'ambiance du modèle bonus, vous pouvez exécuter RL contre cela et apprendre à effectuer des mouvements qui apportent de bonnes vibrations. Évidemment, cela ne produit pas de résultats très intéressants en Go.

Cela s'explique principalement par deux raisons fondamentales et indépendantes :

1) L'ambiance peut être trompeuse, ce qui n'est pas la véritable récompense (gagner la partie). C’est un mauvais objectif d’agent. Pire encore, 2) vous constaterez que votre optimisation RL déraille car elle découvre rapidement que l'état du tableau est opposé au modèle de récompense. N'oubliez pas que le modèle de récompense est un réseau neuronal massif utilisant des milliards de paramètres pour simuler l'atmosphère. Certains états du conseil d'administration se situent en dehors de la plage de distribution de leurs propres données de formation et ne sont pas réellement de bons états, mais reçoivent des récompenses très élevées du modèle de récompense.

Pour la même raison, je suis parfois surpris que le travail du RLHF fonctionne pour le LLM. Le modèle de récompense que nous avons formé pour LLM effectue simplement la vérification des vibrations exactement de la même manière, en attribuant des scores élevés aux réponses de l'assistant que les évaluateurs humains semblent statistiquement apprécier. Ce n’est pas le but réel de résoudre le problème correctement, mais le but de ce que les humains pensent être bon en tant qu’agent.

Deuxièmement, vous ne pouvez même pas exécuter RLHF très longtemps car votre modèle apprend rapidement à réagir de manière à ce que le jeu le récompense. Ces prédictions auront l'air vraiment bizarres, et vous verrez votre assistant LLM commencer à répondre à de nombreuses invites avec des réponses dénuées de sens comme "Le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le le Cela vous semble ridicule, mais ensuite vous regardez les contrôles d'ambiance du modèle bonus et vous réalisez que, pour une raison quelconque, le modèle bonus les trouve superbes.

Votre LLM a trouvé un exemple contradictoire qui se situe en dehors de la plage des données de formation du modèle de récompense et se situe dans une plage indéfinie. Vous pouvez atténuer ce problème en ajoutant ces exemples spécifiques à l'ensemble de formation à plusieurs reprises, tout en trouvant d'autres exemples contradictoires la prochaine fois. Vous ne pouvez même pas exécuter RLHF pour de nombreuses étapes d'optimisation. Vous devez l'appeler après quelques centaines ou milliers d'étapes, car votre optimisation commencera à jouer sur le modèle de récompense. Ce n'est pas RL comme AlphaGo.

Cependant, le RLHF est une étape très utile dans la construction d'un assistant LLM. Je pense qu'il y a plusieurs raisons subtiles à cela, dont ma préférée est qu'avec RLHF, l'assistant LLM bénéficie de l'écart générateur-discriminateur. Autrement dit, pour de nombreux types de questions, il est beaucoup plus facile pour un annotateur humain de sélectionner la meilleure réponse parmi plusieurs réponses candidates que d'écrire la réponse idéale à partir de zéro. Un bon exemple est une invite telle que « Générer un poème avec un trombone ». Un annotateur humain moyen aurait du mal à écrire un bon poème à partir de zéro pour l'utiliser comme exemple de mise au point supervisée, mais pourrait en choisir un meilleur étant donné plusieurs réponses candidates (poèmes). Le RLHF est donc un moyen de bénéficier du manque de « facilité » de la supervision humaine.

Il existe d'autres raisons pour lesquelles le RLHF aide à soulager les hallucinations. Si le modèle de récompense est un modèle suffisamment puissant pour repérer ce que le LLM invente pendant la formation, il peut apprendre à punir ce comportement avec de faibles récompenses, en apprenant au modèle à éviter de prendre des risques pour acquérir des connaissances factuelles lorsqu'elles sont incertaines. Mais le soulagement et la gestion satisfaisante des hallucinations sont une autre affaire et ne seront pas développés ici. En conclusion, RLHF fonctionne, mais ce n'est pas RL.

Jusqu'à présent, aucun RL de qualité production pour LLM n'a été implémenté et démontré de manière convaincante à grande échelle dans le domaine ouvert. Intuitivement, cela est dû au fait qu’il est très difficile d’obtenir des récompenses réelles (c’est-à-dire gagner la partie) dans des tâches ouvertes de résolution de problèmes. Dans un environnement fermé et ludique comme Go, tout est amusant. La dynamique est limitée, le coût d'évaluation de la fonction de récompense est très faible et le jeu est impossible.

Mais comment offrir une récompense objective pour la synthèse d’un article ? Ou répondre à une question ambiguë sur une certaine installation de pip ? Ou raconter une blague ? Ou réécrire du code Java en Python ? Y parvenir n’est pas impossible en principe, mais ce n’est pas facile et nécessite une certaine réflexion créative. Celui qui résoudra ce problème de manière convaincante sera capable d'exécuter un véritable RL, permettant à AlphaGo de battre les humains au Go. Avec RL, LLM a le potentiel de véritablement battre les humains dans la résolution de problèmes de domaine ouvert.

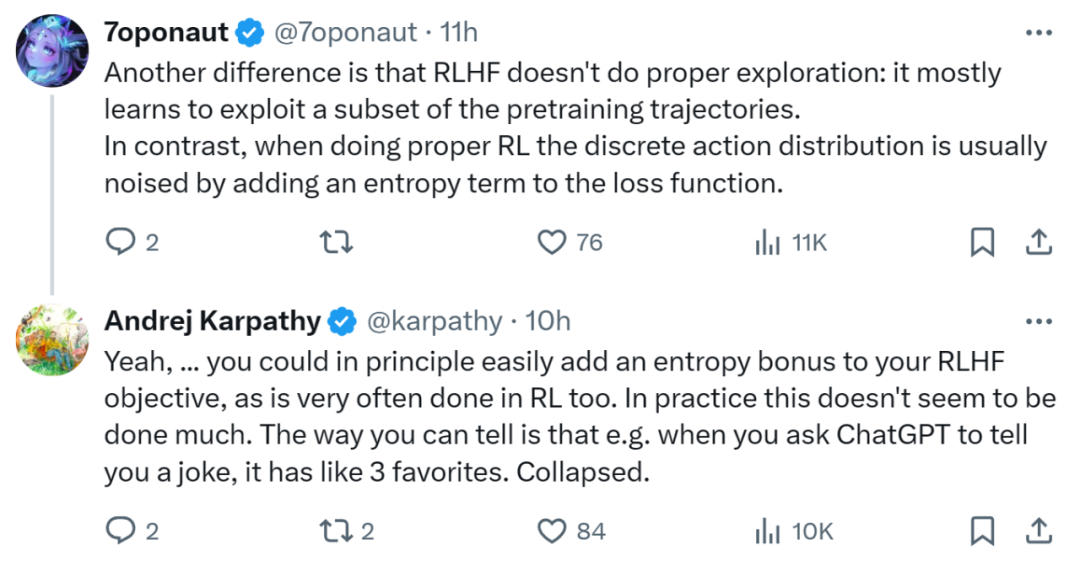

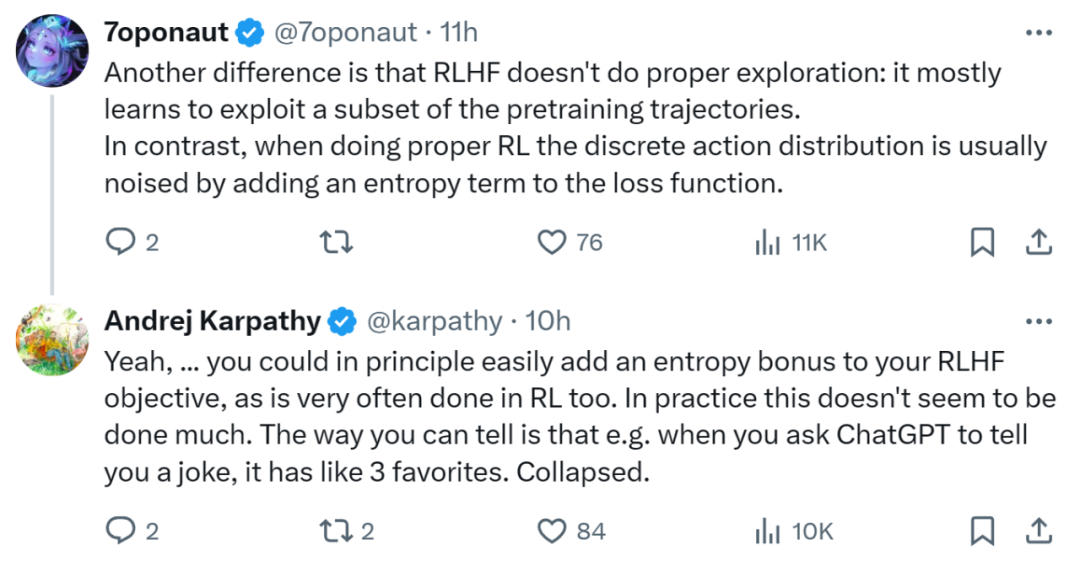

Le point de vue de Karpathy a été repris par certains qui ont souligné davantage de différences entre RLHF et RL. Par exemple, RLHF n'effectue pas de recherche appropriée et apprend principalement à utiliser un sous-ensemble de trajectoires pré-entraînées. En revanche, lors d'une RL appropriée, les distributions d'actions discrètes sont souvent bruitées en ajoutant un terme d'entropie à la fonction de perte. Kaypathy a fait valoir qu'en principe, vous pourriez facilement ajouter des récompenses d'entropie aux objectifs du RLHF, ce qui est également souvent fait dans le RL. Mais en réalité, cela semble rare.

Kevin Patrick Murphy, chercheur chez Google, est également entièrement d'accord avec Karpathy.

- Er glaubt, dass RLHF eher ein Kontext-„Bandit“ mit String-Wert-Operationen ist, wobei prompt der Kontext ist, sodass es nicht als vollständiges RL bezeichnet werden kann.

- Auch die Formalisierung der Belohnungen für die täglichen Aufgaben ist der schwierige Teil (er denkt, man könnte das als Ausrichtung bezeichnen).

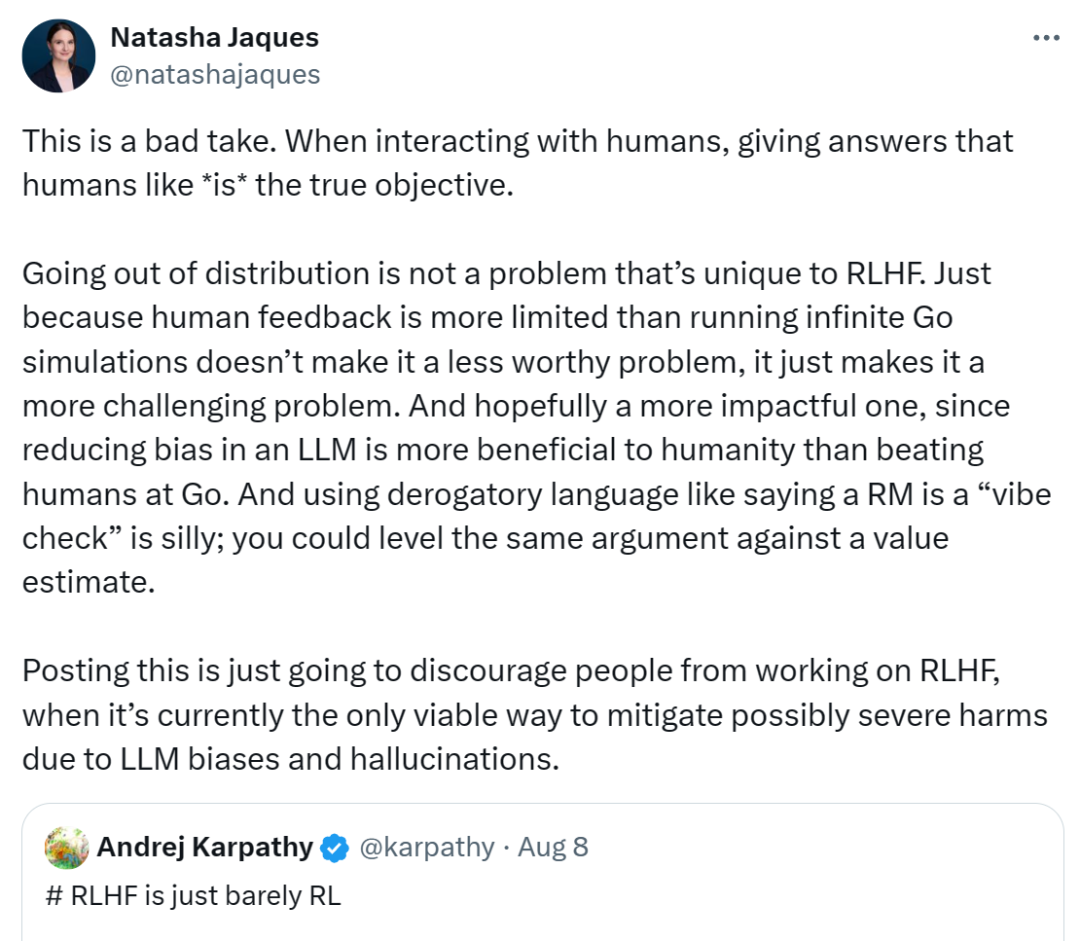

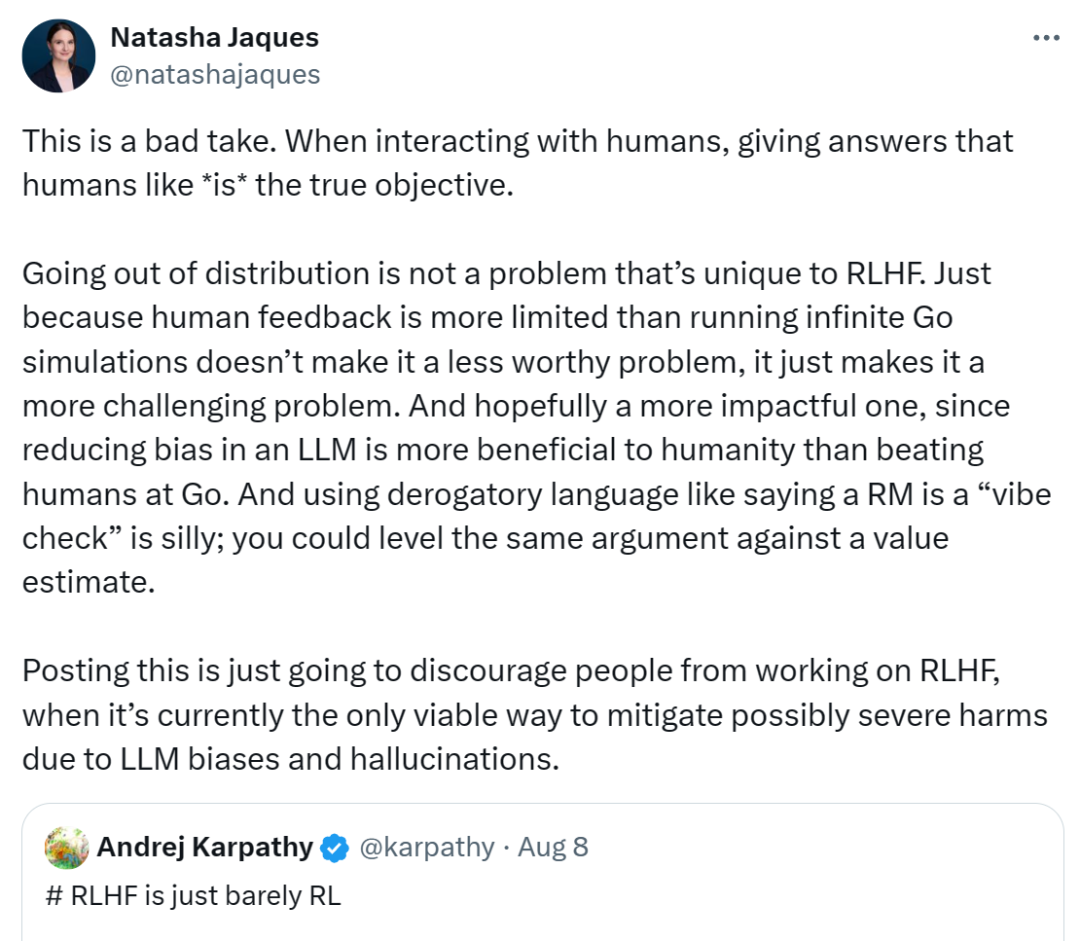

Allerdings ist Natasha Jaques, eine weitere leitende Wissenschaftlerin bei Google, der Meinung, dass Karpathy falsch liegt. Sie glaubt, dass das eigentliche Ziel darin besteht, Antworten zu geben, die den Menschen gefallen, wennAgentmit Menschen interagiert.

Außerhalb des Vertriebsbereichs ist kein Problem, das nur bei RLHF auftritt. Nur weil menschliches Feedback eingeschränkter ist als die Ausführung einer unendlichen Go-Simulation, heißt das nicht, dass es sich nicht um ein lösungswürdiges Problem handelt, sondern macht es nur zu einer größeren Herausforderung. Sie hofft, dass dies zu einem wirkungsvolleren Thema wird, da es schließlich sinnvoller ist, Voreingenommenheit inLLMzu reduzieren, als Menschen in Go zu schlagen. Abfällige Begriffe wie Karpathy zu verwenden, die sagen, das Bonusmodell sei ein Stimmungscheck, ist albern. Das gleiche Argument können Sie auch gegen Wertschätzungen verwenden.

Sie glaubt, dass Karpathys Ansichten nur dazu dienen werden, Menschen davon abzuhalten, der RLHF-Arbeit nachzugehen, obwohl dies derzeit der einzig gangbare Weg ist, den ernsthaften Schaden zu mildern, denLLMVoreingenommenheit und Illusion anrichten können.

Quelle: https://x.com/natashajaques/status/182163113759025979

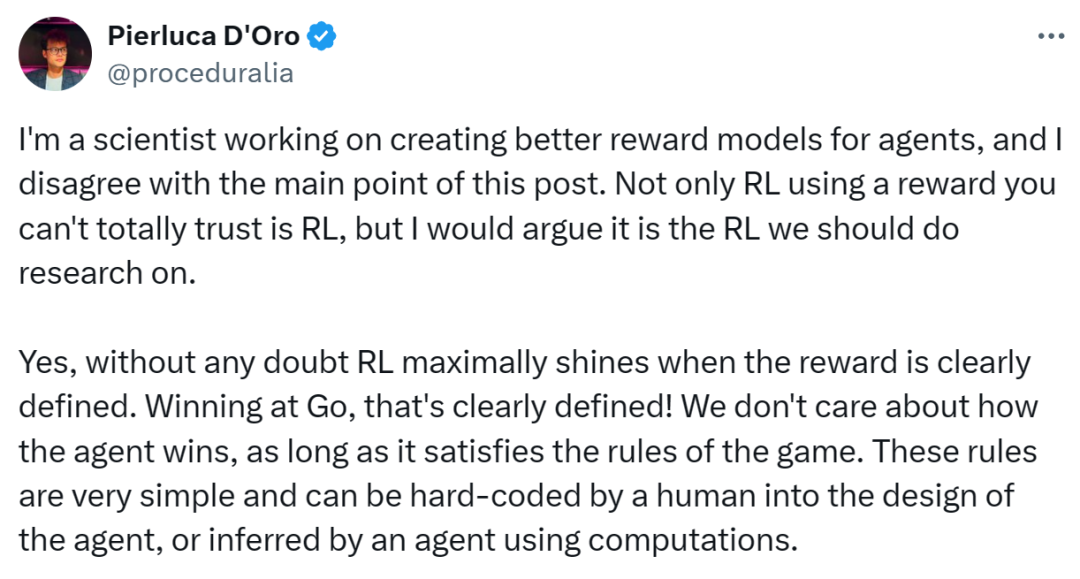

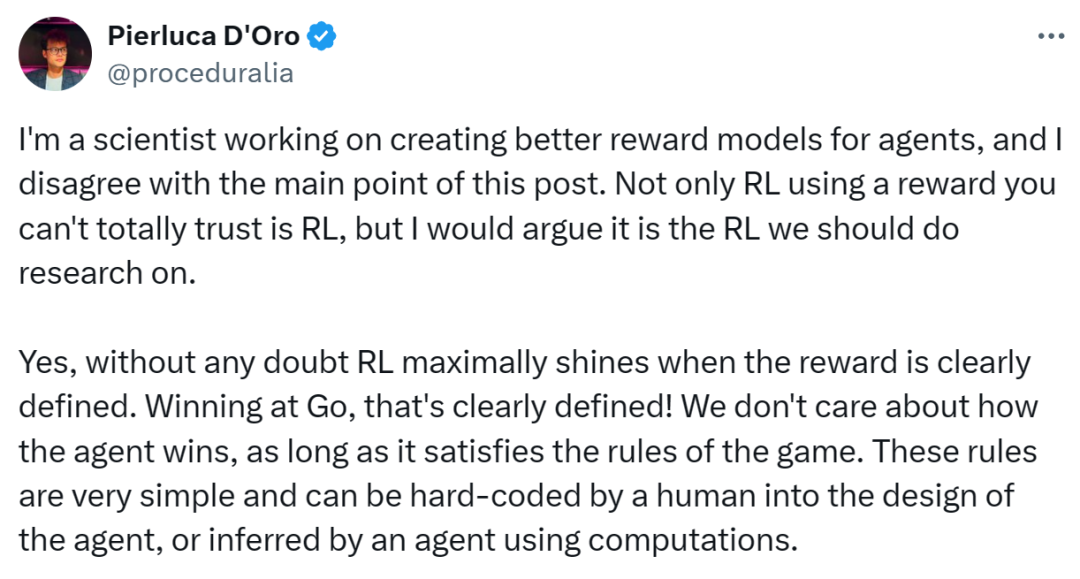

meta -Forscher Pierluca d'Oro stimmt nicht mit Karpathys Hauptpunkt zu, stimmt jedoch zu, dass "rlhf nur bary rl" Dieser Titel "dieses Titel" ist. Er argumentierte, dass RLHF, das üblicherweise zur Feinabstimmung von LLM verwendet wird, kaum RL sei.

Die Hauptpunkte sind wie folgt:

- Beim Reinforcement Learning ist es unrealistisch, ein Konzept der „perfekten Belohnung“ zu verfolgen, da bei den meisten komplexen Aufgaben neben der Wichtigkeit des Ziels auch die Ausführungsmethode gleichermaßen wichtig ist.

- Allerdings schneidet RL bei Aufgaben mit klaren Regeln wie Go gut ab. Aber wenn es um komplexe Verhaltensweisen geht, ist der Belohnungsmechanismus des traditionellen RL möglicherweise nicht in der Lage, die Bedürfnisse zu erfüllen.

- Er befürwortet die Untersuchung, wie die Leistung von RL unter unvollständigen Belohnungsmodellen verbessert werden kann, und betont die Bedeutung von Rückkopplungsschleifen, robusten RL-Mechanismen und der Zusammenarbeit zwischen Mensch und Maschine.

Bildquelle: https://x.com/pro ceduralia/status/1821560990091128943 Wessen Ansicht stimmen Sie zu? Gerne können Sie im Kommentarbereich eine Nachricht hinterlassen.

Das obige ist der detaillierte Inhalt vonKarpathys Ansichten sind umstritten: RLHF ist kein echtes Reinforcement Learning, und Google und Meta sind dagegen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

keine solche Dateilösung

keine solche Dateilösung Warum schlägt die Win10-Aktivierung fehl?

Warum schlägt die Win10-Aktivierung fehl? Der Apple Store kann keine Verbindung herstellen

Der Apple Store kann keine Verbindung herstellen Raum für reguläre Ausdrücke

Raum für reguläre Ausdrücke Was ist der Baidu-Index?

Was ist der Baidu-Index? Prioritätsreihenfolge der Operatoren in der Sprache C

Prioritätsreihenfolge der Operatoren in der Sprache C So erstellen Sie einen neuen Ordner in Pycharm

So erstellen Sie einen neuen Ordner in Pycharm Welche SEO-Diagnosemethoden gibt es?

Welche SEO-Diagnosemethoden gibt es?