Produziert von 51CTO Technology Stack (WeChat-ID: blog51cto)

Mistral hat sein erstes Codemodell Codestral-22B veröffentlicht!

Das Verrückte an diesem Modell ist nicht nur, dass es auf über 80 Programmiersprachen trainiert ist, darunter Swift usw., die viele Codemodelle ignorieren.

Ihre Geschwindigkeiten sind nicht genau gleich. Es ist erforderlich, ein „Publish/Subscribe“-System in der Go-Sprache zu schreiben. Der GPT-4o hier wird ausgegeben und Codestral reicht das Papier so schnell ein, dass es kaum zu erkennen ist!

Da dieses Modell gerade erst auf den Markt gekommen ist, wurde es noch nicht öffentlich getestet. Doch laut Mistral-Verantwortlichen ist Codestral derzeit das leistungsstärkste Open-Source-Codemodell.

Bilder

Bilder

Interessierte Freunde können wechseln zu:

-Hugging Face: https://huggingface.co/mistralai/Codestral-22B-v0.1

-Blog: https:// mistral.ai/news/codestral/

Dem Blog zufolge hat Codestral seine Konkurrenten in Langtext- und mehreren Programmiersprachen-Leistungstests übertroffen, darunter 70B CodeLlama, 33B Deepseek Coder und 70B Llama 3 70B.

Bilder

Bilder

Werfen wir einen genaueren Blick auf den „König“ des Codemodells und darauf, wo Codestral stark ist.

Als 22B-Modell setzt Codestral einen neuen Standard für den Leistungs-/Latenzraum der Codegenerierung. Im Kern verfügt Codestral 22B über eine Kontextlänge von 32 KB und bietet Entwicklern die Möglichkeit, Code in einer Vielzahl von Programmierumgebungen und Projekten zu schreiben und mit ihm zu interagieren.

Bild

Bild

Oben: Mit einem größeren Kontextfenster von 32 KB (im Gegensatz zu 4 KB, 8 KB oder 16 KB der Konkurrenz) übertrifft Codestral alle anderen Modelle in RepoBench, einer Fernbewertung der Codegenerierung.

Codestral ist wahnsinnig auf Datensätzen aus über 80 Programmiersprachen trainiert und eignet sich daher für eine Vielzahl von Programmieraufgaben, darunter das Generieren von Code von Grund auf, das Abschließen von Codierungsfunktionen, das Schreiben von Tests und die Fertigstellung mit Zwischenauffüllmechanismen für jeden Teil des Codes .

Zu den Programmiersprachen, die es abdeckt, gehören beliebtes SQL, Python, Java, C und C++ sowie spezifischeres Swift und Fortran usw., was es zu einem Generalisten in der Programmierwelt macht.

Mistral sagte, dass Codestral Entwicklern helfen kann, ihre Programmierfähigkeiten zu verbessern, Arbeitsabläufe zu beschleunigen und viel Zeit und Mühe beim Erstellen von Anwendungen zu sparen. Ganz zu schweigen davon, dass es auch dazu beitragen kann, das Risiko von Fehlern und Schwachstellen zu verringern.

Oben: HumanEval-Bewertung der Codestral-Leistung in verschiedenen Programmiersprachen

Oben: HumanEval-Bewertung der Codestral-Leistung in verschiedenen Programmiersprachen

Bei der Bewertung der Python-Codegenerierung auf HumanEval und CruxEval beim Testen der Python-Ausgabevorhersage erzielte das Modell 81,1 % bzw. 51,3 % und übertraf die Konkurrenz . Es erreichte sogar den ersten Platz im HumanEval für Bash, Java und PHP.

Es ist erwähnenswert, dass die Leistung des Modells bei HumanEval für C++, C und Typescript nicht die beste ist, aber die durchschnittliche Punktzahl aller Tests mit 61,5 % am höchsten ist, etwas höher als die 61,2 % von Llama 3 70B. In der Spider-Bewertung, die die SQL-Leistung bewertet, belegte es mit einem Wert von 63,5 % den zweiten Platz.

Einige beliebte Entwicklerproduktivitäts- und KI-Anwendungsentwicklungstools haben mit dem Testen von Codestral begonnen. Dazu gehören große Namen wie LlamaIndex, LangChain, Continue.dev, Tabnine und JetBrains.

„Nach unseren ersten Tests ist es eine gute Wahl für generative Code-Workflows, da es schnell ist, ein günstiges Kontextfenster hat und die Verwendung von Versionsunterstützungstools leitet. Wir haben LangGraph für die selbstkorrigierende Codegenerierung von Tests verwendet Das geführte Codestral-Tool kann für die Ausgabe verwendet werden, und es hat sofort nach dem Auspacken wirklich gut funktioniert“, sagte Harrison Chase, CEO und Mitbegründer von LangChain.

Darüber hinaus hat Codestral mit mehreren Industriepartnern zusammengearbeitet, darunter JetBrains, SourceGraph und LlamaIndex. Jerry Liu, CEO von LlamaIndex, sagte über seine Tests von Codestral: „Bisher hat es immer hochpräzisen und verwendbaren Code erzeugt, selbst für komplexe Aufgaben. Zum Beispiel, als ich es gebeten habe, eine Aufgabe zur Erstellung eines neuen When LlamaIndex abzuschließen.“ fragt die unkomplizierten Funktionen der Engine ab, der generierte Code läuft nahtlos, obwohl er auf einer älteren Codebasis basiert.“

Mistral bietet Codestral 22B auf Hugging Face unter seiner eigenen nichtkommerziellen Lizenz an, sodass Entwickler die Technologie für nichtkommerzielle Zwecke nutzen, Tests durchführen und Forschungsbemühungen unterstützen können.

Das Unternehmen bietet das Modell auch über zwei API-Endpunkte an: codestral.mistral.ai und api.mistral.ai.

Ersteres ist für Benutzer konzipiert, die die geführte oder mittlere Füllroute von Codestral innerhalb der IDE verwenden möchten. Es wird mit einem API-Schlüssel auf persönlicher Ebene geliefert, ohne die üblichen Tarifbeschränkungen der Organisation und kann während eines achtwöchigen Testzeitraums kostenlos verwendet werden. Während api.mistral.ai der allgemeine Endpunkt für umfassendere Recherchen, Batch-Abfragen oder die Anwendungsentwicklung Dritter ist, werden Abfragen pro Token abgerechnet.

Was noch interessanter ist, ist, dass Mistral eine geführte Version von Codestral auf Le Chat veröffentlicht hat, die den Zugriff auf Codestral über ihre kostenlose Konversationsschnittstelle Le Chat ermöglicht. Entwickler können auf natürliche und intuitive Weise mit Codestral interagieren und dabei die Funktionen des Modells voll ausnutzen.

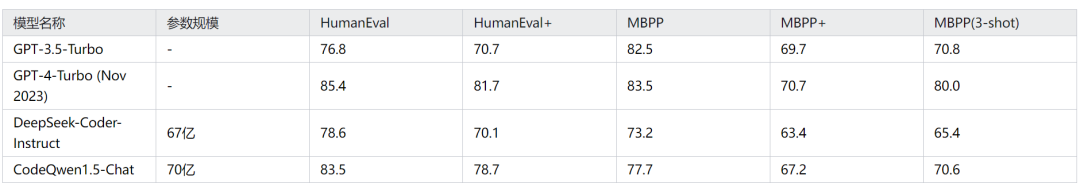

Unter den inländischen Großmodellen gibt es auch Codemodelle mit erstaunlicher Leistung, wie zum Beispiel das 7-Milliarden-Parameter-Großmodell CodeQwen1.5-7B, das Alibaba vor nicht allzu langer Zeit als Open Source bereitgestellt hat.

Im HumanEval-Test übertraf die Punktzahl der CodeQwen1.5-7B-Chat-Version sogar die frühe Version von GPT-4 und war etwas niedriger als die von GPT-4-Turbo (Version November 2023).

Bilder

Bilder

CodeQwen-Entwickler Binyuan Hui hat nicht vergessen, Lian Guillaume Lample von Mistral daran zu erinnern, als er ihm gratulierte, Tongyi mitzubringen, um es gemeinsam zu bewerten!

Bilder

Bilder

Es wird geschätzt, dass wir CodeQwen1.5-7B und Codestral bald in der Arena gegeneinander antreten sehen werden.

Um mehr über AIGC zu erfahren, besuchen Sie bitte:

51CTO AI.x Community

https://www.51cto.com/aigc/

Das obige ist der detaillierte Inhalt vonDas Open-Source-Codemodell von Mistral erobert den Thron! Codestral legt großen Wert auf Schulungen in über 80 Sprachen und einheimische Tongyi-Entwickler bitten um Teilnahme!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Einführung in die Verwendung des gesamten VBS-Codes

Einführung in die Verwendung des gesamten VBS-Codes

Der Unterschied zwischen einem offiziellen Ersatztelefon und einem brandneuen Telefon

Der Unterschied zwischen einem offiziellen Ersatztelefon und einem brandneuen Telefon

Was soll ich tun, wenn meine Windows-Lizenz bald abläuft?

Was soll ich tun, wenn meine Windows-Lizenz bald abläuft?

Verwendung der Schreibfunktion

Verwendung der Schreibfunktion

Was ist j2ee

Was ist j2ee

Was soll ich tun, wenn eDonkey Search keine Verbindung zum Server herstellen kann?

Was soll ich tun, wenn eDonkey Search keine Verbindung zum Server herstellen kann?

Methode zum Löschen von Hiberfil-Dateien

Methode zum Löschen von Hiberfil-Dateien

Was bedeutet Element?

Was bedeutet Element?